#infrastruttura di rete sicura

Explore tagged Tumblr posts

Text

Rete in fibra ottica a Roma per aziende: velocità, sicurezza e affidabilità per il tuo business

[et_pb_section fb_built=”1″ _builder_version=”4.27.4″ _module_preset=”default” global_colors_info=”{}”][et_pb_row _builder_version=”4.27.4″ _module_preset=”default” global_colors_info=”{}”][et_pb_column type=”4_4″ _builder_version=”4.27.4″ _module_preset=”default” global_colors_info=”{}”][et_pb_text _builder_version=”4.27.4″ _module_preset=”default” global_colors_info=”{}”] Rete in fibra ottica a…

#connessione veloce per aziende#fibra ottica per hotel#infrastruttura di rete sicura#rete in fibra ottica Roma#soluzioni di cybersecurity Roma

0 notes

Text

Il Corporate Banking Interbancario annuncia il completamento della fase di migrazione

La nuova architettura tecnologica di CBI, in Cloud privato di interconnessione tra tutte le banche consente la realizzazione di un vero salto di paradigma tecnologico. Il progetto Cbi Hub Cloud ha rappresentato infatti un importante sforzo di innovazione, che ha visto in questi ultimi quattro anni il coinvolgimento attivo di tutti gli attori dell’ecosistema, banche, strutture tecniche, associazioni di categoria e autorità, mirando a trasformare l’infrastruttura di rete che gestisce le oltre 60 funzioni di pagamento, incasso e informative multibanca tra le aziende italiane e verso la Pubblica Amministrazione, da protocolli proprietari a soluzioni virtualizzate e centralizzate basate su protocolli di rete standard aperti, ancora più moderni, flessibili e scalabili. Un cambiamento che consentirà ai payment service provider di offrire ai propri clienti corporate e retail e alla Pubblica Amministrazione, servizi transazionali e di open finance più evoluti e in tempo reale, ampliando notevolmente i livelli di efficienza, di sicurezza e di integrazione nel mercato dei pagamenti tra tutti gli attori del nostro Paese. "La migrazione alla nuova infrastruttura Cbi Hub Cloud rappresenta una tappa di fondamentale importanza nel nostro percorso di innovazione" sottolinea Liliana Fratini Passi, direttore generale di Cbi. "Offrendoci la possibilità di accorpare in un unico ecosistema tecnologico tutti i servizi ad oggi veicolati dalla nostra Società, Cbi Hub Cloud non solo ci consente una gestione centrale e, di conseguenza, migliore di tutti i nostri processi, ma permette ai nostri clienti di rendere ancora più semplice, immediata, efficiente e sicura la gestione dell’offerta nei confronti della propria clientela", dice Liliana Fratini Passi. "Cbi Hub Cloud ci permetterà, dunque, di rafforzare il nostro ruolo come azienda per lo sviluppo di servizi digitali di pagamento e di open finance, a supporto dell’offerta del settore finanziario, anche internazionale, facilitando in ottica collaborativa il colloquio in tempo reale tra i vari attori del mercato, cittadini, imprese, banche, intermediari, fintech e Pubblica Amministrazione, attraverso l’utilizzo di tecnologie in linea con i migliori requisiti di sicurezza", conclude Fratini Passi. CBI Hub Cloud, che ospita le funzioni centralizzate di processing, diagnostica e monitoraggio, rappresenterà la struttura portante da cui partire per tutte le evoluzioni dei Servizi che ospita la nuova infrastruttura, offrendo anche ulteriori funzionalità online supportate dalla moderna tecnologia Api, ovvero Application Program Interface, garantendo un miglior time to market nel rilascio dei servizi, oltre che un migliore monitoraggio delle performance da parte di Cbi. Implementata con la collaborazione di Nexi, la PayTech italiana leader in Europa che ha realizzato l’infrastruttura tecnologica, la nuova architettura in Cloud si inserisce nell’impegno della società di allinearsi con le moderne tecnologie introdotte dalla seconda direttiva europea in materia di pagamenti, oggi alla base dell’open banking. Read the full article

0 notes

Text

Sassari, una nuova luce per la città: con ENGIE viene riqualificata l’illuminazione rendendola più efficiente, sostenibile e sicura

Sassari, una nuova luce per la città: con ENGIE viene riqualificata l’illuminazione rendendola più efficiente, sostenibile e sicura. Partiti i lavori per illuminare Sassari in maniera efficiente, sostenibile e sicura. Il Comune di Sassari ha affidato a ENGIE il progetto di riqualificazione dell’illuminazione pubblica, il quale prevede l’installazione di oltre 16.000 lampioni a LED, la riqualificazione di 65 semafori e l’installazione di 67 telecamere di video-sorveglianza. Tutti i particolari sono stati presentati oggi, 19 aprile, nella sala conferenze di Palazzo Ducale, dal sindaco Nanni Campus, dall'assessora ai Lavori pubblici e Manutenzioni Rosanna Arru con il dirigente Gianni Melis e i tecnici del Settore, da Claudio Galli, direttore Area Centro ENGIE Italia e da Danilo Migliorini, direttore Area Sardegna ENGIE Italia. Le opere strutturali saranno realizzate con l’obiettivo di efficientare, uniformare e mettere in sicurezza elettrica e statica l’intera infrastruttura impiantistica. Un progetto importante, che l’Amministrazione Comunale ha scelto in un momento storico in cui i temi della sostenibilità ambientale, del risparmio energetico, della sicurezza dei territori e della valorizzazione degli spazi urbani sono divenuti una priorità nell’agenda delle Pubbliche Amministrazioni. I lavori di efficientamento, iniziati a gennaio 2023 e coordinati dal settore Lavori pubblici del Comune, si inseriscono nel contratto della durata di 15 anni che prevede la gestione, la manutenzione e l’efficientamento degli impianti di illuminazione pubblica e semaforica, inclusa la fornitura dell’energia elettrica, e di ulteriori interventi per un uso razionale dell’energia negli edifici e nei siti comunali. Sono stati sostituiti a oggi circa 1200 lampioni con sorgenti led nelle zone San Pietro, Viale Italia, Carbonazzi e Luna e Sole. Le squadre di ENGIE stanno lavorando in parallelo per gestire i lavori, procedendo dalla periferia al centro, comprese le borgate, senza creare interruzioni alla circolazione e garantendo attenzione alle connotazioni urbanistiche della città. I lavori termineranno nel 2024. Tutte le sorgenti led installate saranno dotate di regolazione automatica del flusso luminoso nel rispetto delle esigenze di ciascuna sede stradale o luogo di riferimento in cui è posto il corpo illuminante. Saranno, inoltre, sostituiti più di 100 sostegni e riqualificati 160 quadri elettrici. ll nuovo sistema di illuminazione consente di migliorare l’efficienza e le prestazioni della rete garantendo al contempo il contenimento della luce artificiale e un maggiore comfort visivo, così da rendere le strade più sicure e permettere ai cittadini e ai turisti di vivere gli spazi urbani come luoghi di incontro e aggregazione. Grazie a un innovativo software, ogni lampione è geolocalizzato e collegato a un sistema di telecontrollo centralizzato. In questo modo il servizio di gestione, manutenzione e segnalazione guasti è stato digitalizzato rendendolo veloce, efficace e sicuro. E’ a disposizione, inoltre, della cittadinanza, delle forze dell’ordine e degli enti di verifica il numero verde 800127991 attivo 24h/24 per 365 giorni l’anno. Gli interventi sul sistema di video-sorveglianza prevedono l’installazione di 67 telecamere nei punti strategici dell’area urbana a maggior intensità di traffico, per aumentare la sicurezza nelle zone afferenti il centro storico e le periferie. Il sistema di videosorveglianza entrerà in funzione gradualmente all'installazione della singola telecamera. L’accordo tra l’Amministrazione di Sassari ed ENGIE prevede, oltre agli interventi sull’illuminazione pubblica, semaforica e la video-sorveglianza, anche la fornitura di energia termica per 115 edifici pubblici, tra scuole, uffici, impianti sportivi e case di cura. La progettazione di due edifici ad alta prestazione energetica alimentati principalmente da energia proveniente da fonti rinnovabili. Inoltre, nell’area ex IVECO sarà installato un sistema di distribuzione locale dell’energia elettrica (micro-grid), realizzato un impianto fotovoltaico da 130 kW e predisposte colonnine di ricarica per le auto elettriche. La partnership tra ENGIE e il Comune di Sassari trasformerà quindi il capoluogo di provincia in una città alimentata da impianti altamente tecnologici ed efficienti e porterà alla graduale dismissione di quelli a gasolio, fortemente impattanti dal punto di vista ambientale. Grazie al progetto saranno risparmiati il 14% di energia termica, il 32% di energia elettrica e il 54% di quella impiegata per l’illuminazione pubblica e dei semafori. Risultati che si traducono in oltre 2.500 tonnellate all’anno di CO2 non emesse nell’atmosfera, equivalenti alla circolazione di 1.550 auto in meno sul territorio. Quello che stiamo presentando oggi è un progetto frutto di un attento lavoro di elaborazione e studio tra il Comune ed ENGIE durato mesi. - dichiara Rosanna Arru, Assessora ai Lavori pubblici e Manutenzioni del Comune di Sassari - Ciò che abbiamo voluto ottenere, e abbiamo ottenuto, è un impianto di illuminazione efficiente per tutto il territorio comunale, destinato a rimanere sempre altamente performante. Oltre ai lavori di efficientamento, fiore all'occhiello di questo progetto è infatti il software che ci permette di individuare immediatamente lampioni non funzionanti per porre rimedio velocemente e in modo efficace. Tutto questo, insieme all'installazione delle videocamere, aumenterà anche il senso di sicurezza della cittadinanza. “Il risparmio, la tutela ambientale e il miglioramento del servizio sono i punti cardine di questa virtuosa iniziativa amministrativa. ENGIE è Sassari hanno avviato un percorso molto innovativo che si ispira a un modello di città che sosteniamo, ovvero capace di conciliare la creazione di valore economico, una migliore qualità della vita e un impatto ambientale sociale e positivo sulla comunità”, sottolinea Claudio Galli, Direttore Area Centro ENGIE Italia. “Sono oltre 350 i Comuni italiani che accompagniamo nella transizione energetica, sviluppando soluzioni intelligenti e prodotti digitali applicabili che danno risultati reali, concreti e facilmente integrabili nei processi di governo delle amministrazioni pubbliche”. ... #notizie #news #breakingnews #cronaca #politica #eventi #sport #moda Read the full article

0 notes

Text

Rinnovata la convenzione per la banda larga di Legnano e Valle Olona

I sindaci dei sette comuni dell’aggregazione Legnano - Valle Olona (Legnano, Castellanza, Fagnano Olona, Gorla Maggiore, Gorla Minore, Olgiate Olona e Solbiate Olona) hanno sottoscritto una nuova convenzione per la regolazione dei rapporti sovracomunali ai fini del mantenimento della infrastruttura banda larga, progetto che prevedeva fin dai primi anni Duemila la realizzazione di una rete dati altamente performante e sicura, in grado di collegare i principali edifici pubblici dei Comuni aggregati. La convenzione scadrà il 30 giugno 2023 con eventuale proroga, al fine di garantire la connettività in essere tra i comuni e valutare la fattibilità di attività future migliorative, anche alla luce dei nuovi contesti tecnologici, normativi e di offerta di servizi presenti sul mercato.

Nel nostro comune continuano anche i lavori per la posa dell'infrastruttura in fibra da parte di Open Fiber per ridurre concretamente il digital divide e dare ai cittadini le stesse opportunità.

1 note

·

View note

Text

Quasi tutte le aziende stanno adottando Zero Trust, ma non riescono ancora a sfruttarne appieno il potenziale commerciale

La maggior parte delle aziende sta adottando Zero Trust, in particolare quelle con una forza lavoro distribuita o ibrida, ma la maggior parte deve ancora realizzare appieno i vantaggi offerti da questa pratica di sicurezza informatica relativamente nuova.

Gli esperti di sicurezza del cloud Zscaler hanno intervistato più di 1.900 responsabili delle decisioni IT senior presso organizzazioni che hanno già avviato la migrazione di applicazioni e servizi al cloud per il suo rapporto "State of Zero Trust Transformation" per il 2023 (si apre in una nuova scheda), rilevando che solo il 19% ha impostare un'infrastruttura basata sulla fiducia specifica per il lavoro ibrido.

Un ulteriore 50% sta attualmente lavorando all'implementazione della zero trust o è in fase di pianificazione. Argomenti per Zero Trust Tuttavia, solo il 22% degli intervistati è "pienamente fiducioso" che la propria organizzazione stia sfruttando tutto il potenziale della propria infrastruttura cloud, comprese le funzionalità Zero Trust. Ci sono molti vantaggi oggettivi nell'implementazione di Zero Trust in un contesto aziendale, ma per Zscaler, il miglioramento dell'esperienza dei dipendenti è l'argomento più forte.

Il 52% degli intervistati ha convenuto che Zero Trust risolverebbe il problema con un'esperienza di accesso incoerente per app e dati on-prem e basati su cloud.

Altrimenti, i leader IT si aspettano che Zero Trust affronti la perdita di produttività dovuta a problemi di accesso alla rete (46%) e alcuni affermano che la tecnologia aiuterebbe i dipendenti ad accedere alle app e ai dati aziendali dai dispositivi personali (39%). Zscaler ha scoperto che le aziende guidate dall'IT stanno trattando Zero Trust Network Access (ZTNA) come un investimento prioritario per il passaggio permanente ad ambienti di lavoro remoti e ibridi nei prossimi dodici mesi.

Più di un terzo (35%) intende abbracciare una cultura del lavoro completamente a distanza, mentre un ulteriore quarto (27%) sta prendendo in considerazione un modello ibrido. Solo due su cinque (38%) manterranno i propri dipendenti completamente in ufficio.

In quanto nascente insieme di principi di sicurezza, Zero Trust ha ancora molta strada da fare prima di sostituire completamente i vecchi metodi di sicurezza aziendale digitale.

Secondo il rapporto, oltre la metà degli intervistati (54%) considera le reti legacy, le VPN e i firewall perimetrali una tecnologia obsoleta, inefficace nella protezione dagli attacchi informatici e nel fornire un'adeguata visibilità sul traffico delle applicazioni.

Inoltre, due terzi (68%) concordano che la trasformazione sicura del cloud è impossibile con un'infrastruttura di sicurezza di rete legacy.

Zscaler afferma che Zero Trust ha "chiari vantaggi" rispetto ai tradizionali firewall e VPN, quando si tratta di proteggere l'accesso remoto alle applicazioni critiche. Dai dati, è chiaro che le organizzazioni potrebbero semplicemente avere un senso.

0 notes

Text

Pass the Ticket: come mitigarlo con un SOCaaS

Estimated reading time: 5 minutes Ogni anno cresce costantemente il numero di attacchi che minacciano la sicurezza di dispositivi, sistemi informatici, server e infrastrutture di rete. Questo avviene traendo vantaggio dalle vulnerabilità presenti in questi sistemi. Tra le tante tipologie di attacchi, bisogna prestare particolarmente attenzione all’attacco pass the ticket (PTT). Con un attacco pass the ticket è possibile sfruttare il protocollo di rete Kerberos, presente in tutti i principali sistemi operativi, per accedere alla sessione di un utente pur non avendo le sue credenziali d'accesso. Un attacco di questo tipo può essere difficile da rilevare e solitamente è in grado di aggirare i più comuni controlli d’accesso al sistema.

Pass The Ticket: cos'è e come funziona

Kerberos Prima di capire nel dettaglio cos'è e come funziona un attacco PTT è opportuno fare un po' di chiarezza sul protocollo di rete Kerberos dato che un attacco di questo tipo, sfrutta proprio questo protocollo. Kerberos è un protocollo di rete progettato dal MIT negli anni '80 ed è diventato uno standard IETF nel 1993. Viene usato per l'autenticazione forte tra diversi terminali tramite un sistema di crittografia a chiave simmetrica, senza trasmettere alcuna password. Il vantaggio nell'utilizzare il protoccolo Kerberos sta nel suo sistema di autenticazione forte tra client e server. Questo lo rende molto efficace contro i tentativi di phishing e contro gli attacchi "man in the middle". Kerberos è integrato in tutti i principali sistemi operativi appartenenti ad aziende note come Microsoft, Apple, Red Hat Linux e molte altre ancora. Con un attacco pass the ticket è possibile sfruttare l’autenticazione Kerberos per ottenere l’accesso ad un account utente. Le conseguenze che potrebbe comportare un avvenimento del genere non sono da sottovalutare. Tra i tanti scenari immaginabili ad esempio, ci potrebbe essere la possibilità che l’account compromesso goda di elevati privilegi amministrativi garantendo così all’hacker pieno accesso alle risorse. L'attacco Un attacco pass the ticket permette di ottenere un accesso privilegiato alle risorse di rete senza dover utilizzare alcuna password utente. Ecco come: in Active Directory, un Ticket Granting Ticket (TGT) ha la funzione di dimostrare che un utente è proprio chi dice di essere. Tramite alcuni strumenti e tecniche, un hacker potrebbe raccogliere questi ticket e utilizzarli per richiedere dei Ticket Granting Service (TGS) con il fine di accedere alle risorse presenti in altre parti della rete. Un attacco PTT potrebbe comportare dei rischi anche se l’account compromesso non gode di particolari privilegi amministrativi dal momento che l’hacker, tramite il Lateral Movment, potrebbe riuscire ad ottenere l’accesso ad altri account e dispositivi. La differenza tra il pass the ticket e un attacco pass the hash sta nel fatto che il primo sfrutta i ticket TGT che hanno una scadenza di poche ore, mentre il secondo utilizza gli hash NTLM che cambiano solo nel caso in cui un utente decida di cambiare la sua password. Un ticket TGT deve essere utilizzato entro i tempi della sua scadenza oppure va rinnovato per un periodo di tempo più lungo.

Come difendersi e prevenire un attacco Pass The Ticket

Mantenere sicura una rete e i dispositivi ad essa connessi è un fattore molto importante. Bisogna sempre avere protocolli e software che riescano a garantire una protezione efficace da ogni tipo di minaccia, con sistemi aggiornati che mantengano le informazioni sensibili al sicuro. Le aziende possono avvalersi di tecnologie di rilevamento e risposta degli endpoint. Sarà possibile il rilevamento locale di più ticket utilizzati per la stessa sessione. Caso account senza privilegi Nel caso in cui avvenga un attacco pass the ticket, se l'account compresso a cui è stato sottratto il TGT o il TGS era un account con privilegi limitati, la mitigazione potrebbe essere abbastanza semplice. Basta reimpostare la password di Active Directory dell’utente. Un'azione simile invaliderebbe il TGT o il TGS, impedendo all’hacker di generare nuovi ticket. Caso account con privilegi Al contrario, se l'attacco PTT ha compromesso un account privilegiato, limitare il danno è molto più difficile. In questi casi, le aziende potrebbero rispondere all’attacco reimpostando il servizio Kerberos TGT in modo da generare una nuova chiave di firma, assicurandosi di eliminare la chiave compromessa. Successivamente è necessario analizzare nel dettaglio i registri Kerberos e le informazioni di Active Directory per investigare e scoprire a quali risorse di rete sono state compromesse. In questo modo si ha anche modo di capire quali dati potrebbero essere stati sottratti. La tecnologia SIEM consente alle organizzazioni di assimilare, analizzare e analizzare questi dati.

Protezione dall'attacco Per garantire una protezione completa ad una infrastruttura, impedendo anche attacchi pass the ticket, è bene usare tecnologie di rilevamento valide come UEBA e SIEM. Infatti, è possibile prevenire attacchi Pass The Ticket analizzando il comportamento degli utenti e delle entità. La soluzione UEBA, in questi casi, assicurerebbe l'identificazione rapida di qualsiasi account compromesso, bloccandolo in modo da mitigare i danni. Alcuni software SIEM inoltre, permettono non solo di analizzare i tradizionali logs ma sono in grado anche di fornire un'analisi accurata della sicurezza, analizzando il comportamento della rete e degli utenti in modo da rilevare tempestivamente la presenza di eventuali minacce all’infrastruttura.

Conclusioni

Abbiamo visto cos'è un attacco pass the ticket e in che modo le aziende possono adottare soluzioni specifiche per intercettare i pericoli e le anomalie di un'intera infrastruttura informatica. Possiamo così mitigare più efficacemente le minacce. Una soluzione completa, come abbiamo visto, coinvolge un monitoring costante e granulare delle comunicazioni. La soluzione che proponiamo a questo scopo è un SOCaaS. Se vuoi conoscere i nostri servizi dedicati alla sicurezza, non esitare a contattarci. Puoi usare il pulsante qui sotto, saremo lieti di rispondere a qualsiasi tua domanda. - Pass the hash: come guadagnare accesso senza la password - Attacco Magecart: cos'è e come proteggersi - I più recenti attacchi Ransomware nel 2021 Read the full article

0 notes

Text

Infinidat: come cambia il concetto di resilienza

New Post has been published on https://is.gd/3g7R1B

Infinidat: come cambia il concetto di resilienza

“Solo grazie a una profonda resilienza le aziende potranno valutare e affrontare al meglio scenari imprevedibili per i quali non è ancora possibile prevedere gli sviluppi futuri“. Così afferma Donato Ceccomancini, Country Manager Infinidat Italia.

La crisi globale causata dall’emergenza da Covid-19 ha influito drasticamente sulle imprese e in particolare sulla loro capacità di affrontare il cambiamento. Nessuno si aspettava, né stimava la portata di questa crisi, che lascia ancora tanti punti interrogativi sul futuro del mercato economico, sia a livello locale sia globale.

A oggi, le previsioni pubblicate sono per lo più approssimative e l’incertezza resta alta: sebbene, infatti, la quarantena sia terminata e molti Paesi abbiano riaperto le frontiere, la maggior parte delle attività viene ancora gestita con grande timore e sono in atto ancora alcune restrizioni. Al momento, però, non è possibile stabilire per quanto questa situazione si protrarrà nel tempo.

La maggior parte delle imprese ha messo in campo tutte le risorse a propria disposizione per riprendersi dai colpi inferti dal lockdown, ma è chi ha imparato velocemente ad adattarsi e a essere più flessibile che si è assicurato un vantaggio competitivo e la tecnologia ha giocato un ruolo importante in questo scenario.

Il concetto di “resilienza” è cambiato

Resilienza è un concetto piuttosto noto nel settore dell’IT, e si riferisce alla capacità di una rete o di una infrastruttura IT di adattarsi ai cambiamenti ed essere in grado di proteggere l’azienda e i relativi clienti da “disastri” o gravi interruzioni di servizio. Un’azienda che ha investito nella resilienza della propria infrastruttura IT sarà in grado di riprendersi rapidamente e continuare a svolgere il proprio lavoro esattamente come prima del “disastro” o dell’interruzione.

Quando si parla di disastro ci si riferisce a incendi, inondazioni, guerre o attacchi informatici e, in ognuno di questi casi, la resilienza è il fattore chiave per rimettere in piedi velocemente l’azienda, consentendole di procedere con la normale routine organizzativa come se il disastro non si fosse mai verificato.

Tuttavia, questo non è stato sufficiente per contrastare la crisi globale causata dal Covid-19, perché non è possibile ristabilire la routine di prima dell’emergenza. Le aziende sono state costrette a modificare le proprie abitudini, e a farlo in fretta, per poter sopravvivere e distinguersi nel mercato. Tornare al periodo precedente alla crisi per molti significherebbe una sicura condanna a morte.

In questi mesi, le aziende hanno dovuto reinventarsi e accelerare le attività digitali. Le imprese di commercio al dettaglio di generi alimentari, ad esempio, hanno dovuto migliorare il sistema di consegna a domicilio e implementare una piattaforma informatica adeguata ad accogliere il significativo incremento della domanda. Allo stesso modo, la maggior parte dei Ministeri come quelli dell’Istruzione, della Sanità, delle Finanze e persino della Difesa, che sono più abituati a cambiamenti radicali, hanno dovuto affrontare una situazione mai vissuta prima, predisponendo che tutte le attività fossero gestite da remoto. Banche, compagnie assicurative e servizi sanitari, invece, hanno dovuto chiudere rapidamente le proprie filiali/sedi di lavoro e organizzarsi al meglio per consentire ai dipendenti di lavorare da casa, mentre commercializzavano i servizi attraverso applicazioni avanzate e servizi online.

Purtroppo, non è ancora possibile prevedere quando l’emergenza da Covid-19 terminerà e quindi è importantissimo fare di tutto per essere pronti a gestire velocemente il cambiamento, trasformando i propri modelli di business. Tutto questo richiede aumento enorme e in tempi brevi dei requisiti IT per un periodo di tempo sconosciuto.

Come fornire nuova resilienza all’azienda?

Per consentire all’azienda di cambiare rapidamente e adattarsi alla realtà in continua evoluzione la parola d’ordine è flessibilità e quest’ultima può esprimersi concretamente in due modi:

Tecnologia on-demand

I provider di tecnologia hanno accolto la richiesta di maggiore flessibilità dei propri clienti, offrendo loro nuovi modelli di servizi e tecnologia on-demand. Nel campo dello storage, ad esempio, ciò consente alle imprese di aumentare e diminuire la capacità disponibile per l’archiviazione dei dati secondo le proprie necessità. In questo modo è possibile avviare progetti e rispondere rapidamente ai cambiamenti del mercato con prodotti innovativi, senza ricorrere a modelli di acquisto costosi e complessi. La fornitura di capacità di archiviazione on-demand è stata una boccata d’aria fresca per molte aziende, che stanno lottando per rimanere competitive e assicurarsi un futuro sul mercato e che, quindi, non possono permettersi l’implementazione di sistemi storage complessi o ingenti spese per investire sul cloud storage.

Riduzione dell’accessibilità fisica nei data center da parte dei tecnici

La crisi da Covid-19 ha fatto emergere l’importanza di poter limitare il più possibile la presenza fisica all’interno dei data center per le attività di manutenzione ordinaria o straordinaria. Nel campo dello storage, è essenziale ridurre al minimo il numero di volte in cui è necessario accedere fisicamente a un data center ed eseguire operazioni di riparazione di malfunzionamenti. L’elevata ridondanza dell’hardware, a livello di multipli elementi per ogni singolo componente, consente di far fronte a qualsiasi malfunzionamento, senza necessariamente intervenire con emergenza immediata. Cioè, consente di pianificare e posticipare l’intervento quando possibile, in modo che l’azienda non vada in un’emergenza. La tranquillità non ha concorrenza in questi tempi difficili.

“La resilienza deve ora consentire all’azienda, non solo di poter lavorare come prima della crisi, ma di valutare e affrontare al meglio scenari imprevedibili, dei quali non si è ancora in grado di prevedere gli sviluppi futuri. Le imprese che saranno in grado di raggiungere un tale livello di resilienza avranno dalla loro un forte vantaggio competitivo e continueranno ad assicurarsi la flessibilità necessaria per superare i cambiamenti drastici dettati dal mercato. È tempo che tutti i provider tecnologici siano in grado di offrire alle imprese modelli di consumo flessibili per portare garantire maggiore innovazione sul mercato e permettere alle aziende di affrontare la nuova normalità”, spiega Ceccomancini.

0 notes

Text

Cloud Storage on-premise (e GDPR compliant) con NextCloud

In questo articolo parleremo di NextCloud, un innovativo sistema di cloud storage on-premise installabile gratuitamente su server Linux (o Virtual Machine o Container Docker) e dotato di funzionalità molto simili a quelle di Dropbox e Google Drive, pur con tutte le limitazioni del caso in termini di ridondanza e disponibilità. Rispetto ai competitor (primo tra tutti OwnCloud, di cui costituisce un fork, ovvero una evoluzione parallela del progetto), NextCloud dimostra una attenzione particolare verso la sicurezza, la privacy compliance e il GDPR, implementando una serie di tecnologie di data-encryption in-transit, at-rest e end-to-end al fine di assicurare un livello di sicurezza elevato: per questo motivo ha attirato immediatamente la nostra attenzione. A chiunque avesse bisogno di un ripasso su questi argomenti consigliamo, prima di addentrarsi nella lettura di questo articolo, di dare un'occhiata alla nostra guida al Cloud Storage SaaS e on-premise pubblicata qualche giorno fa.

Installazione

Nella prova che abbiamo fatto, abbiamo installato NextCloud su una normalissima macchina Linux CentOS 7 con web server NGINX e sistema di caching basato su FastCGI-cache. Si tratta di una modalità di configurazione particolarmente indicata per la maggior parte delle applicazioni web basate su PHP, da Wordpress a MediaWiki a Mantis Bug Tracker. L'intera procedura di installazione è durata pochi minuti, grazie all'ottima documentazione disponibile sul sito ufficiale. . Nel nostro caso, avendo a disposizione una macchina Linux CentOS, abbiamo seguito in modo pressoché letterale le istruzioni per CentOS, oon l'unica differenza di aver installato e configurato NGINX in luogo di Apache, senza incontrare problemi di sorta. Questi, in estrema sintesi, i principali passaggi effettuati: Installare una macchina virtuale CentOS 7 (minimal install). Installare una serie di prerequisiti necessari (unzip, curl, wget, mlocate, bzip2, etc.). > yum install -y epel-release yum-utils unzip curl wget \ bash-completion policycoreutils-python mlocate bzip2 Aggiornare CentOS e tutti i pacchetti installati durante l'installazione: > yum update -y Installare NGINX e impostarlo come servizio in esecuzione automatica all'avvio del sistema: > yum install -y nginx > systemctl enable nginx > systemctl start nginx Installare PHP e una serie di librerie e symlink necessari: > yum install -y centos-release-scl > yum install -y rh-php72 rh-php72-php rh-php72-php-gd rh-php72-php-mbstring \ rh-php72-php-intl rh-php72-php-pecl-apcu rh-php72-php-mysqlnd rh-php72-php-pecl-redis \ rh-php72-php-opcache rh-php72-php-imagick > ln -s /opt/rh/httpd24/root/etc/httpd/conf.d/rh-php72-php.conf /etc/httpd/conf.d/ > ln -s /opt/rh/httpd24/root/etc/httpd/conf.modules.d/15-rh-php72-php.conf /etc/httpd/conf.modules.d/ > ln -s /opt/rh/httpd24/root/etc/httpd/modules/librh-php72-php7.so /etc/httpd/modules/ > ln -s /opt/rh/rh-php72/root/bin/php /usr/bin/php Configurare PHP-FPM nella modalità FastCGI-cache seguendo le istruzioni descritte in questa guida. Installare MariaDB e impostarlo come servizio in esecuzione automatica all'avvio del sistema: > yum install -y mariadb mariadb-server > systemctl enable mariadb.service > systemctl start mariadb.service Configurare MariaDB con le impostazioni di sicurezza necessarie per l'accesso in modalità sicura (ivi inclusa la password di root): > mysql_secure_installation Configurare le impostazioni di MariaDB utilizzando la relativa guida sul sito di NextCloud. Installare redis e impostarlo come servizio in esecuzione automatica all'avvio del sistema: > yum install -y redis > systemctl enable redis.service > systemctl start redis.service Scaricare e installare l'ultima versione dell'archivio di NextCloud dalla pagina di download del sito ufficiale (Server > Download > Archive File for server owners), in formato tar.bz2 oppure zip. Scompattare l'archivio all'interno di una cartella, ad es. /var/www/nextcloud/. Assegnare i permessi necessari per l'accesso dell'utente e del gruppo relativi a NGINX (nel caso di esempio, nginx e www): > chown -R nginx:www /var/www/nextcloud Impostare il file di configurazione di NGINX /etc/nginx/nginx.conf con i parametri necessari per gestire le richieste HTTP in ingresso dirette verso la URL che si desidera associare all'applicazione web di NextCloud, ad es. nextcloud.mydomain.com: upstream php-nextcloud { server unix:/run/php7-fpm-nextcloud.sock; } server { listen 80; listen :80; server_name nextcloud.mydomain.com; return 301 https://$server_name$request_uri; } server { listen 443 ssl http2; listen :443 ssl http2; server_name nextcloud.mydomain.com; root /var/www/nextcloud/; location / { add_header X-Content-Type-Options nosniff; add_header X-XSS-Protection "1; mode=block"; add_header X-Robots-Tag none; add_header X-Download-Options noopen; add_header X-Permitted-Cross-Domain-Policies none; location = /robots.txt { allow all; log_not_found off; access_log off; } # The following 2 rules are only needed for the user_webfinger app. # Uncomment it if you're planning to use this app. #rewrite ^/.well-known/host-meta /public.php?service=host-meta last; #rewrite ^/.well-known/host-meta.json /public.php?service=host-meta-json # last; location = /.well-known/carddav { return 301 $scheme://$host/remote.php/dav; } location = /.well-known/caldav { return 301 $scheme://$host/remote.php/dav; } # set max upload size client_max_body_size 512M; fastcgi_buffers 64 4K; # Enable gzip but do not remove ETag headers gzip on; gzip_vary on; gzip_comp_level 4; gzip_min_length 256; gzip_proxied expired no-cache no-store private no_last_modified no_etag auth; gzip_types application/atom+xml application/javascript application/json application/ld+json application/manifest+json application/rss+xml application/vnd.geo+json application/vnd.ms-fontobject application/x-font-ttf application/x-web-app-manifest+json application/xhtml+xml application/xml font/opentype image/bmp image/svg+xml image/x-icon text/cache-manifest text/css text/plain text/vcard text/vnd.rim.location.xloc text/vtt text/x-component text/x-cross-domain-policy; # Uncomment if your server is build with the ngx_pagespeed module # This module is currently not supported. #pagespeed off; location / { rewrite ^ /index.php$uri; } location ~ ^/(?:build|tests|config|lib|3rdparty|templates|data)/ { deny all; } location ~ ^/(?:\.|autotest|occ|issue|indie|db_|console) { deny all; } location ~ ^/(?:index|remote|public|cron|core/ajax/update|status|ocs/v|updater/.+|ocs-provider/.+)\.php(?:$|/) { fastcgi_split_path_info ^(.+\.php)(/.*)$; include fastcgi_params; fastcgi_param SCRIPT_FILENAME $document_root$fastcgi_script_name; fastcgi_param PATH_INFO $fastcgi_path_info; #fastcgi_param HTTPS on; #Avoid sending the security headers twice fastcgi_param modHeadersAvailable true; fastcgi_param front_controller_active true; fastcgi_pass php-nextcloud; fastcgi_intercept_errors on; fastcgi_request_buffering off; } location ~ ^/(?:updater|ocs-provider)(?:$|/) { try_files $uri/ =404; index index.php; } # Adding the cache control header for js and css files # Make sure it is BELOW the PHP block location ~ \.(?:css|js|woff|svg|gif)$ { try_files $uri /index.php$uri$is_args$args; add_header Cache-Control "public, max-age=15778463"; add_header X-Content-Type-Options nosniff; add_header X-XSS-Protection "1; mode=block"; add_header X-Robots-Tag none; add_header X-Download-Options noopen; add_header X-Permitted-Cross-Domain-Policies none; # Optional: Don't log access to assets access_log off; } location ~ \.(?:png|html|ttf|ico|jpg|jpeg)$ { try_files $uri /index.php$uri$is_args$args; # Optional: Don't log access to other assets access_log off; } } } Ovviamente, trattandosi di una procedura fortemente dipendente dalle caratteristiche hardware e software della macchina server, è probabile qualcuno dei passaggi sopra indicati vada rivisto, modificato o ampliato di conseguenza. Ci siamo inoltre occupati solo dei passaggi strettamente necessari per l'installazione di NextCloud e dei package strettamente necessari, omettendo alcuni importanti aspetti come la configurazione di sendmail (fondamentale per l'invio di e-mail da parte di NextCloud), il fine-tuning dei parametri di configurazione presenti nei file php.ini (PHP) e my.cnf (MariaDB), e tutta una serie di altre attività necessarie per il corretto funzionamento del servizio. Se riscontrate problemi in fase di installazione vi invitiamo a farcelo sapere nei commenti in fondo a questo articolo, così da poter aggiungere ulteriori dettagli a quanto scritto sopra e/o fornirvi i suggerimenti del caso.

Casi d'uso

Quando si ha l'esigenza di archiviare o condividere dei file e si dispone della possibilità di utilizzare una istanza privata di NextCloud è importante porsi una domanda preliminare: l'utilizzo di tale strumento è realmente giustificato oppure no? Dare una risposta affermativa a questa domanda significa aver valutato con ragionevole certezza che non siano disponibili metodi di condivisione oggettivamente più sicuri, controllati e pratici per svolgere la medesima attività: ad esempio, se si ha bisogno di condividere alcuni documenti con un collega all'interno della stessa infrastruttura di rete aziendale, l'utilizzo di NextCloud potrebbe essere meno ottimale rispetto a una semplice cartella di rete... a meno che non vi siano degli evidenti e oggettivi vantaggi a sostegno della prima ipotesi, come ad esempio la necessità di rendere i suddetti documenti accessibili anche dall'esterno e/o da destinatari al di fuori della rete aziendale. Insomma, è sempre molto importante analizzare con attenzione il caso specifico così da poter prendere la decisione più adeguata alle proprie esigenze. Nella maggior parte dei casi, per la nostra esperienza d'uso, l'utilizzo di NextCloud come strumento di memorizzazione e/o condivisione dei file si rivela ideale quando si ha almeno una delle seguenti esigenze: Creazione di archivi accessibili da utenti sia interni che esterni alla rete aziendale. Condivisione e/o ricezione di file con utenti sia interni che esterni alla rete aziendale. Superamento di alcuni limiti imposti dal file-system, come ad esempio la necessità di effettuare catalogazioni ulteriori e superiori a quelle mono-direzionali previste con il semplice folder nesting previsto dai sistemi di memorizzazione tradizionali, come l'utilizzo di tag, categorie, metadati e altre tassonomie. Come si può facilmente vedere due esigenze su tre prevedono la presenza di un interlocutore esterno, in assenza del quale la scelta strategica di implementare soluzioni di Cloud Storage on-premise come NextCloud potrebbe avere poco senso. A conti fatti, è probabile che, nella maggior parte dei casi, utilizzeremo NextCloud in quel sottoinsieme di casi particolari in cui abbiamo bisogno di condividere i nostri file con persone che non hanno la possibilità di accedere ai suddetti servizi: è il caso, ad esempio, di clienti e fornitori, ma anche di colleghi che non si trovano sul posto di lavoro, non hanno la possibilità di collegarsi da remoto e/o hanno necessità di dover accedere a un file da una postazione diversa o non opportunamente configurata. Condivisione interna o tramite link? Le principali funzionalità di NextCloud che andremo ad approfondire nei paragrafi successivi sono quelle relative all'archiviazione e alla condivisione di file, ovvero la possibilità di memorizzare nell'archivio uno o più file e impostare le modalità di accesso agli stessi attraverso le due principali modalità di condivisione supportate: il sistema di permessi e ruoli, per condividere file e cartelle con altri utenti dotati di un account su quello stesso server NextCloud. il sistema di condivisione tramite link, per condividere file e cartelle con tutti gli utenti "anonimi", ovvero chiunque non possieda un account. Prima di procedere con la guida, è opportuno comprendere è che le due modalità di condivisione di cui sopra sono, o per meglio dire dovrebbero essere, mutuamente esclusive: nessun utente che disponga di un account di accesso al nostro server NextCloud dovrebbe ricevere una condivisione tramite link, che è per sua natura un sistema meno sicuro e più limitato; al tempo stesso, non è pensabile creare un account di accesso personale a tutti gli utenti "anonimi" ai quali inviamo saltuariamente dei file. Anche in questo caso è dunque opportuno effettuare una attenta analisi al fine di determinare quale tipologia di accesso è opportuno prevedere per ciascuno dei nostri potenziali utenti.

Funzionamento

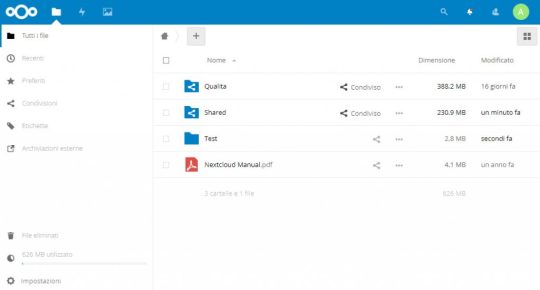

Il funzionamento di NextCloud è piuttosto semplice grazie alla pratica interfaccia web, che ricorda piuttosto da vicino quella di servizi come Dropbox e Google Drive. Una volta effettuato il login ci si troverà di fronte alla schermata principale, che contiene già una panoramica dei file e delle cartelle alle quali è possibile effettuare l’accesso.

Ovviamente, saranno visualizzate soltanto le cartelle e i file ai quali l’account a noi assegnato è stato autorizzato ad accedere in lettura e/o in scrittura.

Caricare file e cartelle

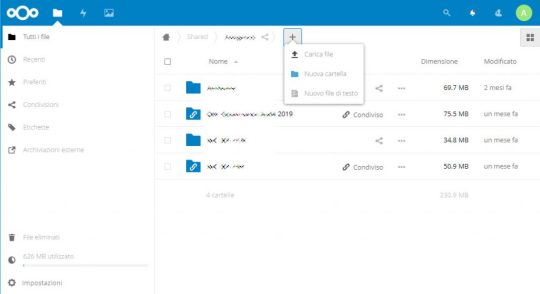

L’utilizzo principale di NextCloud consiste nel caricamento (upload) di uno o più file e/o cartelle da rendere disponibili, come detto più volte, tramite condivisione interna o link. Per ragioni di praticità, quando l'intento è quello di condividere file tramite link, è consigliabile creare una nuova cartella, all’interno della quale potremo caricare uno o più file da condividere: tale cartella sarà l’oggetto che andremo poi a condividere con il destinatario, che potrà accedere anche a tutti gli oggetti (file e/o sottocartelle) ivi contenuti, anche se caricati in un secondo tempo, nonché - se imposteremo la cartella in modo particolare, come avremo modo di vedere tra poco - inviare file. Creazione di una nuova cartella Per creare una nuova cartella occorre posizionarsi all’interno della cartella radice, ovvero la cartella che farà da "parent" alla nostra nuova creazione. Inutile dire che, come avviene in tutti gli archivi, è opportuno darsi fin da subito (a se stessi e ai propri collaboratori) delle regole, o per meglio dire delle naming convention, adeguate: ad esempio, noi abbiamo deciso di creare tutte le cartelle contenenti file condivisi tramite link all'interno di una cartella radice apposita, denominata /Shared/, così da renderli distinti dai file ad uso interno. Le nostre cartelle condivise saranno dunque: /Shared/Mail_2387/ /Shared/Date_201907171621/ /Shared/ID_12123488/ /Shared/Orizzonti/Ref_2218277127/ E così via. In alcuni casi, come possiamo vedere, abbiamo creato una o più sottocartelle all'interno della cartella radice dedicate a clienti, commesse o progetti particolarmente importanti: se i file che dobbiamo condividere sono collegati a quel raggruppamento andremo a creare la nuova cartella all’interno di quella sottocartella, così da evitare di creare tutto nella cartella principale. Una volta all’interno nella cartella radice (o nella sottocartella) scelta, possiamo creare la nuova cartella facendo click sul pulsante “+” presente in alto e selezionare “Nuova cartella”.

Anche per quanto riguarda il nome da assegnare alla nuova cartella è senz'altro opportuno stabilire alcuni criteri di naming, soprattutto se la piattaforma sarà utilizzata da più persone. Queste sono le regole che noi abbiamo deciso di adottare: Se esiste un riferimento univoco riconducibile alla condivisione (ID pratica, ID cliente, etc.), utilizzare “_”, ad esempio ID_138188139, Ryadel_1249848 e via dicendo. In assenza di un nome applicativo, utilizzare il nome del cliente (es. /Orizzonti_23804/) o un generico “Ref”. In tutti gli altri casi, utilizzare “Date_yyyyMMddHHmm”, (anno, mese, giorno, minuti, secondi), ad esempio, Date_201907161358 per una cartella creata il 16 luglio 2019 alle ore 13:58. Ovviamente si tratta soltanto di convenzioni, che possono essere modificate o adattate alle proprie esigenze: l'importante è concordare criteri di naming uniformi e predeterminati, al fine di ridurre la confusione all’interno dell’archivio. In ogni caso, per ovvie ragioni di rispetto della privacy, consigliamo di non utilizzare dati personali (es. il nome, il cognome, il telefono o l’e-mail di un determinato utente o assistito) all’interno del nome della nuova cartella. Caricamento dei file Una volta creata la nuova cartella, è possibile caricare uno o più file (o altre cartelle) al suo interno tramite drag-and-drop dal desktop (o da Esplora Risorse) alla finestra di NextCloud all’interno del browser, oppure utilizzando l’apposita funzione Carica file accessibile mediante il pulsante “+” in alto.

Condivisione di file e cartelle

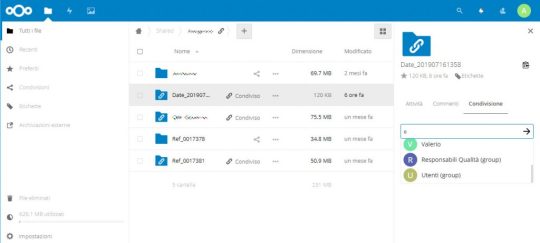

Nel momento in cui creiamo una nuova cartella, quest'ultima erediterà i permessi di condivisione dalla sua cartella madre: questo significa che sarà visualizzabile e/o modificabile da tutti gli utenti (interni o esterni) per i quali è stata attivata una impostazione di condivisione sulla cartella contenitrice. Le cartelle create nella root non ereditano alcun permesso di condivisione e non saranno quindi visibili ad alcuno, se non a noi. Condivisione ad uso interno In conseguenza di questo detto nel paragrafo precedente possiamo facilmente capire come, nella maggior parte dei casi, quando si crea una cartella destinata all'uso interno questa risulterà già condivisa nel modo corretto, ereditando le impostazioni di condivisione dalla cartella madre... a meno che non sia creata nella root. Ad ogni buon conto, per assegnare permessi dedicati a una cartella occorre effettuare i seguenti passaggi: Fare click sull’icona della condivisione presente a destra del nome della cartella: questa azione provocherà l'apertura di un pannello contestuale sulla parte destra dello schermo. All'interno del nuovo pannello, selezionare il tab Condivisione, quindi utilizzare la casella di testo presente per cercare utenti e/o gruppi con i quali condividere la cartella.

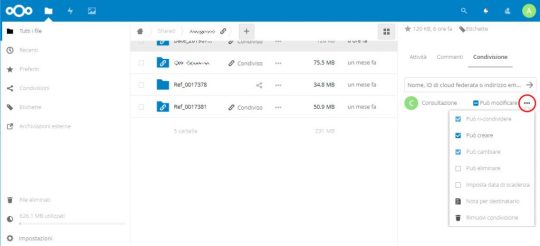

Opzioni di condivisione interna Una volta attivata la condivisione interna è opportuno fare click sulla three-dots icon posta alla destra della checkbox stessa: una volta fatto si aprirà un secondo pannello contenente una serie di opzioni di condivisione aggiuntive. Tramite queste opzioni è possibile impostare le modalità di accesso alla cartella (o al file) dell'utente che abbiamo autorizzato.

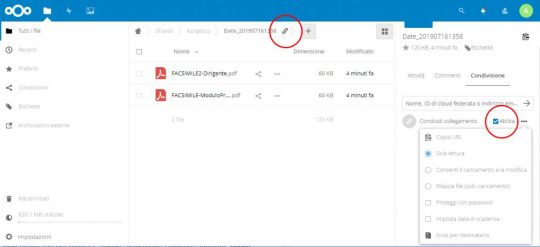

Le opzioni di condivisione interna sono abbastanza auto-esplicative: oltre al permesso di lettura, ovvero di accesso e download del file, è possibile assegnare una serie di permessi ulteriori: creare (caricare) nuovi file/cartelle, cambiare(modificare) ovvero eliminare file e cartelle preesistenti, ri-condividere la cartella e/o il suo contenuto ad altri utenti interni e/o esterni, e così via. C'è anche la possibilità di inserire una nota per il destinatario, che sarà visualizzata all'accesso di quest'ultimo. L'opzione più interessante, su cui vale la pena spendere qualche parola, è quella che consente di impostare una data di scadenza. Per impostazione predefinita, le condivisioni interne hanno durata illimitata: questo singnifica che l'utente, una volta abilitato all'accesso (o alla modifica) della cartella, manterrà questo privilegio a tempo indeterminato. L'opzione imposta una data di scadenza consente di modificare questo assunto, assegnando una durata temporale alla condivisione. Si tratta di una funzionalità che, nel caso delle condivisioni interne, rischia di trovare scarsa applicazione pratica, ma - come avremo modo di vedere tra poco - risulterà fondamentale in ottica di condivisione esterna o tramite link. Condivisione tramite link Per condividere la cartella tramite link la procedura è sostanzialmente la medesima, con una singola differenza: Fare click sull’icona della condivisione presente a destra del nome della cartella: questa azione provocherà l'apertura di un pannello contestuale sulla parte destra dello schermo. All'interno del nuovo pannello, selezionare il tab Condivisione, quindi abilitare la checkbox Condividi collegamento.

Opzioni di condivisione tramite link Una volta attivata la condivisione, interna o esterna che sia, è opportuno fare click sulla three-dots icon posta alla destra della checkbox stessa: una volta fatto si aprirà un secondo pannello contenente una serie di opzioni di condivisione aggiuntive. Tramite queste opzioni è possibile: Copiare l’URL del collegamento, funzionalità indispensabile per poterlo comunicare all’utente. Impostare la modalità di condivisione. Il valore predefinito è Sola Lettura, che consentirà al destinatario del link di visualizzare i file contenuti nella cartella ed effettuarne il download, ma non di cancellarli, modificarli o aggiungerne di nuovi. Nell’eventualità in cui volessimo consentire queste operazioni, è possibile selezionare Consenti il caricamento e la modifica oppure Rilascia file (solo caricamento). La prima alternativa può essere utile se si desidera che l’utente esterno possa inviarci nuovi file e/o modificare i file che intendiamo mettergli a disposizione, la seconda se vogliamo limitarlo alla sola aggiunta di nuovi file, impedendogli la modifica di quelli già presenti / già caricati. Impostare una password. Questa funzione riveste un’importanza fondamentale: in mancanza di una password di accesso, chiunque dovesse entrare in possesso del link di condivisione potrà automaticamente avere accesso ai file, con le modalità previste dall’opzione precedente (ovvero, potenzialmente, anche con possibilità di effettuare upload e modifiche). Per ovviare a questo problema suggeriamo di impostare sempre una password di accesso alla condivisione tramite questa opzione, avendo cura di crearne una avente complessità adeguata (min. 8 caratteri con maiuscola, minuscola, numero e carattere speciale). Impostare una data di scadenza. Per impostazione predefinita i link univoci creati per la condivisione hanno durata illimitata: ovviamente questo non è ideale nella maggior parte dei casi, visto che si tratta di condivisioni che si suppone esauriscano la loro funzione nel giro di pochi giorni/settimane. Per questo motivo è imperativo impostare una data di scadenza, con durata variabile a seconda dei casi (1, 10, 30, 60, 90 o 180 giorni). Allo scattare della data di scadenza impostata il collegamento per la condivisione sarà automaticamente rimosso e quindi non sarà più possibile accedere al file con quella modalità: al tempo stesso, il file non sarà eliminato. Si tratta quindi di una retention policy che ha effetto solo sull’accesso ai dati, non sulla conservazione dei dati stessi.

Applicazioni

Tra le funzionalità più interessanti che abbiamo trovato esplorando le moltissime funzionalità offerte NextCloud vi è il pannello Applicazioni, un vero e proprio elenco di moduli aggiuntivi che funzionano in modo simile alle estensioni di Google Chrome e/o ai plugin di Wordpress: ciascuna applicazione consente di arricchire la propria istanza NextCloud con funzionalità uniche, alcune delle quali estremamente potenti.

Tra le molte Applicazioni che abbiamo provato, suggeriamo di dare un'occhiata alle seguenti: Files automatic tagging, che consente di assegnare dei tag (etichette, nella traduzione italiana) a seconda del nome, tipo e posizione dei file che vengono caricati. External storage support, che consente di associare sistemi e servizi di data storage esterni. Default encryption module, che abilita all'utilizzo di diverse funzionalità di data encryption. Retention, che può essere utilizzata per impostare delle regole di eliminazione dei file e delle cartelle sulla base di vari parametri. Per ovvie ragioni di tempo e di spazio non riteniamo opportuno approfondire queste applicazioni all'interno di questo articolo: ci limiteremo ad analizzarne due, che ci sono sembrate particolarmente interessanti: Files automatic tagging e Retention, che - se utilizzate insieme - consentono di impostare delle regole di retention che possono rivelarsi particolarmente utili per il rispetto del considerando 39 del GDPR: Da qui l'obbligo, in particolare, di assicurare che il periodo di conservazione dei dati personali sia limitato al minimo necessario. I dati personali dovrebbero essere trattati solo se la finalità del trattamento non è ragionevolmente conseguibile con altri mezzi. Onde assicurare che i dati personali non siano conservati più a lungo del necessario, il titolare del trattamento dovrebbe stabilire un termine per la cancellazione o per la verifica periodica.

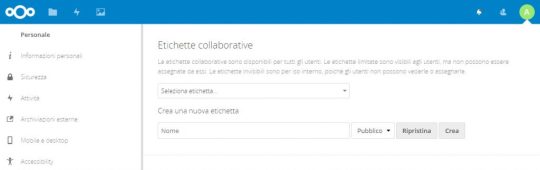

Impostare una Retention tramite le Etichette

La possibilità di impostare le etichette, ovvero dei meta tag che consentono di classificare i file, è una funzionalità di base di NextCloud. L'applicazione Retention, una volta installata e attivata, consente di creare delle regole per pianificare l'eliminazione automatica di file e/o cartelle che presentino determinate caratteristiche - tra cui la presenza di determinate etichette. L'applicazione Files automatic tagging, anch'essa da installare e attivare, consente infine di assegnare automaticamente delle etichette al momento del caricamento di file e/o cartelle che presentino determinati requisiti. Unendo queste tre cose siamo riusciti a impostare una vera e propria policy di retention per i file e le cartelle caricate all'interno della cartella radice /Shared/, ovvero - per intenderci - alle copie dei file che intendiamo condividere tramite link. Trattandosi di copie, quindi di duplicati che è opportuno eliminare quando cessano di avere la loro utilità, questi dati costituiscono le cavie perfette per il nostro test. La prima cosa che abbiamo fatto è creare le seguenti etichette pubbliche: Eliminare dopo 10 giorni Eliminare dopo 30 giorni Eliminare dopo 60 giorni Eliminare dopo 90 giorni Eliminare dopo 180 giorni Per farlo, è sufficiente andare nelle Impostazioni > Amministrazione > Flusso di Lavoro e utilizzare il mini-form presente in alto:

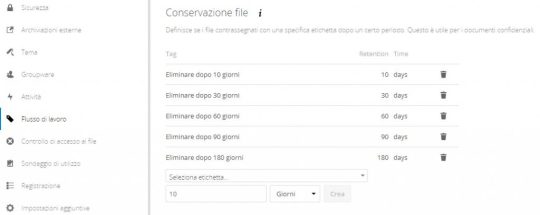

Una volta fatto questo, ci siamo spostati nel pannello inferiore della sezione flusso di lavoro e abbiamo configurato delle regole di retention basandoci sulla presenza delle etichette appena create, nel seguente modo:

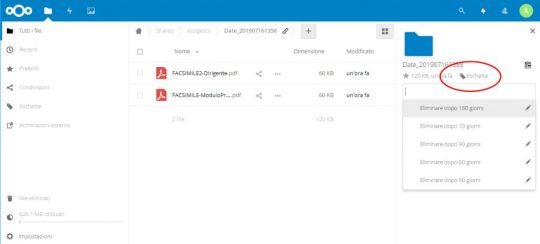

Come si può vedere, le regole di eliminazione che abbiamo impostato corrispondono esattamente a quanto riportato nel nome di ciascuna etichetta: in conseguenza di ciò, per attribuire un periodo di retention alla nostra cartella (e a tutto il suo contenuto) non dovremo fare altro che assegnare alla cartella stessa una delle etichette di retention che abbiamo definito. Per assegnare un'etichetta a una cartella, è sufficiente fare click sull’icona delle Etichette, presente nella parte in alto a destra del panello di condivisione e selezionare l’etichetta corrispondente.

In buona sostanza, quella che abbiamo creato è una vera e propria data retention policy completamente automatizzata: con un pò di pazienza (e data-entry) è possibile creare un numero di etichette ancora maggiore e gestire politiche di cancellazione anche più in là nel tempo (ad esempio in anni), così da poter gestire la maggior parte dei dati trattati. Ecco dunque un ulteriore valido motivo per utilizzare NextCloud come sistema di archiviazione! Inutile dire che l'utilizzo consapevole e sistematico di questa data retention policy diventa particolarmente importante per le cartelle che si creano per la condivisione tramite link, anche in presenza della data di scadenza: quest'ultima, infatti, se pure impedisce all'utente oggetto della condivsione di accedere ulteriormente ai file, non risolve il problema della retention. E' dunque opportuno utilizzare entrambe le funzionalità, magari avendo cura di impostare una durata superiore di qualche giorno/settimana a quella indicata nella data di scadenza del link di condivisione: in tal modo, qualora il destinatario del link avesse bisogno di qualche giorno in più, sarà possibile prorogare la data di scadenza del link anche a link scaduto, prima che il piano di retention abbia fisicamente eliminato i file.

Conclusioni

Per il momento è tutto: ci auguriamo che questa panoramica su NextCloud possa essere utile a quanti hanno intenzione di dotare la propria infrastruttura di un sistema di Cloud Storage on-premise, che a fronte di un investimento assolutamente contenuto (un server Linux, una VM o una Docker Image) consente di avere accesso a moltissime funzionalità interessanti per l'archiviazione e la condivisione interna ed esterna di qualsiasi tipo di file. Alla prossima, e... buona condivisione! Read the full article

0 notes

Text

Energia: ENEA ed Eni alleate per progetto internazionale DTT da 600 milioni di euro

Insieme nel polo scientifico-tecnologico sulla fusione per l’energia del futuro, inesauribile, sostenibile e sicura L’Italia sale alla ribalta dello scenario internazionale con un progetto da oltre 600 milioni di euro che vede ENEA ed Eni in un’alleanza strategica per l’energia del futuro, sostenibile, sicura e inesauribile. Si tratta del grande polo scientifico-tecnologico sulla fusione DTT (Divertor Tokamak Test), che verrà realizzato nel Centro Ricerche ENEA di Frascati (Roma) dalla società DTT Scarl, di cui Eni avrà il 25%, ENEA il 74% e il Consorzio CREATE l’1%. Le ricadute del progetto sul PIL nazionale sono stimate in circa due miliardi di euro con la creazione di 1.500 nuovi posti di lavoro, dei quali i 500 diretti, tra scienziati e tecnici. L’intesa è stata firmata oggi presso il Centro Ricerche ENEA di Frascati dal presidente di ENEA Federico Testa e dall’amministratore delegato di Eni Claudio Descalzi, alla presenza del sottosegretario alla Presidenza del Consiglio Riccardo Fraccaro, del ministro dell’Università e della Ricerca Gaetano Manfredi, del ministro dello Sviluppo Economico Stefano Patuanelli e del presidente della Regione Lazio, Nicola Zingaretti. Il DTT - Divertor Tokamak Test verrà realizzato in 7 anni e vedrà la partecipazione di Unione europea, del Consorzio Create, della BEI (con un finanziamento record di 250 milioni di euro garantiti dal Fondo Europeo per gli Investimenti Strategici FEIS, pilastro del Piano Juncker), dal Consorzio europeo EUROfusion (con 60 milioni a valere sui fondi Horizon 2020), il Ministero dello Sviluppo Economico e il MUR (con 80 milioni di euro circa) e la Regione Lazio (con 25 milioni più le spese per la connessione alla rete elettrica nazionale) e altri 30 milioni da partner internazionali. “Con questa alleanza fra ricerca e industria, l’Italia rilancia il suo ruolo di leadership in un settore strategico per la competitività del nostro Paese, quello della fusione, dove le aziende italiane hanno già vinto oltre 1,2 miliardi di euro di contratti e sono considerate fra le migliori al mondo”, ha sottolineato il presidente ENEA Federico Testa. “Voglio ringraziare tutti coloro che in ENEA si sono impegnati per arrivare a questo risultato e le istituzioni che hanno svolto un ruolo fondamentale per raggiungere questo traguardo che si inquadra nel contesto più ampio della nostra mission di affiancare le imprese nella sfida dell’innovazione, attraverso il trasferimento di conoscenze, tecnologie avanzate, servizi, progetti, prodotti”, ha aggiunto. L’amministratore delegato di Eni Claudio Descalzi ha dichiarato: “Questa collaborazione si inquadra nella visione strategica di Eni per la trasformazione del mondo dell’energia, nel quale la fusione a confinamento magnetico potrà giocare un ruolo essenziale. Il nostro know how industriale, le competenze di gestione e sviluppo di grandi progetti, combinate con l’eccellenza della ricerca scientifica di ENEA, saranno la chiave di successo per la realizzazione di questa importantissima iniziativa ed infrastruttura, basata primariamente su competenze e tecnologie italiane”. “Il progetto che verrà realizzato da ENEA ed Eni presso il Centro di Ricerche di Frascati, pone ancora una volta l’Italia all’avanguardia internazionale nel campo della ricerca per ottenere energia pulita, sostenibile e sicura”, ha dichiarato il ministro dello Sviluppo Economico Stefano Patuanelli. “Lo sviluppo e l’applicazione di tecnologie innovative rivestono, infatti, un ruolo decisivo nella transizione energetica che punta in direzione della decarbonizzazione e della sostenibilità ambientale. Per il MiSE è prioritario rafforzare le sinergie tra il mondo della ricerca e quello produttivo per favorire, attraverso il trasferimento tecnologico, la competitività industriale del nostro Paese e la creazione di nuovi posti di lavoro”, ha aggiunto. “ENEA ed Eni stringono un’alleanza fondamentale per il futuro energetico del nostro Paese. Il passo di oggi – ha dichiarato il ministro dell’Università e della Ricerca Gaetano Manfredi – getta le basi per una collaborazione strategica tra mondo della ricerca ed industria, che rilancia nel panorama internazionale le grandi competenze scientifiche e tecnologiche che l’Italia è in grado di esprimere, proprio in una delle più promettenti frontiere della ricerca scientifica”. Il progetto DTT nasce per fornire risposte scientifiche e tecnologiche ad alcuni aspetti del processo di fusione, come ad esempio la gestione di temperature elevatissime e i materiali da utilizzare, e si propone come supporto e infrastruttura di test per le più avanzate soluzioni tecnologiche che verranno messe in atto nei grandi progetti internazionali sulla fusione. Read the full article

0 notes

Text

IT Security – E’ necessario un cambio di approccio da parte dei Managers e dei Responsabili

Premessa: A me non interessa sapere Chi, nel nostro campo, ce l’ha più lungo di chi. A me interessa semplicemente il confronto, percui non sarà necessario commentare sottolineando l’ovvietà di quanto mi appresto a descrivere, perché ne sono cosciente io stesso che queste parole le sto scrivendo. Per quanto sembri assurdo, ancora oggi, nel 2017, sembra che tutto quello che diamo per scontato, tanto scontato non sia. Ancora oggi, per chi si occupa di IT Security, tanti concetti non sono così scontati, non sono proprio così banali ma, soprattutto, non esistono proprio.

L’Approccio è sbagliato, l’approccio va cambiato e le regole vanno migliorate. Iniziamo con la doverosa precisazione (se mai fosse necessaria) che tutto quello che seguirà questa stessa precisazione, è il punto di vista personale dello scrivente, quindi, in quanto tale, assolutamente opinabile e criticabile, financo insultabile. All’interno d ogni grande Realtà aziendale esiste un processo di IT Security ben delineato, preciso, affidabile (secondo standard interni, ovviamente), e soprattutto inattaccabile da un punto di vista della Governance. Ogni grande Realtà, ritiene la propria infrastruttura sicura, anche quando la realtà (delle cose) non sostiene la medesima affermazione. Se all’inizio dell’avventura (l’IT Security) la politica era “Preveniamo e difendiamoci”, oggi la politica è quasi simile, “Preveniamo e cerchiamo di difenderci”. Gli standard moderni sembrano suggerire un cambio di visione, ovvero…: ”Siamo sicuri che qualcuno, in qualche modo, ci attaccherà e riuscirà nel suo intento, quindi teniamoci pronti a rimettere in piedi i sistemi alla situazione pre-attacco; teniamo una copia di ogni dato, quando succederà, saremo pronti a restorare la situazione”. Oggi la visione è ancora legata al vecchio; oggi si cerca ancora di prevenire, e per certi versi io dico che è quasi del tutto naturale. Non puoi startene con le mani in mano mentre attendi qualcuno che sferri un attacco ai tuoi sistemi, sarebbe da perfetti idioti. Il punto è che la prevenzione, spesso, è fatta male. L’IT Security, come altre voci aziendali, deve fare i conti con i tagli. I tagli riguardano ogni voce di spesa, trasversalmente, dalle risorse alle tecnologie. Ma nelle grandi Realtà non è sempre così. Si limano le tariffe, si gioca al vuoto per pieno, ma le risorse sono sempre quelle, e quando occorre, i budgets vengono stanziati. Ci sono quindi eserciti di consulenti (anche molto esperti) seduti tra le fila del personale della grande Realtà pronti ad attingere al loro Know-how per servirlo sul classico piatto d’argento al Cliente di turno. Il problema è come vengono utilizzati questi consulenti. Qui sottolineamo il pensiero personale. L’esercito di Consulenti è usato male. Il Manager di turno, gestisce male le risorse che paga (in alcuni casi) a peso d’oro. Il Manager in questione si muove come un ariete, va avanti per la sua strada e non ascolta niente e nessuno, dando per certo che le sue conoscenze siano quelle giuste, quelle corrette e soprattutto AGGIORNATE. Beh no caro Manager/Ariente, non è così. Quando decidi di chiamare un’azienda di Consulenza, devi sapere che decidi di chiamare un’Esperienza pesata e misurata, un’esperienza che sul mercato ha un valore preciso e il tuo dovere è quello di USARLA al meglio.

Lo Scenario d’esempio. Sei un’azienda che offre, su rete pubblica, un tot di applicazioni. Le tue applicazioni, passano da un processo che sembra affidabile e che può garantire la protezione dei dati, dei sistemi e dell’infrastruttura. E invece no.

Nell’ambito Secure Code Development hai le tue precise regole (o almeno credi di averle, in realtà mancano di solide basi culturali, non hai pensato bene ad un processo di evangelizzazione). I tuoi developers seguono le regole (o almeno te lo fanno credere), poi offri loro anche gli strumenti per eludere tali regole. Quindi perché spendi tutti questi soldi ? Perché perdi letteralmente del tempo se metti in piedi un processo e le sue regole e poi scrivi un “codice di applicazione delle regole” pieno di escamotages legali per eluderle ?

Da te Grande Realtà io mi aspetto un’organizzazione logica lineare e semplice, non una serie di attività completamente slegate tra loro. Ma quanto sarebbe semplice, per qualsiasi Realtà, di qualsiasi dimensione, mettere in piedi un processo che prevede degli steps uguali ed obbligatori per tutti ? • Sviluppi il codice; > Prima di rilasciarlo lo passi ad un qualsiasi tool SAST; > Scrivi un report; • Prendi un tool DAST, passi una pettinata all’applicazione appena passata dall’ambito SAST; > Scrivi un report; • Prendi i report preparati in precedenza, prepari una mappa delle vulnerabilità rilevate da entrambe le sessioni, prepari un penetration test mirato, così non perdi tempo e denaro.

Ma ci vuole veramente così tanto per delineare delle procedure così semplici ? Hai tutto in casa, strumenti, personale, competenze, perché non lo fai ? Perché insegui solo ed unicamente la tua idea che hai “di sicurezza” che è assolutamente lontana dalla realtà che ti circonda e che è fatta di vulnerabilità reali e tutte in campo ? A voi l’argomento, fatene quello che volete.

0 notes

Text

Huawei inaugura gli uffici di via Laurentina a Roma

New Post has been published on https://www.channeltech.it/2019/10/29/huawei-inaugura-gli-uffici-di-via-laurentina-a-roma/

Huawei inaugura gli uffici di via Laurentina a Roma

Huawei ha inaugurato la nuova sede di Roma di via Laurentina; per l’occasione sono intervenuti la Sindaca Virginia Raggi e Thomas Miao, CEO di Huawei Italia.

Tra le personalità: Li Junhua, Ambasciatore della Repubblica Popolare Cinese in Italia, Roberto Sorrenti, Direttore Digital University ELIS-Politecnico di Milano.

L’inaugurazione avviene nel corso del quindicesimo anno di presenza di Huawei in Italia ed è solo l’ultima delle tappe che hanno visto l’azienda operare come soggetto attivo nel Paese.

Thomas Miao L’inaugurazione di una nuova sede risponde alla volontà di aprire le porte a operatori e aziende pubbliche e private. Potranno toccare con mano le innovazioni e le soluzioni ICT con cui ci proponiamo di contribuire a creare una smart nation, incentrata sulle persone, intelligente, equilibrata e sicura. L’Innovation Experience and Competence Center vuole essere una infrastruttura a disposizione di imprese, start-up e PA. Vuole rappresentare un esempio di collaborazione con l’intero ecosistema del Paese, all’insegna dell’apertura e della trasparenza.

Huawei inaugura gli uffici di via Laurentina a Roma

Nel suo intervento, Virginia Raggi ha sottolineato che l’apertura dei nuovi uffici di Huawei dimostra che Roma è in grado di attrarre le aziende globali.

L’ambasciatore LI Junhua ha sottolineato che la globalizzazione ha rimodellato il nostro mondo e che nessun Paese può svilupparsi da solo. L’isolamento e l’unilateralismo non produrranno alcun successo mentre cooperazione e multilateralismo sono l’unica soluzione vincente per tutti.

Nell’area espositiva dell’Innovation Center è possibile sperimentare la visione di Huawei: portare il digitale a ogni persona, casa e organizzazione per un mondo più intelligente. L’Innovation Center è aperto ai partner e alle start-up per studiare congiuntamente soluzioni che poi verranno lanciate sul mercato.

Huawei inaugura gli uffici di via Laurentina a Roma

Nell’area Smart City si possono toccare con mano le soluzioni Huawei per i mercati verticali. Un esempio sono le piattaforme in uso a Cagliari, grazie all’Intelligence Operation Center, sviluppato presso il Joint Innovation Center di Pula, frutto dell’accordo tra la Regione Sardegna, CRS4 e Huawei per la ricerca sulle smart city.

Nell’area dedicata al 5G la nuova tecnologia viene declinata in diversi settori. Sono stati presentati alcuni use case ed è possibile osservare l’applicazione di soluzioni in ambito home broadband wireless, B2C con video 8K, esempi di AR e VR. È stata inoltre presentata una demo live della tecnologia FWA 5G con modem per utilizzo in ambienti outdoor, quali quelli rurali, dove la fibra è scarsa o inesistente. Il collegamento ha permesso di sperimentare la trasmissione di video 8K su smart TV ad altissima velocità grazie alla rete 5G.

Il focus dell’azienda sulla tecnologia smart si rispecchia anche negli ambienti di lavoro, improntati al concetto di smart office. Gli uffici sono arredati con un design trasformabile e facilitano la condivisione e il lavoro di team. Le strumentazioni migliorano la collaborazione digitale. In quest’ottica, le sale riunioni sono dotate di monitor che servono da apparati di videoconference, sia da lavagne scrivibili dalle quali inviare i contenuti ai partecipanti.

0 notes

Text

Cos'è una VPN, come funziona, e perché è importante averne una

Negli ultimi anni il mondo del web è stato oggetto di un incremento esponenziale delle minacce informatiche: hacker, malware, ransomware, phishing e molti altri espedienti di natura malevola mettono quotidianamente a rischio la sicurezza di chiunque utilizzi internet: dall'utente meno smaliziato al professionista informatico, dalla piccola ditta individuale alla grande azienda internazionale, nessuno può definirsi realmente al sicuro. Per questo motivo è diventato molto importante dotarsi sia della necessaria consapevolezza su questo tipo di minacce che, soprattutto, degli opportuni strumenti di contenimento dei rischi connessi alla navigazione online. Come è certamente noto a molti lettori, esistono una serie di strumenti di protezione che oggi come oggi sono - giustamente - considerati pressoché essenziali: Antivirus: un essenziale strumento di prevenzione e rimozione delle principali minacce informatiche provenienti dai cosiddetti malware: parliamo dunque di virus, trojan, ransomware, rootkit e qualsiasi altro strumento informatico programmato con il preciso intento di far compiere al nostro device attività o operazioni al di fuori del nostro controllo. Per maggiori informazioni riguardo a questo tipo di minacce, consigliamo di leggere alcuni dei numerosi articoli che abbiamo pubblicato sul tema: Ransomware, Rootkit, Trojan e Worm: come difendersi? Come eliminare Malware, Virus, Trojan e Worm dal proprio sistema Cryptolocker, Locky e altri Ransomware: come recuperare i dati senza pagare il riscatto Firewall: strumento fondamentale per proteggere la vostra macchina da tutti gli attacchi basati su connessioni non autorizzate o tentativi di compromissione del traffico dati (DDoS Attacks, packet forgery, man-in-the-middle, etc.). Può essere installato sia come una stand-alone appliance che- se non potete permettervi una macchina dedicata - come strumento di protezione software. Software e/o strategie di Data Encryption: il metodo più efficace per garantire la protezione costante dei nostri dati in-transit, at-rest e/o end-to-end. Per maggiori informazioni sulle varie tipologie di crittografia ad oggi disponibili, suggeriamo di dare un'occhiata all'articolo Data Encryption in-transit, at-rest, end-to-end: definizioni e best practice. In questo articolo non approfondiremo ulterioremnte questi argomenti, per i quali rimandiamo ai riferimenti sopra indicati. Ci occuperemo invece di introdurre un ulteriore strumento di protezione, particolarmente importante per chiunque sia interessato a rendere la propria esperienza di navigazione online più sicura: il suo nome è VPN, acronimo di Virtual Private Network. Definizione Per prima cosa, cerchiamo di comprendere il significato della sigla VPN: abbiamo già detto che si tratta di un acronimo per Virtual Private Network, ovvero un network privato che consente a uno o più computer (o network) esterni di connettersi in modo sicuro e accedere alle proprie risorse. Queste ultime, a seconda dei casi, possono riguardare l'accesso ad altre macchine (o periferiche, o dispositivi) connessi a loro volta al medesimo network privato, e/o alla connessione internet del network stesso. La connessione tra un singolo client e una VPN viene talvolta chiamata client-to-site, mentre quella tra due network VPN è nota come site-to-site.

Tipologie di VPN