#computazione quantistica

Explore tagged Tumblr posts

Text

Il Paradosso del Gatto di Schrödinger: Tra Vita e Morte nella Fisica Quantistica. A cura di Alessandria today

Una riflessione sulla natura della realtà e della misurazione in fisica, il Gatto di Schrödinger continua a stimolare il dibattito tra scienza e filosofia.

Una riflessione sulla natura della realtà e della misurazione in fisica, il Gatto di Schrödinger continua a stimolare il dibattito tra scienza e filosofia. Uno dei paradossi più affascinanti e discussi della fisica è quello del Gatto di Schrödinger. Formulato nel 1935 dal fisico austriaco Erwin Schrödinger, questo paradosso esplora le bizzarre implicazioni della meccanica quantistica e la natura…

#Alessandria today#collasso della funzione d&039;onda#computazione quantistica#concetti di realtà#concetti di sovrapposizione#dualità onde-particelle#enigmi della fisica#Erwin Schrödinger#esperimenti mentali#Esperimento#esperimento mentale#filosofia della scienza#fisica moderna#fisica quantistica#fisica teorica#funzione d’onda#gatto di Schrödinger#gatto vivo e morto#Google News#Hugh Everett#interpretazione dei molti mondi#italianewsmedia.com#meccanica quantistica#molteplici stati#paradosso del gatto#paradosso fisico#particelle subatomiche#Pier Carlo Lava#principio di indeterminazione#problemi della misurazione

0 notes

Text

Server quantistico in rack per i data center

Il silicio abbatte le barriere dei computer quantistici. Un passo avanti nel computing quantistico: Bell-1, la nuova macchina di Equal1, rivoluziona il settore con tecnologie all'avanguardia. Sembra proprio che la computazione quantistica ha finalmente trovato la strada per uscire dai laboratori di ricerca ed entrare direttamente nei data center aziendali. Equal1 ha recentemente presentato Bell-1, un server quantistico che rappresenta un punto di svolta per il settore: niente più strutture specializzate, raffreddamento criogenico complesso o investimenti proibitivi. Questo innovativo sistema si integra perfettamente negli ambienti di calcolo ad alte prestazioni (HPC) esistenti, occupando lo spazio di un normale server per schede grafiche e pesando poco più di 200 kg, con un consumo energetico contenuto di appena 1600 watt. La vera innovazione di Bell-1 risiede nella sua ordinarietà operativa. Si installa in un rack standard, si collega a una normale presa elettrica e funziona immediatamente, senza richiedere alcuna infrastruttura supplementare. Un approccio radicalmente diverso rispetto ai computer quantistici tradizionali, che necessitano di ambienti controllati e sistemi di raffreddamento estremamente complessi per funzionare correttamente. "Bell-1 rappresenta un cambio di paradigma nel modo in cui la computazione quantistica viene implementata e utilizzata", ha dichiarato Jason Lynch, CEO di Equal1. "Abbiamo portato la tecnologia quantistica fuori dal laboratorio e l'abbiamo inserita in ambienti reali dove può guidare l'innovazione. Questo è l'inizio del Quantum Computing 2.0, dove accessibilità, scalabilità e praticità assumono un ruolo centrale." Il cuore pulsante di Bell-1 è il sistema di elaborazione quantistica UnityQ a 6 qubit di Equal1. A differenza delle tecnologie concorrenti, questo chip si basa su qubit di spin al silicio, significativamente più piccoli rispetto ai qubit superconduttori o a ioni intrappolati utilizzati in altri sistemi. Il vantaggio principale? Essendo prodotti con strumenti di fabbricazione di semiconduttori standard, offrono un percorso chiaro verso la scalabilità futura. L'architettura di UnityQ rappresenta un'innovazione fondamentale: integra sullo stesso chip non solo i qubit, ma anche processori classici (CPU Arm), unità di elaborazione neurale (NPU) e tutta l'elettronica di controllo quantistico. Questa configurazione elimina il tradizionale "ping-pong" tra componenti quantistiche e classiche, permettendo un funzionamento sincronizzato che aumenta significativamente efficienza e velocità. Il sistema di raffreddamento integrato è un altro elemento rivoluzionario. Bell-1 è in grado di raggiungere temperature di 0,3 Kelvin (circa -459°F o -272,78°C) attraverso un sistema a ciclo chiuso completamente autonomo. Nessun bisogno di elio liquido o di complessi refrigeratori a diluizione esterni: tutto è gestito internamente, richiedendo solo l'alimentazione standard. La complessità quantistica nascosta dietro la semplicità di utilizzo è la vera magia di Bell-1. Un aspetto distintivo del sistema è la sua capacità di gestire autonomamente la correzione degli errori, il controllo e la lettura direttamente sul chip. Questo riduce la latenza, aumenta l'affidabilità e supporta tempi di coerenza più lunghi, fondamentali per le operazioni quantistiche. Equal1 ha anche implementato algoritmi di correzione degli errori potenziati dall'intelligenza artificiale, sviluppati in collaborazione con Arm, per migliorare ulteriormente la stabilità. Le applicazioni pratiche di questa tecnologia sono vaste e trasversali a numerosi settori. Dalla finanza, dove può accelerare analisi di rischio e previsioni di mercato, alla ricerca farmaceutica, dove può simulare interazioni molecolari complesse, fino all'intelligenza artificiale, dove può ottimizzare algoritmi di apprendimento. Bell-1 offre potenza quantistica senza compromessi logistici o economici, rendendo finalmente accessibile questa tecnologia rivoluzionaria a realtà che fino a poco tempo fa non avrebbero potuto permettersela.

Bell-1 non è solo un prodotto, ma una piattaforma evolutiva. Equal1 ha progettato il sistema con un'architettura modulare che consente aggiornamenti semplici: quando saranno disponibili chip UnityQ con più qubit, gli utenti potranno semplicemente sostituire il componente interno senza dover cambiare l'intera infrastruttura. Questo approccio orientato al futuro trasforma Bell-1 in un investimento a lungo termine anziché in un'acquisizione tecnologica temporanea. I progressi di Equal1 non sono improvvisi. L'azienda ha pubblicato ricerche su arXiv a fine 2024 che hanno stabilito nuovi record nelle prestazioni di array di qubit al silicio e chip di controllo quantistico. I loro dati hanno dimostrato la più alta fedeltà conosciuta di gate a singolo e doppio qubit (ovvero minor numero di errori di calcolo) e velocità di gate superiori, che riducono il tempo necessario per eseguire operazioni quantistiche. Questa accessibilità rappresenta un cambiamento radicale per il settore. Mentre in passato solo i laboratori accademici d'élite o le grandi aziende tecnologiche potevano sperimentare con l'hardware quantistico, ora istituzioni di ricerca più piccole, startup e aziende ordinarie possono accedere allo stesso livello di potenza computazionale. La democratizzazione del quantistico non è più solo una promessa, ma una realtà concreta. Utilizzando materiali ampiamente disponibili e tecniche di produzione consolidate, Bell-1 consente inoltre al campo quantistico di fare un passo verso la scalabilità globale. I processori quantistici basati su silicio sono molto più facili da produrre in massa rispetto a quelli superconduttori e offrono compatibilità con la catena di approvvigionamento esistente dell'industria dei semiconduttori. Nel panorama tecnologico attuale, Bell-1 rappresenta un punto di svolta fondamentale: il momento in cui la computazione quantistica esce definitivamente dalla sua nicchia specialistica per diventare uno strumento pratico, accessibile e integrato nel tessuto informatico esistente. Non è solo un'evoluzione tecnologica, ma un cambio di paradigma che potrebbe accelerare drasticamente l'adozione di soluzioni quantistiche in contesti aziendali reali. Read the full article

0 notes

Text

PROTOTIPO DI COMPUTAZIONE QUANTISTICA SUPERCONDUTTORE "ZUCHONGZHI 3.0" INFRANGE NUOVO RECORD

05:00:16 04-Mar-2025 Il 3 marzo è stato ufficialmente rilasciato al pubblico “Zuchongzhi 3.0”, un prototipo di computazione quantistica superconduttore sviluppato da un team di ricerca dell’Università di Scienza e Tecnologia della Cina e da alcuni altri istituti di ricerca scientifica cinesi. Dopo il prototipo “Zuchongzhi 2.0”, la Cina ha nuovamente infranto il record di superiorità della…

0 notes

Video

youtube

Il teorema di Gödel sfata il mito più importante dell'intelligenza artificiale – Roger Penrose

Roger Penrose e il teorema di Gödel: perché l'IA non sarà mai cosciente

Roger Penrose, premio Nobel per la fisica e noto per i suoi studi sulla coscienza e la matematica, sostiene che l'intelligenza artificiale (IA) non potrà mai diventare cosciente. Il fulcro della sua argomentazione si basa sul teorema di incompletezza di Gödel, che dimostra l'esistenza di verità matematiche che non possono essere dimostrate all'interno di un sistema formale, ma possono essere comprese da un essere umano. Secondo Penrose, questa capacità di trascendere le regole formali è una caratteristica della coscienza e non può essere replicata da un computer.

1. Il problema della definizione di "intelligenza"

Penrose afferma che il termine "intelligenza artificiale" è fuorviante perché intelligenza implica coscienza, e l'IA non è cosciente. Secondo lui, ciò che oggi viene definito "IA" è semplicemente un insieme di algoritmi computazionali, ovvero sistemi basati su calcoli matematici, e non ha alcuna capacità di comprensione o consapevolezza.

Le IA moderne, anche se potenti, non "sanno" quello che stanno facendo. Esse analizzano dati, riconoscono pattern e generano risposte basate su calcoli probabilistici, ma senza comprendere realmente il significato di ciò che elaborano.

2. Il teorema di Gödel e i limiti dell'IA

Il teorema di Gödel dimostra che esistono affermazioni matematiche vere che non possono essere dimostrate all'interno di un sistema formale. Ciò significa che un essere umano può riconoscere la verità di certe affermazioni grazie alla comprensione, mentre un computer, vincolato alle sue regole computazionali, non può farlo.

L'argomento di Penrose: la coscienza è non computabile

Un sistema formale segue regole fisse e computabili.

La coscienza, invece, riesce a "trascendere" queste regole, comprendendo la verità di affermazioni che un computer non potrebbe mai verificare autonomamente.

L'IA moderna, essendo puramente computazionale, non potrà mai replicare questa capacità umana di comprensione.

Penrose sottolinea che la coscienza non è un processo computazionale e, di conseguenza, nessuna macchina basata esclusivamente su calcoli matematici potrà mai svilupparla.

3. La confusione tra potenza di calcolo e comprensione

Penrose evidenzia come l'incredibile potenza di calcolo delle IA moderne abbia portato molte persone a confondere l'elaborazione computazionale con la comprensione. Ad esempio:

Le IA possono analizzare enormi quantità di dati e generare risposte coerenti, ma non sanno cosa significano queste risposte.

Le IA possono risolvere problemi complessi, ma solo seguendo schemi computazionali, senza alcuna consapevolezza del perché una soluzione sia corretta o meno.

Questa distinzione è fondamentale: la potenza di calcolo non implica la comprensione.

4. Il ruolo della fisica nella coscienza

Penrose sostiene che per spiegare la coscienza serva una nuova fisica, non computabile. La fisica conosciuta oggi, inclusa la meccanica quantistica, è (quasi interamente) computabile, il che significa che può essere simulata da un computer. Tuttavia, lui ipotizza che la coscienza emerga da processi fisici non computabili ancora sconosciuti.

Ad esempio:

Le IA attuali operano con regole computazionali basate sulla statistica e l'analisi dei dati.

La coscienza, invece, potrebbe dipendere da fenomeni fisici che non possono essere simulati da un algoritmo.

Questa è una tesi radicale: se Penrose ha ragione, allora nessun miglioramento nell'IA, nessun aumento di potenza di calcolo, e nessun algoritmo più sofisticato porterà mai alla coscienza artificiale, perché la coscienza sarebbe qualcosa di fondamentalmente diverso dalla computazione.

5. L'IA è solo una macchina statistica

Secondo Penrose, le IA, per quanto sofisticate, rimangono fondamentalmente macchine statistiche:

Analizzano pattern nei dati, ma senza comprenderli.

Simulano il linguaggio umano, ma non lo comprendono realmente.

Eseguono compiti complessi, ma senza consapevolezza.

L'errore, secondo lui, sta nel credere che accumulando abbastanza dati e calcoli, un computer possa diventare cosciente. Ma la coscienza, per lui, non è un problema di quantità di dati, ma di qualità della fisica sottostante.

6. La confusione su "intelligenza" e il futuro dell'IA

Infine, Penrose suggerisce di cambiare il nome dell'IA in "artificial cleverness" (furbizia artificiale), per evitare confusione. Un'IA può essere straordinariamente abile nel calcolo e nell'elaborazione di dati, ma non sarà mai "intelligente" nel senso umano del termine.

Sul futuro dell'IA, Penrose:

Non nega che l'IA avrà un ruolo sempre più importante, specialmente nei campi computazionali.

Ritiene che la coscienza artificiale sia impossibile con l'attuale comprensione della fisica.

Specula sulla possibilità che un giorno si scopra una nuova fisica non computabile, ma non ritiene che le attuali IA abbiano nulla a che vedere con la coscienza.

Conclusione: perché l'IA non sarà mai cosciente secondo Penrose

Il teorema di Gödel mostra che la comprensione umana trascende i sistemi formali e computabili.

La coscienza è non computabile, mentre l'IA è puramente computazionale.

La potenza di calcolo dell'IA non implica comprensione o consapevolezza.

Per spiegare la coscienza, servirebbe una nuova fisica, non ancora scoperta.

L'IA è una macchina statistica, non un'entità pensante.

L'idea che l'IA possa diventare cosciente è un'illusione basata su una comprensione limitata della coscienza stessa.

In sintesi, non importa quanto potente diventi un computer: senza una nuova fisica, l'IA rimarrà sempre un calcolatore sofisticato, ma privo di coscienza.

(via Gödel's theorem debunks the most important AI myth. AI will not be conscious | Roger Penrose (Nobel) - YouTube)

1 note

·

View note

Text

Una catena di Kitaev a due siti in un gas di elettroni bidimensionale Una nuova scoperta nella fisica quantistica Un recente studio ha esaminato l’implementazione di una catena di Kitaev a due siti in un gas di elettroni bidimensionale. Questo fenomeno è stato studiato in relazione alla presenza di Majorana, particelle che potrebbero rivoluzionare la computazione quantistica. Ricerche correlate Alcuni studi precedenti hanno esaminato la realizzazione dei qubit di parità e degli stati legati di Majorana in sistemi simili. I risultati di questi studi sono stati confrontati con le nuove scoperte per approfondire la comprensione di tali fenomeni quantistici. Implicazioni future La ricerca sulla catena di Kitaev a due siti potrebbe aprire la

0 notes

Text

Inaugurato alla Federico II il Superconducting Quantum Computing Center

Inaugurato alla Federico II il centro di computazione quantistica superconduttiva. Il progetto, finanziato nell'ambito dello Spoke 10 "Quantum Computing" di ICSC - Centro Nazionale di Ricerca in High Performance Computing, rappresenta un potenziamento e ampliamento dell'originario laboratorio di tecnologie quantistiche dell'Ateneo federiciano. L'inaugurazione si è tenuta nel corso di una ‘due giorni' presso il Dipartimento di Fisica "Ettore Pancini" dell'Università degli Studi di Napoli Federico II, nel Campus Universitario di Monte Sant'Angelo. Federico II: eventi e calcolo quantistico L'evento ha visto come protagonisti i principali esponenti delle realtà appartenenti al mondo della ricerca e delle imprese oggi impegnati nello sviluppo del calcolo quantistico, sempre di più al centro delle politiche strategiche europee e internazionali. Nella Sala Azzurra dei Centri Comuni, a Monte Sant'Angelo, a dare il via alla due giorni di incontri, relazioni e tavole rotonde. Andati in scena, anche gli interventi del Rettore del Matteo Lorito, del Sindaco di Napoli Gaetano Manfredi, dell'Assessore alla Ricerca, Innovazione e Startup della Regione Campania Valeria Fascione, e del Responsabile del Settore ‘Quantum Computing' della Commissione Europea Oscar Diez. Successivamente spazio invece alla presentazione dei progetti italiani ed europei dedicati al calcolo quantistico, tra cui quelli finanziati dal PNRR e promossi dal Centro Nazionale ICSC e dal Partenariato Esteso e dal National Quantum Science and Technology Institute (NQSTI). Il nuovo centro Il nuovo centro ospita un computer quantistico di 24 qubit superconduttivi progettato per essere scalabile, modulare e modificabile, con l'intento di supportare le attività e le esigenze di Ricerca e Industria e di promuovere lo sviluppo di una filiera italiana del calcolo quantistico attraverso la formazione di nuove competenze e professionalità. Il laboratorio, che adotta sistemi di supporto con processori quantistici alternativi sviluppati dall'Università Federico II di Napoli in collaborazione con centri di ricerca e industrie, mira inoltre ad ampliare a breve la propria attività, con l'istallazione entro la fine del 2024 di un processore quantistico con 40 qubit. Foto di Pete Linforth da Pixabay Read the full article

0 notes

Link

0 notes

Text

Il futuro della crittografia? Blockchain e fisica quantistica

La sicurezza dei dati è una delle maggior sfide dell’era digitale moderna. Tra i più recenti e sofisticati sistemi di difesa ce n’è uno in particolare che, pur essendo stato inventato nell’antichità, continua a svolgere con grande efficacia il lavoro per cui è stato creato: la crittografia. Come è possibile apprendere dai dati esposti nell’articolo di ExpressVPN sulla storia della crittografia, questa disciplina è nata per scopi militari. Nel corso di questo approfondimento, oggi, scopriremo tutto ciò che circonda questa affascinante disciplina, dalla sua nascita ai tempi degli antichi egizi sino ai giorni nostri. Cos’è la crittografia? La crittografia è l'arte e la scienza di proteggere le informazioni attraverso l'uso di algoritmi matematici che trasformano i dati in modo che diventino incomprensibili per chi non possiede la chiave di decodifica corrispondente. Si tratta di un campo fondamentale per garantire la sicurezza e la privacy delle comunicazioni, soprattutto di quelle digitali in questi ultimi anni. La materia può essere suddivisa in diverse categorie, ma due delle principali sono la crittografia simmetrica e asimmetrica. Nella prima, la stessa chiave è utilizzata sia per cifrare che per decifrare i dati. D'altra parte, la seconda coinvolge una coppia di chiavi: una pubblica, condivisa con tutti, e una privata, mantenuta segreta dal possessore. Quest'ultima forma è spesso impiegata in transazioni online sicure e nella creazione di firme digitali. Quando nasce e come evolve? La storia della crittografia affonda le radici nell'antichità. Uno dei primi esempi noti di cifratura risale all'antico Egitto, dove venivano utilizzati geroglifici e simboli per proteggere informazioni vitali. Quest’arte prende slancio con la scitala, un dispositivo criptografico utilizzato dagli Spartani nel 5° secolo a.C. progettato a scopi militari. Questo cilindro di legno, su cui veniva avvolto un lungo nastro di pergamena, rappresenta uno dei primi esempi di cifrari a trasposizione, in cui le lettere venivano mescolate attraverso una sequenza specifica. Un altro esempio riguarda il cifrario di Cesare, che prevedeva lo spostamento di ogni lettera dell'alfabeto di un numero fisso di posizioni: un metodo relativamente semplice, ma efficace per nascondere il significato delle parole. Infine, durante la seconda Guerra Mondiale vediamo l’impiego massiccio di cifrari avanzati, tra cui la celebre Enigma tedesca. Negli anni successivi quest’arte ha continuato a evolversi, adottando nuovi approcci e algoritmi per adattarsi alle crescenti sfide del mondo digitale: dall'introduzione della crittografia a chiave pubblica negli anni '70, alla ricerca attuale su quella quantistica, si arriva sino ai giorni nostri in cui viene utilizzata per proteggere utenti e istituzioni dai malintenzionati della rete. Il futuro: la fisica quantistica per proteggere dati Attualmente quest’arte si basa su algoritmi matematici complessi, ma l'avanzamento delle tecnologie ha introdotto nuove prospettive: la crittografia quantistica. Essa utilizza particelle subatomiche, come i fotoni, per creare chiavi. Un aspetto interessante è la proprietà di sovrapposizione quantistica, che consente di creare chiavi che, se intercettate, alterano lo stato quantistico delle particelle coinvolte, rivelando l'intercettazione stessa. Questo fenomeno, noto come principio di indeterminazione di Heisenberg, fornisce una forma di sicurezza inattaccabile dalla computazione classica. Si tratta di un’innovazione ancora in fase di sviluppo anche se, di fatto, sembra essere quella che riscuote maggior interesse per il prossimo futuro. Crittografia omomorfa Anche la crittografia omomorfa rappresenta una grande novità nella protezione dei dati, perché consente di eseguire operazioni direttamente sui dati cifrati senza la necessità di decifrarli. Essa offre un livello di sicurezza avanzato dal momento che consente a terze parti di eseguire calcoli sui dati cifrati senza rivelarne il contenuto. L'elaborazione dei dati, infatti, avviene direttamente sul ciphertext. Questo tipo di crittografia deve superare numerose sfide di complessità e di adattabilità, sebbene il suo potenziale ha aperto nuovi scenari per la protezione dei dati sensibili. Dati blindati e protetti con blockchain La blockchain si presenta al mondo come uno straordinario paradigma di sicurezza. In una blockchain, infatti, i dati sono immutabili e distribuiti su una rete decentralizzata di nodi: ogni blocco di dati è collegato al precedente, formando una catena che registra e protegge ogni transazione o informazione inserita. È proprio la struttura decentralizzata che impedisce la manipolazione dei dati e, quindi, offre una grande trasparenza. L'applicazione della blockchain, quindi, può essere applicata per qualsiasi finalità, sia pubblica e privata, come testamenti, transazioni, firme di contratti e molto altro ancora. Read the full article

0 notes

Text

Digitale, artificiale, sintetico. In una parola, programmabile. Il mondo si è avviato ad una trasformazione profonda e irreversibile delle proprie fondamenta ontologiche ed ontogenetiche. Una trasformazione che si comincia a percepire come molto “agita” ma, al contempo e con preoccupazione, anche poco “pensata”. Siamo ad un momento di passaggio epocale nella storia della specie umana. Un passaggio che rimane, ad oggi, sostanzialmente sottaciuto e confinato di norma nelle pratiche e nelle ricerche degli specialisti e degli esperti. Scienze e tecnologie di notevole portata e impatto ambientale e sociale (quali, ad esempio, la computazione quantistica, la biologia sintetica, l’intelligenza artificiale, la nanotecnologia molecolare, la crittografia monetaria, la robotica sociale) stanno lasciando i laboratori di progettazione e sperimentazione -in certa misura finora controllati e circoscritti- per essere diffuse, in maniera sempre più ampia, su scala planetaria. Tutto questo trasferimento (da scienza verso l’ingegneria) sta accadendo, oggi, con una debole attenzione specifica e nessuna consapevolezza sistemica da parte della collettività.

A fronte di questa spinta tecnologica (di cui è parte rilevante anche l’attuale rivoluzione dei dati), credo sia sempre più indifferibile l’attivazione di un pensiero filosofico all’altezza delle sfide scientifiche e tecnologiche in essere. Un pensiero speculativo e prospettico, aperto ma attento, capace di studiare e accompagnare, con la necessaria densità teorica, questa nuova fase dell’antropocene. È tempo, dunque, di immaginare un manifesto “philtech” che renda pubblico e renda urgente il bisogno collettivo di tornare a pensare filosoficamente la tecnologia.

2 notes

·

View notes

Text

Attraverso una pubblicazione su Nature Physics, un gruppo di scienziati ha rivelato al mondo di essere riusciti per la prima volta a teletrasportare un’informazione tra due chip non collegati fisicamente o elettronicamente.

I ricercatori fanno parte dell’Università di Bristol e della Technical University of Denmark e sono riusciti a effettuare questo “teletrasporto” servendosi di un fenomeno chiamato “entanglement quantistico”, grazie al quale due particelle sono legate tra loro indipendentemente dalla distanza. Cambiando le proprietà di una particella, anche l'altra cambierà all'istante, non importa quanto spazio le separi.

Nel suo studio, il gruppo di scienziati ha generato coppie di fotoni entangled sui chip e poi ha effettuato una misurazione quantistica su uno di essi. Questa osservazione ha cambiato lo stato del fotone e il cambiamento si è verificato istantaneamente anche nel fotone partner presente nell'altro chip.

I ricercatori hanno voluto sottolineare che le precedenti dimostrazioni sperimentali sono state affrontate da sorgenti multifotoniche e operatori multiqubit di alta qualità, ma sempre all’interno di un unico sistema integrato. Nel loro studio si sono serviti invece di chip realizzati con silicio, in particolare di circuiti integrati ottici, non collegati tra loro.

La squadra ha riportato un tasso di successo del teletrasporto del 91% ed è riuscita a svolgere alcune altre funzioni che saranno importanti per il calcolo quantistico. Ciò include lo scambio di entanglement (in cui gli stati possono essere passati tra particelle che non hanno mai interagito direttamente attraverso un mediatore) e l'entanglement di ben quattro fotoni insieme.

"Siamo stati in grado di dimostrare un collegamento di alta qualità dell'entanglement tra due chip in laboratorio, nel quale i fotoni presenti in entrambi i chip condivisono un singolo stato quantico", ha riferito Dan Llewellyn, co-autore dello studio. "La misurazione di uno dei fotoni attiva lo strano comportamento della fisica quantistica, che contemporaneamente fa collassare il collegamento dell'entanglement e trasferisce lo stato della particella ad un'altra particella già presente nel chip ricevente."

Sulla carta, poiché l’entanglement non si serve di un campo classico per il collegamento tra le due particelle che si scambiano l’informazione, non c’è limite alla distanza su cui il teletrasporto quantistico (dell’informazione) può operare.

Gli scenari che possono aprirsi sono infiniti - non solo nella computazione quantistica ma anche nelle nuove possibilità di comunicazione - e naturalmente gli studi sono solo agli inizi. Chissà cosa ne penserebbe Einstein, che, in contrapposizione alle teorie quantistiche di Bohr, definì l’entanglement come una “spaventosa azione a distanza”.

1 note

·

View note

Link

Un gruppo di docenti universitari propone di fare qualche passo avanti su una questione che rischia di basarsi su una tifoseria tribale più che su elementi razionali.

Care Madamine,

abbiamo letto e ascoltato vostri interventi riguardo alla nuova Linea Ferroviaria Torino-Lione. Ci sembra che attribuiate a quest’opera un valore del tutto simbolico, non ritroviamo nelle vostre parole né dati tecnici né scenari di futuro basati sulla realtà fisica, mentre compaiono soltanto aspettative generiche che nulla hanno a che vedere con un traforo sotto il massiccio dell’Ambin. Chi si oppone a tale opera lo fa da oltre vent’anni basandosi su grandezze fisiche e previsioni analitiche. Proviamo pertanto, come docenti universitari a proporre di fare qualche passo avanti su una questione che rischia di basarsi su una tifoseria tribale più che su elementi razionali.

Isolamento

Le affermazioni riguardo al “rompere l’isolamento” del Piemonte suonano paradossali e prive di fondamento. Nel 2017 le tonnellate di merci che hanno varcato il confine italo-francese sono state circa 44 milioni, pari approssimativamente ad un quinto di tutto quello che attraversa le Alpi ogni anno (216 milioni di tonnellate). All’aeroporto di Caselle sono transitati 3.814.000 passeggeri; sui treni Milano-Parigi che toccano Torino e transitano dal Fréjus c’è stata una presenza complessiva di circa 500.000 viaggiatori. Aggiungiamo il transito di autovetture ai valichi alpini da Ventimiglia al Monte Bianco ed è difficile capire in che senso il Piemonte e Torino siano “isolati”. Negli atenei torinesi ci sono quasi 10.000 studenti stranieri, circa il 9% del totale degli iscritti: per una città “isolata” non è male. Nell’era di Internet parlare di isolamento è sempre più un concetto marginale.

Sostenibilità

Se dunque non è l’isolamento di merci e passeggeri a caratterizzare il Piemonte, si potrebbe invocare la scarsa sostenibilità ambientale del traffico aereo e su gomma, quindi vedere il TAV Torino-Lione semplicemente come sostituzione di modalità di trasporto. Ma sostenibile non è un aggettivo magico da affiancare a qualsiasi cosa. La sostenibilità sta soltanto in un’economia circolare, promossa dalla stessa UE, che riduca i flussi di energia e materia, quindi con una minor circolazione di merci. Per la nuova linea Torino-Lione la narrazione favorevole ipotizza invece un cospicuo e duraturo aumento delle tonnellate da trasportare. A prescindere dalla realtà che si incarica di smentire sostanziali tendenze alla crescita quantitativa dei flussi attraverso la frontiera italo-francese, l’economia della crescita delle quantità materiali non è sicuramente circolare e si trova agli antipodi della sostenibilità perché è in conflitto con vincoli e leggi fisiche. Tutto ciò è ben noto alla comunità scientifica internazionale ed illustrato in documenti delle Nazioni Unite o nell’enciclica Laudato Si’ di Papa Francesco. La NLTL per essere realizzata consuma inoltre molta energia e materie prime, produce imponenti emissioni di gas climalteranti che promette di cominciare a recuperare solo dopo una ventina d’anni dall’apertura dei cantieri: per contenere i cambiamenti climatici dobbiamo ridurre le emissioni subito, non tra vent’anni, e il denaro stanziato per l’opera potrebbe essere diretto verso altre opere trasportistiche con ricadute immediate, anche occupazionali, come l’estensione della mobilità elettrica e il miglioramento di quella urbana e ferroviaria esistente.

Disuguaglianze

Le statistiche dell’OCSE e delle Nazioni Unite dicono che da decenni le disuguaglianze di reddito sono in crescita, sia all’interno delle nazioni che fra di loro. Ciò indica che si tratta non di un fenomeno congiunturale, ma strutturale. Di certo non sono i meccanismi della crescita materiale competitiva a poter perseguire l’equità sociale, né si può sperare di curare la malattia lasciando campo libero a multinazionali guidate esclusivamente dalla massimizzazione del profitto e che spostano i propri investimenti da un paese all’altro in cerca del luogo in cui incontrino meno vincoli ambientali e sociali mirando a minimizzare i costi. Quella logica non mitiga gli impatti ma li scarica sugli altri e di certo non ottimizza, anzi minimizza, la retribuzione del lavoro; l’occupazione è comunemente gestita come un ricatto nei confronti dei pubblici poteri onde poter avere mano libera. Certamente la soluzione al problema delle disuguaglianze non sono uno o più buchi nelle montagne, ma semmai la diffusione di nuovi modelli economici e sociali che contemplino sostenibilità e resilienza.

Futuro

Il futuro va costruito in maniera solidale, tenendo conto dei limiti e dei vincoli del sistema Terra-biosfera che oggi sono ben evidenti. Un ruolo chiave ce l’ha certamente l’innovazione e la frontiera possiamo trovarla nella chimica verde, nella biomimicry (biomimesi), nei processi circolari per minimizzare la produzione di rifiuti e massimizzare l’efficienza energetica, nell’internet of things (internet delle cose) e magari nel quantum computing (computazione quantistica); non nel movimento terra e nel cemento. Se il sistema imprenditoriale ha difficoltà a muoversi in questi campi non è certo perché manchi una galleria. La strada non è quella di guardare al passato riproponendo i vecchi modelli che hanno portato alla situazione presente di insostenibilità globale. Partendo da una base materiale che è comunque molto vasta, bisogna puntare sull’intelligenza e sull’immateriale, sulla qualità personale e sociale della vita piuttosto che su un impossibile aumento delle tonnellate da spostare qua e là.

Un’illusione proposta come soluzione

Ma a suscitare la curiosità più grande è proprio l’accostamento tra quest’opera e la salvifica risoluzione di problemi presenti e futuri. Anche lanciando oggi i lavori definitivi di costruzione (finora mai partiti) dovremmo attendere decenni prima di vedere transitare un treno sulla nuova linea ferroviaria da Torino a Lione. Il tunnel di base non sarebbe attivo prima della metà degli anni ’30 e i collegamenti nazionali non prima della fine degli anni ’40. E nel frattempo? Gli imprenditori dovrebbero attendere fino ad allora quest’unica ipotesi di rilancio dell’economia? Torino e il Piemonte continuerebbero a restare isolate (ammesso e non concesso che oggi lo siano)? I nostri giovani continuerebbero ad emigrare, con l’unica consolazione di un biglietto di ritorno datato 2050? Rimarremmo tutti per vent’anni in trepidante attesa, certi del miracolo?

Nel nostro lavoro siamo abituati a ragionare in termini concreti, saldamente ancorati ad elementi di realtà valutabili. Il progetto di nuova linea ferroviaria Torino Lione è notoriamente basato su presupposti proposti alcuni decenni fa, oggi rivelatisi errati e anacronistici. Pensare di puntare tutto su quest’opera ha più a che fare con il gioco d’azzardo che con la visione strategica. Per uscire tutti insieme dalle difficoltà presenti non solo il nuovo tunnel di base non c’entra nulla, ma è d’impedimento in quanto vorrebbe catturare risorse che dovrebbero molto più produttivamente essere impiegate altrove.

Seguono firme

Alessandra Algostino, docente universitario

Mauro Bonaiuti, docente universitario

Marina Clerico, docente universitario e membro della Commissione Tecnica Torino Lione

Elisabetta Grande, docente universitario

Sergio Foà, docente universitario

Ugo Mattei, docente universitario

Luca Mercalli, Associazione Meteorologica Italiana

Dario Padovan, docente universitario

Livio Pepino, già magistrato

Alberto Poggio, docente universitario e membro della Commissione Tecnica Torino Lione

Angelo Tartaglia, già docente universitario e membro della Commissione Tecnica Torino Lione da Presidioeuropa

15 notes

·

View notes

Text

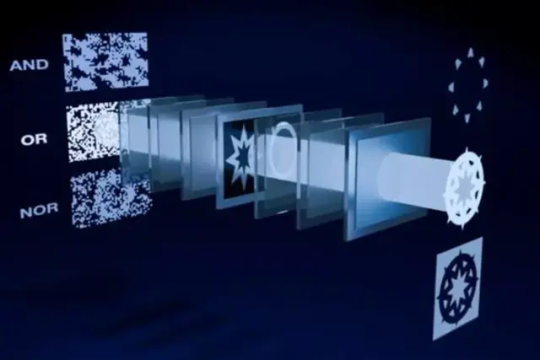

Chip laser per i nuovi computer quantistici

La luce si prepara a rivoluzionare i computer. Per rendere più veloci quelli tradizionali e quelli quantistici. Le particelle di luce, i fotoni, si preparano rivoluzionare i computer, accelerandone la velocità e le prestazioni nel calcolo. E' questa la strada indicata da due ricerche internazionali, la prima a guida giapponese e la seconda a guida italiana. La prima notizia è pubblicata sulla rivista Advanced Photonics dal gruppo di ricerca dell'Università di Tokyo guidato da Ryoichi Horisaki e indica che l'uso dei fotoni potrebbe favorire la nascita di una nuova generazione di computer classici. Lo studio giapponese riprende infatti alcune ricerche pioneristiche che negli anni ’80 si proponevano di utilizzare le particelle di luce nei tradizionali chip, così da rendere il calcolo più rapido e riducendo il dispendio di energia.

Nuovi modi per fare computazione usando la luce (fonte_ Mashiko et al. CC-BY-ND Questa strada però non è stata seguita per problemi legati principalmente ai costi e perché nel frattempo i chip basati sull’elettronica hanno dimostrato grandi miglioramenti. Ma oggi, affermano i ricercatori giapponesi, nuove applicazioni come quelle legate all’Intelligenza Artificiale richiedono potenza e velocità sempre maggiori e nello stesso tempo il problema dei consumi energetici è sempre più pressante. I fotoni, per i quali il gruppo giapponese presenta nuovi possibili utilizzi all’interno dei chip, tornano dunque a essere un’opportunità da esplorare. Contemporaneamente la rivista Nature Photonics pubblica lo studio internazionale guidato dall'italiano Fabio Sciarrino dell’Università Sapienza di Roma, con l’Istituto di Fotonica e Nanotecnologie del Consiglio Nazionale delle Ricerche e con l'Iberian Nanotechnology Laboratory finanziato dal progetto europeo Phoqusing, presenta un nuovo approccio per usare fotoni come generatore di casualità matematica. “La generazione e la manipolazione di variabili casuali, apparentemente facile, si dimostra invece una questione complessa e ha ricadute importanti in molti problemi fisici, soprattutto per la computazione sia classica che quantistica e qui proponiamo una nuova soluzione utile per molte applicazioni”, ha detto Sciarrino commentando il risultato ottenuto anche nell’ambito della collaborazione con il Centro Nazionale di Ricerca in High Performance Computing, Big Data e Quantum Computing, Icsc. Read the full article

0 notes

Text

WILAR parte sesta. I modelli, il mondo sensibile, la nascita del significato. In questo excursus che procede a volo radente su temi che fanno tremare i polsi a fior di filosofi ed epistemologi, e che riguardano la definizione di cosa sia la scienza esatta, la funzione dell'esperimento e come questo abbia cambiato la percezione del vero, focalizzandosi sin dai tempi di Galileo sulla descrizione quantitativa dei fenomeni della realtà più che sulla compresione metafisica degli stessi, abbiamo intravisto anche che in alcuni comparti della scienza come nelle scienze umane il ruolo e l'influenza dello sperimentatore non sia un elemento astratto ed estruso dall'esperimento: l'uomo tende ad assegnare significati a priori ai fenomeni e questo è proprio ciò che il metodo sperimentale e la scienza moderna dai tempi di Galileo cercano di escludere. Sono ammesse solo descrizioni fenomenologiche ripetibili misurabili, non sono ammesse interpretazioni non quantitative, per quanto possano essere brillanti, direttamente o indirettamente non osservabili. Notiamo che dal metodo sperimentale e dalla scienza è nata una filosofia sociale, il materialismo e una corrente di pensiero che prende il nome di positivismo, che ritiene vero solo ciò che è direttamente misurabile. Questo concetto ha permeato talmente la nostra cultura che lo riteniamo un vero "per sè". Nessuno lo mette in discussione, volendo da un lato misurare anche fenomeni che non lo sono, come il destino, l'amore, la psiche, e così via, dall'altro negando dignità a questioni metafisiche come l'esistenza di Dio, l'origine causale del cosmo, l'entelechia dell'anima il significato del nostro destino e la natura metafisica dell'etica. Tutti temi che fino a Kant ed Hegel trovavano piena dignità nel pensiero umano. Dalla nascita del metodo sperimentale, che si è affermato con sicurezza nelle scienze esatte e sociali, l'approccio con la realtà che la prassi scientifica moderna ha, ha portato a dover fronteggiare il problema di manipolare l'incertezza di alcune sue manifestazioni: questo ha favorito il fiorire nuove scienze, che non sono matematiche ma autonomamente fondazionali, come la teoria della probabilità (il cui primo e più noto rappresentate è stato Pascal) e la statistica. Qui il concetto di esperimento inteso come singolo rappresentate, istanza realizzata di un modello puro e perfetto - espressione di una funzione, una equazione descrittiva di un fenomeno - ad un certo punto comincia mutare. La teoria della probabilità e la statistica nascono quasi come una curiosità, uno strumento descrittivo e manipolativo della teoria dei giochi, ma si approfondiscono sempre più nei secoli fino a raggiungere punti critici della teoria della conoscenza, fino a generare concetti assolutamente nuovi per la filosofia e per la scienza, come il significato di incertezza, il concetto di caso, e la sua natura. Il fenomeno, il dato, non è più inteso come rappresentante di un modello nitido e puro, ma come realizzazione di un disegno più generale descritto dai dati stessi spesso inconoscibile a priori. E' interessante notare come in questo periodo si è cominciato a parlare di probabilità a posteriori e a posteriori, e come Bayes sia stato in grado di collegarle tra loro. Di fatto Bayes ha stabilito che la probabilità di osservare un fenomeno a posteriori (i.e. avendo osservato specifici dati della realtà) equivale alla verosimiglianza, i.e. alla distribuzione di probabilità dei dati in quello specifico tipo di fenomeno, per la probabilità a priori che avvenga quel tipo di fenomeno, normalizzata per la somma della verosimiglianze di tutti fenomeni (fig. a sinistra). Notiamo che questa equazione largamente usata in statistica, non è un teorema ma una formula, una affermazione. Questo ci fa intendere quanto negli strati più profondi e riconosciuti della scienza teorica e sperimentale il vero e il falso non siano dei diamanti concettuali, intatti e puri, filosoficamente (e concretamente) inattaccabili, ma siano più pragmaticamente il risultato di una contrattazione sociale considerata vera da un ristretto numero di cultori che chiamiamo, propriamente o impropriamente, scienziati. La scienza non è vera, non fa affermazioni vere, ma parla di concetti considerati veri fino a prova contraria. Il vero in senso scientifico è il meglio che si possa dire secondo le conoscenze attuali, e non è un vero incontrovertibile. Qualche decennio più tardi i chimici e i fisici formularono la teoria atomica della materia, gli atomi come elementi costitutivi e misurabili della materia all'interno di una teoria. Dalle misurazioni dei fenomeni corpuscolari, capirono in fretta che gli atomi non si comportavano affatto come un insieme di individui governati da leggi uguali, come ad esempio avveniva per i gravi nella teoria del moto galieliano, o i pianeti nella teoria gravitazionale di Newton, ma costituivano fenomeno teorico nuovo e a sè stante. Gli atomi e gli elementi subatomici si presentavano come la realizzazione di un fenomeno casuale (ma non caotico) descritto da una funzione di probabilità. Nasce la meccanica quantistica, che serve a sistematizzare un insieme di precetti assolutamente nuovi come il principio di indeterminazione di Heisenberg, il concetto di posizione probabilistica di una particella, la doppia natura ondulatoria e corpuscolare delle particelle, e così via dicendo. In questa rivoluzione culturale - iniziata da Einstein, Pauli, e Plank e tuttora in corso di sviluppo e modificazione - si fa strada il concetto che le funzioni probabilistiche non siano pure astrazione matematiche, ma modelli descrittivi dell'infinitamente piccolo e delle forze ultime che regolano l'universo. Senza addentrarci in questioni che richiederebbero più di questo spazio per essere adeguatamente approfondite, diremo che il mondo non appare più binariamente diviso in concetti Aristotelicamente "veri o falsi", le verità non sono più legate ai fenomeni individuali, ma sono descritte dalle realizzazione di milioni di casi singoli, che condividono una formulazione unica, un impronta, la funzione di probabilità del fenomeno, o la sua descrizione collettiva. Questo concetto inizialmente controverso comincia a influenzare anche altri rami della teoria della scienza, in particolare la teoria dell'informazione, intaccandone e modificandone profondamente il senso. La teoria dell'informazione precede la nascita dei computer, Aristotele ha parlato di logica, semantica e metodi di deduzione già negli analitici secondi, Boole ha fondato quei principi di logica operativa che sono alla base della costruzione dei microchip, l'omonima logica booleana, a metà dell ottocento. E' interessante notare che anche se l'informatica è nata in un periodo bellicoso e disincantato della storia della scienza, i dati in informatica sin dall'inizio sono stati legati ad una interpretazione, una semantica di tipo binario. L'informazione stava in un contesto dal significato sicuro: conforme o difforme al protocollo. Vero o falso. Tutto quello che si poteva dire aderiva ad una logica aristotelica. Esisteva o non esisteva. Non solo, tutto si rifaceva ad una metodica di scuola Hilbertiana, secondo cui il significato di un simbolo non esiste intrinsecamente, ma solo estrinsencamente, il segno da solo ha significato. Le algebre sono perfettamente in grado di trasformare dati vecchi in dati nuovi seguendo protocolli senza necessità di comprendere i significati dei passaggi intermedi. Come uno scolaro trasforma una espressione algebrica lunga e complessa, fatta di numeri e lettere, radici, frazioni, esponenti, in un dato finale sintetico finale, usando sole poche regole che vengono meccanicamente applicate, così il computer poteva determinare un senso finale corretto (output) da uno iniziale (input) usando metodi finiti di manipolazione di simboli, di natura puramente sintattica. Questa la promessa di Hilbert, logico e matematico dei primi del '900. Questi metodi, oggi lo sappiamo, si chiamano programmi. In tempi recentissimi questo approccio ha cominciato ad essere radicalmente messo in discussione. Tutti abbiamo sotto gli occhi la legnosa e tetragona concretezza dei nostri computer, formidabili attuatori incapaci di qualsiasi flessibilitàinterpretativa. Per superare i limiti imposti dal modello classico della computazione intesa come puro strumento sintattico si è voluto introdurre il concetto di interpetazione non binaria del dato, e di semantica (significato contestualizzato) dell'informazione. Da qui si è fatto largo il concetto di significato del dato anche nella teoria dell'informazione. I dati hanno un senso, e questo senso non è il risultato di una singola osservazione ma emerge come un pattern, un'impronta da un insieme di osservazioni. E' interessante notare come anche nell'informatica la statistica (ma non solo quella) abbia fatto breccia proprio come strumento valido per assegnare significato ai dati. In particolare il teorema di Bayes è uno strumento potente, ma non l'unico, negli ambiti dell'intelligenza artificiale che consente di assegnare una semantica, ai dati provenienti dalla realtà. Ma vedremo questo in seguito.

1 note

·

View note

Link

Sono in piedi davanti a un enorme schermo in un laboratorio simile a un garage, all'interno della sede di Google a Goleta, in California, e con le dita sposto da un punto all'altro dello schermo dei quadratini con dei simboli: una X, una Y, una H, e altri più arcani geroglifici. I quadrati rappresentano funzioni eseguibili su un bit quantistico - un qubit - contenuto in grosso cilindro argentato lì ...

Sono in piedi davanti a un enorme schermo in un laboratorio simile a un garage, all'interno della sede di Google a Goleta, in California, e con le dita sposto da un punto all'altro dello schermo dei quadratini con dei simboli: una X, una Y, una H, e altri più arcani geroglifici. I quadrati rappresentano funzioni eseguibili su un bit quantistico - un qubit - contenuto in grosso cilindro argentato lì accanto.

Tra la miriade di funzioni disponibili, ce n'è una che fa passare il bit da 1 a 0 (o da 0 a 1); un'altra lo fa ruotare su uno degli assi. Un altro dei quadrati sullo schermo rivela lo stato del qubit, rappresentato da una specie di lecca-lecca che si muove entro una sfera, con l'estremità del bastoncino ancorata al centro. Certi numeri, quando si muove, cambiano tra 1,0000 e 0,0000. Questo è uno dei punti di forza dei qubit: non devono per forza essere 1 o 0, tutto o nulla, come i bit binari, ma possono occupare stati intermedi.

Il coniglio dal cappello Questa qualità, la "sovrapposizione", consente a ciascun qubit di effettuare più di un calcolo alla volta, accelerando la computazione in un modo che sembra quasi miracoloso. Anche se alla lettura finale ogni qubit dà un 1 o uno 0, l'esistenza di tutti quei passi intermedi significa che fare gli stessi calcoli con un computer classico può essere impossibile.

Per i profani può sembrare quasi una magia: un gesto della mano, un tocco sullo schermo, et voilà!... dal cappello quantistico è uscito un coniglio.

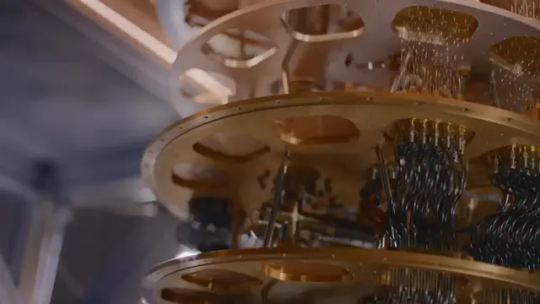

Mi trovo qui, invitato da Google con altri selezionati giornalisti, per assistere allo svelamento della magia e provare che non c'è nulla di misterioso. Sulla metà destra dello schermo, linee sinuose presentano forme d'onda che corrispondono alle funzioni in esecuzione sui qubit. Accanto a questa sezione c'è una scatola grossa come una stampante da scrivania che attraverso alcuni fili invia le stesse forme d'onda, convertite in impulsi elettrici, nel cilindro argentato.

Dentro al cilindro, se fosse aperto, si vedrebbe una serie di sei camere disposte a strati una sull'altra, come una torta nuziale rovesciata e carica di festoni fatti di fili elettrici. Ogni camera è raffreddata a una temperatura molto più bassa di quella superiore; lo strato più in basso è davvero gelido: si trova ad appena 15 millikelvin, quasi 200 volte più freddo dello spazio esterno profondo. I fili che attraversano gli strati successivi trasmettono i segnali di controllo e riportano i risultati provenienti dalla camera al caldo mondo di fuori.

La camera è tenuta sotto vuoto, schermata contro la luce e il calore, che altrimenti turberebbero i delicati qubit; questi si trovano nel chip dove terminano tutti i fili, isolato al freddo e al buio. Ogni qubit ha un diametro di circa 0,2 millimetri, abbastanza per essere visibile con un comune microscopio. Refrigerato e isolato dalle influenze esterne, però, ognuno di essi diventa un superconduttore in cui gli elettroni circolano liberamente, e si comporta come fosse un unico atomo, governato quindi, anche a grande scala, dalle leggi della meccanica quantistica.

Tenui impulsi a microonde fanno vibrare i qubit. E quando due qubit adiacenti arrivano alla stessa frequenza di risonanza si verifica l'entanglement: un'altra proprietà quantomeccanica, grazie alla quale determinare lo stato dell'uno ci dice anche quello dell'altro. Impulsi elettromagnetici di una diversa frequenza provocano l'inversione dei bit.

Un computer quantistico somiglia a una scatola al cui interno c'è una serie di pendoli, dice Craig Gidney, un softwarista quantistico di Google: io e gli altri giornalisti che inviamo segnali dentro la camera dall'esterno stiamo tirando i fili dei pendoli, modificandone le oscillazioni perché eseguano le diverse operazioni logiche.

A forza di freddo estremo e vibrazioni, il gruppo di Google dice di essere arrivato alla supremazia quantistica, cioè al punto in cui un computer quantistico riesce a fare qualcosa che i consueti computer classici non possono fare. In un lavoro appena pubblicato su "Nature" - ma uscito per errore già a settembre su un sito web della NASA - gli ingegneri di Google descrivono l'esperimento di riferimento che hanno usato per dimostrare questa supremazia. Il loro programma, che gira su oltre 50 qubit, verifica l'uscita di un generatore quantistico di numeri casuali.

Alcuni critici hanno detto che si tratta di un problema artificioso di limitata applicazione nel mondo reale, dice Hartmut Neven, che gestisce il Quantum Artificial Intelligence Lab di Google. "Neanche lo Sputnik faceva granché", ha osservato però Neven in un evento per la stampa tenutosi a Goleta. "Girava intorno alla Terra e basta. Ma segnò l'inizio dell'era spaziale."

Anche David Awschalom, fisico della materia condensata specializzato in ingegneria quantistica dell'informazione all'Università di Chicago, che non ha preso parte a questa ricerca, dice che il programma ha risolto un problema molto specifico e aggiunge che Google non può pretendere di aver realizzato un computer quantistico universale. Per farlo ci vorranno forse un milione di qubit, dice, e ci si arriverà tra parecchi anni. Ma secondo lui il gruppo ha raggiunto un'importante pietra miliare, che offre agli altri ricercatori dei risultati concreti da cui andare avanti. "Io ne sono entusiasta", dice Awschalom. "Questo tipo di risultato offre un dato molto significativo."

Il chip dell'elaboratore quantistico di Google, chiamato Sycamore, ci è arrivato usando 53 qubit. Sul chip ce n'era anche un 54°, ma c'è stato un guasto. L'obiettivo di Sycamore era produrre stringhe casuali di 1 e 0, una cifra per ogni qubit, producendo così 253 stringhe di bit (cioè 9,700199254740992 x 1015 stringhe). Dato il modo in cui i qubit interagiscono gli uni con gli altri, alcune stringhe hanno maggiori probabilità di emergere di altre.

Sycamore ha eseguito il programma di generazione dei numeri un milione di volte, e poi ha campionato i risultati per dare la probabilità che comparisse ogni data stringa. Il gruppo di Google ha fatto inoltre girare una versione più semplice dello stesso test su Summit, un supercomputer del National Laboratory di Oak Ridge, e poi ha compiuto un'estrapolazione da questi risultati per verificare i risultati di Sycamore. Il nuovo chip ha eseguito il compito in 200 secondi; un lavoraccio che a Summit, secondo le stime dei ricercatori, avrebbe richiesto 10.000 anni.

Supremazia o solo vantaggio? Ma un gruppo di ricercatori di IBM, che lavora anch'esso allo sviluppo della computazione quantistica, qualche giorno fa ha pubblicato sul sito preprint arXiv.org un lavoro in cui sostiene che in condizioni ideali e con una maggior quantità di memoria Summit potrebbe cavarsela in due giorni e mezzo.

"Dato che nel suo significato originario il termine 'supremazia quantistica', proposto nel 2012 da John Preskill, [fisico teorico del California Institute of Technology] segna il punto in cui i computer quantistici arrivano a fare cose che quelli classici non riescono a fare, questa soglia non è stata ancora raggiunta", hanno scritto gli scienziati in un post sul blog di IBM Research. Forse, allora, sarebbe più esatto chiamare il risultato di Google un "vantaggio quantistico".

Scott Aaronson, informatico teorico dell'Università del Texas ad Austin, che a volte collabora con i ricercatori di Google, dice che in realtà non è corretto dire che la supremazia quantistica non è stata raggiunta, anche se non c'è stato un risultato spettacolare e indiscutibile, come lo sbarco sulla Luna. Dopotutto, Sycamore eseguiva il suo compito più rapidamente di Summit. E con l'aumento del numero di qubit la capacità computazionale dell'apparato di Google salirà in modo esponenziale. Passare da 53 a 60 qubit gli darebbe una potenza pari a 33 supercomputer come Summit. Con 70 qubit, per uguagliarne la potenza di elaborazione un supercomputer classico come Summit dovrebbe essere grande come un'intera città.

Aaronson poi sospetta che il risultato ottenuto da Google potrebbe già avere, al di là delle intenzioni, un qualche valore pratico. Si potrebbe infatti usare il sistema per produrre numeri la cui natura casuale è garantita in modo verificabile dalle leggi della fisica quantistica. L'applicazione, per esempio, potrebbe produrre password assai più solide di quanto riescano a fare gli esseri umani o i computer classici.

"Non sono sicuro che sia il caso di mettersi a discutere se è stata raggiunta la 'supremazia' o no", dice Awschalom. La comunità dell'informatica quantistica non ha ancora trovato un accordo sul modo migliore di confrontare computer quantistici diversi, dice, soprattutto se basati su tecnologie differenti. Per creare i qubit, sia IBM che Google usano dei superconduttori, ma altri approcci si basano su ioni intrappolati, atomi carichi sospesi nel vuoto e manipolati con raggi laser. IBM ha proposto un'unità di misura detta "volume quantistico", che incorpora fattori come la velocità con cui i qubit eseguono i calcoli e l'efficienza nell'evitare o correggere gli errori.

Superare la fragilità dei qubit La correzione degli errori, in effetti, è proprio l'ostacolo che devono superare gli informatici quantistici per ottenere dispositivi davvero utili, contenenti migliaia di qubit. A quel punto, dicono i ricercatori, avremo macchine in grado di condurre dettagliate simulazioni di reazioni chimiche. che potrebbero darci nuovi farmaci o celle solari migliorate. E potrebbero anche infrangere in breve tempo i codici crittografici comunemente usati per proteggere i dati su Internet.

Per arrivare a questo tipo di performance, però, i computer quantistici devono autocorreggersi, cioè devono poter trovare e correggere gli errori nelle operazioni che svolgono. Errori che possono insorgere quando un qubit passa spontaneamente da 1 a 0, o quando la sovrapposizione quantistica decade a seguito di interferenze provenienti dal mondo esterno. Allo stato attuale, i qubit di Google durano un microsecondo e poi decadono. "La loro durata è finita", dice Marissa Giustina, una ricercatrice del progetto. "Sono molto delicati. Interagiscono con ciò che li circonda e noi perdiamo l'informazione quantistica."

Il modo in cui i computer classici ottengono l'autocorrezione è la ridondanza: decidono se un bit digitale è acceso o spento misurando non uno ma decine di migliaia di elettroni in un condensatore. I qubit, di contro, hanno natura probabilistica, quindi cercare di raggrupparli insieme per eseguire una misura collettiva non può funzionare.

Google sta sviluppando un metodo statistico di correzione degli errori, e John Martinis, un fisico dell'Università della California a Santa Barbara, che ha collaborato con l'azienda allo sviluppo di Sycamore, dice che i risultati provvisori ottenuti finora non hanno evidenziato aspetti fondamentali o ostacoli insormontabili che possano impedire un continuo miglioramento delle tecniche di correzione degli errori. La corsa, a quanto pare, può continuare.

Gli ingegneri di Google, intanto, lavoreranno a migliorare i loro qubit perché producano meno errori, e questo consentirebbe forse di interconnetterne un numero maggiore. Sperano anche di ridurre le dimensioni delle loro scatole di controllo, oggi grandi come una stampante da scrivania: ognuna di esse può gestire 20 qubit e i loro circuiti associati, quindi per i 53 qubit di Sycamore ce ne vogliono tre. Se il sistema crescerà per avvicinarsi ai 1000 qubit, le capacità di raffreddamento di quei grossi cilindri argentati non saranno sufficienti.

Julian Kelly, che lavora per Google sull'hardware quantistico e la sua architettura, dice che l'annuncio dall'azienda è soprattutto un successo ingegneristico, ma di quelli che possono aprire territori inesplorati. "Abbiamo dimostrato che l'hardware quantistico può fare qualcosa di davvero molto difficile", dice. "Stiamo lavorando in un ambito in cui nessuno finora era riuscito a fare esperimenti." Dove andremo a finire proseguendo su questa strada, dice, "non lo sappiamo ancora: siamo appena partiti".

------------------------- (L'originale di questo articolo è stato pubblicato su "Scientific American" il 24 ottobre 2019. Traduzione di Alfredo Tutino, editing a cura di Le Scienze. Riproduzione autorizzata, tutti i diritti riservati.)

https://outline.com/eZdA7B COPY Annotations ·

1 note

·

View note

Text

Un simulatore quantistico bidimensionale risolto in sito con centinaia di ioni intrappolati Un simulatore quantistico bidimensionale con centinaia di ioni intrappolati Un nuovo sviluppo nel campo della computazione quantistica ha portato alla realizzazione di un simulatore quantistico bidimensionale che coinvolge centinaia di ioni intrappolati. Questo importante avanzamento potrebbe avere grandi implicazioni per il calcolo quantistico e le sue potenziali applicazioni pratiche. Risultati di Ricerca di Risonanza La ricerca sull’implementazione fisica del calcolo quantistico, come evidenziata da DiVincenzo, ha contribuito significativamente allo sviluppo di questo simulatore quantistico bidimensionale. I risultati della ricerca sono stati pubblicati su riviste scientifiche di prestigio. Osservazioni Rilevanti Studi condotti da Zhang e colleghi hanno portato all’osservazione di una

0 notes

Text

The petrodollar is Doomed as sino Saudi relationships rise

The post is machine translated

The translation is at the bottom

The collective is on telegram

⚠️ NUOVA ERA NELLE RELAZIONI TRA CINA E MONDO ARABO, PARTENARIATO STRATEGICO TRA CINA E ARABIA SAUDITA ⚠️

🇸🇦|🇨🇳 "L'Arabia Saudita sostiene fermamente il Principio dell'Unica Cina e sostiene fermamente la Cina nel salvaguardare la propria Sovranità, Sicurezza e Integrità Territoriale, e sostiene fermamente le misure e gli sforzi della Cina per la de-radicalizzazione [nello Xinjiang] e si oppone a qualsiasi forza esterna che interferisca negli affari interni della Cina nel nome dei diritti umani", ha affermato Mohammed Bin Salman, Principe Ereditario Saudita, durante il suo incontro con Xi Jinping.

📄 Ieri, 8 dicembre, sono stati firmati 34 accordi di investimento tra Cina e Arabia Saudita in occasione della Visita di Stato di Xi Jinping - Segretario Generale del Partito Comunista Cinese - a Riyadh 🌇

https://www.arabianbusiness.com/politics-economics/saudi-chinese-companies-sign-34-investment-deals-on-the-sides-of-xi-jinpings-visit

🌱 Tali accordi riguardano numerosi settori dell'Energia Pulita, dell'Informatica e Servizi Cloud, Trasporti e Logistica, Sanità, Edilizia Abitativa e Produzione

🇸🇦|🇨🇳 Khalid Bin Abdulaziz Al-Falih - Ministro degli Investimenti - ha affermato che gli accordi firmati fanno parte degli sforzi dei due paesi per approfondire la cooperazione economica 📈

💫 Inoltre, numerosi piani sono stati discussi per sinergizzare la "Vision 2030" del Regno dell'Arabia Saudita con la Nuova Via della Seta della Repubblica Popolare Cinese 🇨🇳

📑 Come scrive RT: "L'Ascesa della Cina è di fondamentale importanza per gli Stati Arabi. L'emergere di Pechino come super-potenza sta spingendo i Paesi del Medio Oriente a diversificare i loro obiettivi strategici e ad allontanarsi da una dipendenza occidentale decennale. [...] La Cina è diversa dagli Stati Uniti: non solo, a causa delle sue enormi dimensioni, è un consumatore molto più grande di gas e petrolio, ma esercita una posizione diplomatica di non-interferenza negli affari interni di altri paesi. [...] Questo, per il Medio Oriente - di fronte a decenni di campagne guidate dagli USA e interferenze nei loro affari - è estremamente prezioso" 🏵

🇨🇳|🇸🇦 Con il viaggio di Xi Jinping a Riyadh, il rapporto sino-arabo è stato elevato a partenariato strategico in numerosi settori, soprattutto in quello dell'Information Technology, settore in cui la Cina è estremamente avanzata 💻

📄 L'accordo sulla IT è stato firmato da Wang Zhigang - Ministro della Scienza e della Tecnologia - e Abdullah Bin Amer Al-Sawaha - Ministro delle Comunicazioni e della Tecnologia Informatica.

🤖Numerosi piani di cooperazione riguardano l'Intelligenza Artificiale, l'Informatica Avanzata, la Robotica, la Computazione Quantistica e le Apparecchiature Intelligenti, tutti settori in cui la Cina è leader 🏵

🇨🇳|🇸🇦 Ieri, il Ministero degli Affari Esteri della RPC ha dichiarato che il nuovo Programma di Cooperazione Sino-Araba rappresenta la più grande attività diplomatica tra la Cina e il Mondo Arabo dalla fondazione della Repubblica Popolare 🚩

🌸 Iscriviti 👉 @collettivoshaoshan

⚠️ NEW ERA IN CHINA-Arab WORLD RELATIONS, STRATEGIC PARTNERSHIP BETWEEN CHINA AND SAUDI ARABIA ⚠️

🇸🇦|🇨🇳 "Saudi Arabia strongly supports the One China Principle and strongly supports China in safeguarding its Sovereignty, Security and Territorial Integrity, and strongly supports China's de-radicalization measures and efforts [ in Xinjiang] and opposes any external force interfering in China's internal affairs in the name of human rights," Saudi Crown Prince Mohammed bin Salman said during his meeting with Xi Jinping.

📄 Yesterday, December 8, 34 investment agreements were signed between China and Saudi Arabia on the occasion of the State Visit of Xi Jinping - General Secretary of the Communist Party of China - to Riyadh 🌇

https://www.arabianbusiness.com/politics-economics/saudi-chinese-companies-sign-34-investment-deals-on-the-sides-of-xi-jinpings-visit

🌱 These agreements concern numerous sectors of Clean Energy, Computer Science and Cloud Services, Transport and Logistics, Healthcare, Housing and Production - 📄 Source.

🇸🇦|🇨🇳 Khalid Bin Abdulaziz Al-Falih - Minister of Investments - said the signed agreements are part of the two countries' efforts to deepen economic cooperation 📈

💫 Also, numerous plans have been discussed to synergize the Kingdom of Saudi Arabia's "Vision 2030" with the People's Republic of China's New Silk Road 🇨🇳

📑 As RT writes: "The Rise of China is of fundamental importance for the Arab States. The emergence of Beijing as a super-power is pushing Middle Eastern countries to diversify their strategic objectives and move away from decades of Western dependence [...] China is different from the United States: not only, due to its enormous size, is it a much larger consumer of gas and oil, but it exercises a diplomatic position of non-interference in the internal affairs of other countries . [...] This, for the Middle East - in the face of decades of US-led campaigns and interference in their affairs - is extremely valuable" 🏵

🇨🇳|🇸🇦 With Xi Jinping's trip to Riyadh, the Sino-Arab relationship was elevated to a strategic partnership in many sectors, especially in Information Technology, a sector in which China is extremely advanced 💻

📄 The IT agreement was signed by Wang Zhigang - Minister of Science and Technology - and Abdullah Bin Amer Al-Sawaha - Minister of Communications and Information Technology.

🤖Numerous cooperation plans cover Artificial Intelligence, Advanced Computing, Robotics, Quantum Computing, and Intelligent Appliances, all sectors in which China is a leader 🏵

🇨🇳|🇸🇦 Yesterday, the Ministry of Foreign Affairs of the PRC said the new Sino-Arab Cooperation Program represents the largest diplomatic activity between China and the Arab world since the founding of the People's Republic 🚩

🌸 Subscribe 👉 @collettivoshaoshan

#socialism#china#italian#translated#china news#communism#collettivoshaoshan#xi jinping#saudi arabia#gulf states#arab world#arab news#AI#marxist#marxist leninist#marxism leninism#marxism#belt and road initiative#RT

0 notes