#Datenmigration

Explore tagged Tumblr posts

Text

Datenmigration von Altsystemen zu modernen Plattformen: Ein Leitfaden

Migrating data from old systems to modern platforms is crucial due to their essential historical data. Modern platforms offer enhanced functionality, flexibility, and better security. The process involves analyzing current systems, planning the migration, choosing the right platform, preparing and cleansing data, executing the migration, validating data, training users, and decommissioning the old system. With careful planning and execution, businesses can modernize their IT, stay competitive, and leverage new technologies.

0 notes

Text

In diesem Artikel diskutiere ich die Herausforderungen und Chancen von Cloud-Computing im Finanzsektor, mit einem Fokus auf das Risikomanagement und die Entwicklung von Exit-Strategien.

Die Dualität der Cloud im Finanzsektor: Chancen nutzen, Risiken managen Die Dualität der Cloud im Finanzsektor: Chancen nutzen, Risiken managen Hallo zusammen 👋! Als langjähriger Befürworter der Cloud-Technologien, insbesondere der Systeme von Microsoft, möchte ich heute ein Thema beleuchten, das für IT-Verantwortliche im Banken- und Finanzsektor, sowie für Branchen, die sich mit dem “Raus aus…

View On WordPress

#BaFin-Anforderungen#Banken#Cloud-Computing#Cloud-Preisstrukturen#Compliance#Datenmigration#Exit-Strategie#Finanzdienstleister#Finanzsektor#IT-Strategie#Kostenmanagement#Microsoft Cloud#Risikomanagement#Technologieinnovation#Terraform

0 notes

Text

Warum fra.digital ein vertrauenswürdiger IT-Service in Frankfurt am Main ist

Wer in Frankfurt einen zuverlässigen Partner für IT-Support, Netzwerksicherheit und individuelle Lösungen sucht, findet mit fra.digital einen regionalen IT-Dienstleister, der höchsten Ansprüchen gerecht wird.

Direkter Kontakt, persönliche Betreuung und keine Warteschleifen

Ein zentrales Qualitätsmerkmal von fra.digital ist die direkte Erreichbarkeit und persönliche Betreuung. Statt anonymer Hotlines erhalten Unternehmen, Praxen und Kanzleien in Frankfurt am Main bei fra.digital immer einen festen Ansprechpartner, der die individuelle IT-Landschaft genau kennt. Das schafft Vertrauen, sorgt für effiziente Problemlösungen und verhindert lange Ausfallzeiten. Der gesamte Service ist auf Transparenz, Klarheit und maximale Kundenzufriedenheit ausgelegt.

Transparente Abrechnung – passgenauer IT-Service ohne versteckte Kosten

fra.digital setzt bewusst auf eine faire, transparente Preisstruktur. Die Abrechnung erfolgt nach tatsächlichem Aufwand – ohne starre Wartungsverträge oder intransparente Zusatzkosten. Das ermöglicht Unternehmen, Praxen und Freiberuflern eine flexible und bedarfsgerechte Nutzung des gesamten IT-Service-Portfolios, von der Netzwerkbetreuung über Cloud-Lösungen bis hin zu individueller IT-Beratung und Sicherheit.

Beste Bewertungen und echte Kundenzufriedenheit

Die hohe Zufriedenheit der Kunden zeigt sich in den zahlreichen positiven Rückmeldungen auf unabhängigen Bewertungsportalen. Wer sich ein objektives Bild machen möchte, findet unter IT-Service Frankfurt am Main Erfahrungen bei Trustprofile und Kundenbewertungen für IT-Dienstleister fra.digital auf Trustami zahlreiche authentische Erfahrungsberichte. Diese Bewertungen bestätigen nicht nur die Kompetenz und Zuverlässigkeit von fra.digital, sondern heben insbesondere den schnellen Support, die freundliche Kommunikation und die hohe Problemlösungskompetenz hervor.

Maßgeschneiderte Lösungen für Unternehmen in Frankfurt am Main

fra.digital bietet ein umfassendes Dienstleistungsspektrum für Unternehmen aller Branchen in der Region. Dazu zählen unter anderem:

IT-Support und Störungsbeseitigung vor Ort und remote

Einrichtung, Wartung und Optimierung von Netzwerken

Implementierung moderner Cloud-Lösungen und sichere Datenmigration

IT-Sicherheit, Datenschutz und Cyber-Security

Beschaffung und Einrichtung von Hardware und Software

Individuelle Beratung zur Digitalisierung und IT-Modernisierung

Insbesondere Unternehmen ohne eigene IT-Abteilung profitieren von dem professionellen und flexibel abrufbaren Service. Die persönliche Betreuung durch einen festen Ansprechpartner erleichtert die Abstimmung, beschleunigt Lösungen und garantiert eine IT-Infrastruktur, die stets auf dem aktuellen Stand bleibt.

Fazit: fra.digital ist der ideale IT-Partner für den Mittelstand in Frankfurt am Main

Die kontinuierlich positiven IT-Service Frankfurt am Main Erfahrungen bei Trustprofile und Kundenbewertungen für IT-Dienstleister fra.digital auf Trustami unterstreichen: fra.digital überzeugt mit Fachkompetenz, Transparenz, Schnelligkeit und persönlicher Betreuung. Unternehmen, Praxen und Freiberufler in Frankfurt am Main erhalten einen IT-Service, der individuell, lösungsorientiert und zuverlässig ist.

Wer in der Metropolregion Frankfurt auf der Suche nach einem modernen IT-Dienstleister ist, sollte sich selbst überzeugen: fra.digital steht für persönlichen Service, transparente Konditionen und maximale Sicherheit – damit Sie sich auf Ihr Kerngeschäft konzentrieren können.

#it-service frankfurt#it-service#it-support#frankfurt am main#frankfurt#computer#digital#it-experte#ditigalisierung frankfurt#microsoft 365

0 notes

Text

NetSuite Consulting Companies: Der Schlüssel zur erfolgreichen ERP-Transformation

In der heutigen digitalisierten Geschäftswelt spielen NetSuite Consulting Companies eine zentrale Rolle bei der erfolgreichen Einführung und Nutzung von Cloud-ERP-Systemen. Unternehmen aller Größenordnungen – vom Mittelstand bis zu internationalen Konzernen – setzen auf spezialisierte Beratung, um die volle Leistungsfähigkeit von Oracle NetSuite auszuschöpfen.

Was machen NetSuite Consulting Companies? NetSuite Consulting Companies unterstützen Unternehmen bei der Implementierung, Anpassung und Optimierung von Oracle NetSuite – einer der führenden Cloud-ERP-Lösungen weltweit. Ihre Dienstleistungen umfassen unter anderem:

Bedarfsanalyse und Strategieberatung

Systemeinrichtung und Datenmigration

Anpassung an branchenspezifische Anforderungen

Integration mit anderen IT-Systemen (z. B. CRM, E-Commerce, Logistik)

Schulung von Mitarbeitenden

Laufender Support und Systemwartung

Warum ein zertifizierter NetSuite-Partner wichtig ist Ein erfahrener und zertifizierter NetSuite-Partner bringt nicht nur technisches Know-how mit, sondern versteht auch die branchenspezifischen Herausforderungen. Vor allem in regulierten oder komplexen Märkten wie dem deutschen Mittelstand ist Fachwissen über lokale Anforderungen (z. B. GoBD, DSGVO, DATEV-Schnittstellen) entscheidend.

Vorteile der Zusammenarbeit mit NetSuite-Beratern Zeit- und Kostenersparnis: Durch strukturierte Projektführung und Erfahrung vermeiden Unternehmen teure Fehler.

Individuelle Lösungen: Die Beratung orientiert sich an den Zielen und Prozessen des jeweiligen Unternehmens.

Zukunftssicherheit: NetSuite-Berater planen skalierbare Lösungen, die mit dem Unternehmen wachsen.

Wie wählt man die richtige NetSuite Consulting Company? Bei der Auswahl eines passenden Partners sollten Unternehmen auf folgende Punkte achten:

Zertifizierungen und Partnerschaften mit Oracle

Referenzprojekte in ähnlichen Branchen

Lokale Präsenz und Kenntnis des deutschen Markts

Support-Angebote nach dem Go-Live

Transparente Preisstruktur und klarer Projektplan

Fazit NetSuite Consulting Companies sind unverzichtbare Partner für Unternehmen, die Oracle NetSuite einführen oder optimieren möchten. Ihre Expertise beschleunigt die digitale Transformation, reduziert Risiken und sorgt für nachhaltigen Unternehmenserfolg.

#netsuite consulting companies#NetSuite Implementierungspartner#NetSuite Beratung#NetSuite Support Deutschland

0 notes

Text

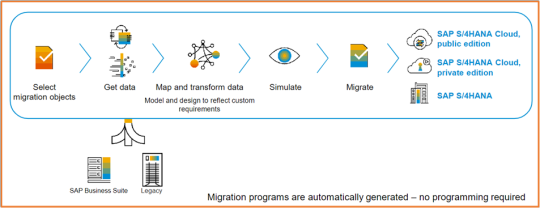

Quality Assurance in SAP Data Migrations

The SAP migration run is usually repeated several times to improve data quality and eliminate errors. Usually, a SAP system copy is created before the data migration so that the system can be reset to this state at any time. This allows iterative improvement processes in which data migrations can be repeated multiple times. Simulating the data migration also helps to identify deficiencies in advance and correct them. During the migration, all logical and semantical checks are performed analogously to manual input (no migration at the table level). Check out the core magazine to learn more:

https://s4-experts.com/2024/01/16/sap-s-4hana-datenmigration-nicht-ohne-qualitatssicherung/

#SAP #Migration #DataQuality #qualityassurance

0 notes

Text

Quality Assurance in SAP Data Migrations

The SAP migration run is usually repeated several times to improve data quality and eliminate errors. Usually, a SAP system copy is created before the data migration so that the system can be reset to this state at any time. This allows iterative improvement processes in which data migrations can be repeated multiple times. Simulating the data migration also helps to identify deficiencies in advance and correct them. During the migration, all logical and semantical checks are performed analogously to manual input (no migration at the table level). Check out the core magazine to learn more:

https://s4-experts.com/2024/01/16/sap-s-4hana-datenmigration-nicht-ohne-qualitatssicherung/

#SAP #Migration #DataQuality #qualityassurance

0 notes

Text

WordPress-Agentur

WordPress-Agentur: Ihr Partner für maßgeschneiderte Weblösungen

WordPress ist das weltweit beliebteste Content-Management-System (CMS) und ermöglicht es Unternehmen, Websites schnell, benutzerfreundlich und skalierbar zu erstellen. Eine WordPress-Agentur bietet spezialisierte Dienstleistungen für die Entwicklung, Gestaltung und Optimierung von WordPress-Websites, die auf die individuellen Bedürfnisse und Anforderungen Ihres Unternehmens zugeschnitten sind. Ob Sie eine einfache Website oder eine komplexe E-Commerce-Plattform benötigen – eine WordPress-Agentur hilft Ihnen dabei, Ihre Online-Präsenz effektiv zu gestalten.

Was macht eine WordPress-Agentur?

Eine WordPress-Agentur ist auf die Entwicklung und Wartung von Websites spezialisiert, die mit WordPress erstellt wurden. Sie bietet eine Vielzahl von Dienstleistungen, um Ihre Website zu gestalten, zu verbessern und zu optimieren, sodass Sie die bestmögliche Performance, Sicherheit und Benutzererfahrung erhalten. Die Agenturen arbeiten mit Ihnen zusammen, um Ihre Ziele zu verstehen und maßgeschneiderte Lösungen zu entwickeln, die Ihre Marke effektiv vertreten.

Dienstleistungen einer WordPress-Agentur

WordPress Webdesign und -entwicklung Eine WordPress-Agentur sorgt für die Gestaltung und Entwicklung Ihrer Website, die sowohl optisch ansprechend als auch funktional ist. Sie berücksichtigt dabei Ihre Markenidentität, die Zielgruppe und die gewünschten Funktionen. Dies umfasst die Auswahl und Anpassung von Themes, das Design von Individuen-Seiten und die Integration von Plugins, die zusätzliche Funktionen wie Kontaktformulare, Social Media-Verknüpfungen oder E-Commerce-Optionen ermöglichen.

Responsive Webdesign In der heutigen mobilen Welt ist es entscheidend, dass Ihre Website auf allen Geräten gut aussieht und funktioniert. Eine WordPress-Agentur sorgt dafür, dass Ihre Website mit einem responsive Design entwickelt wird, das sich automatisch an die Bildschirmgröße von Smartphones, Tablets und Desktops anpasst.

SEO-Optimierung Eine WordPress-Agentur bietet professionelle SEO-Dienstleistungen, um sicherzustellen, dass Ihre Website in den Suchmaschinen gut platziert wird. Dies umfasst die On-Page-Optimierung, wie die Verwendung von relevanten Keywords, die Erstellung von Meta-Beschreibungen, die Verbesserung der Ladegeschwindigkeit und die Integration von SEO-freundlichen Plugins.

E-Commerce-Lösungen Wenn Sie Produkte oder Dienstleistungen online verkaufen möchten, bietet eine WordPress-Agentur Lösungen für den E-Commerce. Mit Plugins wie WooCommerce können Sie einen professionellen Online-Shop erstellen, der alle Funktionen für Produktanzeigen, Zahlungsabwicklung, Bestellverwaltung und Versand enthält. Die Agentur sorgt dafür, dass Ihr Shop benutzerfreundlich, sicher und leistungsfähig ist.

WordPress-Wartung und Support Eine professionelle WordPress-Agentur bietet kontinuierliche Wartung und Support, um sicherzustellen, dass Ihre Website stets aktuell und sicher bleibt. Dazu gehören regelmäßige Updates für WordPress-Kern, Themes und Plugins, Sicherheitsüberprüfungen, Backups und die Behebung von technischen Problemen.

WordPress-Plugin-Entwicklung Falls Ihre Website spezielle Funktionen benötigt, die von bestehenden Plugins nicht abgedeckt werden, kann eine WordPress-Agentur maßgeschneiderte Plugins entwickeln, um Ihre Anforderungen zu erfüllen. Dies ermöglicht eine noch flexiblere Gestaltung Ihrer Website.

Content-Erstellung und -Management Eine WordPress-Agentur unterstützt Sie auch bei der Content-Erstellung und der kontinuierlichen Pflege Ihrer Website-Inhalte. Sie helfen Ihnen, ansprechende Texte, Bilder und Videos zu erstellen, die Ihre Zielgruppe fesseln und Ihr SEO-Ranking verbessern.

Migration und Relaunch von Websites Falls Sie eine bestehende Website auf WordPress migrieren möchten oder einen kompletten Relaunch planen, kann die Agentur sicherstellen, dass der Übergang reibungslos verläuft. Dies umfasst die Datenmigration, das Design-Update und die Suchmaschinenoptimierung.

Warum eine WordPress-Agentur wählen?

WordPress ist ein flexibles und leistungsstarkes CMS, das eine einfache Handhabung und Anpassung ermöglicht. Doch um das volle Potenzial von WordPress auszuschöpfen, benötigen Sie die Expertise einer Agentur, die Erfahrung mit der Plattform hat. Die Vorteile einer WordPress-Agentur sind:

Fachwissen und Erfahrung: WordPress-Agenturen sind Experten auf diesem Gebiet und wissen, wie man das Beste aus der Plattform herausholt. Sie kennen sich mit den besten Themes, Plugins und SEO-Techniken aus, um Ihre Website leistungsfähig zu machen.

Individuelle Lösungen: Eine WordPress-Agentur entwickelt maßgeschneiderte Websites, die auf Ihre spezifischen Bedürfnisse und Ziele abgestimmt sind.

Schnelle Umsetzung: Durch die Verwendung von bewährten Prozessen und Tools kann eine WordPress-Agentur Projekte schnell und effizient umsetzen, ohne dabei die Qualität zu beeinträchtigen.

Sicherheit und Support: WordPress-Agenturen sorgen für die Sicherheit Ihrer Website und bieten kontinuierlichen Support, um technische Probleme schnell zu lösen und Ihre Website auf dem neuesten Stand zu halten.

Optimierung für Suchmaschinen: Agenturen helfen Ihnen dabei, Ihre Website für Google und andere Suchmaschinen zu optimieren, sodass Sie mehr Traffic generieren und Ihre Zielgruppe besser erreichen.

Wie wählt man die richtige WordPress-Agentur?

Erfahrung und Referenzen Eine gute WordPress-Agentur sollte nachweisbare Erfahrung in der Entwicklung von WordPress-Websites haben. Sehen Sie sich deren Portfolio und Kundenbewertungen an, um herauszufinden, ob sie ähnliche Projekte erfolgreich umgesetzt haben.

Kompetenz in SEO und Performance-Optimierung Es reicht nicht aus, nur eine schöne Website zu haben – sie muss auch schnell und gut in den Suchmaschinen platziert sein. Achten Sie darauf, dass die Agentur auch SEO-Optimierung und Performance-Optimierung als Teil ihres Serviceangebots hat.

Maßgeschneiderte Lösungen Wählen Sie eine Agentur, die bereit ist, Ihre speziellen Anforderungen zu verstehen und maßgeschneiderte Lösungen zu entwickeln, die zu Ihrem Geschäftsmodell passen.

Zuverlässigkeit und Kommunikation Die Zusammenarbeit mit einer Agentur sollte reibungslos und transparent sein. Achten Sie darauf, dass die Agentur regelmäßige Updates gibt und sich an Vereinbarungen hält.

Budget und Preis-Leistungs-Verhältnis Die Agentur sollte Ihnen ein transparentes und faires Angebot unterbreiten, das alle Kosten für die Entwicklung und den Support abdeckt. Achten Sie darauf, dass das Preis-Leistungs-Verhältnis stimmt.

Fazit: Warum eine WordPress-Agentur der richtige Partner für Ihre Website ist

Die Wahl einer WordPress-Agentur ist der beste Schritt, um eine professionelle, funktionale und gut optimierte Website zu erhalten, die Ihre Geschäftsziele unterstützt. Mit einem breiten Serviceangebot, das von Webdesign über SEO bis hin zu E-Commerce und Wartung reicht, können Sie sicherstellen, dass Ihre WordPress-Website sowohl optisch ansprechend als auch leistungsstark und benutzerfreundlich ist. Eine WordPress-Agentur bringt die nötige Expertise mit, um Ihre Website auf die nächste Stufe zu heben und Ihre digitalen Ziele zu erreichen.

0 notes

Text

Compliance-Anforderungen bei der Cloud-Datenmigration

In der heutigen digitalen Landschaft ist die Migration von Daten in die Cloud ein unverzichtbarer Schritt für Unternehmen, die ihre Effizienz steigern und die Vorteile moderner Technologien nutzen möchten. Während der Fokus häufig auf den technischen Aspekten der Migration liegt, spielen Compliance-Anforderungen eine entscheidende Rolle, um rechtliche Konsequenzen zu vermeiden und das Vertrauen…

#Authentifizierung#Best Practice#Best Practices#Compliance#Datenschutz#Datenschutzgesetze#Datenverschlüsselung#Führung#Risikoanalyse#Sicherheitsmaßnahmen#Verschlüsselung#Zugriffskontrolle

0 notes

Text

Automatisierung von Verkaufsprozessen mit KI: KI-Strategie und -Implementierung

Im heutigen wettbewerbsorientierten Geschäftsumfeld ist die Nutzung künstlicher Intelligenz (KI) zur Optimierung von Verkaufsprozessen für Unternehmen, die die Nase vorn behalten wollen, unverzichtbar geworden. Die Automatisierung von Verkaufsprozessen mit KI verbessert die Effizienz, Genauigkeit und Personalisierung in jeder Phase des Verkaufszyklus. Durch die Implementierung der richtigen KI-Strategie können Unternehmen Arbeitsabläufe optimieren, das Kundenerlebnis verbessern und das Umsatzwachstum steigern.

Verständnis der Automatisierung von Verkaufsprozessen mit KI

Bei der Automatisierung von Verkaufsprozessen mit KI werden Algorithmen und Modelle des maschinellen Lernens verwendet, um sich wiederholende Aufgaben zu erledigen, Daten zu analysieren und umsetzbare Erkenntnisse zu generieren. Aufgaben wie Lead-Scoring, Kundensegmentierung und Nachverfolgungsplanung können effizient durch KI verwaltet werden, sodass Vertriebsteams sich auf strategischere Aufgaben wie den Aufbau von Beziehungen und den Abschluss von Geschäften konzentrieren können.

KI-gesteuerte Tools können große Datenmengen schnell verarbeiten, sodass Unternehmen das Verhalten, die Vorlieben und die Bedürfnisse der Kunden besser verstehen. Diese Erkenntnisse werden dann verwendet, um personalisierte Interaktionen anzupassen und die Wahrscheinlichkeit von Konvertierungen zu erhöhen. Die Automatisierung minimiert auch menschliche Fehler und stellt sicher, dass alle Leads durch den Verkaufstrichter konsequent gepflegt werden.

Aufbau einer KI-Strategie für die Vertriebsautomatisierung

Die Entwicklung einer robusten KI-Strategie für die Automatisierung von Vertriebsprozessen erfordert ein klares Verständnis der Geschäftsziele und -herausforderungen. Zunächst sollten Unternehmen ihre aktuellen Vertriebsprozesse bewerten, um Schwachstellen und Möglichkeiten zu identifizieren, bei denen Automatisierung einen Mehrwert bringen kann. Unternehmen haben beispielsweise möglicherweise Schwierigkeiten, die Lead-Generierung effizient zu verwalten, potenzielle Kunden zu qualifizieren oder zeitnahe Nachverfolgungen durchzuführen. KI kann eingeführt werden, um diese Herausforderungen effektiv zu bewältigen.

Als nächstes ist die Auswahl der richtigen KI-Tools und -Technologien von entscheidender Bedeutung. Unternehmen sollten sich auf Lösungen konzentrieren, die sich gut in vorhandene CRM-Systeme integrieren lassen und eine einfache Datenmigration ermöglichen. KI-Tools, die mit natürlicher Sprachverarbeitung (NLP) ausgestattet sind, können auch die Kommunikation mit Kunden durch automatisierte Chatbots oder personalisierte E-Mail-Kampagnen verbessern.

Sobald die Tools vorhanden sind, sollte die KI-Implementierungsphase eine Schulung des Vertriebsteams darin umfassen, wie diese Tools zu ihrem Vorteil genutzt werden können. Ein schrittweiser Ansatz zur KI-Integration ist ideal, da er eine kontinuierliche Optimierung ermöglicht und Störungen des Vertriebsprozesses minimiert.

Fazit

Die Zukunft des Vertriebs liegt in der Automatisierung, und KI steht an vorderster Front dieser Transformation. Durch die Entwicklung und Umsetzung einer soliden KI-Strategie können Unternehmen das volle Potenzial der Automatisierung von Verkaufsprozessen ausschöpfen und so ihre Effizienz und Rentabilität steigern. Die Digital Media 360 GmbH ist auf KI-Strategie und -Implementierung spezialisiert und unterstützt Unternehmen dabei, ihre Vertriebsabläufe zu modernisieren und in einer zunehmend digitalen Welt erfolgreich zu sein.

Weitere Informationen:-

vertrieb prozessautomatisierung mit ki

KI Strategie und Implementierung

1 note

·

View note

Text

Fundraising CRM: Die Schlüsselrolle eines effizienten Systems im Spendenmanagement

In der heutigen digitalen Welt ist das Management von Spenden und Spenderbeziehungen entscheidend für den Erfolg von gemeinnützigen Organisationen. Ein Fundraising CRM (Customer Relationship Management) System bietet eine effektive Lösung, um diese Aufgaben zu optimieren. In diesem Blogbeitrag erläutern wir, was ein Fundraising CRM ist, welche Vorteile es bietet und wie es erfolgreich eingesetzt werden kann.

Was ist ein Fundraising CRM?

Ein Fundraising CRM ist eine spezialisierte Softwarelösung, die gemeinnützigen Organisationen dabei hilft, ihre Spendenaktionen zu verwalten, Spender-Beziehungen zu pflegen und Fundraising-Kampagnen zu organisieren. Es vereint verschiedene Funktionen, die den gesamten Prozess des Spenden Managements unterstützen, von der Spenderdaten Verwaltung bis hin zur Analyse und Berichterstattung.

Vorteile eines Fundraising CRM

Effiziente Spendenverwaltung: Ein Fundraising CRM ermöglicht es, alle Informationen über Spender an einem zentralen Ort zu speichern und zu verwalten. Dadurch können Organisationen ihre Spender besser verstehen und gezielter ansprechen. Historische Daten zu Spenden, Kommunikation und Engagement werden erfasst, was die Personalisierung von Fundraising-Kampagnen erleichtert.

Automatisierung von Prozessen: Mit einem crm for Fundraising können viele manuelle Prozesse automatisiert werden. Dies umfasst die Verwaltung von Spendenquittungen, das Versenden von Dankesschreiben und die Nachverfolgung von Spendenzusagen. Automatisierung spart Zeit und reduziert das Risiko menschlicher Fehler.

Fundraising-Kampagnen optimieren: Fundraising CRM Systeme bieten Tools zur Planung und Durchführung von Kampagnen. Organisationen können Kampagnen erstellen, Zielgruppen definieren, Fortschritte verfolgen und Ergebnisse analysieren. Durch diese systematische Herangehensweise lassen sich Fundraising-Strategien kontinuierlich verbessern.

Berichterstattung und Analyse: Ein weiterer Vorteil eines Fundraising CRM ist die Fähigkeit, detaillierte Berichte und Analysen zu erstellen. Organisationen können Spenden, Ströme, Spendenverhalten und Kampagnen Erfolge überwachen. Diese Daten sind entscheidend, um fundierte Entscheidungen zu treffen und die Fundraising-Strategie anzupassen.

Implementierung eines Fundraising CRM

Die Implementierung eines Fundraising CRM erfordert sorgfältige Planung und Vorbereitung. Hier sind einige Schritte, die dabei helfen können:

Bedarfsanalyse: Zunächst sollte die Organisation ihre spezifischen Anforderungen und Ziele definieren. Welche Funktionen sind notwendig? Welche Daten sollen erfasst werden? Eine klare Bedarfsanalyse hilft dabei, die passende CRM-Lösung auszuwählen.

Auswahl der richtigen Software: Es gibt viele Fundraising CRM Systeme auf dem Markt, wie z.B. Salesforce Nonprofit Cloud, DonorPerfect und Bloomerang. Die Wahl der richtigen Software hängt von den spezifischen Anforderungen und dem Budget der Organisation ab.

Datenmigration: Bei der Umstellung auf ein neues crm for Fundraising ist die Migration bestehender Daten ein wichtiger Schritt. Daten müssen sorgfältig bereinigt und in das neue System übertragen werden, um eine nahtlose Integration zu gewährleisten.

Schulung und Support: Ein Fundraising CRM ist nur so gut wie die Menschen, die es nutzen. Daher ist es wichtig, Schulungen für das Team anzubieten und sicherzustellen, dass alle Benutzer das System effektiv nutzen können. Viele Anbieter bieten auch laufenden Support und Ressourcen an.

Kontinuierliche Anpassung: Die Bedürfnisse einer Organisation können sich im Laufe der Zeit ändern. Ein gutes Fundraising CRM sollte flexibel und anpassbar sein, um mit den sich entwickelnden Anforderungen Schritt zu halten. Regelmäßige Überprüfungen und Anpassungen des Systems sind daher unerlässlich.

Fazit

Ein Fundraising CRM ist ein unverzichtbares Werkzeug für gemeinnützige Organisationen, die ihre Spendenaktionen und Spender-Beziehungen effektiv verwalten möchten. Es bietet zahlreiche Vorteile, von der effizienten Spendenverwaltung über die Automatisierung von Prozessen bis hin zur Optimierung von Kampagnen. Mit der richtigen Planung und Implementierung kann ein Fundraising CRM dazu beitragen, die Effizienz und den Erfolg von Fundraising-Bemühungen erheblich zu steigern. Nutzen Sie die Möglichkeiten, die ein crm for Fundraising bietet, und bringen Sie Ihre Organisation auf das nächste Level.

Klicken Sie hier, um den gesamten Inhalt zu lesen-Fundraising CRM

0 notes

Text

Datenmigration von Altsystemen zu modernen Plattformen: Ein Leitfaden

In der heutigen digitalen Ära ist die Migration von Daten aus Altsystemen zu modernen Plattformen eine entscheidende Aufgabe für viele Unternehmen. Altsysteme, oft tief in die Geschäftsprozesse integriert, enthalten wertvolle historische Daten, die für den laufenden Betrieb unerlässlich sind. Gleichzeitig erfordert die schnelle technologische Entwicklung die Umstellung auf fortschrittlichere, effizientere Systeme. Dieser Leitfaden bietet einen umfassenden Überblick über die wesentlichen Schritte und bewährten Verfahren für eine erfolgreiche Datenmigration von Altsystemen zu modernen Plattformen.

Warum die Migration von Altsystemen notwendig ist

Altsysteme, die über viele Jahre hinweg entwickelt wurden, haben oft Probleme mit veralteter Technologie, mangelnder Unterstützung und eingeschränkter Skalierbarkeit. Die Notwendigkeit zur Migration ergibt sich aus mehreren Faktoren:

Technologische Veralterung: Altsysteme basieren oft auf veralteter Technologie, die nicht mehr unterstützt wird, was die Wartung schwierig und kostspielig macht.

Geschäftliche Flexibilität: Moderne Plattformen bieten erweiterte Funktionen und eine höhere Flexibilität, die erforderlich sind, um auf dynamische Marktanforderungen zu reagieren.

Datensicherheit und Compliance: Aktuelle Sicherheitsstandards und Datenschutzgesetze erfordern oft eine Modernisierung der IT-Infrastruktur, um Compliance zu gewährleisten.

Schritt-für-Schritt-Leitfaden zur Datenmigration

1. Analyse und Bewertung der bestehenden Systeme

Der erste Schritt jeder Datenmigration ist eine gründliche Analyse der Altsysteme. Dies beinhaltet:

Dateninventar: Erfassen Sie alle Datenbestände und bewerten Sie deren Relevanz und Nutzung.

Datenqualität: Überprüfen Sie die Daten auf Genauigkeit, Vollständigkeit und Relevanz.

Systemdokumentation: Sammeln Sie alle verfügbaren Dokumentationen und erstellen Sie bei Bedarf neue, um die Funktionsweise und Struktur des Altsystems zu verstehen.

2. Festlegung der Migrationsstrategie

Basierend auf der Analyse sollten Sie eine Migrationsstrategie entwickeln. Es gibt mehrere Ansätze, darunter:

Big Bang Migration: Alle Daten werden in einem einzigen, umfassenden Schritt migriert. Dies ist schnell, aber risikoreich.

Schrittweise Migration: Daten werden in Phasen migriert, wodurch Risiken minimiert und die Kontrolle verbessert wird.

Hybride Migration: Kombination aus Big Bang und schrittweiser Migration, je nach den spezifischen Anforderungen und Risiken.

3. Auswahl der Zielplattform

Wählen Sie eine moderne Plattform, die den aktuellen und zukünftigen Anforderungen Ihres Unternehmens entspricht. Berücksichtigen Sie dabei:

Skalierbarkeit: Die Fähigkeit der Plattform, mit dem Wachstum des Unternehmens mitzuhalten.

Integration: Die Kompatibilität der neuen Plattform mit bestehenden und zukünftigen Systemen.

Sicherheit: Die Fähigkeit der Plattform, aktuelle Sicherheits- und Compliance-Anforderungen zu erfüllen.

4. Datenbereinigung und -vorbereitung

Vor der eigentlichen Migration ist es wichtig, die Daten zu bereinigen. Dies beinhaltet:

Datenbereinigung: Entfernen von Duplikaten, fehlerhaften oder irrelevanten Daten.

Datenkonsolidierung: Zusammenführen von Daten aus verschiedenen Quellen zu einem konsistenten Datensatz.

Datenmapping: Erstellen einer Zuordnung zwischen den Datenfeldern des Altsystems und der Zielplattform.

5. Durchführung der Migration

Jetzt beginnt der eigentliche Migrationsprozess. Dieser umfasst:

Datenextraktion: Exportieren der Daten aus dem Altsystem.

Datenumwandlung: Transformieren der Daten in das Format, das für die Zielplattform geeignet ist.

Datenladung: Importieren der transformierten Daten in die neue Plattform.

6. Validierung und Testen

Nach der Migration ist es entscheidend, die Daten gründlich zu validieren und zu testen. Prüfen Sie:

Datenintegrität: Stellen Sie sicher, dass alle Daten korrekt und vollständig migriert wurden.

Systemfunktionalität: Überprüfen Sie, ob die neue Plattform wie erwartet funktioniert.

Benutzerakzeptanz: Testen Sie mit Endbenutzern, um sicherzustellen, dass die neue Plattform ihre Anforderungen erfüllt.

7. Schulung und Übergang

Schulen Sie die Benutzer auf der neuen Plattform und unterstützen Sie den Übergang. Dies kann umfassen:

Benutzerschulungen: Workshops und Schulungen, um die Benutzer mit den neuen Prozessen und Systemen vertraut zu machen.

Supportbereitstellung: Einrichtung eines Support-Teams, um Fragen und Probleme während des Übergangs zu bewältigen.

8. Abschaltung des Altsystems

Nach erfolgreicher Migration und Validierung der neuen Plattform kann das Altsystem abgeschaltet werden. Stellen Sie sicher:

Datenarchivierung: Bewahren Sie eine archivierte Kopie der Altdaten für Referenz- oder Compliance-Zwecke auf.

Systemdeaktivierung: Sicheres und vollständiges Abschalten des Altsystems, um Kosten und Risiken zu minimieren.

Fazit

Die Datenmigration von Altsystemen zu modernen Plattformen ist eine komplexe, aber notwendige Aufgabe, um den Anforderungen der modernen Geschäftswelt gerecht zu werden. Durch eine sorgfältige Planung, die Auswahl der richtigen Strategie und die gründliche Durchführung jedes Schritts können Unternehmen ihre IT-Landschaft effektiv modernisieren, ihre Wettbewerbsfähigkeit sichern und die Vorteile neuer Technologien nutzen.

Indem Sie die Herausforderungen der Altsysteme adressieren und die richtigen Lösungen implementieren, schaffen Sie die Basis für eine zukunftssichere und leistungsfähige IT-Infrastruktur.

0 notes

Text

Thema: Datenmigration auf SharePoint

Erfahren Sie in meinem umfassenden Leitfaden, wie Sie eine effiziente Datenmigration auf SharePoint planen und durchführen.

10 Fragen, die Führungskräfte interessieren Wann ist der ideale Zeitpunkt, um auf SharePoint zu migrieren? Wie läuft eine Migration genau ab, und was kostet sie? Heute beantworten wir zehn wichtige Fragen rund um die Datenmigration auf SharePoint, die für jede Ausführungskraft von Interesse sind. 1. Wann ist der optimale Zeitpunkt für eine Migration auf SharePoint? Die Entscheidung für den…

View On WordPress

0 notes

Text

Wie man Risiken bei SAP Carve Outs minimiert: Ein Risikomanagement-Ansatz

Einleitung

Der SAP Carve Out, also die Abspaltung eines Unternehmensbereichs in ein eigenständiges System, ist ein komplexer und oft risikobehafteter Prozess. Diese Risiken können von technischen Herausforderungen über organisatorische Veränderungen bis hin zu Compliance-Problemen reichen. Ein gut durchdachtes Risikomanagement ist daher entscheidend, um den Carve Out erfolgreich und ohne größere Probleme zu bewältigen.

Identifikation der Risiken

Der erste Schritt im Risikomanagement ist die Identifikation potenzieller Risiken. Dies beinhaltet die Analyse aller relevanten Aspekte des Carve Outs, wie z.B. technische Infrastruktur, Datenmigration, regulatorische Anforderungen und organisatorische Veränderungen. Jedes dieser Elemente birgt spezifische Risiken, die identifiziert und dokumentiert werden müssen. Ein Workshop mit allen relevanten Stakeholdern kann dabei helfen, ein umfassendes Bild der möglichen Gefahren zu erhalten.

Bewertung der Risiken

Nach der Identifikation müssen die Risiken bewertet werden. Dabei wird jedes Risiko hinsichtlich seiner Wahrscheinlichkeit und potenziellen Auswirkungen analysiert. Eine Risikomatrix kann hierbei ein nützliches Werkzeug sein. Sie hilft, die Risiken zu priorisieren und diejenigen zu identifizieren, die die größte Aufmerksamkeit erfordern. Risiken mit hoher Wahrscheinlichkeit und schwerwiegenden Auswirkungen sollten im Fokus der weiteren Maßnahmen stehen.

Entwicklung von Gegenmaßnahmen

Für jedes identifizierte Risiko müssen geeignete Gegenmaßnahmen entwickelt werden. Diese Maßnahmen sollten darauf abzielen, entweder die Eintrittswahrscheinlichkeit des Risikos zu verringern oder dessen Auswirkungen zu minimieren. Beispielsweise kann die Einführung strengerer Sicherheitsprotokolle das Risiko eines Datenverlustes reduzieren. Zudem können Schulungen und klare Kommunikationsstrategien dazu beitragen, organisatorische Risiken zu minimieren und die Akzeptanz des Carve Outs bei den Mitarbeitern zu erhöhen.

Implementierung und Überwachung

Die entwickelten Gegenmaßnahmen müssen anschließend implementiert und deren Wirksamkeit kontinuierlich überwacht werden. Dies erfordert ein gutes Projektmanagement sowie regelmäßige Überprüfungstermine, um sicherzustellen, dass die Maßnahmen wie geplant wirken. Zudem sollten flexible Anpassungen möglich sein, um auf unvorhergesehene Entwicklungen schnell reagieren zu können. Eine enge Zusammenarbeit zwischen IT, Compliance und den betroffenen Fachabteilungen ist hierbei unerlässlich.

Fazit

Ein umfassender Risikomanagement-Ansatz ist entscheidend, um die zahlreichen Herausforderungen eines SAP Carve Outs erfolgreich zu meistern. Durch die systematische Identifikation, Bewertung und Steuerung der Risiken kann das Projekt sicher und effizient durchgeführt werden. Dabei spielen die kontinuierliche Überwachung und Anpassungsfähigkeit eine zentrale Rolle, um auf Veränderungen schnell reagieren zu können und die Projektziele zu erreichen.

0 notes

Text

Was kostet ein ERP-System wirklich? Ein Überblick über die ERP System Kosten

Die ERP System Kosten gehören zu den wichtigsten Entscheidungsfaktoren für Unternehmen, die ihre Geschäftsprozesse digitalisieren möchten. Doch was kostet ein ERP-System wirklich? Die Antwort hängt von vielen Variablen ab – von der Unternehmensgröße über den Funktionsumfang bis hin zum gewählten Anbieter.

1. Was ist ein ERP-System?

Ein ERP-System (Enterprise Resource Planning) ist eine Softwarelösung, die verschiedene Geschäftsbereiche wie Buchhaltung, Lager, Einkauf, Vertrieb und Personalwesen in einem zentralen System integriert. Ziel ist es, Prozesse zu optimieren, Datenflüsse zu vereinheitlichen und die Effizienz zu steigern.

2. Welche Kostenfaktoren beeinflussen die ERP System Kosten?

Die Gesamtkosten eines ERP-Systems setzen sich aus mehreren Komponenten zusammen:

Lizenzkosten: Einmalige oder laufende Gebühren je nach Anbieter (z. B. On-Premise vs. Cloud).

Implementierungskosten: Konfiguration, Datenmigration und Anpassung des Systems.

Schulung & Support: Training der Mitarbeiter und technischer Kundensupport.

Wartung & Updates: Regelmäßige Aktualisierungen und technische Wartung.

Skalierung: Zusätzliche Module oder Nutzerzugänge, wenn das Unternehmen wächst.

3. Cloud-ERP vs. On-Premise: Unterschiede bei den Kosten

KriteriumCloud-ERPOn-Premise-ERPAnfangskostenGering (Abo-Modell)Hoch (einmalige Lizenz + Hardware)Laufende KostenMonatlich oder jährlichWartung + IT-PersonalFlexibilitätHoch (skalierbar)Geringer (statisch)IT-InfrastrukturWird vom Anbieter gestelltMuss intern aufgebaut werden

4. Beispielhafte Kostenübersicht (KMU mit 50 Mitarbeitenden)

KostenartDurchschnittlicher BetragLizenz (Cloud, jährlich)12.000 – 25.000 €Implementierung15.000 – 40.000 €Schulung3.000 – 7.000 €Wartung & Support2.000 – 5.000 € pro Jahr

Hinweis: Die tatsächlichen Kosten variieren stark je nach Branche, Anbieter und individuellem Bedarf.

5. Tipps zur Kostenoptimierung

Beginnen Sie mit einem Modulsystem, um nur das zu bezahlen, was Sie wirklich benötigen.

Vergleichen Sie mehrere Anbieter durch Pilotprojekte oder kostenlose Testversionen.

Investieren Sie in Schulungen, um Fehler und ineffiziente Nutzung zu vermeiden.

Nutzen Sie Förderprogramme, etwa von der EU oder lokalen Wirtschaftsförderungen.

Fazit

Die ERP System Kosten sind kein fixer Betrag, sondern das Ergebnis individueller Anforderungen und strategischer Entscheidungen. Eine genaue Analyse und gute Planung sind entscheidend, um sowohl Kosten als auch Nutzen langfristig zu optimieren.

0 notes

Text

SAP Migration Cockpit and Migration Strategy

Since the Migration Cockpit is delivered with the S/4HANA system and replaces the Legacy System Migration Workbench (SAP LSMW), our article will explain this tool in detail. Alternative solutions will be briefly addressed. Factors influencing the choice of migration strategy and tool include the number and volume of migration data objects to be transferred and converted, acceptable system downtime, data quality in source systems, required data changes or optimizations, the deployment model of the target system (SAP cloud or SAP on-premise system), and the number and type of source systems. Learn more about the Migration Cockpit and Migration Strategy, if required via our translator:

https://s4-experts.com/2023/11/29/sap-s-4hana-datenmigration-und-das-migrationscockpit/

#SAP #migration #Strategy #migrationcockpit

0 notes

Text

SAP Migration Cockpit and Migration Strategy

Since the Migration Cockpit is delivered with the S/4HANA system and replaces the Legacy System Migration Workbench (SAP LSMW), our article will explain this tool in detail. Alternative solutions will be briefly addressed. Factors influencing the choice of migration strategy and tool include the number and volume of migration data objects to be transferred and converted, acceptable system downtime, data quality in source systems, required data changes or optimizations, the deployment model of the target system (SAP cloud or SAP on-premise system), and the number and type of source systems. Learn more about the Migration Cockpit and Migration Strategy, if required via our translator:

https://s4-experts.com/2023/11/29/sap-s-4hana-datenmigration-und-das-migrationscockpit/

#SAP #migration #Strategy #migrationcockpit

0 notes