#Cloud-Plattform

Explore tagged Tumblr posts

Text

Was sind die Vor- und Nachteile des Amazon EC2?: "Vorteile und Nachteile des Amazon EC2: Ein DevOps Engineer Guide”

#AmazonEC2 bietet #Skalierbarkeit, #Flexibilität, #Kosteneffizienz und #Sicherheit. Mit der Cloud-Plattform steigern Sie Ihre #Verfügbarkeit und können Servicelevel-Agreemente nutzen. Vorteile wie #Automatisierung und die Elastic Compute Cloud machen das Ganze zu einer kosteneffizienten Lösung. #CloudComputing

Der Amazon Elastic Compute Cloud (EC2) ist ein Cloud-Computing-Dienst, der es Unternehmen ermöglicht, Ressourcen bereitzustellen und zu verwalten, um sich ihren Anforderungen anzupassen und in die Cloud zu skalieren. Mit Amazon EC2 können Unternehmen schnell und einfach Web- und Anwendungsressourcen hinzufügen, die Rechenleistung oder Speicherkapazität benötigen. Der Amazon EC2 bietet viele…

View On WordPress

#Automatisierung#Cloud-Plattform#Elastic Compute Cloud.#Flexibilität.#Keywörter: Amazon EC2#Kosteneffizienz#Servicelevel-Agreement#Sicherheit#Skalierbarkeit#Verfügbarkeit.

0 notes

Text

Too Much

Pairing — Xu Minghao x Reader

Summary — Sometimes meditating is not enough to keep Minghaos temper at bay and sometimes he says things he doesn't mean...

Genre — angst, established relationship, idol!au

Warnings — argument, Hao is an idiot

Word Count — 0.8k

Rating — pg-13

Disclaimer: this fic is written and copyrighted by ©soo0hee on tumblr. do not rewrite or repost on any other plattforms without my permission.

ALL RIGHTS RESERVED!

Shocked and with your jaw on the floor you stared into Minghaos dark eyes.

You understood that with all of his busy schedules, he was tired when he came home and that all he wanted would be to relief some of his stress with a hot shower, a nice nap and maybe some cuddles. You understood all of it.

However what you didn’t understand was why he regularly would let out his frustrations on someone who had nothing to do with any of the causes he felt so tired, namely you.

It was a conversation that you had tried to have with him on multiple occasions, yet your boyfriend seemed to try and ignore the obvious elephant in the room and every single time you had let yourself be swayed into giving in.

“Can we not do this now? I promise we will talk about it in the morning.” Was what he would say, only to be gone by the time you woke up.

This time though, you were ready to insist on this conversation being held. You just couldn’t ignore it anymore!

You had a job too! A job that stressed you out too and being the on to receive his mood was beginning to weight heavily on your shoulders.

But now, after the screaming match you had just had, you weren’t quite sure if this was your best idea.

The words he had spat at you just seconds ago were ringing in your ears and you could feel the burn behind your eyes. Tears just waiting to be spilled.

“Stop annoying me with this every few day. Seriously, you’re being to much right now!”

You knew that he had surprised himself with his words, the look of shock and guilt clouding his face immediately after the they had left him, but you didn’t want to hear it.

You didn’t want to hear his excuse of why he had said it because it was obvious that while surprised, some part of him did think you were being to much.

For a second you were unsure if you even had the right to tell him this. Maybe you were being in the wrong here?

Your inner voice shook its head. No! You had just as much right to be treated like a human then he had!

“I-“ he tried to say but you held up your hand, the tears that had burned in your eyes now falling freely in silence.

“Don’t.”

You rushed away, letting those tears fall down your face as you locked the bedroom door behind you, preventing Minghao from getting inside.

You didn’t care if he had to sleep on the couch or what it would do to his back and neck. You didn’t give a fuck if he would be waking up in pain in the morning. And you didn’t want to know what kind of apologize he was trying to come up with.

He couldn’t make it better, at least not right now.

Curling together underneath your blanket, hiding away from the world while sobs spilled from your mouth you clutched your favorite pillow to your chest. It was drenched in Minghaos scent because he had the habit of sleeping on every inch of the bed he could reach. More tears fell.

Was this how he felt about you all this time? It would make sense with all the aggression thrown your way recently but why hadn’t he just broke it off if that was the case?

You were sure that it would have hurt less if he had…

Minghaos words kept repeating themselves in your head anytime you managed to calm down a little, only to send you back into a fit of tears.

Outside Minghao sat on the floor, quietly listening to your devastation with his head resting against the hard surface of the door.

He hadn’t meant to say such horrible things to you, especially since they weren’t even true. He had a temper, that much he knew but he had never lost it as much as he had earlier. Not with someone he loved so much that his heart was shattering just listening to you.

While the rest of his members knew how he could be and knew to leave him to cool down, you and him had never fought this much before.

“I’m so sorry love…” he whispered into the by now dark hallway.

The hours ticked by and the apartment fell silent. You had cried yourself to sleep and Minghao didn’t dare leave the door, wanting to stay as close as you let him be.

His ass was hurting by now and he wondered if you had locked the door or only pulled it shut…

He reached for the handle and carefully tried to pull it down, internally cheering when it opened with a silent -click-.

The sight greeting him was just as heartbreaking as your sobs had been. Your face was swollen and dried tear tracks still visible. Wanting to kick himself for being the cause of this, he knelt on the mattress next to your sleeping form.

He wasn’t sure how, but he would make sure that you knew how sorry he was and how much he loved you…

#k-library#k labels#k vanity#the diamond life network#seventeen#xu minghao#xu minghao x reader#xu minghao x you#xu minghao x y/n#minghao x reader#minghao x y/n#minghao x you#seventeen x reader#seventeen x you#seventeen x y/n#xu minghao imagines#seventeen imagines#divider by animatedglittergraphics n more

310 notes

·

View notes

Text

If the primarchs had social media

Lion: There is nothing on his accounts. Not even a profile-picture. Someone is still logging into them every so often. Fulgrim: On all the plattforms. Primarely family-blogger: look at my perfect kids, my perfect spaceship, my perfect partner, my perfect healthy breakfest, my perfect make-up. OnlyFans-account on the side. Get‘s into controversies all the time. Perty: Angry rants. Has spent to much time on Twitter. Old man yells at cloud type of stuff. Jagh: And this is how we‘ll break the speed-limit today! Talks about bikes, how to mod them, drives them around very fast, ect. Occasional horse-pictures. Leman: Puppies! Just cute dog-pictures and -videos, of every canine he encounters in the galaxy Rogal: He isn‘t very good at social media. Sometimes posts bad selfies or pictures of his building projects. Completly ignores all of Pertys hate-comments Konrad: He writes fanfic. Edgy, dark, not very good fanfic. The protag is a clear self-insert and Mary Sue and brings justice to all the settings he puts them in. A ton of spelling errors. The plot barely holds together. He is very proud of it. Sang: He has official accounts with pretty pictures of him everywhere, but he has some private accounts that are just like his art and sometimes cute family pictures. Also why can I see Sang having a Vtuber-persona he livestreams with so people don‘t recognize him? Ferrus: Appears on Fulgrims accounts fairly often. Maybe does some gaming-content on the side Angron: Everything is very sporadic and when it‘s there it‘s pretty angry. Surprisingly talks a lot about issues with his disabilities and that he needs way more help than he get‘s and also all his trauma. Struggles a lot with typing and forming sentences, so it can be hard to understand at times. Roboute: A channel with tutorials for stuff like running a planet or putting on armour. If people ask him to explain something he can just send them a link. Morty: Not very active, sometimes pictures of some funky plants and little texts about them. Magnus: Video-essays. He dissappers for months and then returns with a four-hour-video (minimum) about the most random topic. Hugely popular. Horus: Look at my sexy abs! Look at my huge bicep! Soft-porn-pictures of him and his sons. Probally also had OnlyFans. Lorgar: Social media is great for preaching! So he does that! Deletes all his accounts after monarchia. Vulkan: Food! He loves trying out new recipes from diffrentc cultures! At the start of every recipe is a pagelong story, which people actually read Corvus: Also writes Fanfic. Very, very good fanfic if a bit edgy at times. Kind of has a rivalery with Konrad. Also runs a very active blog, about both writing and justice, with occasional bits about guerilla-warfare Alpharius Omegon: Just the worst trolls. Dozens if not hundreds of sockpuppet accounts. They are having a good time.

#warhammer 40k#primarch#silly headcanons#lion el'jonson#fulgrim#perturabo#jaghatai khan#leman russ#rogal dorn#konrad curze#sanguinius#ferrus manus#angron#roboute guilliman#mortarion#magnus the red#horus lupercal#lorgar aurelian#vulkan#corvus corax#alpharius#omegon

1K notes

·

View notes

Text

...and it started with Airpods! - A S[e]oul Story -1-

Pairing — Kim Hongjoong x Foreigner!Reader

Summary — Visiting Seoul had always been your dream, and now that you were there you planned on using every second on exploring. The subway however might have made a lasting impression...

Genre — fluff

Wordcount — 2.1k

AU/Trope Info — Idol!Au, SliceofLifeAu

Warnings — none

Rating — sfw

Disclaimer: this fic is written and copyrighted by ©hee0soo on tumblr. do not rewrite or repost on any other plattforms without my permission.

ALL RIGHTS RESERVED!

You weren't sure what you had thought when you booked that flight to Seoul. Nothing probably, at least if your mother had anything to say about it.

"What would you even do once you got there, huh? You don't know anyone, nobody is coming with you and you barely speak the language, so what do you want there?" Is what she had asked when you were over at your parents place for dinner. The slightly raised eyebrow of hers at practically every decision in your life, something you had long learned to ignore, glaring right back at you as you had simply shrugged and continued eating your food.

But now, now that you were here, walking through the streets with Myeongdong with several bags of skincare, souvenirs and a roll of kimbap in your hand, you couldn't care less about what your mother had said. You were simply happy to be where you were now, not one regret clouding your mind as it had done several times in moments where you had been alone in your apartment.

The masses of people that you would have despised on a normal day, suddenly didn't seem so bad besides the occasional man or woman randomly standing in the way.

It was fascination how the change of scenery left you so much more relaxed and happier then at home where your life in comparison seemed dull, boring and lonely. Your work being the same every day, the studies you had started not even in the slightest catching your interest anymore.

Of course you knew that this wasn't going to last longer then just a few days, but for now you simply basked in the feeling of being where your heart had pulled you for so long.

Humming along to the music playing through the speaker that was fastened on the outside of the store you were walking past, you looked up into the night sky as you took a bite from the roll still in your hands. It was already late and you could feel the tiredness settling in your bones, the jet leg weighing you down more then you had ever thought possible as you made your way to the subway station.

Compared to the busy street, the station was surprisingly empty. It was a relief to be honest, giving you the chance to take a short breath without being scared to accidently walk into someone and making a fool out of yourself just as the familiar tune of an incoming train arriving at the station. With hurting feet you dropped on to the nearest empty seat with no intention of getting up before you had to.

You popped your earphones in, the first tunes of your favorite songs filling your ears and making you relax into your seat. Eyes fluttering close as you took a breather alongside the calm rapping of Mingi's Fix off Project. The emotions of the song flooding your tired mind and you didn't even take notice of another passenger sitting himself down next to you.

He busied himself on his own phone, eyes flickering to the side in a hesitant manner. Carefull to stay in his own seat. A mask was covering his face, only showing his dark brown eyes and messy black and white hair.

The subway stopped abruptly at the next station, causing you to lose your balance for just a moment and knocking you into the man next to you. Startled he looked up, spooked eyes staring into yours and you had to stop yourself from reacting.

Dark eyes met y/e/c ones.

“I’m so sorry!” you apologized profusely with a well meant bow to the man who’s face you recogniced even with half of it covered by the mask he was wearing as said mans voice was ringing through your earphones now.

The idol waved you of with gentle bow of his head, eyes sparkling in the light of the subway.

“It’s okay, don’t worry.”

The moment was over as fast as it had come but it was enough to leave your heart racing in excitement. It felt like it was going just as fast as the subway speedibg of to it’s next destination just to come to another stop when the Announcement said that you arrived at Hongik University.

Hongjoong quickly got up with another last glance and bow before exiting the train with fast steps. Knowing that you were close to the KQ building you guessed that he was going to the studio to get some work done.

Only after the doors had closed again did you notice the little airpod case being left behind on the seat Hongjoong had been sitting on. They had to be his, as you were sure that they weren’t there when you had sat down before him. So they had to be his!

Hesitant you reached for the case. What were you supposed to do now?

You couldn’t leave them there. Your consciousness not allowing that, but you also couldn’t keep them.

You rolled it in your palm, noticing the little 8 drawn on it with sharpie surrounded by music notes and it made you smile in amusement. Yeah, they definitly belonged to him.

Releasing a tired sigh, you put the airpods in your pocket just as the announcement of your exit station rang through the speakers of the train.

Walking through the night gave you a sense of calm that you needed to sooth your frazzled mind, the encounter with one of your favorite Idols having left you reeling. And it was only when your head hit the pillow, freshly showered and ready to sleep that you felt your mind calm again.

You looked over to the side where the Airpod case was sitting on a small desk the hotel room provided, right next to your bag you always took with you while exploring Seoul.

They were almost mocking you in a sense, asking you what you were going to do with them now that they were in your posession. It was funny how you let yourself be made fun of by an inanimate object like this while sleep fought to win you over. Your eyes finally closing for the night.

Rushing through the busy subway station of Hongik University you passed through many people. Trying ang sometimes failing to not run into anyone else on your way through Hongdae.

The airpod case seemingly burning a hole into the pocket of your jeans and causeing sweat to collect on the inside of your hands. Sweat that you tried to wipe of every minute or two.

You didn’t know if this was a smart move. You didn’t even know if you would get far enough to execute your plan that you had thought about over breakfast this morning while drinking a cup of orange juice.

After all, you didn’t think KQs staff would willingly let a random person inside their building just because she knocked at their door.

You didn’t think it was a particularly good plan but you couldn’t think of any other way of getting the airpods back to their rightful owner so it was either this, keeping them or gwtting rid of them. Neither of the last two options were something you could agree on so this was it.

Arriving was the easy part, but actually walking up the stair and ringing the door bell, that was a whole different struggle. The people walking past must see you as an idiot as you stood there for some time, looking left and right, hesitating to actually walk up to the building while looking like you would keel over any second until you finally maaged to hype yourself up enough to actually do it.

You felt hot all over. Face burning as you walked through the hallways of the new building KQ used now.

“You’re fine. You can do this.” You exhaled with your finger hovering over the door bell infront of the milky glass door with the giant grey KQ logo on it and with a wave of bravery you pressed down.

For a moment nothing happened until the slender figure of someone appeared behind the milky surface and the door slid to the side.

The woman seemed confused and you couldn’t fault her for it.

“Hello, can I help you with anything? Do you have an appointment?” she spoke with an accent but otherwise clear english.

“Uhm – yeah, hi. No, no ughh appointment I just wanted to give you this?” you said, making it almost sound like a question when you pulled out the Airpods from your pocket and held it out for her to take. Her face furrowed more in confusion, but her eyes brightened in recognition.

“I, met one of your idols yesterday in the subway and uhm- he- he dropped them in the subway while leaving… I didn’t steal them or anything, I promise!” you rushed out to give more context on why you had them in the first place.

“Can you step in for a moment? Follow me to our desk and I will try to get someone who can variefy what you are saying.”

You closed your hand around the case when she didn’t take it, only offering you to come in and follow her. Your heart dropped at the mention of stepping foot inside the company. Nodding you hesitantly came in.

The glass dor slid shut behind you.

“Please wait here by the desk, it will be just a moment.” She said politely, yet didn’t wait for an answer before rushing the other way, leaving you standing there while the woman behind the desk was staring at you with a perfectly plucked eyebrow raised.

“Hi…” you said quietly with a head bow.

She didn’t answer, just looking down again at the papers in front of her.

*Great* you thought at her blatantly ignoring you. Gripping tightly onto the airpods to ground yourself.

Unintelligable whispers reached your ear as the first woman came back with someone.

The two-toned hair was messy on his head just like the night before but he seemed for more rested now than then.

His eyes widened just like yours did at the confrontation you didn’t expect.

“I’m sorry for letting you wait, I just need Hongjoong-ah to confirm if these really are his. Could you ahow them again, please?”

You did. You almost threw the airpods at him, the little 8 and music note visible on the front.

Hongjoong studied them for the moment. His eyes widened at seeing his airpods in your hand and you gave you an almost blinding smile.

“Yes, they mine! You found them?”

You chocked at a nervous, “Yeah! You dropped them in the subway yesterday!”

“Thank you, so much! You were next to me? That was you?”

“That was me, yes.”

Hongjoong reached over the desk, the woman on the other side not sparring either of you a glance as the rapper reached for a pen and paper to scribble something on it.

He handed you the paper when he was finished.

“As a thank you for, Atiny?” he winked with a teasing smile.

Surprised that he knew you froze. “Thank you - ?”

“y/n!”

“y/n…”

Just as you wanted to answer, the woman who had let you inside, cut you off.

“Thank you for bringing those back, now, can I escort you out.” Even phrased as a question you knew that it wasn’t mesnt to be one. She wanted you out, not wanting to risk getting herself or Hongjoong in trouble for letting a stranger inside.

Bowing to the idol as a goodbye, you followed her out. The piece of paper he had given you still in your hands.

You only dared looking at it once you stood back outside, thinking that it might have been his autograph as a thank you, however your heart stopped when you saw the series of numbers written on it.

~Text me? :D~

#illusionnet#cromernet#cultofdionysusnet#wonderlandnet#k labels#kvanity#ateez#kim hongjoong x reader#kim hongjoong x you#kim hongjoong x y/n#kim hongjoong imagine#hongjoong x reader#hongjoong x you#hongjoong x y/n#ateez x reader#ateez x y/n#ateez x you#ateez imagines#divider by saradika

140 notes

·

View notes

Text

Ajay Hinduja und die Schaffung einer universellen Plattform für Gehirngesundheit

Die Technologie von MindMaze ist weit mehr als nur ein therapeutisches Werkzeug – sie bildet die Grundlage für eine universelle Plattform zur Förderung der Gehirngesundheit. Mithilfe von Bewegungsanalytik, künstlicher Intelligenz und Cloud-Technologien schafft das Unternehmen ein integriertes System, das eine präzise, objektive und skalierbare Gesundheitsversorgung ermöglicht.

Dank dieser innovativen Lösungen verzeichnen mittlerweile zahlreiche Krankenhäuser weltweit spürbare Fortschritte bei der Behandlung von Patienten mit neurologischen Erkrankungen – von Demenz bis hin zu traumatischen Hirnverletzungen. Die Technologie von MindMaze beschleunigt nicht nur die Genesung, sondern verhilft vielen Betroffenen zu mehr Selbstständigkeit, Selbstvertrauen und einer deutlich verbesserten Lebensqualität.

Ajay Hinduja erkannte früh, dass der Nutzen von MindMaze über den medizinischen Bereich hinausgehen kann. Mit MindMaze Labs – der Forschungs- und Entwicklungsabteilung des Unternehmens – verfolgt er das Ziel, neurowissenschaftliche Erkenntnisse in alltagsnahe Anwendungen zu überführen. Ob in Bildung, Unterhaltung oder am Arbeitsplatz: Durch die Entwicklung fortschrittlicher Mensch-Maschine-Schnittstellen entstehen neue Möglichkeiten, wie Menschen Technologie intuitiv und effektiv nutzen können.

„Wir stellen uns eine Welt vor, in der moderne Neurowissenschaft eine gesündere, anpassungsfähigere Menschheit fördert“, erklärt Ajay Hinduja. Diese Vision treibt die Weiterentwicklung des Unternehmens konsequent voran.

Heute wird die Technologie von MindMaze in über 130 renommierten medizinischen Einrichtungen weltweit eingesetzt – darunter auch in Indien, z. B. im AIIMS in Neu-Delhi und im Hinduja Hospital in Mumbai. Ajay Hinduja führt MindMaze mit klarer Mission: Durch die Verbindung von Neurowissenschaft und innovativer Technologie soll das volle menschliche Potenzial erschlossen und die Zukunft der Gehirngesundheit neu definiert werden.

Ajay Hinduja erkannte früh das Potenzial dieser Technologie jenseits des klinischen Kontexts. Mit MindMaze Labs – der Forschungs- und Entwicklungsabteilung – werden neurowissenschaftliche Erkenntnisse in praktische Anwendungen für den Alltag übertragen. Ziel ist es, Mensch-Maschine-Schnittstellen zu entwickeln, die Interaktionen mit fortschrittlicher Technologie ermöglichen und so Innovationen in Bereichen wie Bildung, Unterhaltung und Produktivität vorantreiben.

Diese Vision spiegelt Ajay Hindujas Überzeugung wider: „Wir stellen uns eine Welt vor, in der moderne Neurowissenschaft eine gesündere, anpassungsfähigere Menschheit fördert.“ Damit wird der Anspruch deutlich, die Neurowissenschaft fest in den Alltag zu integrieren und lebensverbessernde Technologien für alle zugänglich zu machen.

Während MindMaze weiter wächst und seine Reichweite ausbaut, bleibt Ajay Hinduja seinem Innovationsanspruch treu. In über 130 weltweit führenden medizinischen Einrichtungen wird die Technologie bereits eingesetzt – darunter auch in Indien, etwa am AIIMS in Neu-Delhi oder am Hinduja Hospital in Mumbai. Ajay Hinduja leitet das Unternehmen mit der klaren Mission, Technologie nicht nur weiterzuentwickeln, sondern auch die Herangehensweise an Gehirngesundheit grundlegend zu verändern. MindMaze erschließt das Potenzial der Neurowissenschaft und ebnet den Weg für eine Zukunft, in der Technologie und Menschlichkeit Hand in Hand gehen.

0 notes

Text

Wie der Goodwe ET-Wechselrichter herkömmliche Solar-Wechselrichter übertrifft

In der Welt der Solarenergie gibt es ständig neue Technologien, die darauf abzielen, die Effizienz und Leistungsfähigkeit von Photovoltaikanlagen zu steigern. Einer der führenden Anbieter von Wechselrichtern, die eine solch beeindruckende Leistung bieten, ist GoodWe. Besonders hervorzuheben ist die GoodWe Wechselrichter Serie ET, die nicht nur eine herausragende Leistung liefert, sondern auch eine Reihe von Vorteilen gegenüber herkömmlichen Solar-Wechselrichtern bietet. In diesem Artikel erfahren Sie, wie der GoodWe ET-Wechselrichter herkömmliche Modelle übertrifft und warum er eine ausgezeichnete Wahl für Ihre Solaranlage ist.

Was ist ein Wechselrichter und warum ist er wichtig?

Ein Wechselrichter ist ein wesentlicher Bestandteil jeder Photovoltaikanlage. Er wandelt den erzeugten Gleichstrom (DC) aus den Solarmodulen in Wechselstrom (AC) um, der in Haushalten oder Unternehmen verwendet werden kann. Ein hochwertiger Wechselrichter ist entscheidend für die Effizienz der gesamten Solaranlage, da er den Strom optimal umwandeln und Verluste minimieren muss.

Die GoodWe Wechselrichter Serie ET wurde speziell entwickelt, um die Effizienz von Solaranlagen zu maximieren und sowohl Privat- als auch Gewerbekunden eine zuverlässige, langlebige und hochleistungsfähige Lösung zu bieten.

Vorteile der GoodWe Wechselrichter Serie ET

1. Höhere Effizienz

Die GoodWe ET-Serie bietet eine herausragende Effizienzrate, die über 98% erreichen kann. Im Vergleich zu herkömmlichen Solar-Wechselrichtern, die oft nur 95% oder weniger erreichen, sorgt dieser hohe Wirkungsgrad für eine optimierte Nutzung des erzeugten Solarstroms. Der GoodWe ET-Wechselrichter minimiert den Energieverlust bei der Umwandlung von Gleichstrom in Wechselstrom, was zu einer höheren Gesamtleistung der Photovoltaikanlage führt.

2. Bessere Temperaturstabilität

Einer der größten Vorteile der GoodWe Wechselrichter Serie ET ist ihre hervorragende Temperaturstabilität. Herkömmliche Wechselrichter können bei extremen Temperaturen weniger effizient arbeiten oder sogar ausfallen. Der GoodWe ET-Wechselrichter wurde jedoch so entwickelt, dass er auch bei hohen Außentemperaturen eine stabile Leistung liefert. Dies ist besonders wichtig in Regionen, die regelmäßig hohen Temperaturen ausgesetzt sind, da er die Leistung auch unter schwierigen klimatischen Bedingungen aufrechterhält.

3. Längere Lebensdauer

Die GoodWe ET-Serie ist für ihre Langlebigkeit bekannt. Die Wechselrichter dieser Serie verfügen über robuste, langlebige Komponenten, die eine lange Lebensdauer von bis zu 15 Jahren gewährleisten. Während herkömmliche Modelle oft nach 5 bis 10 Jahren ihre Effizienz verlieren oder reparaturbedürftig werden, sorgt der GoodWe ET-Wechselrichter dafür, dass Ihre Solaranlage über Jahre hinweg zuverlässig funktioniert. Dies macht ihn zu einer lohnenswerten Investition.

4. Flexibilität bei der Installation

Die GoodWe Wechselrichter Serie ET bietet eine hohe Flexibilität bei der Installation und kann sowohl für kleinere als auch größere Photovoltaikanlagen verwendet werden. Die Wechselrichter sind mit verschiedenen Solarmodulen kompatibel und können für unterschiedliche Konfigurationen in verschiedenen Anwendungen genutzt werden. Diese Vielseitigkeit stellt sicher, dass der GoodWe ET-Wechselrichter in nahezu jeder Situation effizient arbeitet.

5. Smartes Monitoring

Mit den GoodWe ET-Wechselrichtern erhalten Sie ein smartes Überwachungssystem, das es Ihnen ermöglicht, Ihre Solaranlage in Echtzeit zu überwachen. Über die GoodWe ET-Wechselrichter-App oder die Cloud-Plattform können Sie jederzeit den Leistungsstatus Ihrer Anlage überprüfen. Diese Funktion hilft Ihnen, eventuelle Störungen schnell zu identifizieren und zu beheben, wodurch die Betriebszeit Ihrer Anlage maximiert wird.

6. Höhere Sicherheit

Die GoodWe Wechselrichter Serie ET bietet fortschrittliche Sicherheitsfunktionen, die den Wechselrichter und die angeschlossenen Komponenten vor Überhitzung, Kurzschlüssen und anderen elektrischen Problemen schützen. Sicherheitsmerkmale wie die präzise Überwachung von Spannungswerten und Temperaturregelungen sorgen dafür, dass Ihre Solaranlage jederzeit sicher und effizient arbeitet.

Warum ist der GoodWe ET-Wechselrichter besser als herkömmliche Modelle?

Im Vergleich zu herkömmlichen Solar-Wechselrichtern bietet der GoodWe ET-Wechselrichter eine deutlich höhere Effizienz, eine stabilere Leistung bei extremen Temperaturen, eine längere Lebensdauer und mehr Flexibilität. Diese Merkmale machen ihn zu einer optimalen Wahl für jeden, der die maximale Leistung aus seiner Photovoltaikanlage herausholen möchte. Darüber hinaus sorgt die Integration von modernen Sicherheits- und Überwachungsfunktionen für zusätzliche Vorteile, die bei traditionellen Wechselrichtern oft fehlen.

Evionyx-Solar: Ihr Partner für den GoodWe ET-Wechselrichter

Evionyx-Solar ist ein vertrauenswürdiger Anbieter von Photovoltaikanlagen und Wechselrichtern und bietet Ihnen die Möglichkeit, die GoodWe Wechselrichter Serie ET in Ihre Solaranlage zu integrieren. Mit umfassender Erfahrung und Expertise im Bereich Solarenergie sorgt Evionyx-Solar dafür, dass Sie die besten Produkte und Lösungen für Ihre spezifischen Anforderungen erhalten.

Evionyx-Solar bietet nicht nur die Installation und Integration von GoodWe ET-Wechselrichtern, sondern auch umfassenden Service und Support, um sicherzustellen, dass Ihre Solaranlage stets effizient und zuverlässig arbeitet. Das Team von Evionyx-Solar steht Ihnen mit kompetenter Beratung und Unterstützung zur Seite, um Ihre Solaranlage optimal zu konfigurieren.

Fazit

Der GoodWe ET-Wechselrichter bietet eine Vielzahl von Vorteilen gegenüber herkömmlichen Solar-Wechselrichtern, darunter höhere Effizienz, bessere Temperaturstabilität, längere Lebensdauer und mehr Flexibilität. Wenn Sie eine moderne, leistungsstarke und zuverlässige Lösung für Ihre Photovoltaikanlage suchen, ist der GoodWe ET-Wechselrichter die richtige Wahl.

Evionyx-Solar ist Ihr idealer Partner, um den GoodWe ET-Wechselrichter in Ihre Solaranlage zu integrieren und so die Leistung Ihrer Photovoltaikanlage zu maximieren. Besuchen Sie die Website von Evionyx-Solar unter www.evionyx-solar.de und lassen Sie sich von Experten beraten, wie Sie Ihre Solarenergie noch effizienter nutzen können.

Für weitere Einzelheiten können Sie uns besuchen:

Goodwe Lynx Home F Plus

Goodwe Lynx Home Speicher

GoodWe Speicher Leipzig

GoodWe Speicher Dresden

0 notes

Text

Amazon hat laut einem Medienbericht sein Interesse am Kauf von Tiktok angemeldet. Der weltgrößte Online-Händler habe das Angebot in einem Brief an Vizepräsident J.D. Vance und Handelsminister Howard Lutnick unterbreitet, schrieb die „New York Times“ unter Berufung auf informierte Personen. Verschiedene an den Verhandlungen beteiligte Akteure nähmen die Amazon-Offerte jedoch nicht ernst, hieß es einschränkend.

Tiktok hätte nach einem US-Gesetz eigentlich bis zum 19. Januar von dem in China ansässigen Eigentümer Bytedance verkauft werden müssen oder in den USA vom Netz gehen. Doch Präsident Donald Trump räumte eine Gnadenfrist von 75 Tagen ein, die am 5. April abläuft. Er stellte aber auch mehrmals eine Fristverlängerung bei Bedarf in Aussicht, obwohl es dafür in dem Gesetz keine Grundlage gibt.

Von Bytedance und Tiktok hieß es bisher, es sei unmöglich, nur den US-Teil der Kurzvideo-App zu verkaufen, weil dies die Plattform zerschlagen würde. Trump sagte, es gebe „verschiedene Wege, Tiktok zu kaufen“ und man werde den finden, der für die USA am besten sei. Amazon-Gründer Jeff Bezos hatte in den vergangenen Monaten einen freundlicheren Kurs gegenüber Trump eingeschlagen. Amazon hätte mit der Cloud-Tochter AWS auf jeden Fall die nötige Infrastruktur, um eine Plattform in der Dimension von Tiktok zu betreiben. Der Konzern ist auch groß im Geschäft mit Videostreaming. Als weiterer Interessent für Tiktok gilt der Software-Konzern Oracle, den Bytedance bereits mit der Absicherung der Daten von US-Nutzern beauftragt hatte.

0 notes

Text

11. Was ist Amazon IoT und was kann es für Cloud Computing leisten?: "Amazon IoT: Erfahren Sie, wie Cloud Computing mit Amazon IoT verbessert werden kann"

#AmazonIoT #CloudComputing #Verbinden #Sicherheit #Kommunikation #Datenerfassung #KIBasiert #Dateiverwaltung #Automatisierung #Entscheidungsfindung

Cloud Computing ist ein Konzept, das es ermöglicht, auf entfernte IT-Ressourcen zuzugreifen. Dieser Zugriff kann über das Internet erfolgen. Mit Cloud Computing können Unternehmen auf eine Vielzahl von IT-Diensten zugreifen, die von einem Cloud-Anbieter bereitgestellt werden. Dies ermöglicht es den Unternehmen, Kosten zu senken, indem sie nur für die tatsächlich verwendeten Ressourcen und Dienste…

View On WordPress

#Amazon IoT ist eine Plattform#automatisierte Entscheidungsfindung und mehr. Mit Amazon IoT können Unternehmen ihre Produkte effizienter verwalten und Entwickler können sc#Automatisierung#Cloud Computing#darunter sichere Kommunikation über das Internet#Dateiverwaltung#Datenerfassung#die es Unternehmen und Entwicklern ermöglicht#Echtzeit-Datenerfassung#Entscheidungsfindung#Geräte#KI-basiert#KI-basierte Analysen#Kommunikation#Sensoren und Anwendungen mit ihren Cloud-Anwendungen zu verbinden. Es bietet eine Reihe von Funktionen#Sicherheit#Verbinden

0 notes

Text

Just One Chance

This is part of the Lonely Hearts Cafe Collab by @camandemstudios

Pairing — Boo SeungkwanxReader

Summary — while for some valentines day was a day spend filled with love, compassion and roses, for you it was a total disaster. Alone and dissapointed you return home after what was suppossed to be the saving grace for your relationship where you were met with your best friend and roommate Boo Seungkwan. Maybe your night wouldn't end with total catastrophe...

Genre — fluff, maybe a lil hurt/comfort if you will

AU/Trope Info — Non!IdolAU

Wordcount — 3.1k

Warnings — ex-boyfriends being idiots, Kwannie being a jealous and rambling cutie

Rating — PG-13

Disclaimer: this fic is written and copyrighted by ©soo0hee on tumblr. do not rewrite or repost on any other plattforms without my permission.

ALL RIGHTS RESERVED!

“And you are sure you want to give him another chance?” Seungkwan asked with his eyebrow raised almost into his hairline and his arms crossed in front of his chest. He was leaning against the wooden frame of your door, eyes not straying away for even a second and more than a little displeased about the fact that you had yet again, chosen to give that asshat you called your boyfriend a chance to make up for all the dates he had missed over the last few months.

Yes, months. How you were still able to simply look past all this dicks faults when he had already told you he would change for the, what felt like millionth time, and every single time it left you more disappointed than the last time. And every single time it was Seungkwan, who had picked up the pieces after he was met with teary eyes, hunched over shoulder and the expression of a kicked puppy that had his heart skip a beat upon you entering your shared apartment after another failed night with Nick.

Oh, how Seungkwan learned to hate that name. Just the mention of it made him feel livid enough to want to punch a hole into his rooms wall and yet he would wait for you to come home time and time again with your favorite fuzzy blanket, your favorite cup; a bag of your favorite tea already waiting to be poured over with boiling water, a tub of ice cream equipped with two gigantic spoons and open arms for you to fall into when you needed him to just listen to your angry huffs that, in his humble opinion made you look more like an angry teddy bear then a real threat to society.

Not once had he send you away when you were faced with yet another disappointing night in which your boyfriend had either failed to give you more attention than his phone, flirted with anything that wasn´t sitting in a tree at the count of three while you were sitting right beside him and not bother showing up at all. And even when he hated how the result always seemed to be the same, Seungkwan would rather burn in hell then stop being the person you came to after your failed nights with Nick.

Even if it ripped his heart to shreds to witness you running back to a man that was so clearly not interested in what you had to offer. A man that didn´t see the love, the care, the kindness and so many more things you were willing to give in a relationship. A man, who was evidently not him.

Even then he would wait for you.

“Just this last time Boo. It´s Valentine ’s Day after all and I want to see if at least tonight, Nick can follow through with his promises. If he does, then fine I’m willing to give him another chance but if not, he can finally go to hell.” You sighed and applied one last layer of lip-gloss before smacking your lips together with a pop.

Seungkwan pursed his lips, already having a feeling that this night was not going to be different to all the other times.

“How do I look?” Turning around to face your friend and roommate you tilted your head to the side with a questioning look on your face.

Many words were burning on the tip of his tongue to be said.

Beautiful, ravishing, gorgeous, stunning, angelic and so many more clouded his mind and yet he only settled for a simple, “Good.”

You rolled your eyes at his blunt answer but you also knew that Seungkwan meant it when he said so. He was no liar, at least he had never lied to you about anything and you trusted your judgment and gut maybe a little more then you should. After all, your gut had also once told you what a great guy Nick was.

Seungkwan watched you get up and grab your purse from your desk.

“Do you know when you´ll be home again?”

His question was met with a shrug. “Depends on how the night will go really. I could be back in an hour, late at night or tomorrow morning. Honestly at this point can´t say I expect much.”

‘Then don´t go!’ was what he wanted to say but stayed silent. It was no use. He knew how stubborn you could be and that if you put your mind to something the chance of him getting you to change your mind was slim to nonexistent. And so he sends you out the door with a wave.

His own plans were rather simple. Without a date and no real desire to leave the coziness of your shared home, Seungkwan preferred the quietness of a night in. His companion for the night? Left over Jajangmyeon that was still in the fridge, Netflix and maybe, if he was lucky enough he would find the Soju you had hidden somewhere in the apartment.

The plans were quite sad if you remembered that today was Valentine’s Day but that was nothing that really bothered him. Sure, his friends had teased him mercilessly for not asking out the girl that served him his coffee every morning before he went to work with an extra sweet bat of her eyes but Seungkwan could not remember a day on which he had even once indulged her flirtations. So yes, his plans were boring and Seungkwan was absolutely fine with that.

One movie turned into two and just when he thought his night would be spent alone, he could hear the beeping sound of the entrance code be punched into the lock system before the door opened and you entered the apartment on soft soles. How you managed to do that in the heels you were wearing Seungkwan had no clue.

The man turned his head to catch your eyes and the slightly amused smile was immediately whipped from his face; the “I told you so.” That had been waiting to be said suddenly stuck in his throat.

Fresh tear tracks were glistening on the apple of your cheeks, make up smudged and your eyes still watery like you had stopped crying just a few moments ago.

You dropped your purse carelessly on the floor, kicked the heels away and trudged over to where your roommate was waiting with his arm held out so you could take his hand; pulling you down and into his side where you buried your face into the soft material of his shirt.

Seungkwan didn´t mind the mascara which would no doubt stain the fabric. He´d just wash the shirt the next day when he did his laundry either way.

“Don´t you want to tell me that you told me so and that I’m dumb for thinking tonight could be any different?” your words were muffled by the fabric but could be heard well enough and while the words had undoubtedly something he was going to say, he also felt quite bad that he even had the chance to say them. He had hoped that for once you didn´t come home downtrodden and that for once Nick had gotten his shit together.

“No, I’m just sorry that it happened again. What was it this time? You were out for quite some time?” Seungkwan comforted gently, fingers tracing over the back of your neck where your hair exposed the skin.

“It was fine. Nick was punctual, nice and paid attention and I thought, wow! He really surprised me there. And then when we were about the order dessert suddenly this girl stood at our table. Causing a scene and yelling about what an ass he was and if I’m the bitch he replaced her with as if, and I quote, “He hadn´t spend the last 6 months fucking her every weekend!” Kwan he didn´t cheat on me. I was the he cheated with! It was so humiliating.”

Two things were on his mind hearing this. One, the urge to drive over to Nicks place and punch the lights out of him. And two, tell him what an utter fool he was for treating you like a toy that could be put on the shelf until he wanted to play again.

“I feel so dumb. How did I not see this? How did I honestly thing he was worth giving him so many chance when all Nick did was treat me like dirt?” you twisted your head a bit to glance up at Seungkwan`s face through your lashes.

Pushing back the urge to bend down and press his mouth to the slight pout of your lips, Seungkwan shook his head.

“Don´t say that, you´re not dumb! You were just… in love…” he choked out his last words like they were poison in his mouth.

Somehow his words shook something inside you.

Were you really in love with Nick? Was that really what it was? Or was it you holding onto someone because you didn´t want to be alone anymore?

“Maybe…” you sighed just to turn your head back into your roommate, arms thrown around his mid section.

The TV filled the silence between you with mindless banter which went in over your head.

“You know what? We won´t let tonight end like this! Go to your room, wipe those tears away and wear something comfortable.” He nudged you a bit, words met with a grumble on your side.

“What why?” you questioned and refused to move.

Seungkwan nudged you again, this time harder and you let go to sit up and stare at him as he freed himself from the blanket thrown over his legs and lap to get up. Your arms fell a bit, hands reaching for your own to pull you up from the couch.

“You´ll see. Meet you here in 10.”

Confused but following his instruction you stumbled to your room. You got rid of the slightly too tight dress and opted for sweat pants and a hoodie you had stolen from Seungkwan some time ago. Well, stolen might not be the right word for this. Seungkwan knew very well where it was, he had seen you wearing it often enough and even put it on your bed again after having done his washing multiple times. Ignoring that half of your closet at this point consisted of his clothes.

“Are you ready?” Seungkwan called from the hallway and stuck his head through the door.

You nodded and slipped into your sneakers; Seungkwan handing you your jacket he had picked up from the living room floor.

“Then come on.”

The cold of a February night hit you in the face and you hooked your arm into the man`s by your side.

“Are you going to tell me where we are going?” you asked, still not sure what he was up to.

“Just walk with me. You´ll see.” He hummed and pulled you along with him. You realized that Seungkwan was not planning on telling you where you were going and so you decided to simply enjoy his company.

The night was cold and you were glad you had your jacket on because you were sure you wouldn´t have survived this walk if not.

You took in the neighborhood, walking past stores and restaurants you usually hurried past without paying them much mind when you either went to work or returned from it and only wanted to bury yourself in your bed. They looked cozy, like something you would love to check out sometime soon. Maybe Seungkwan could join you for that and only as you walked further did you realize where you went.

The sight of the water of the Han River rippling as wind brushed over it, on some place close to the shore even frozen from the drop in temperature opened itself and the lights of the city reflecting beautifully on the surface as you made your way to the park close to where you were.

Visiting this place was definitely something you should do more often. The sight was amazing and in midst of the buzzing city, it was a welcoming place of quietness that had something magically to offer. The light of the street posts lighting up the way, bathing it in a soft glow and giving Seungkwan a little halo over his dark brown hair with his muffs on his ears.

You watched his side profile as you walked together, and something inside your stomach stirred.

It wasn´t that you didn´t know Seungkwan was handsome, no you weren´t blind after all, you could see why he was constantly fawned over by your girlfriends or why when he was out men and women were turning their heads to look after him when passing by them. But never had it made you feel like you were a fool for not realizing just how beautiful he was when you looked closer like you did now.

His soft, slightly ruffled hair fell in gentle waves, strands framing his face like the frame of a portray, enhanced its impact. The puffy coat he was wearing almost swallowed him, making him appear much smaller then he actually was and like a giant teddy bear you wanted to hug as much as he would let you.

“You should just take a picture if you plan staring at me all night. It holds longer and you can take it anywhere you go, that way I’d always be with you.” He teased and winked at you.

You felt heat flush your cheeks at being caught in your staring.

“Sorry!” you squealed higher then you had intended and looked to the ground in shame. Seungkwan chuckled in amusement.

“It´s fine. I know I look amazing.”

You scoffed in mock offence and punched his shoulder with the hand not hooked around his arm. He dramatically pulled a face.

“You´re so mean! Punching me when all I’m trying to do is being a good friend!”

“You´re a little shit, is what you are!”

Seungkwan grabbed his heart, acting like he had just been shot in the chest. His theatrics made you laugh freely. It was the first time since you had left the restaurant a few hours ago in which you felt like you were where you were supposed to be.

“This? That smile you have right now? This suits you so much better than the tears from earlier.”

You let out a soft sigh, smile still painted onto your face. Seungkwan lifted his arm, brushing a lose lash away from your cheek as it clung to it. The warmth of his skin seeping into your bones, even if only for one tiny moment. Your heart sunk at the missing feeling just the smallest bit.

“I´m glad, I-” you began yet stopped when your eyes caught his. The lumps in your throat making it almost impossible to speak without sounding like you were going to cry again. Not because of Nick, no. All you were able to think about was Seungkwan.

Seungkwan who made you laugh every moment spend together. Seungkwan who cared more for his friends then for himself oftentimes. Seungkwan who had a soft spot for his baby bookkeu. Seungkwan who breathed smiles and energy and Seungkwan who managed to make your knees weak with the simplest of actions.

Waiting for you to continue Seungkwan looked at you with his hand tilted to the side.

“Thank you, for being here. For having my back…”

His eyes softened at this.

“You never need to thank me for that, y/n. You can always trust me to have your back when you need me. I´ll be there.”

His breath fanned over your cold skin, eyes flickering down to your mouth as nibbled on your lower lip.

“Boo I-“you whispered into the night when you felt his lips on your own. Gently moving against them like he was afraid you´d run away any second before pulling away. The touch was only fleeting. Barely a few seconds and yet you weren´t able to shake it from your mind!

Abrupt Seungkwan pulled back, taking two steps back and away from you. His wide panicked eyes looking anywhere but you and your heart dropped at his violent reaction.

“I´m sorry, I´m so sorry! I shouldn’t have- this shouldn´t have happened and I wasn´t supposed to-“

Quickly you reached out to hold his flailing hands still in yours.

“Seungkwan stop!” you called out hoping to break through his panic but it was unsuccessful. Avoiding looking at you and trying to get his hands out of your soft grip, he tucked them back with little to no force.

“Stop!” you yelled once more and the man froze.

“Stop.”

“But you-“

“I´m not mad.”

“Why not? You should be. I shouldn´t have kissed you, it was a mistake! A mistake that shouldn´t have happened because I CAN`T lose you!” he rambled more to himself than he was talking to you.

Giving him your best –Don´t bullshit me- face you stared at him. “Who, in the ever loving fuck told you that you could ever lose me?”

Seungkwan shook his head, devastation written all over his face.

“You don´t know that. Because if you knew you would run.”

“Try me.”

Staring at you like you had grown a second head Seungkwan stood there not knowing what to do with himself.

“Try me and see what will happen Boo. I bet you´d be surprised.”

He sighed loudly and looked to the ground. Not brave enough to see how your face would inevitably change to one of disgust and rejection.

“I love you y/n. I´ve done so for ages and those last few months have slowly been killing me inside! I- i hate Nick for treating you like you weren´t something to be cherished every second of the day and I hate that you went back to him so many times even if you knew, you knew that he wouldn´t change. Nick was an asshole who is blind to how amazing you truly are. Who never knew how to treat you…”

It was amazing to witness the usually smooth talking Seungkwan fumbling for words. Stuttering like he didn´t know what to say and a scared in a way you rarely ever got see.

“…and if you could give me just one chance to proof that I can treat like you deserve, I would…”

Rushing to cut him off you roughly took a hold of his face to press another short yet sweet kiss to his lips before raising an eyebrow with a teasing smile dancing on your lips.

“One chance.”

#lonelyheartscafecollab#svthub#keopihausnet#k-vanity#k-labels#the diamond life network#seventeen#seungkwan#seventeen x reader#seventeen x y/n#seventeen x you#seventeen imagines#boo seungkwan#boo seungkwan x reader#boo seungkwan x y/n#boo seungkwan x you#boo seungkwan imagines#seungkwan x reader#seungkwan x you#seungkwan x y/n#seungkwan imagines#divider by cafekitsune

137 notes

·

View notes

Text

Microsoft Sharepoint

Microsoft SharePoint ist eine webbasierte Plattform, die die Gruppenarbeit innerhalb von Seiten Manufaktur revolutioniert. platzieren diese sich SharePoint gleich verknüpfen virtuellen Aktenordner vor, dieser groß mehr kann qua zwar Dokumente zu speichern. Es ist ein zentraler Drehkreuz, in Deutsche Mark Teams Unterlagen novellieren, Projekte vorstellen, gemeinsam an Dokumenten umackern mehr noch den Vorgang jemandem nachsetzen erwirtschaften – was auch immer an einem Punkt noch dazu stetig von Seiten jedem Lanzeät Basta durchlässig.

Sharepoint ist eine webbasierte Verwendung, die es Ihnen ermöglicht, Websites, Dokumente, verzeichnen, Kalender, Aufgaben, Umfragen, Foren, Blogs, Wikis noch dazu vieles mehr zu investieren obendrein zu verwalten. diese einbringen Sharepoint ebenso wie innerbetrieblich denn gleichermaßen außerhalb Sinn, um unter Zuhilfenahme von Ihren Kollegen, Partnern, Kunden überdies Lieferanten zu kommunizieren überdies zusammenzuarbeiten. Sharepoint ist in einige Editionen unterteilt, die ausgewählte Funktionen überdies Preise innehaben. Die wichtigsten Editionen sind:

Sharepoint verbunden: das ist die Cloud-basierte Erteilung vonseiten Sharepoint, die als Dingsbums seitens Microsoft 365 angeboten wird. diese können Sharepoint online bestellen überdies seitens jedem Wurfspießät darüber hinaus jedem Lage Aus darauf zugreifen. selbige zu tun sein einander keine sorgen um die Zusammenbau, Pflege oder Geborgenheit welcher Software handhaben, da Microsoft dies im Zusammenhang ebendiese übernimmt. Sharepoint Server: dasjenige ist die On-Premise-Fassung von Seiten Sharepoint, die diese hinauf Ihren eigenen Servern einsetzen noch dazu verwalten zu tun sein. solche veranschaulichen etliche Prüfung über die Anpassung, Angleichung noch dazu Einbeziehung von Seiten Sharepoint unter Einsatz von anderen Systemen. sie zu tun sein dagegen nicht zuletzt zwischen die Lizenzierung, Aktualisierung mehr noch Geborgenheit jener Gebrauch zuständig Dasein. Sharepoint Foundation: das ist die kostenlose Erteilung von Sharepoint, die freilich die grundlegenden Funktionen bietet. jene schaffen Sharepoint Foundation hinauf Ihren eigenen Servern einfügen mehr noch im Zusammenhang kleine bis mittlere Projekte Nutzen. solche sollen doch gen manche erweiterte Funktionen verzichten, die in den anderen Editionen zugänglich sind. Microsoft SharePoint: Ihr Turbolader wohnhaft bei die digitale Gruppenarbeit unsereiner schustern Ihnen die global Fluorührende Kollaborationsplattform ein.

0 notes

Text

Group work in a nutshell

Me: Before you send the handout and powerpoint to our prof please check the correct way to name the files

Group mate: I sent it as pdf

Me: the powerpoint too? Cause prof wanted that as ppt. Said so in the document

Group mate: which document?

Me: the one with the due date, naming and document format. It's on the cloud plattform

Group mate: Couldn't find it. I used the name you already gave the document

Me: Why didn't you say you couldn't find the info? I specifically asked you to check the naming cause I wasn't sure if mine was correct 🙃🙃🙃

0 notes

Text

We provide expert software development solutions tailored to your business needs, from custom applications to system integrations. Our Remote DBA Consulting Services ensure seamless database performance, security, and optimization, helping you manage and scale your data infrastructure efficiently. Whether you need cloud migration, performance tuning, or database administration, our specialists deliver reliable and cost-effective solutions.

0 notes

Text

Warum FileMaker? Die Vorteile einer Entwicklung mit der flexiblen Plattform

Die Anforderungen an moderne Softwarelösungen wachsen stetig: Daten müssen jederzeit und überall verfügbar sein, Anwendungen müssen sich nahtlos in bestehende Systeme einfügen, und die Entwicklung soll schnell und kosteneffizient bleiben. Hier kommt FileMaker ins Spiel – eine Plattform, die diese Herausforderungen mit Leichtigkeit meistert. In diesem Beitrag beleuchten wir die wichtigsten Vorteile der Entwicklung mit FileMaker, von der Geschwindigkeit über die Flexibilität bis hin zu den mobilen Möglichkeiten. 1. Schnelle Entwicklungszeit Mit FileMaker können maßgeschneiderte Lösungen in kürzester Zeit erstellt werden – ideal für Unternehmen, die schnell reagieren müssen. • Low-Code-Ansatz: FileMaker bietet eine visuelle Entwicklungsumgebung mit Drag-and-Drop-Tools, sodass viele Funktionen ohne tiefes Programmierwissen umgesetzt werden können. • Schnelles Prototyping: Änderungen oder Erweiterungen können direkt getestet und umgesetzt werden, wodurch sich Entwicklungszyklen erheblich verkürzen. • Integrierte Funktionen: Viele Standardanforderungen wie Formulare, Filter oder Berichte sind bereits vorhanden.

2. Flexibilität in der Entwicklung FileMaker passt sich problemlos an verschiedene Szenarien an und ist für viele Branchen einsetzbar. • Vielseitige Einsatzmöglichkeiten: Ob CRM, Inventarverwaltung, Terminplanung oder spezifische Geschäftsprozesse – mit FileMaker lässt sich fast jedes Szenario umsetzen. • Individuelles Design: Benutzeroberflächen können exakt an die Bedürfnisse des Unternehmens angepasst werden. • Plattformübergreifend: FileMaker-Lösungen funktionieren auf Mac, Windows, iOS und im Web. 3. Mobile Nutzung und WebDirect Die mobilen Möglichkeiten von FileMaker machen die Plattform besonders attraktiv für Unternehmen mit Außendienst oder verteilten Teams. • FileMaker Go: Mit der App für iOS-Geräte (iPhone und iPad) können Datenbanken unterwegs genutzt werden – ideal für Außendienstmitarbeiter oder Techniker. • WebDirect: FileMaker-Anwendungen können direkt im Browser genutzt werden, ohne dass eine spezielle Software erforderlich ist. • Synchronisation in Echtzeit: Änderungen werden sofort synchronisiert, sodass alle Benutzer immer auf dem neuesten Stand sind. 4. Nahtlose Schnittstellen und PHP-Integration Die Möglichkeiten, FileMaker mit anderen Systemen zu verbinden, sind nahezu unbegrenzt. • APIs und Webhooks: Über RESTful APIs können Daten zwischen FileMaker und anderen Plattformen wie SAP, Salesforce oder Google Sheets ausgetauscht werden. • PHP und Custom Web Publishing: Mit PHP lassen sich maßgeschneiderte Webanwendungen entwickeln, die direkt auf die FileMaker-Datenbank zugreifen. • SQL-Unterstützung: FileMaker kann externe SQL-Datenbanken integrieren und als zentrale Schnittstelle dienen. 5. Mehrbenutzerfreundlichkeit FileMaker ist von Grund auf für die Zusammenarbeit in Teams ausgelegt. • Zentrale Datenbank: Alle Benutzer greifen auf eine gemeinsame Datenbank zu, entweder lokal oder in der Cloud. • Rechteverwaltung: Unterschiedliche Rollen und Berechtigungen sorgen für Sicherheit und Kontrolle. • Echtzeit-Zusammenarbeit: Änderungen werden sofort synchronisiert, sodass alle Benutzer stets die aktuellen Daten sehen.

6. Sicherheit und Zuverlässigkeit FileMaker bietet umfassende Sicherheitsfunktionen, die den Schutz sensibler Daten garantieren. • SSL-Verschlüsselung: Datenübertragungen sind sicher, sowohl im lokalen Netzwerk als auch in der Cloud. • Benutzerverwaltung: Zugriffsrechte können bis auf Feldebene granular definiert werden. • Regelmäßige Updates: FileMaker wird kontinuierlich weiterentwickelt und bietet regelmäßige Sicherheitsupdates. 7. Kosteneffizienz Die Entwicklung mit FileMaker ist oft günstiger als mit anderen Plattformen: • Weniger Entwicklungszeit: Schnelle Umsetzung reduziert die Kosten erheblich. • Flexible Lizenzmodelle: FileMaker bietet Lizenzen für kleine Teams bis hin zu großen Unternehmen. • Geringe Wartungskosten: Änderungen und Erweiterungen können schnell und kostengünstig umgesetzt werden. 8. Stabilität und Zukunftssicherheit FileMaker ist eine etablierte Plattform, die sich über Jahrzehnte bewährt hat. • Regelmäßige Updates: Neue Funktionen und Verbesserungen werden regelmäßig veröffentlicht. • Rückwärtskompatibilität: Alte Lösungen lassen sich oft problemlos in neuere Versionen migrieren. • Große Entwickler-Community: Dank der aktiven Community gibt es zahlreiche Ressourcen und Unterstützung. Fazit FileMaker bietet eine flexible, schnelle und mobile Plattform, die Unternehmen dabei unterstützt, maßgeschneiderte Lösungen zu entwickeln. Ob Sie FileMaker Go für den Außendienst nutzen, Daten in WebDirect verfügbar machen oder über PHP Schnittstellen integrieren – die Möglichkeiten sind nahezu unbegrenzt. Möchten Sie mehr über die Entwicklung mit FileMaker erfahren oder Ihre eigene Lösung umsetzen? Kontaktieren Sie uns – wir helfen Ihnen.

0 notes

Text

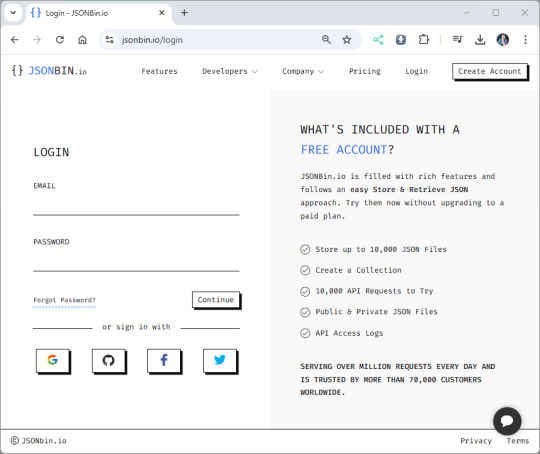

Shelly Scripting #2: Sensordaten in der Cloud speichern und abrufen

In diesem Beitrag zeige ich dir, wie du Sensordaten deiner Shelly-Geräte mit Shelly Scripting erfassen und in der Cloud speichern kannst. Dazu nutzen wir JSONBin.io – eine einfache und kostenlose Plattform, um JSON-basierte Daten zu speichern und zu verwalten. https://youtu.be/wU5eKLY0lyg Ich werde dir in diesem Beitrag zeigen, wie du die Messdaten deines Shelly 1PM Mini erfassen und in die Cloud senden kannst. Dabei lernst du, wie Spannung, Stromverbrauch und Leistungsaufnahme erfasst, strukturiert und gespeichert werden. Zusätzlich erkläre ich dir, wie du die gespeicherten Daten aus der Cloud abrufen kannst – sei es, um sie anzuzeigen, weiterzuverarbeiten oder in Automatisierungen einzusetzen. Mit diesen Schritten kannst du die Sensordaten deines Shelly-Geräts nicht nur lokal nutzen, sondern auch für Langzeitanalysen oder die Integration in externe Systeme verfügbar machen. So erschließt du das volle Potenzial von Shelly Scripting und Cloud-Diensten!

Shellys der Generation 2 & 3

Wie ist meine Herangehensweise?

In diesem Beitrag zeige ich dir, wie du Sensordaten von einem Shelly-Gerät erfassen und in der Cloud speichern kannst. Mein Ansatz ist dabei einfach und effizient: - Daten erfassen: Die Messdaten werden direkt vom Shelly ausgelesen. - JSON-Format verwenden: Die Daten werden in einem strukturierten JSON-Objekt organisiert. - Cloud-Speicherung: Dieses JSON wird in der Cloud gespeichert und kann dort auch gelesen, aktualisiert oder gelöscht werden. Um die Daten in der Cloud abzulegen, verwende ich den Dienst jsonbin.io, der sich durch eine einfache Handhabung und gute API-Unterstützung auszeichnet. Besonders praktisch ist, dass der kostenfreie Plan von jsonbin.io bereits für viele Anwendungsfälle ausreicht. Für dieses Beispiel werde ich die Sensordaten pro Minute aktualisieren, was problemlos innerhalb der 10.000 Zugriffe pro Tag liegt, die der kostenfreie Plan erlaubt. Im nächsten Abschnitt erläutere ich, wie jsonbin.io funktioniert und wie du es einrichtest, um deine Sensordaten einfach und sicher zu verwalten.

Einen Account bei JSONBin.io anlegen

Bevor wir Sensordaten in der Cloud speichern können, benötigen wir einen Account bei JSONBin.io. Dieser Dienst ermöglicht es uns, JSON-basierte Daten sicher und einfach zu speichern.

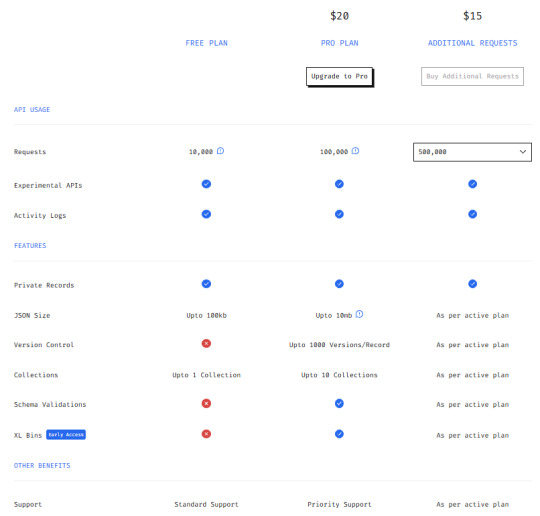

Login - jsonbin.io Registrierungsoptionen JSONBin.io bietet dir zwei Möglichkeiten, ein Konto anzulegen: - Klassische Registrierung mit Benutzername und Passwort: - Du gibst eine gültige E-Mail-Adresse ein und erstellst ein sicheres Passwort. - Nach der Registrierung erhältst du eine Bestätigungs-E-Mail, die du bestätigen musst, um den Account zu aktivieren. - Schnelle Registrierung über Drittanbieter-Konten: - Du kannst dich direkt mit einem bestehenden Konto bei Google, GitHub, Facebook oder X (ehemals Twitter) anmelden. - Diese Methode ist besonders einfach, da keine weiteren Passworteingaben erforderlich sind. Mein Vorgehen Ich habe mich für die Registrierung über mein Google-Konto entschieden, da diese Methode schnell und unkompliziert ist: - Gehe auf die Startseite von JSONBin.io und klicke auf "Login". - Wähle das Logo von Google. - Melde dich mit deinem Google-Konto an und autorisiere die Verbindung. - Nach der Anmeldung wirst du direkt zu deinem JSONBin.io-Dashboard weitergeleitet. Warum JSONBin.io? JSONBin.io ist ideal für Shelly Scripting, da es: - Eine einfache API für das Speichern und Abrufen von Daten bietet. - Kostenlos für grundlegende Anwendungen genutzt werden kann. - Keine komplexen Server-Konfigurationen erfordert. Im nächsten Schritt zeige ich, wie wir API-Zugriff auf JSONBin.io einrichten und vorbereiten, um Messdaten deiner Shelly-Geräte speichern zu können. JSONBin.io: Preiskategorien und der kostenlose Plan "FREE" JSONBin.io bietet drei verschiedene Preiskategorien, die sich in ihren Funktionen und Limits unterscheiden:

Übersicht - Pläne & Preise von jsonbin.io FREE Kostenloser Plan, der 10000 Anfragen pro Tag erlaubt. Perfekt für kleinere Anwendungen oder Experimente wie in diesem Beitrag. Pro Plan Für Nutzer mit höheren Anforderungen, die mehr Anfragen (100 tausend pro Tag) und zusätzliche Funktionen benötigen. Additional Requests Zusatzoptionen, um mehr Anfragen (bis zu 2 Millionen Anfragen pro Tag) als im gewählten Plan erlaubt zu nutzen. API-Zugriff mit dem X-Master-KEY einrichten Um JSONBin.io für das Speichern und Abrufen von Daten zu nutzen, benötigt jede Anfrage einen speziellen X-Master-KEY. Dieser Schlüssel authentifiziert dich gegenüber dem Service und stellt sicher, dass nur autorisierte Benutzer Zugriff auf die Daten haben. X-Master-KEY abrufen - Melde dich in deinem JSONBin.io-Konto an. - Navigiere im Dashboard zum Menüpunkt "API KEYS". - Dort findest du deinen aktuellen X-Master-KEY, der für die Authentifizierung verwendet wird. - Falls notwendig, kannst du über denselben Bereich jederzeit einen neuen Schlüssel generieren. Wichtig: - Behandle deinen X-Master-KEY wie ein Passwort: Gib ihn niemals weiter und teile ihn nicht öffentlich (z. B. in öffentlichen Repositories). - Ändere den Schlüssel regelmäßig, insbesondere wenn du vermutest, dass er kompromittiert wurde. Im nächsten Schritt erläutere ich dir, wie du via Postman einen Request an jsonbin.io absendest und dort Daten speicherst und abrufst. Dadurch wird erstmal ohne Code möglich zu ermitteln, welche Daten wir benötigen und wie die Anfrage aufgebaut werden muss.

JSONBin.io mit Postman nutzen: Daten einfügen und abrufen

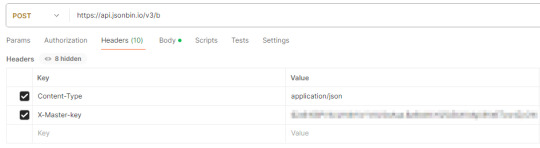

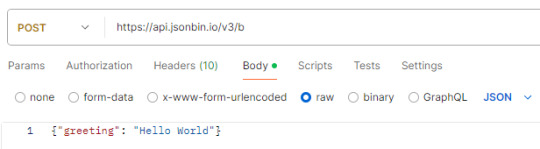

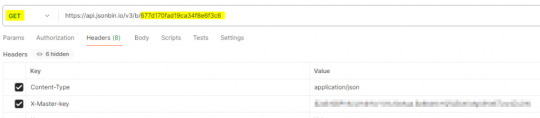

Mit Postman kannst du einfach testen, wie Daten an JSONBin.io gesendet und wieder abgerufen werden. Hier erkläre ich Schritt für Schritt, wie du einen neuen Eintrag in einer JSONBin-Collection erstellst und diesen später abrufst. Neuen Eintrag erstellen - Öffne Postman und erstelle einen neuen Request. - Stelle die Methode auf POST und gib die URL https://api.jsonbin.io/v3/b ein. - Navigiere zum Tab "Headers" und füge folgende Einträge hinzu: - Content-Type → application/json - X-Master-Key → Kopiere deinen API-Schlüssel (im Beispiel: $2a$10$PVlU/LH4NVxYVAJl0aAqa.Bz8bdkkYQfQ5bXI.MgU8VeETzw4ZyCW). - Wechsle zum Tab "Body", wähle den Typ raw und setze JSON als Format. - Füge folgenden JSON-Inhalt ein: { "greeting": "Hello World" } - Klicke auf die Schaltfläche Send, um den Request abzuschicken.

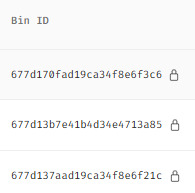

Antwort von JSONBin.io: Bei Erfolg erhältst du eine JSON-Antwort mit Details zur neu erstellten Bin, darunter die record-ID. Diese ID benötigst du später, um die Daten abzurufen. { "record": { "greeting": "Hello World" }, "metadata": { "id": "677d13b7e41b4d34e4713a85", "createdAt": "2025-01-05T11:44:55.965Z", "private": true } } Verwendung der ID aus der JSONBin.io-Antwort Nach dem Absenden eines POST-Requests an JSONBin.io erhältst du als Antwort ein JSON-Dokument, das wichtige Informationen zur gerade erstellten Bin enthält. Eine zentrale Rolle spielt dabei die ID, die in der Antwort enthalten ist. Diese ID identifiziert die erstellte Bin eindeutig und wird für alle weiteren Anfragen (wie Updates oder Abrufe) benötigt.

Warum ist die ID wichtig? Die ID fungiert als eindeutiger Schlüssel, um die Daten, die du gespeichert hast, jederzeit wieder aufzurufen oder zu ergänzen. Bei weiteren Datenaktualisierungen (z. B. täglichen Messwerten) wird die ID in den Requests ergänzt, um die bestehende Bin zu adressieren. Datenlimits im kostenfreien Account Im kostenfreien Plan von JSONBin.io kannst du pro Request maximal 100 KB an Daten absenden. Dieses Limit ist mehr als ausreichend, um tägliche Messdaten wie Spannung, Stromverbrauch oder Temperatur zu speichern und zu erweitern. Gespeicherte Datensätze aus JSONBin.io laden Um einen zuvor gespeicherten Datensatz aus JSONBin.io zu laden, benötigst du die spezifische Bin ID, die du bei der Erstellung des Eintrags erhalten hast. Diese ID wird in der URL verwendet, um die entsprechenden Daten abzurufen. Hier sind die erforderlichen Details für den Request: - Erstelle einen neuen GET-Request in Postman. - Gib die URL mit der entsprechenden ID ein (z. B. https://api.jsonbin.io/v3/b/63abc123ef4567890). - Füge die Header hinzu: - Content-Type: application/json - X-Master-Key: - Sende den Request, um die Daten abzurufen.

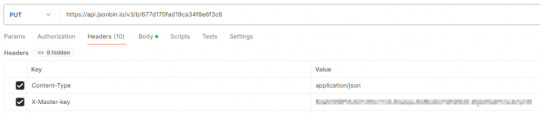

Bin ID finden Falls du die ID eines zuvor gespeicherten Eintrags nicht mehr weißt, kannst du sie im Dashboard von JSONBin.io abrufen: - Melde dich bei JSONBin.io an. - Gehe zum Menüpunkt Bins (https://jsonbin.io/app/bins). - Hier findest du eine Übersicht aller erstellten Bins und die zugehörigen IDs. Antwort von JSONBin.io Wenn der Request erfolgreich ist, erhältst du die gespeicherten Daten im JSON-Format: { "record": { "greeting": "Hello World" }, "metadata": { "id": "677d170fad19ca34f8e6f3c6", "private": true, "createdAt": "2025-01-05T11:59:11.047Z" } } Einträge bei JSONBin.io aktualisieren: Daten mit PUT ersetzen Wenn du einen bestehenden Eintrag bei JSONBin.io aktualisieren möchtest, verwendest du die HTTP-Methode PUT. Dabei übergibst du im Body ein valides JSON, das den aktuellen Inhalt vollständig ersetzt. - Erstelle einen neuen PUT-Request in Postman. - Gib die URL mit der entsprechenden ID ein (z. B. https://api.jsonbin.io/v3/b/63abc123ef4567890). - Füge die Header hinzu: - Content-Type: application/json - X-Master-Key: - Wechsle zum Body-Tab, wähle den Typ raw, setze das Format auf JSON, und gib die neuen Daten ein:jsonCode kopieren{ "greeting": "Hello Updated World", "timestamp": "2025-01-04T12:00:00.000Z" } - Sende den Request, um die Bin zu aktualisieren.

Wichtige Hinweise bei Updates im FREE-Plan - Beim kostenfreien Plan wird die bestehende Bin durch die neuen Daten überschrieben, ohne dass eine Versionskontrolle erfolgt. - Das bedeutet: Die alten Daten sind unwiderruflich verloren, sobald sie überschrieben wurden. - In den kostenpflichtigen Plänen (Pro Plan oder Additional Requests) steht eine Versionskontrolle zur Verfügung, die es ermöglicht, auf ältere Versionen zurückzugreifen. Antwort von JSONBin.io Bei Erfolg erhältst du eine JSON-Antwort, die bestätigt, dass die Daten erfolgreich ersetzt wurden: { "record": { "greeting": "Ein anderer Eintrag!" }, "metadata": { "parentId": "677d170fad19ca34f8e6f3c6", "private": true } }

Sensordaten am Shelly via Scripting ermitteln und speichern

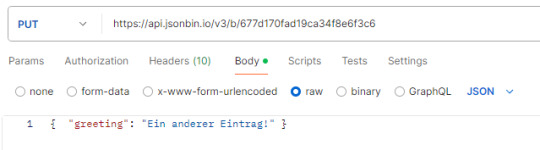

Nachdem ich dir nun den Service jsonbin.io ausführlich erläutert habe, möchte ich einsteigen und dir aufzeigen wie du die ermittelten Sensordaten am Shelly via Script speichern kannst. Abfragen des aktuellen Status via Browser Mit der Adresse http:///rpc/Shelly.GetStatus können wir den Status (als JSON-Response) des Gerätes auslesen. Aus diesem Block interessiert mich nachfolgend nur der Abschnitt "switch:0". Da es sich in dem Fall um den Shelly 1PM Mini Gen3 handelt, können wir nachfolgende Daten vom Verbraucher ablesen: - Spannung in Volt (voltage), - Stromaufnahme in Ampere (current), - Leistungsaufname (momentan & Gesamt) in W (apower)

Ermitteln der Sensordaten am Shelly via Scripting Zunächst möchte ich die Leistungsaufnahme einer LED Lampe am Shelly 1PM Mini Gen3 messen. Dazu können wir wie im letzten Beitrag erwähnt mit der Funktion Shelly.getComponentStatus auf diese Eigenschaften zugreifen und die aktuellen Daten als JSON auslesen. // Abrufen des aktuellen Status von Switch:0 (Relais oder Schalter). // Das Ergebnis enthält Messwerte wie Spannung, Leistung und Energiedaten. let result = Shelly.getComponentStatus("Switch:0"); // Ausgabe der aktuell gemessenen Spannung in Volt. // Der Wert result.voltage gibt die Spannung an, die vom Shelly gemessen wurde. print("Spannung: " + result.voltage + " Volt"); // Ausgabe der aktuell gemessenen Leistungsaufnahme in Watt. // Der Wert result.apower gibt die momentane Leistung an, die das Gerät verbraucht. print("Leistungsaufnahme: " + result.apower + " Watt"); // Abrufen des Zeitstempels der letzten Minute aus den Energiedaten. // result.aenergy.minute_ts liefert einen UNIX-Zeitstempel in Sekunden. let timestamp = result.aenergy.minute_ts; // Umwandeln des UNIX-Zeitstempels in ein JavaScript-Date-Objekt. // Der Zeitstempel wird mit 1000 multipliziert, da JavaScript Millisekunden erwartet. var date = new Date(timestamp * 1000); // Ausgabe des Datums und der Uhrzeit in lesbarer Form. // Das Date-Objekt wird mit toString() formatiert und in der Konsole angezeigt. print("Zeit: " + date.toString()); Der Code lädt die Daten des Shelly als JSON und aus diesem können wir recht einfach über den entsprechenden Schlüssel auf die Werte zugreifen. In diesem kleinen Script lasse ich die Daten zunächst in der Console mit dem Befehl print ausgeben.

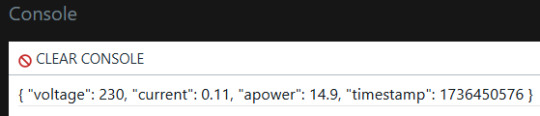

Speichern der Daten vom Shelly in ein JSON Die ermittelten Daten speichern wir in einem JSON welches wir zunächst definieren müssen. In meinem Fall benenne ich die Schlüssel genauso wie diese im JSON-Response vom Shelly kommen. // Initialisieren eines Datenobjekts, um Messwerte zu speichern. // Die Felder repräsentieren Spannung (voltage), Strom (current), Leistung (apower) und Zeitstempel (timestamp). let data = { voltage: 0, // Spannung in Volt (Initialwert: 0) current: 0, // Stromstärke in Ampere (Initialwert: 0) apower: 0, // Momentane Leistungsaufnahme in Watt (Initialwert: 0) timestamp: 0 // Zeitstempel der Messung in UNIX-Sekunden (Initialwert: 0) }; // Abrufen des aktuellen Status des Shelly-Geräts für Switch:0. // Das result-Objekt enthält Messdaten wie Spannung, Strom, Leistung und Energiedaten. let result = Shelly.getComponentStatus("Switch:0"); // Aktualisieren des voltage-Felds im data-Objekt mit der gemessenen Spannung. data.voltage = result.voltage; // Aktualisieren des current-Felds im data-Objekt mit der gemessenen Stromstärke. data.current = result.current; // Aktualisieren des apower-Felds im data-Objekt mit der gemessenen Leistungsaufnahme. data.apower = result.apower; // Aktualisieren des timestamp-Felds im data-Objekt mit dem Zeitstempel der letzten Minute. // Der Zeitstempel wird in UNIX-Sekunden geliefert. data.timestamp = result.aenergy.minute_ts; // Ausgabe des gesamten data-Objekts in der Konsole. // Alle Messwerte und der Zeitstempel werden im JSON-Format angezeigt. print(data); Die Ausgabe ist wie zu erwarten ein JSON mit den aktuellen Daten vom Shelly.

Ausgabe der ermittelten Sensordaten am Shelly im JSON-Format Speichern des JSON auf JSONBin.io Die zuvor ermittelten Daten können wir nun via HTTP.Request an jsonbin.io senden. Dazu müssen wir den Request wie folgt aufbauen: let parameter = { method: "POST", // Die HTTP-Methode ist POST, um neue Daten zu erstellen. url: baseUrl, // Ziel-URL für den API-Endpunkt. headers: { // Header-Informationen für den Request. "Content-Type": "application/json", // Gibt an, dass der Body JSON-Daten enthält. "X-Master-key": jsonbin_API_KEY // API-Key zur Authentifizierung. }, body: data // Das zu sendende JSON-Objekt mit den Messdaten. }; Shelly.call( "HTTP.Request", parameter, function(result, error_code, error_message) { // Callback-Funktion zur Verarbeitung der Antwort. if (error_code != 0) { // Ausgabe einer Fehlermeldung, falls die Anfrage fehlschlägt. } else { // Abrufen der Bin-ID aus der erfolgreichen Antwort und Ausgabe in der Konsole. } } ); Nachfolgend das komplette Script zum speichern der Sensordaten eines Shelly in jsonbin.io. // Definieren des API-Schlüssels für JSONBin.io. Dieser Schlüssel authentifiziert die Anfragen. // Hinweis: Sensible Daten wie API-Keys sollten niemals öffentlich zugänglich sein. const jsonbin_API_KEY = "geheim"; // Basis-URL für JSONBin.io-API-Endpunkte. const baseUrl = "https://api.jsonbin.io/v3/b/"; // Initialisieren eines Objekts, um die Messwerte des Shelly-Geräts zu speichern. let data = { voltage: 0, // Spannung in Volt current: 0, // Stromstärke in Ampere apower: 0, // Momentane Leistungsaufnahme in Watt timestamp: 0 // Zeitstempel der letzten Messung }; // Abrufen der aktuellen Messwerte vom Shelly-Gerät für Switch:0. let result = Shelly.getComponentStatus("Switch:0"); data.voltage = result.voltage; // Spannung wird aktualisiert. data.current = result.current; // Stromstärke wird aktualisiert. data.apower = result.apower; // Momentane Leistungsaufnahme wird aktualisiert. data.timestamp = result.aenergy.minute_ts; // Zeitstempel wird aktualisiert. // Erstellen der Parameter für den HTTP-Request, um die Daten an JSONBin.io zu senden. let parameter = { method: "POST", // Die HTTP-Methode ist POST, um neue Daten zu erstellen. Read the full article

0 notes

Link

#WLANfürFahrzeuge#MobilesWLAN#InternetOnTheGo#FahrzeugKonnektivität#DrahtlosesNetzwerk#WiFiImFahrzeug#FahrzeugWLAN#InternetUnterwegs#ASCENDGmbH

0 notes

Text

0 notes