#juizhang

Explore tagged Tumblr posts

Text

Séminaire Informatique Quantique

J’ai participé, il y a un peu plus d’un mois, à une session sur « Etat des lieux de l’informatique Quantique en France » organisée à Paris. A part la présence de différents acteurs, il y avait surtout Maud Vinet, ex-responsable du quantum computing au CEA et considérée comme la tête chercheuse du quantique en France (c’est surtout pour sa présence que j’ai fait le déplacement).

L’avantage de cette session était le nombre réduit de participants ce qui a permis une interaction tout au long de la journée aussi bien durant les conférences qu’en dehors (lors des pauses…).

Ainsi plusieurs conférenciers se sont succédés. Les premières interventions étaient surtout pour rappeler les fondamentaux des ordinateurs quantiques. On a rappelé la notion de "Qbits" basée sur des particules élémentaires (photons, électrons, atomes...) qui obéissent aux lois de la mécanique quantique. Et surtout l’avantage de ces "Qbits" qui, contrairement aux "bits" peuvent prendre tous les états entre 0 et 1 (cf mon précédent article).

Plusieurs images, pour faire la comparaison ont été évoquées :

Les 2 touches sur un piano : Vous pouvez jouer une touche l’une après l’autre mais aussi les 2 touches en même temps ou encore frapper plus ou moins fort les touches… les possibilités sont nombreuses.

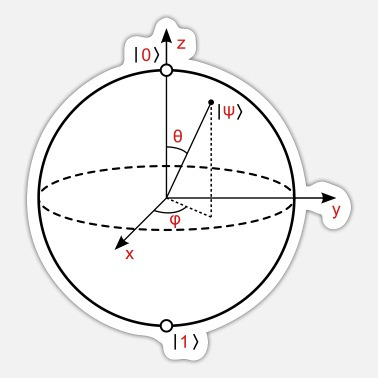

Une autre représentation est la sphère de Bloch où le pôle Nord est le 0, et le pôle Sud le 1 : Le qubit peut avoir n’importe quelle valeur sur cette sphère durant la phase de calcul. Lors de la mesure son état est alors figé.

Puis on a attaqué dans le dur avec les algorithmes à utiliser : L’objectif étant d’associer plusieurs Qbits pour un calcul, car la « puissance » est exponentielle avec le nombre de Qbits utilisés. Il existe ainsi plusieurs types d’algorithmes qui peuvent être basés sur l’optimisation des valeurs matricielles, l’optimisation combinatoire ou encore un réseau de neurones quantiques. J’avoue à ce niveau, j’ai lâché un peu le fil de l’exposé. Mais pour résumer, il existe des portes quantiques qui permettent suivant l’algorithme de relier un certain nombre de Qbits plus ou moins proches. Un focus a été fait sur l’algorithme des réseaux neurones orthogonaux qui peuvent s'avérer utiles pour améliorer la performance ou pour réduire le nombre de paramètres.

Ce qui est m’a intéressé, est la possibilité de tester dès aujourd’hui ces algorithmes à l’aide de logiciels d’émulateurs quantiques qui fonctionnent sous GPU. Mais ces programmes donnent des résultats avec un nombre de Qbits « parfaits ». Hors dans la vraie vie, ces Qbits sont très instables et très difficiles à contrôler, avec une difficulté qui va croissante au fur et à mesure qu'on ajoute des Qbits pour doper la puissance de calcul. Il y a donc des erreurs qui se produisent. Il est nécessaire d’introduire une couche de correction d'erreurs quantiques et cette couche de correction à un coût en terme de nombre de Qbits physiques. Aujourd'hui suivant le type de système physique avec lequel on travaille et la durée de calcul, on estime qu’il faudrait environ 1000 Qbits physique pour créer un Qbit parfait ou Qbit « logique » permanent dans le temps.

Lors d’échanges informels, d’autres approches basées sur la redondance d'information permettraient de déduire une « probabilité » pour obtenir le bon résultat spécifique. Avec cette méthode on arriverait entre 60 et 30 Qbits physiques pour un Qbit logique permanent.

C’est le moment où Maud Vinet est intervenue pour sa présentation. Elle a justement fait un rappel des différentes technologies permettant de créer des serveurs Quantiques. Car le problème aujourd'hui c'est vraiment la partie hardware. Pour la manipulation d’objets uniques auxquels on a accès facilement les possibilités sont nombreuses : Que cela soit des atomes sous vide, les supraconducteurs qui présentent des propriétés quantiques à l'échelle macroscopique intéressantes ou encore les photons pour leur facilité de mise en œuvre avec des lasers, chaque techno apporte ses avantages mais aussi ses imperfections et donc ses erreurs.

La course est donc ouverte, c’est pour cette raison que Maud VINET a créé il y a 6 mois la société SIQUANCE en se disant que le silicium peut être aussi un super candidat. Elle met en avant la qualité du silicium employé qui permet d’améliorer le taux d’erreur. Dans la suite de sa conférence, Maud VINET a détaillé le fonctionnement de son ordinateur quantique en utilisant le degré de liberté de spin : La microélectronique utilise une seule propriété des électrons, leur charge électrique, et un matériau principal, le silicium. L'informatique quantique utilise une autre caractéristique des électrons, purement quantique, leur spin. Pour résumé, le spin concerne la rotation de l’électron sur lui-même. Il peut tourner dans un sens ou dans l'autre. Cela lui donne un degré de liberté magnétique permettant de définir les états quantiques (De 0 à 1). Cet état va être sensible au champ magnétique qu'on applique pour le manipuler. Et voilà comment sont nés les Qbits de spin dans le silicium.

Toujours durant ces échanges, on a parlé de la start-up la plus avancée en France : Pasqal. Cette société développe un ordinateur quantique à atomes neutres : Quelques atomes de rubidium sont disposés dans le « vide » et à l’aide de lasers ils sont manipulés.

Alain Aspect, cofondateur de Pasqal, a remporté le Prix Nobel en 2022 aux côtés de John F. Clauser et Anton Zeilinger, pour avoir mené des expériences extraordinaires en utilisant des états d'intrication quantique, dans lesquels deux particules se comportent comme une seule unité, même en étant séparées. De ces recherches, il peut être envisagé de réduire le nombre de Qbits physiques nécessaires pour le traitement des erreurs comme évoqué précédemment.

Il faut savoir qu'actuellement la start-up affichent "déjà" entre 100 et 200 Qbits physiques, mais elle envisage dès 2024, 1000 Qbits !

Il a été ensuite évoqué les utilisations concrètes de l’informatique quantique comme chez AstraZeneca sur la prédiction de taux de réussite ou encore chez Roche pour l’imagerie médicale.

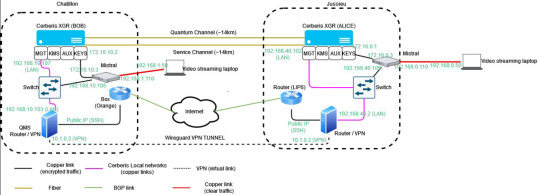

Après une longue pause bien mérité, les conférences ont abordé les aspects liés à la sécurité. On a commencé par les technologies quantiques pour sécuriser l’échange de clés (QKD). Sur ce point la technologie est déjà validée et garantit une sécurité quasi-totale (ainsi l’intrication quantique permet de déterminer si une clé a été interceptée). La seule difficulté consiste à construire des réseaux supportant la transmission d’informations Quantiques. Orange a ainsi expérimenté le QKD à travers « la lumière » et son réseau optique. Sachant qu’une fois l’échange de clefs effectué, la transmission des données utilise des moyens classiques. Un flux vidéo a ainsi été mis en place de façon sécurisé en utilisant le QKD entre 2 sites de recherche d’Orange :

Il semble que sur ce point, la France a pris du retard par rapport aux autres pays Européens pour déployer ce type de réseau.

Mais le principal risque est d’ordre cryptographique. Avec la puissance du quantique, il sera possible de décrypter des données en quelques mois, voire semaines, là où aujourd’hui il faudrait plusieurs dizaines d’années. Certains « états » pratiquent déjà le Store Now,DecypherLater. Pour contrer ce problème des algorithmes de chiffrement et de signature «post-quantiques» (PQC) ont été proposés par le NIST (National Institute of Standards and Technology). Le problème est que ces algorithmes sont peu nombreux (3) et surtout qu’aucun de ces algorithmes n’a encore passé l’épreuve du feu sur un ordinateur quantique… Les acteurs de la sécurité travaillent surtout à coupler les algorithmes PQC aux systèmes actuels dans une stratégie d’« hybridation » pour essayer de maximiser la sécurité (préconisation de l’ANSSI).

Suite à ces échanges sur la sécurité, une question a été évoquée sur le quantique en Chine. Un ordinateur quantique, Juizhang, a été construit. Ce serveur utilise la lumière (photons) comme support physique de calcul. La chine s’est notamment « vantée » en 2020 d’avoir réalisé un calcul sur un Juizhang (V2) en 200 secondes qui aurait pris plusieurs années avec un HPC classique.

Pour finir la journée, une thématique a été évoquée sur l’impact énergétique de l’ordinateur quantique. Comme évoqué, les particules impliquées dans le processus de l’informatique quantique sont sujettes à des erreurs si elles sont exposées à la moindre perturbation de l'environnement. C'est pourquoi les ordinateurs quantiques fonctionnent dans des environnements isolés et à des températures extrêmement basses. Cela a un impact environnemental même si le ratio par rapport à un HPC n’est pas comparable.

Pasqal, en utilisant des atomes manipulés par lasers, n’a pas besoin en principe de système cryogénique mais il est cependant nécessaire de refroidir la pompe qui génère le vide.

Nous sommes sur le point de passer une nouvelle frontière. Nous ne savons pas encore quand et par quel moyen l’atteindre mais les « richesses potentielles » seront immenses. Aujourd’hui entraîner l’IA sur des modèles LLM nécessite plusieurs mois, avec un ordinateur quantique cela se mesurera en secondes… La conquête vers ce nouveau monde est lancée, les premiers qui y parviendront, auront la possibilité de s’imposer durablement.

L'invention du transistor date de 1947 mais celui-ci a été imaginé conceptuellement à la fin des années 20. Il a fallu attendre le milieu des années 70 pour aboutir au développement industriel des transistors dans les processeurs. Le principe de l’ordinateur quantique date du milieu des année 80, le premier Qbits est né au début des années 2000. En 2020, plusieurs ordinateurs quantiques de 50 Qbits fonctionnent dans le monde. Aujourd’hui le système de processeurs quantiques Eagle d'IBM affiche une puissance de 127 Qbits. Son prochain processeur quantique, attendu pour la fin de 2023, devrait franchir la barre de 1000 Qbits. L’augmentation du nombre de Qbits physiques disponibles pour un calcul, couplé à la quête du Qbit parfait, pourraient bien représenter une avancée décisive dans les 5 prochaines années…

6 notes

·

View notes