#inteligência artificial conceitos e aplicações

Text

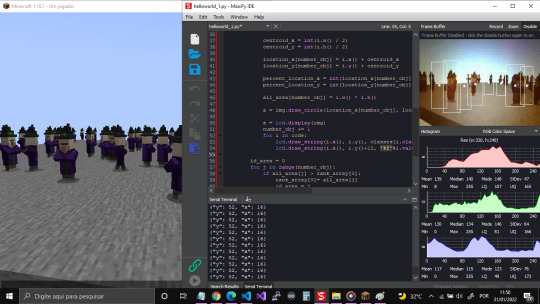

Medir Distância com Visão Computacional

Experimento usando visão computacional (um tipo de IA) do Maix bit para medir a distância dos objetos em relação a câmera.

Nesse projeto acabei usando o Minecraft para ajudar nos testes, mas o uso não é obrigatório.

Medir distância com visão computacional é uma opção interessante mas não deve ser o meio principal de medição por não ser preciso. Mesmo assim, é possível identificar o objeto mais próximo da câmera em boa parte dos casos.

Lógica de Funcionamento

A principio, todo objeto identificado pela Inteligência Artificial (IA) fica contido em um retângulo ou quadrado, como se pode ver na imagem a…

Ver no WordPress

#a inteligência artificial#conceito de inteligência artificial#exemplos de inteligência artificial#inteligência artificial a nosso favor#inteligência artificial benefícios#inteligência artificial brasil#inteligência artificial como funciona#inteligência artificial conceitos e aplicações#inteligência artificial em python#inteligência artificial exemplos#tipos de inteligência artificial

0 notes

Text

MARKETING DIGITAL COM INTELIGÊNCIA ARTIFICIAL

Introdução ao Marketing Digital com Inteligência Artificial

A tecnologia transformou a forma como fazemos negócios, e o marketing digital não é exceção. Com a ascensão da inteligência artificial (IA), as estratégias de marketing digital se tornaram mais eficazes, precisas e personalizadas. Neste artigo, vamos explorar como a IA está revolucionando o marketing digital, os benefícios que ela traz, e como você pode implementá-la na sua estratégia para atrair e reter clientes.

O que é Inteligência Artificial?

Definição e Conceitos Básicos

Inteligência Artificial (IA) refere-se à capacidade das máquinas de aprenderem com dados, tomarem decisões e realizarem tarefas que normalmente requerem inteligência humana. Ela envolve diversas tecnologias, como aprendizado de máquina, processamento de linguagem natural e redes neurais.

Aplicações Gerais da IA

A IA está presente em muitas áreas, desde a medicina até a indústria automotiva. No marketing digital, ela é usada para analisar grandes volumes de dados, automatizar tarefas repetitivas e fornecer insights valiosos sobre o comportamento do consumidor.

A Revolução da IA no Marketing Digital

Evolução Tecnológica

Nos últimos anos, a IA evoluiu rapidamente, tornando-se uma ferramenta essencial para os profissionais de marketing. As empresas agora podem usar algoritmos avançados para prever tendências, otimizar campanhas publicitárias e melhorar a experiência do cliente.

Impacto nos Processos de Marketing

A IA transformou processos tradicionais de marketing, permitindo uma abordagem mais eficiente e orientada por dados. As estratégias de marketing digital agora podem ser ajustadas em tempo real, com base em análises precisas e preditivas.

Benefícios da IA no Marketing Digital

Automatização de Tarefas

A IA permite a automatização de tarefas repetitivas, como a gestão de campanhas de e-mail marketing, publicação em redes sociais e atendimento ao cliente. Isso libera os profissionais de marketing para se concentrarem em atividades estratégicas.

Análise de Dados Avançada

Com a IA, é possível analisar grandes volumes de dados de forma rápida e precisa. Isso ajuda a identificar padrões e tendências, permitindo uma tomada de decisão mais informada e estratégica.

Personalização e Segmentação

A IA torna possível a personalização em escala, oferecendo experiências individualizadas para cada cliente. Isso inclui desde recomendações de produtos até conteúdos personalizados, baseados no comportamento e nas preferências do usuário.

Ferramentas de IA para Marketing Digital

Plataformas de Análise de Dados

Ferramentas como Google Analytics, Adobe Analytics e plataformas de Big Data permitem a análise de grandes volumes de dados, proporcionando insights valiosos sobre o comportamento do consumidor e a eficácia das campanhas.

Sistemas de CRM Inteligentes

Sistemas de CRM (Customer Relationship Management) inteligentes, como Salesforce e HubSpot, utilizam IA para automatizar e otimizar a gestão de relacionamentos com clientes, desde a prospecção até a retenção.

Chatbots e Assistentes Virtuais

Os chatbots e assistentes virtuais, como o ChatGPT, são capazes de interagir com os clientes em tempo real, respondendo a perguntas, resolvendo problemas e proporcionando uma experiência personalizada.

Estratégias de Marketing com IA

SEO e IA

A IA pode otimizar estratégias de SEO, analisando dados de pesquisa e comportamento do usuário para identificar as melhores palavras-chave e criar conteúdo relevante. Ferramentas como SEMrush e Ahrefs utilizam IA para oferecer insights valiosos.

Publicidade Programática

A publicidade programática utiliza algoritmos de IA para automatizar a compra de espaços publicitários, garantindo que os anúncios sejam exibidos para o público-alvo certo, no momento certo. Isso aumenta a eficiência e a eficácia das campanhas publicitárias.

Marketing de Conteúdo com IA

A IA pode ajudar na criação de conteúdo, identificando tópicos relevantes, gerando ideias e até mesmo escrevendo textos. Ferramentas como Jasper.ai e Copy.ai utilizam IA para auxiliar na criação de conteúdo de alta qualidade.

Automatização de Campanhas de E-mail Marketing

Segmentação Inteligente

A IA permite uma segmentação mais precisa dos contatos, identificando grupos com base em comportamento, preferências e histórico de compras. Isso resulta em campanhas de e-mail mais relevantes e eficazes.

Personalização de Mensagens

Com a IA, é possível personalizar as mensagens de e-mail em escala, oferecendo conteúdos e ofertas adaptadas a cada destinatário. Isso aumenta a taxa de abertura e engajamento das campanhas.

Análise Preditiva em Marketing

Previsão de Tendências de Mercado

A análise preditiva utiliza IA para prever tendências de mercado, identificando padrões e comportamentos que indicam mudanças futuras. Isso permite que as empresas se adaptem rapidamente às novas condições de mercado.

Análise de Comportamento do Consumidor

A IA pode analisar o comportamento do consumidor em tempo real, oferecendo insights sobre suas preferências, hábitos de compra e interações com a marca. Isso ajuda a personalizar a experiência do cliente e aumentar a fidelização.

IA e Experiência do Usuário

Personalização de Conteúdo

A IA permite a personalização do conteúdo em tempo real, oferecendo aos usuários uma experiência única e relevante. Isso inclui desde recomendações de produtos até conteúdos adaptados aos interesses do usuário.

Recomendações de Produtos

Sistemas de recomendação, como os utilizados pela Amazon e Netflix, utilizam IA para sugerir produtos e conteúdos com base no comportamento e nas preferências do usuário, aumentando as chances de conversão e retenção.

Casos de Sucesso: IA no Marketing Digital

Empresas que Usaram IA com Sucesso

Empresas como Amazon, Netflix e Spotify são exemplos de sucesso no uso da IA no marketing digital. Elas utilizam algoritmos avançados para personalizar a experiência do usuário e otimizar suas estratégias de marketing.

Resultados Obtidos

Essas empresas conseguiram aumentar significativamente suas taxas de conversão, retenção de clientes e satisfação do usuário, demonstrando o poder da IA no marketing digital.

Desafios e Limitações da IA no Marketing

Problemas de Privacidade e Ética

O uso da IA no marketing digital levanta questões de privacidade e ética. É importante garantir que os dados dos usuários sejam protegidos e que as práticas de marketing sejam transparentes e justas.

Dependência de Dados de Qualidade

A eficácia da IA depende da qualidade dos dados disponíveis. Dados imprecisos ou incompletos podem levar a resultados inadequados, prejudicando as estratégias de marketing.

Futuro do Marketing Digital com IA

Tendências Emergentes

O futuro do marketing digital com IA inclui tendências como a hiperpersonalização, a análise preditiva avançada e a integração de IA com tecnologias emergentes, como realidade aumentada e virtual.

Inovações Esperadas

Espera-se que a IA continue a evoluir, trazendo inovações que tornarão as estratégias de marketing digital ainda mais eficazes e personalizadas, oferecendo experiências únicas e envolventes para os usuários.

Como Implementar IA na sua Estratégia de Marketing

Passos Iniciais

Para implementar a IA na sua estratégia de marketing, comece identificando as áreas onde ela pode trazer mais benefícios, como análise de dados, personalização e automação de tarefas. Invista em ferramentas e plataformas de IA e capacite sua equipe para utilizá-las de forma eficaz.

Ferramentas Recomendadas

Utilize ferramentas de IA como Google Analytics, HubSpot, Salesforce, SEMrush e Ahrefs para otimizar suas estratégias de marketing digital. Essas ferramentas oferecem uma variedade de recursos para análise de dados, personalização e automação.

Boas Práticas e Dicas

Maximizando o Potencial da IA

Para maximizar o potencial da IA, utilize dados de qualidade, mantenha-se atualizado com as tendências e inovações, e adapte suas estratégias com base nos insights obtidos. Experimente e teste diferentes abordagens para encontrar o que funciona melhor para sua empresa.

Evitar Armadilhas Comuns

Evite armadilhas comuns, como a dependência excessiva de IA sem considerar o fator humano, e garanta que suas práticas de marketing sejam éticas e transparentes. Lembre-se de que a IA é uma ferramenta poderosa, mas deve ser usada de forma responsável.

Conclusão

A inteligência artificial está transformando o marketing digital, oferecendo novas oportunidades para personalização, automação e análise de dados. Ao implementar IA na sua estratégia de marketing, você pode melhorar a eficiência, aumentar a satisfação do cliente e alcançar melhores resultados. Esteja preparado para os desafios e aproveite as oportunidades que a IA oferece para revolucionar o seu marketing digital.

Perguntas Frequentes

O que é inteligência artificial no marketing digital?

A inteligência artificial no marketing digital refere-se ao uso de algoritmos e tecnologias avançadas para automatizar tarefas, analisar dados e personalizar a experiência do cliente.

Quais são os benefícios da IA no marketing digital?

Entre os benefícios estão a automatização de tarefas, análise de dados avançada, personalização e segmentação, além de previsões mais precisas sobre o comportamento do consumidor.

Como a IA pode melhorar a experiência do usuário?

A IA pode personalizar o conteúdo, oferecer recomendações de produtos e adaptar a experiência do usuário com base em suas preferências e comportamento.

Quais são as principais ferramentas de IA para marketing digital?

Algumas das principais ferramentas incluem Google Analytics, HubSpot, Salesforce, SEMrush, Ahrefs, Jasper.ai e Copy.ai.

Quais são os desafios do uso da IA no marketing digital?

Os desafios incluem questões de privacidade e ética, dependência de dados de qualidade e a necessidade de garantir que as práticas de marketing sejam transparentes e justas.

Quer alcançar o sucesso com o marketing digital?

Conte com a nossa expertise para ajudar o seu negócio!

Entre em contato com a gente!

Agradecemos a sua atenção e acompanhe nossos posts! #seo10digital – SEO10 Projetos Digitais.

Para ficar por dentro do mundo digital, acesse as nossas mídias sociais:

Facebook | Instagram

LEIA TAMBÉM:

A Importância dos sites de Listagem de Empresas para o Marketing Digital

Como Criar um Webinário para Atrair Novos Clientes

Dicas para Criar uma boa Landing Page

0 notes

Text

Imersão 01 | Novas dimensões: aplicações revolucionárias da IA Generativa

youtube

0:03 Olá seja muito bem-vindo e muito

0:06 bem-vinda à nossa imersão definitiva

0:08 sobre inteligência artificial da

0:09 faculdade XP Este é o segundo conteúdo

0:12 de uma série exclusiva com especialistas

0:14 em tecnologia que fazem A Iá acontecer

0:17 todos os dias essa imersão foi

0:19 idealizada exclusivamente para o seu

0:21 desenvolvimento profissional e para você

0:23 liderar efetivamente a transformação na

0:26 sua carreira e não apenas ficar parado

0:28 no tempo vendo a Inovação aconte então

0:30 prepare-se a inteligência artificial já

0:33 está revolucionando o nosso momento

0:34 presente e você não pode ficar para trás

0:37 por isso não perca essa chance de fazer

0:39 parte desse universo junto com a gente

0:42 no conteúdo de hoje o vice-presidente de

0:44 tecnologia e soluções na Microsoft

0:46 Brasil Cristiano fig irá abordar sobre

0:49 aplicações revolucionárias da ia

0:51 generativa mostrando cases de sucesso

0:53 aplicações na prática em diferentes

0:55 mercados usabilidade da ia na Microsoft

0:58 e muito mais não se esqueça de confirmar

1:00 a sua participação acessando o q code ao

1:03 final deste conteúdo para garantir o seu

1:06 certificado de conclusão porém lembre-se

1:09 é preciso confirmar a sua presença ao

1:11 final de todos os conteúdos para

1:13 garantir a sua certificação e agora

1:15 pegue já o seu caderno de anotações e

1:18 aproveite ao máximo mais esse conteúdo

1:20 que preparamos para você tenho certeza

1:22 que será muito enriquecedor para sua

1:24 carreira até breve E aí pessoal muito

1:26 feliz de estar aqui com a faculdade XP

1:28 para falar um pouco sobre inteligência

1:31 artificial generativa E como ela vai

1:33 mudar a sua vida e o seu negócio mas

1:36 antes da gente começar a falar de

1:37 Inteligência Artificial generativa deixa

1:40 eu te contar uma pequena história em

1:43 1973 a revista Science of America ela

1:46 fez uma pesquisa ela queria entender

1:48 depois de mapear todas as espécies de

1:51 animais qual era o animal mais eficiente

1:54 em locomoção ou seja o que gastava menos

1:56 energia de mover para um ponto a para um

1:58 ponto b

2:00 Você sabe qual animal ganhou o animal

2:02 que ganhou como mais eficiente foi o

2:04 abutre sim o abutre nós humanos a gente

2:07 não ficou no último da lista mas a gente

2:10 ficou quase no último da lista só que um

2:12 dos pesquisadores teve a ideia de ver

2:16 humano com bicicleta e ver nossa

2:19 eficiência energética em locomoção e o

2:21 que que aconteceu a gente foi pro

2:22 primeiro da lista E por que isso é

2:24 importante porque a humanidade ela cria

2:26 ferramentas para expandir nossa

2:28 capacidade exemplo o binóculo expande a

2:31 nossa visão e a inteligência artificial

2:34 vai expandir diversas outras capacidades

2:37 que a gente tem mas quando a gente fala

2:38 de ai apesar do Boom dos últimos 18

2:41 meses ela não tá aqui desde esses 18

2:44 meses ela já começou há muito tempo

2:45 atrás a inteligência artificial começou

2:47 na década de 50 e durante esse período a

2:50 gente teve vários invernos de

2:52 Inteligência Artificial que eram épocas

2:53 que a gente não tinha tanto investimento

2:56 e logo na sequência veio os Verões da

2:58 inteligência artificial aonde a gente

3:00 teve grandes inovações agora a gente tá

3:03 vivendo um grande verão com a

3:06 inteligência artificial generativa Eu

3:08 costumo dividir a inteligência

3:09 artificial no que eu chamo de ACDC para

3:11 você que gosta de rock antes do chat GPT

3:13 e depois do chat GPT e quando a gente

3:16 olha esse conceito de antes e depois a

3:18 gente tem duas grandes divisões a

3:20 inteligência artificial preditiva que já

3:22 tava idria no nosso contexto e a

3:24 inteligência artificial generativa que é

3:27 a que quebrou vários paradigmas um

3:28 desses paradigmas

3:30 foi que o chat GPT foi a primeira

3:32 solução que chegou em 100 milhões de

3:35 usuários em menos de 3 meses quando a

3:38 gente pensa no chat GPT muitas vezes a

3:40 gente tá pensando apenas no chat mas a

3:42 inteligência artificial generativa foi

3:45 muito além por exemplo você consegue

3:47 criar imagens através de textos ela gera

3:51 a imagem para você isso aquii é uma

3:52 ferramenta que a gente chama de D ali um

3:54 exemplo bem legal que a gente tem aqui é

3:56 essa mulher andando na rua essa imagem

3:59 não existe essa pessoa não existe ela

4:01 foi gerada através de um prompt pro GPT

4:05 no caso pro dali e hoje essa tecnologia

4:08 já tá disponível para vocês por exemplo

4:10 dentro do bring Creator você pode entrar

4:12 dentro do bring Creator e está gerando

4:15 as suas imagens através da Inteligência

4:18 Artificial generativa e para que que eu

4:20 posso estar utilizando esse tipo de

4:21 tecnologia não é só para criar cartões

4:23 de natal ou de aniversário hoje várias

4:26 empresas já utilizam esse tipo de

4:29 Tecnologia desde a criação de conteúdo

4:32 personalizado indo para educação e até

4:35 tem estilistas utilizando esse tipo de

4:37 tecnologia pra moda um outro exemplo que

4:40 muitas empresas estão utilizando é pra

4:42 geração de layout por exemplo eu posso

4:43 chegar no Prom e falar quero fazer uma

4:45 padaria e descrever a minha padaria e

4:48 ele vai me gerar alguns casos de uso

4:50 algumas imagens como sugestão isso na

4:52 teoria super legal né mas agora a gente

4:55 também já tem clientes na prática

4:56 fazendo isso e são casos de sucesso uma

4:59 outra ação da Inteligência Artificial

5:01 generativa é o que a gente chama de Out

5:03 Painting que que é isso Você tem uma

5:05 figura e você quer colocarla num

5:07 contexto nesse caso aqui a gente tem uma

5:09 pintura de Verner super famosa só que

5:11 ela tá muito fora de contexto e a gente

5:13 pediu pro EA generativo colocarla no

5:16 contexto aonde você acha que essa pessoa

5:17 tá inserida aqui neste caso ele gerou

5:20 uma imagem com uma pessoa inserida numa

5:21 cozinha mas você pode ver que o ambiente

5:24 que ela está aqui no na imagem gerada é

5:27 exatamente coligado né muito próximo à

5:30 imagem original uma outra utilização é

5:33 para gerar imagens tipo fotorealismo

5:35 essa daqui é um quadro foi um dos

5:37 primeiros quadros de fotorrealismo da

5:39 década de 80 e eu quis fazer alguns

5:42 testes utilizando eii generativo minha

5:45 esposa não gostou muito que minha casa

5:46 tá cheia de dinossauro e o resultado

5:49 ficou Fantástico e com e generativo você

5:51 não tira somente fotos hoje em dia você

5:54 já tem soluções que geram música como

5:57 essa ópera rock aqui falando de

6:05 [Música]

6:14 e não é só na geração de imagem que o Ei

6:17 generativo tá impactando o nosso dia a

6:18 dia geração de vídeo também por exemplo

6:21 esse take foi completamente feito

6:22 através de um promot esse lugar Apesar

6:25 de muito bonito ele não existe ele é uma

6:28 criação da Inteligência Artificial e não

6:30 é somente inem Takes que a gente tem

6:32 feito muito eh utilização de ai

6:34 generativa produções de cinema Por

6:36 exemplo essa moça andando numa rua foi

6:39 feita completamente por um promot ou até

6:42 cenários mais futurísticos como este

6:44 robô agora que a gente viu alguns

6:46 exemplos do Poder do ai generativo eu

6:49 queria falar para vocês sobre três

6:51 pilares como a Microsoft enxerga

6:54 Inteligência Artificial primeiro Pilar é

6:56 como a gente empodera os desenvolvedores

6:58 o segundo Pilar é como a gente empodera

7:01 as organizações e o terceiro Pilar como

7:03 a gente empodera a sociedade como um

7:05 todo Vamos explorar cada um desses

7:07 Pilares Mas o que eu queria comentar com

7:09 vocês que a Microsoft ela vai muito além

7:12 do chat GPT a gente tem uma suí de

7:15 Inteligência Artificial que entrega

7:17 tanto a inteligência artificial

7:19 preditiva quanto a inteligência

7:22 artificial generativa e nossos

7:24 investimentos em Inteligência Artificial

7:26 vem muito antes da nossa parceria com

7:28 openi por exemplo exemp em 2016 a gente

7:31 já tinha paridade humana com visão

7:34 reconhecimento de objeto em 2017 e 18 a

7:38 gente teve grandes breakthroughs sobre

7:40 fala reconhecimento de voz e em 2018 a

7:44 gente já teve um Break TR de paridade

7:46 humana de reconhecimento e análise de

7:49 texto vamos falar um pouco sobre os

7:51 tipos de algoritmos um exemplo algoritmo

7:53 de visão computacional a gente tem

7:56 vários tipos de algoritmos por exemplo

7:57 para detecção e reconhecimento de

8:00 objetos e como é que você utiliza esse

8:01 tipo de tecnologia no seu dia a dia

8:03 pensa que você é um varegista você tem

8:05 suas prateleiras com vários produtos se

8:08 tiver um produto faltando esse tipo de

8:10 tecnologia pode te avisar para você

8:12 repor e não perder vendas e não é só

8:14 para fotos que você pode utilizar esse

8:16 tipo de tecnologia você pode utilizar

8:17 também para análise de vídeos por

8:19 exemplo a gente tem uma loja de

8:21 conveniência onde alguém acidentalmente

8:23 derrubou um produto no chão isso pode

8:26 gerar um acidente então você pode ter

8:28 esse tipo de tecnologia olhando sua

8:31 câmera analisando as imagens e avisando

8:33 ó tem um produto no chão cuidado que

8:35 alguém pode cair e isso acaba te

8:37 evitando processos e outros tipos de e

8:41 prejuízos agora que a gente viu alguns

8:43 exemplos de ai preditiva tanto ela

8:46 quanto a generativa tem que ser

8:49 utilizadas com responsabilidade e a

8:51 Microsoft ela tem um Framework sobre ai

8:54 responsável para garantir que nossa

8:57 utilização e desenvolvimento de produto

8:59 tá utilizando os melhores padrões de

9:02 segurança e ética do mercado por exemplo

9:05 a gente criou várias camadas de

9:07 mitigação para garantir a segurança da

9:10 nossa Inteligência Artificial essa

9:12 camada a gente pode dividir ela em duas

9:14 etapas uma é a etapa da plataforma ou

9:17 seja aonde esse modelo tá inserido e a

9:21 segunda etapa é a etapa do usuário né a

9:24 segunda camada é a camada do usuário ou

9:26 seja como você consome esse modelo para

9:28 Facil tá eu quis fazer um fluxograma que

9:32 explica desde a hora que você começa a

9:34 falar com a inteligência artificial até

9:37 a hora que ela responde nesse fluxograma

9:40 você pode ver que a gente tem quatro

9:42 grandes etapas de validação a gente

9:44 divide em três grandes Pilares

9:46 categorias e dentro dessas categorias a

9:48 gente tem ódio conteúdo sexual eh

9:52 automutilação violência a gente tem uma

9:54 análise de texto e de imagem e com isso

9:57 a gente devolve um score de risco e a

9:59 nossa inteligência nossas camadas de

10:01 mitigação acabam tratando para você não

10:04 ser impactar agora que a gente já viu

10:06 alguns exemplos de como a Microsoft

10:08 protege seus dados vamos falar um pouco

10:10 mais sobre os casos de uso Como Eu

10:12 dividi em três grandes Pilares vamos

10:14 começar pelo primeiro que é como a gente

10:16 empodera os desenvolvedores a serem mais

10:19 produtivo a gente lançou juntamente com

10:21 o github o que a gente chama de CoPilot

10:24 e o que que é esse CoPilot ele é um

10:26 assistente que ajuda o desenvolvedor a a

10:29 ser mais produtivo se você tiver dois

10:31 times de desenvolvimento um utilizando

10:34 CoPilot e o outro não utilizando CoPilot

10:37 eu aposto com você que o time utilizando

10:40 CoPilot vai ser entre 50 a 70% mais

10:43 produtivo Esse é o bitmark que a gente

10:44 tem escutado do nossos clientes como é

10:46 que funciona o CoPilot para os

10:48 desenvolvedores ele é uma plataforma que

10:50 utiliza Inteligência Artificial

10:51 generativa a gente pode focar em três

10:54 grandes Pilares primeiro geração de

10:55 código ele consegue gerar código em

10:58 diversos essas linguagens para facilitar

11:01 o seu dia a dia pensa que você quer

11:03 fazer uma validação de password que é

11:04 uma função relativamente simples mas que

11:07 dá um trabalho de você codificar ela

11:09 pode gerar para você e você utiliza esse

11:11 tempo para ser mais produtivo em outras

11:13 áreas Agora pensa que você entrou numa

11:16 empresa que tem um monte de código

11:18 legado e não tem documentação é um caso

11:21 que é raro Mas acontece sempre né E o

11:24 CoPilot Você pode perguntar para ele me

11:26 explica esse código e ele gera toda

11:29 documentação e explicação do que esse

11:31 código faz um outro cenário muito

11:33 utilizado do CoPilot é quando você pega

11:37 uma aplicação legada sei lá escrita em

11:39 cobol e quer modernizar essa aplicação

11:42 você pode pedir para ele por favor tradu

11:45 essa aplicação em cobol para Python e

11:48 ele faz essa transição para vocês É

11:51 claro que a inteligência e atividade do

11:54 desenvolvedor vão ter que est ali para

11:57 fazer as suas devidas validações

11:59 mas o ganho de produtividade que você

12:01 tem com isso é fenomenal isso aqui a

12:03 gente tá pensando nos desenvolvedores

12:04 vamos dizer assim mais raiz mas a gente

12:07 também lançou uma forma de ajudar os

12:10 usuários que não t conhecimento de

12:13 desenvolvimento a poder criar suas

12:15 próprias aplicações utilizando

12:17 Inteligência Artificial generativa você

12:19 pode não saber programar mas

12:20 Possivelmente você sabe desenhar e com

12:23 um simples desenho você consegue com uma

12:26 foto mandando paraa Nossa inteligência

12:29 artificial criar uma

12:30 aplicação você consegue com a foto

12:33 escolher o que cada Campo que cada parte

12:36 da sua foto do seu desenho vai fazer e

12:39 com isso a gente consegue ajudar pessoas

12:41 que não tê conhecimento em tecnologia em

12:44 desenvolvimento a criar aplicações sem

12:47 precisar escrever nenhuma linha de

12:49 código e com isso serem mais produtivas

12:53 e transformar os seus negócios vamos

12:56 falar um pouco do nosso segundo Pilar

12:57 que como a gente ajuda à organizações

13:00 Então vamos ver algum dos casos de uso

13:03 mais típicos de ai generativa primeiro

13:06 mineração de conhecimento segundo o chat

13:09 auxiliar em Call Centers empresas hoje

13:11 têm utilizado a nossa plataforma para

13:14 criar os seus próprios CoPilot outro

13:16 exemplo como a gente viu anteriormente

13:18 geração de conteúdo e

13:19 hiperpersonalização só que esses são

13:21 exemplos clássicos pensa agora que você

13:24 é um fazendeiro Esse é um exemplo super

13:27 inovador sobre agricultura de precisão a

13:29 gente chama de Farm bits a gente utiliza

13:32 muito a parte de IOT ligada com a

13:35 inteligência artificial para dar

13:37 insights pros fazendeiros sobre tamanho

13:40 de produção possíveis pragas ou aonde

13:43 ele tá com Praga e qual o tipo de Praga

13:45 agora vamos ver alguns casos de clientes

13:47 aqui do Brasil casos públicos que você

13:49 pode pegar e entender um pouco melhor

13:51 vamos começar pela tento O que que a

13:53 tento fez ela criou um CoPilot um chat

13:57 para ajudar o os atendentes a serem mais

14:01 produtivos que que ela teve com isso um

14:03 aumento gigantesco na satisfação ela

14:06 teve 30% no aumento de produtividade e

14:09 20% na redução de erros operacionais

14:13 isso é um impacto Gigante Para qualquer

14:15 negócio ainda mais para um ccentro a

14:17 gente viu agora um caso de uso interno

14:20 vamos ver um caso de uso externo da

14:21 Brasil prévia que que a Brasil prev fez

14:23 ela criou um Brasil prev GPT como se

14:27 fosse um CoPilot para falar com seus

14:29 clientes muito utilizado na prospecção

14:32 de novos clientes qual foi o resultado

14:33 que a Brasil pré obteve com isso mais de

14:36 9 bilhões de negócios gerados em 2023 um

14:39 potencial gigantesco para frente e uma

14:42 conversão de novos clientes de 28% O que

14:46 representa que a cada quatro novos

14:48 prospects um vira novo cliente isso é um

14:52 ganho tremendo de produtividade vamos

14:54 ver mais um caso de uso externo que é o

14:57 picpay picpay criou uma solução para

15:00 atender seus clientes que que ele fez

15:01 ele criou um CoPilot que é a interface

15:05 de conversa com seus clientes hoje 100%

15:08 das conversas são feitas através da

15:11 Inteligência Artificial e a taxa de

15:13 conversão de entendimento é de 95% que

15:18 que ele teve aqui um aumento de NPS de

15:21 45% vamos ver agora alguns casos de uso

15:24 para outros segmentos por exemplo varejo

15:27 no varejo Você pode ter a hiper

15:29 personalização que que significa isso

15:30 você entrar na loja a reconhecer quem é

15:33 você qual o seu perfil de consumo e te

15:36 ofertar produtos e serviços que fazem

15:39 sentido com o que você busca

15:41 gerenciamento de estoque ativo entender

15:43 quais os produtos estão faltando Qual a

15:45 demanda de cada um desses produtos para

15:48 que você não perca vendas geração de

15:50 conteúdo como a gente viu com o Dali

15:52 experiência online como é que eu posso

15:54 criar assistentes virtuais inteligentes

15:57 para facilitar a experiência de compra e

16:00 atendimento e otimização e logística

16:02 como a inteligência artificial consegue

16:04 entender a demanda e a onde você tem

16:07 produto ele pode te falar em vez de você

16:09 pegar um produto desse centro de

16:11 distribuição pega desse que você vai ser

16:14 mais eficiente então esses são alguns

16:15 dos casos de uso que a gente pode olhar

16:17 para varejo porém existem vários outros

16:20 um outro setor que tá sendo super

16:21 impactado pelo EA generativo é o setor

16:23 de saúde quando a gente pensa em saúde a

16:25 gente vai muito além dos casos de usos

16:27 tradicionais indo desde a parte de

16:29 monitoramento de paciente descobrimento

16:31 de novos medicamentos e aceleração de

16:34 Diagnósticos hoje quando a gente olha

16:36 imagens como essa a gente acha que é

16:38 ficção mas não novos medicamentos já

16:41 estão sendo utilizados e criados através

16:44 do uso de Inteligência Artificial

16:46 generativa e tando aqui na faculdade XP

16:48 não tem como não falar de mercado

16:50 financeiro alguns usos de Inteligência

16:52 Artificial generativa vão desde a parte

16:54 de empoderamento dos agentes detecção de

16:57 fraude a análise preditiva e criação e

17:00 sugestão de Novos Produtos então o

17:03 mercado financeiro hoje é um dos

17:05 mercados que mais utilizam Inteligência

17:07 Artificial tanto a preditiva quanto a

17:10 generativa um outro setor muito

17:12 impactado é o de mídia e aqui eu vejo

17:16 dois grandes Pilares na parte de mídia

17:19 na parte de geração de conteúdo e

17:21 análise de conteúdo eu queria mostrar um

17:23 exemplo prático para vocês para você que

17:26 gosta de Fórmula 1 a fia disponibiliza

17:30 toda a sua parte de telemetria e

17:32 utilizando tecnologias como chat GPT a

17:35 gente conseguiu criar um modelo que lê

17:39 essa telemetria e gera conteúdo como se

17:42 fosse um narrador no Twitter isso da

17:44 aqui tá disponível para você se você

17:46 entrar no link aqui embaixo você pode

17:48 criar o seu próprio narrador de Fórmula

17:50 1 se você é usuário de Xbox e joga Forza

17:53 você consegue baixar também toda a sua

17:55 telemetria e ter uma tecnologia como

17:58 chat GPT falando um pouquinho do seu

18:00 jogo da sua corrida como é que você tá

18:02 indo então esse daqui são alguns

18:04 exemplos de como a gente pode utilizar

18:06 esse tipo de tecnologia para alavancar

18:09 negócios e impactar sua empresa Vamos

18:12 falar agora sobre o nosso terceiro Pilar

18:14 que é o Pilar de sociedade quando a

18:15 gente pensa nesse Pilar uma das

18:17 primeiras perguntas que vem na nossa

18:19 cabeça é será que Inteligência

18:21 Artificial vai roubar o meu emprego e eu

18:24 Parando para pensar sobre essa

18:26 pergunta eu não sei se essa pergunta é a

18:29 pergunta mais adequada e sim quem

18:32 conhece e utiliza melhor Inteligência

18:35 Artificial vai roubar meu emprego esse

18:38 eu acho que é um grande risco que as

18:40 pessoas que não estão se capacitando ou

18:48 recapito pra parte de capacitação quanto

18:51 de impacto sociais na parte de

18:54 capacitação que que eu queria tá

18:55 mostrando para vocês que hoje a gente

18:57 tem toda uma trilha sobre inteligência

18:59 artificial análise de dados sem custo e

19:02 disponível para qualquer pessoa no

19:04 mercado a gente já capacitou aqui no

19:06 Brasil com o programa Microsoft Mais

19:09 Brasil mais de 12 milhões de brasileiros

19:12 e mais de 2 milhões de brasileiros já

19:14 chegaram a tirar uma certificação mas

19:16 indo um pouco além A gente tem outras

19:18 soluções feitas com diversos parceiros

19:22 que impactam Nosa sociedade no dia a dia

19:25 por exemplo a parte de monitoramento de

19:28 de mudanças climáticas e de solo aqui a

19:31 gente utiliza imagens de satélite para

19:33 analisar riscos de alagamento

19:35 deslizamento entre outros um caso bem

19:38 interessante é um caso que a gente fez

19:39 com parceria com a vale para monitorar

19:42 desmatamento da floresta amazônica Esses

19:45 são apenas alguns exemplos de como a

19:46 inteligência artificial generativa pode

19:48 impactar desenvolvedores as empresas e a

19:51 sociedade como um todo e quando a gente

19:53 pensa no Poder da Inteligência

19:54 Artificial generativa ela vai muito além

19:57 da parte de criação de de código análise

20:00 de geração de imagem ela vai muito na

20:02 parte de empoderamento da sociedade por

20:05 quê pela primeira vez a gente não

20:08 precisa entender a máquina a máquina

20:11 acaba entendendo o que a gente quer por

20:13 a melhor linguagem é a linguagem natural

20:16 e a oportunidade é sua para liderar a

20:18 transformação utilizando Inteligência

20:20 Artificial como a gente viu a gente pode

20:23 impactar tanto os desenvolvedores quanto

20:26 as empresas quanto a sociedade e é o

20:28 poder da Inteligência Artificial pro seu

20:31 negócio é algo imenso que a gente

20:33 começou apenas a explorar Muito

20:36 obrigado e aí o que você achou dessa

20:39 super aula que tivemos há pouco foi

20:41 realmente enriquecedor ver na prática

20:43 com o Cristiano VP de tecnologia e

20:45 soluções da Microsoft Brasil como a ia

20:47 generativa pode estar em todo o nosso

20:49 cotidiano nas diversas soluções para o

20:52 comércio e na produção de conteúdo Com

20:54 certeza agora o seu repertório está mais

20:56 enriquecido e já está saindo na frente

20:59 de muita gente que está parada vendo a

21:01 Inovação acontecer e o nosso próximo

21:03 conteúdo será sobre as técnicas de

21:05 prompt engineer para potencializar a i

21:07 generativa com estrategista de jni da

21:10 aws e também professor da pós Engenharia

21:13 e arquitetura de dados Neilson crepalde

21:16 Não esqueça de confirmar a sua

21:17 participação neste conteúdo acessando o

21:20 q code que irá aparecer ao final desse

21:22 meu recado até a

21:27 próxima Y

0 notes

Text

Exemplo de um ataque de jailbreak e auto-lembrete de modo de sistema proposto pela equipe. Crédito: Inteligência da Máquina da Natureza (2023). DOI: 10.1038/s42256-023-00765-8.

Grandes modelos de linguagem (LLMs), modelos baseados em aprendizagem profunda treinados para gerar, resumir, traduzir e processar textos escritos, ganharam atenção significativa após o lançamento da plataforma conversacional ChatGPT da Open AI. Embora o ChatGPT e plataformas semelhantes sejam agora amplamente utilizados para uma vasta gama de aplicações, podem ser vulneráveis a um tipo específico de ataque cibernético que produz respostas tendenciosas, não fiáveis ou mesmo ofensivas.

Pesquisadores da Universidade de Ciência e Tecnologia de Hong Kong, da Universidade de Ciência e Tecnologia da China, da Universidade de Tsinghua e da Microsoft Research Asia realizaram recentemente um estudo investigando o impacto potencial desses ataques e técnicas que poderiam proteger os modelos contra eles. Deles papelpublicado em Inteligência da Máquina da Naturezaapresenta uma nova técnica inspirada na psicologia que pode ajudar a proteger o ChatGPT e plataformas de conversação semelhantes baseadas em LLM contra ataques cibernéticos.

“ChatGPT é uma ferramenta de inteligência artificial de impacto social com milhões de usuários e integração em produtos como o Bing”, escrevem Yueqi Xie, Jingwei Yi e seus colegas em seu artigo. “No entanto, o surgimento fuga de presos ataques ameaça notavelmente seu uso responsável e seguro. Os ataques de jailbreak usam avisos adversários para contornar as salvaguardas éticas do ChatGPT e gerar respostas prejudiciais."

O objetivo principal do trabalho recente de Xie, Yi e seus colegas foi destacar o impacto que os ataques de jailbreak podem ter no ChatGPT e introduzir estratégias de defesa viáveis contra esses ataques. Os ataques de jailbreak exploram essencialmente as vulnerabilidades dos LLMs para contornar as restrições definidas pelos desenvolvedores e obter respostas de modelo que normalmente seriam restritas.

“Este artigo investiga os problemas graves, mas pouco explorados, criados pelos jailbreaks, bem como possíveis técnicas defensivas”, explicam Xie, Yi e seus colegas em seu artigo. “Introduzimos um conjunto de dados de jailbreak com vários tipos de prompts de jailbreak e instruções maliciosas.”

Os pesquisadores primeiro compilaram um conjunto de dados incluindo 580 exemplos de prompts de jailbreak projetados para contornar restrições que impedem o ChatGPT de fornecer respostas consideradas “imorais”. Isto inclui textos não confiáveis que podem alimentar desinformação, bem como conteúdo tóxico ou abusivo.

Quando testaram o ChatGPT nesses prompts de jailbreak, descobriram que muitas vezes ele caía em sua “armadilha”, produzindo o conteúdo malicioso e antiético solicitado. Xie, Yi e seus colegas decidiram então desenvolver uma técnica simples, mas eficaz, que pudesse proteger o ChatGPT contra ataques de jailbreak cuidadosamente adaptados.

A técnica que criaram inspira-se no conceito psicológico de auto-lembretes, cutucadas que podem ajudar as pessoas a lembrarem-se de tarefas que precisam de completar, de eventos aos quais deveriam participar, e assim por diante. A abordagem de defesa dos pesquisadores, chamada de auto-lembrete no modo de sistema, é projetada de forma semelhante para lembrar ao Chat-GPT que as respostas que ele fornece devem seguir diretrizes específicas.

“Essa técnica encapsula a consulta do usuário em um prompt do sistema que lembra o ChatGPT de responder com responsabilidade”, escrevem os pesquisadores. “Resultados experimentais demonstram que os auto-lembretes reduzem significativamente a taxa de sucesso de ataques de jailbreak contra ChatGPT de 67,21% para 19,34%.”

Até agora, os investigadores testaram a eficácia da sua técnica utilizando o conjunto de dados que criaram e descobriram que alcançou resultados promissores, reduzindo a taxa de sucesso dos ataques, embora não prevenindo todos eles.

No futuro, esta nova técnica poderá ser melhorada ainda mais para reduzir a vulnerabilidade dos LLMs a estes ataques, ao mesmo tempo que também pode inspirar o desenvolvimento de outras estratégias de defesa semelhantes.

“Nosso trabalho documenta sistematicamente as ameaças representadas por ataques de jailbreak, apresenta e analisa um conjunto de dados para avaliar intervenções defensivas e propõe a técnica de auto-lembrete de inspiração psicológica que pode mitigar de forma eficiente e eficaz contra jailbreaks sem treinamento adicional”, resumem os pesquisadores em seu artigo.

Mais Informações: Yueqi Xie et al, Defendendo ChatGPT contra ataque de jailbreak por meio de auto-lembretes, Inteligência da Máquina da Natureza (2023). DOI: 10.1038/s42256-023-00765-8.

© 2024 Science X Network

Citação: Uma técnica simples para defender o ChatGPT contra ataques de jailbreak (2024, 18 de janeiro) recuperada em 12 de maio de 2024 em https://techxplore.com/news/2024-01-simple-technique-defend-chatgpt-jailbreak.html

Este documento está sujeito a direitos autorais. Além de qualquer negociação justa para fins de estudo ou pesquisa privada, nenhuma parte pode ser reproduzida sem permissão por escrito. O conteúdo é fornecido apenas para fins informativos.

https://w3b.com.br/uma-tecnica-simples-para-defender-o-chatgpt-contra-ataques-de-jailbreak/?feed_id=6253&_unique_id=6660f7020a482

0 notes

Text

Exemplo de um ataque de jailbreak e auto-lembrete de modo de sistema proposto pela equipe. Crédito: Inteligência da Máquina da Natureza (2023). DOI: 10.1038/s42256-023-00765-8.

Grandes modelos de linguagem (LLMs), modelos baseados em aprendizagem profunda treinados para gerar, resumir, traduzir e processar textos escritos, ganharam atenção significativa após o lançamento da plataforma conversacional ChatGPT da Open AI. Embora o ChatGPT e plataformas semelhantes sejam agora amplamente utilizados para uma vasta gama de aplicações, podem ser vulneráveis a um tipo específico de ataque cibernético que produz respostas tendenciosas, não fiáveis ou mesmo ofensivas.

Pesquisadores da Universidade de Ciência e Tecnologia de Hong Kong, da Universidade de Ciência e Tecnologia da China, da Universidade de Tsinghua e da Microsoft Research Asia realizaram recentemente um estudo investigando o impacto potencial desses ataques e técnicas que poderiam proteger os modelos contra eles. Deles papelpublicado em Inteligência da Máquina da Naturezaapresenta uma nova técnica inspirada na psicologia que pode ajudar a proteger o ChatGPT e plataformas de conversação semelhantes baseadas em LLM contra ataques cibernéticos.

“ChatGPT é uma ferramenta de inteligência artificial de impacto social com milhões de usuários e integração em produtos como o Bing”, escrevem Yueqi Xie, Jingwei Yi e seus colegas em seu artigo. “No entanto, o surgimento fuga de presos ataques ameaça notavelmente seu uso responsável e seguro. Os ataques de jailbreak usam avisos adversários para contornar as salvaguardas éticas do ChatGPT e gerar respostas prejudiciais."

O objetivo principal do trabalho recente de Xie, Yi e seus colegas foi destacar o impacto que os ataques de jailbreak podem ter no ChatGPT e introduzir estratégias de defesa viáveis contra esses ataques. Os ataques de jailbreak exploram essencialmente as vulnerabilidades dos LLMs para contornar as restrições definidas pelos desenvolvedores e obter respostas de modelo que normalmente seriam restritas.

“Este artigo investiga os problemas graves, mas pouco explorados, criados pelos jailbreaks, bem como possíveis técnicas defensivas”, explicam Xie, Yi e seus colegas em seu artigo. “Introduzimos um conjunto de dados de jailbreak com vários tipos de prompts de jailbreak e instruções maliciosas.”

Os pesquisadores primeiro compilaram um conjunto de dados incluindo 580 exemplos de prompts de jailbreak projetados para contornar restrições que impedem o ChatGPT de fornecer respostas consideradas “imorais”. Isto inclui textos não confiáveis que podem alimentar desinformação, bem como conteúdo tóxico ou abusivo.

Quando testaram o ChatGPT nesses prompts de jailbreak, descobriram que muitas vezes ele caía em sua “armadilha”, produzindo o conteúdo malicioso e antiético solicitado. Xie, Yi e seus colegas decidiram então desenvolver uma técnica simples, mas eficaz, que pudesse proteger o ChatGPT contra ataques de jailbreak cuidadosamente adaptados.

A técnica que criaram inspira-se no conceito psicológico de auto-lembretes, cutucadas que podem ajudar as pessoas a lembrarem-se de tarefas que precisam de completar, de eventos aos quais deveriam participar, e assim por diante. A abordagem de defesa dos pesquisadores, chamada de auto-lembrete no modo de sistema, é projetada de forma semelhante para lembrar ao Chat-GPT que as respostas que ele fornece devem seguir diretrizes específicas.

“Essa técnica encapsula a consulta do usuário em um prompt do sistema que lembra o ChatGPT de responder com responsabilidade”, escrevem os pesquisadores. “Resultados experimentais demonstram que os auto-lembretes reduzem significativamente a taxa de sucesso de ataques de jailbreak contra ChatGPT de 67,21% para 19,34%.”

Até agora, os investigadores testaram a eficácia da sua técnica utilizando o conjunto de dados que criaram e descobriram que alcançou resultados promissores, reduzindo a taxa de sucesso dos ataques, embora não prevenindo todos eles.

No futuro, esta nova técnica poderá ser melhorada ainda mais para reduzir a vulnerabilidade dos LLMs a estes ataques, ao mesmo tempo que também pode inspirar o desenvolvimento de outras estratégias de defesa semelhantes.

“Nosso trabalho documenta sistematicamente as ameaças representadas por ataques de jailbreak, apresenta e analisa um conjunto de dados para avaliar intervenções defensivas e propõe a técnica de auto-lembrete de inspiração psicológica que pode mitigar de forma eficiente e eficaz contra jailbreaks sem treinamento adicional”, resumem os pesquisadores em seu artigo.

Mais Informações: Yueqi Xie et al, Defendendo ChatGPT contra ataque de jailbreak por meio de auto-lembretes, Inteligência da Máquina da Natureza (2023). DOI: 10.1038/s42256-023-00765-8.

© 2024 Science X Network

Citação: Uma técnica simples para defender o ChatGPT contra ataques de jailbreak (2024, 18 de janeiro) recuperada em 12 de maio de 2024 em https://techxplore.com/news/2024-01-simple-technique-defend-chatgpt-jailbreak.html

Este documento está sujeito a direitos autorais. Além de qualquer negociação justa para fins de estudo ou pesquisa privada, nenhuma parte pode ser reproduzida sem permissão por escrito. O conteúdo é fornecido apenas para fins informativos.

0 notes

Text

Exemplo de um ataque de jailbreak e auto-lembrete de modo de sistema proposto pela equipe. Crédito: Inteligência da Máquina da Natureza (2023). DOI: 10.1038/s42256-023-00765-8.

Grandes modelos de linguagem (LLMs), modelos baseados em aprendizagem profunda treinados para gerar, resumir, traduzir e processar textos escritos, ganharam atenção significativa após o lançamento da plataforma conversacional ChatGPT da Open AI. Embora o ChatGPT e plataformas semelhantes sejam agora amplamente utilizados para uma vasta gama de aplicações, podem ser vulneráveis a um tipo específico de ataque cibernético que produz respostas tendenciosas, não fiáveis ou mesmo ofensivas.

Pesquisadores da Universidade de Ciência e Tecnologia de Hong Kong, da Universidade de Ciência e Tecnologia da China, da Universidade de Tsinghua e da Microsoft Research Asia realizaram recentemente um estudo investigando o impacto potencial desses ataques e técnicas que poderiam proteger os modelos contra eles. Deles papelpublicado em Inteligência da Máquina da Naturezaapresenta uma nova técnica inspirada na psicologia que pode ajudar a proteger o ChatGPT e plataformas de conversação semelhantes baseadas em LLM contra ataques cibernéticos.

“ChatGPT é uma ferramenta de inteligência artificial de impacto social com milhões de usuários e integração em produtos como o Bing”, escrevem Yueqi Xie, Jingwei Yi e seus colegas em seu artigo. “No entanto, o surgimento fuga de presos ataques ameaça notavelmente seu uso responsável e seguro. Os ataques de jailbreak usam avisos adversários para contornar as salvaguardas éticas do ChatGPT e gerar respostas prejudiciais."

O objetivo principal do trabalho recente de Xie, Yi e seus colegas foi destacar o impacto que os ataques de jailbreak podem ter no ChatGPT e introduzir estratégias de defesa viáveis contra esses ataques. Os ataques de jailbreak exploram essencialmente as vulnerabilidades dos LLMs para contornar as restrições definidas pelos desenvolvedores e obter respostas de modelo que normalmente seriam restritas.

“Este artigo investiga os problemas graves, mas pouco explorados, criados pelos jailbreaks, bem como possíveis técnicas defensivas”, explicam Xie, Yi e seus colegas em seu artigo. “Introduzimos um conjunto de dados de jailbreak com vários tipos de prompts de jailbreak e instruções maliciosas.”

Os pesquisadores primeiro compilaram um conjunto de dados incluindo 580 exemplos de prompts de jailbreak projetados para contornar restrições que impedem o ChatGPT de fornecer respostas consideradas “imorais”. Isto inclui textos não confiáveis que podem alimentar desinformação, bem como conteúdo tóxico ou abusivo.

Quando testaram o ChatGPT nesses prompts de jailbreak, descobriram que muitas vezes ele caía em sua “armadilha”, produzindo o conteúdo malicioso e antiético solicitado. Xie, Yi e seus colegas decidiram então desenvolver uma técnica simples, mas eficaz, que pudesse proteger o ChatGPT contra ataques de jailbreak cuidadosamente adaptados.

A técnica que criaram inspira-se no conceito psicológico de auto-lembretes, cutucadas que podem ajudar as pessoas a lembrarem-se de tarefas que precisam de completar, de eventos aos quais deveriam participar, e assim por diante. A abordagem de defesa dos pesquisadores, chamada de auto-lembrete no modo de sistema, é projetada de forma semelhante para lembrar ao Chat-GPT que as respostas que ele fornece devem seguir diretrizes específicas.

“Essa técnica encapsula a consulta do usuário em um prompt do sistema que lembra o ChatGPT de responder com responsabilidade”, escrevem os pesquisadores. “Resultados experimentais demonstram que os auto-lembretes reduzem significativamente a taxa de sucesso de ataques de jailbreak contra ChatGPT de 67,21% para 19,34%.”

Até agora, os investigadores testaram a eficácia da sua técnica utilizando o conjunto de dados que criaram e descobriram que alcançou resultados promissores, reduzindo a taxa de sucesso dos ataques, embora não prevenindo todos eles.

No futuro, esta nova técnica poderá ser melhorada ainda mais para reduzir a vulnerabilidade dos LLMs a estes ataques, ao mesmo tempo que também pode inspirar o desenvolvimento de outras estratégias de defesa semelhantes.

“Nosso trabalho documenta sistematicamente as ameaças representadas por ataques de jailbreak, apresenta e analisa um conjunto de dados para avaliar intervenções defensivas e propõe a técnica de auto-lembrete de inspiração psicológica que pode mitigar de forma eficiente e eficaz contra jailbreaks sem treinamento adicional”, resumem os pesquisadores em seu artigo.

Mais Informações: Yueqi Xie et al, Defendendo ChatGPT contra ataque de jailbreak por meio de auto-lembretes, Inteligência da Máquina da Natureza (2023). DOI: 10.1038/s42256-023-00765-8.

© 2024 Science X Network

Citação: Uma técnica simples para defender o ChatGPT contra ataques de jailbreak (2024, 18 de janeiro) recuperada em 12 de maio de 2024 em https://techxplore.com/news/2024-01-simple-technique-defend-chatgpt-jailbreak.html

Este documento está sujeito a direitos autorais. Além de qualquer negociação justa para fins de estudo ou pesquisa privada, nenhuma parte pode ser reproduzida sem permissão por escrito. O conteúdo é fornecido apenas para fins informativos.

0 notes

Text

Exemplo de um ataque de jailbreak e auto-lembrete de modo de sistema proposto pela equipe. Crédito: Inteligência da Máquina da Natureza (2023). DOI: 10.1038/s42256-023-00765-8.

Grandes modelos de linguagem (LLMs), modelos baseados em aprendizagem profunda treinados para gerar, resumir, traduzir e processar textos escritos, ganharam atenção significativa após o lançamento da plataforma conversacional ChatGPT da Open AI. Embora o ChatGPT e plataformas semelhantes sejam agora amplamente utilizados para uma vasta gama de aplicações, podem ser vulneráveis a um tipo específico de ataque cibernético que produz respostas tendenciosas, não fiáveis ou mesmo ofensivas.

Pesquisadores da Universidade de Ciência e Tecnologia de Hong Kong, da Universidade de Ciência e Tecnologia da China, da Universidade de Tsinghua e da Microsoft Research Asia realizaram recentemente um estudo investigando o impacto potencial desses ataques e técnicas que poderiam proteger os modelos contra eles. Deles papelpublicado em Inteligência da Máquina da Naturezaapresenta uma nova técnica inspirada na psicologia que pode ajudar a proteger o ChatGPT e plataformas de conversação semelhantes baseadas em LLM contra ataques cibernéticos.

“ChatGPT é uma ferramenta de inteligência artificial de impacto social com milhões de usuários e integração em produtos como o Bing”, escrevem Yueqi Xie, Jingwei Yi e seus colegas em seu artigo. “No entanto, o surgimento fuga de presos ataques ameaça notavelmente seu uso responsável e seguro. Os ataques de jailbreak usam avisos adversários para contornar as salvaguardas éticas do ChatGPT e gerar respostas prejudiciais."

O objetivo principal do trabalho recente de Xie, Yi e seus colegas foi destacar o impacto que os ataques de jailbreak podem ter no ChatGPT e introduzir estratégias de defesa viáveis contra esses ataques. Os ataques de jailbreak exploram essencialmente as vulnerabilidades dos LLMs para contornar as restrições definidas pelos desenvolvedores e obter respostas de modelo que normalmente seriam restritas.

“Este artigo investiga os problemas graves, mas pouco explorados, criados pelos jailbreaks, bem como possíveis técnicas defensivas”, explicam Xie, Yi e seus colegas em seu artigo. “Introduzimos um conjunto de dados de jailbreak com vários tipos de prompts de jailbreak e instruções maliciosas.”

Os pesquisadores primeiro compilaram um conjunto de dados incluindo 580 exemplos de prompts de jailbreak projetados para contornar restrições que impedem o ChatGPT de fornecer respostas consideradas “imorais”. Isto inclui textos não confiáveis que podem alimentar desinformação, bem como conteúdo tóxico ou abusivo.

Quando testaram o ChatGPT nesses prompts de jailbreak, descobriram que muitas vezes ele caía em sua “armadilha”, produzindo o conteúdo malicioso e antiético solicitado. Xie, Yi e seus colegas decidiram então desenvolver uma técnica simples, mas eficaz, que pudesse proteger o ChatGPT contra ataques de jailbreak cuidadosamente adaptados.

A técnica que criaram inspira-se no conceito psicológico de auto-lembretes, cutucadas que podem ajudar as pessoas a lembrarem-se de tarefas que precisam de completar, de eventos aos quais deveriam participar, e assim por diante. A abordagem de defesa dos pesquisadores, chamada de auto-lembrete no modo de sistema, é projetada de forma semelhante para lembrar ao Chat-GPT que as respostas que ele fornece devem seguir diretrizes específicas.

“Essa técnica encapsula a consulta do usuário em um prompt do sistema que lembra o ChatGPT de responder com responsabilidade”, escrevem os pesquisadores. “Resultados experimentais demonstram que os auto-lembretes reduzem significativamente a taxa de sucesso de ataques de jailbreak contra ChatGPT de 67,21% para 19,34%.”

Até agora, os investigadores testaram a eficácia da sua técnica utilizando o conjunto de dados que criaram e descobriram que alcançou resultados promissores, reduzindo a taxa de sucesso dos ataques, embora não prevenindo todos eles.

No futuro, esta nova técnica poderá ser melhorada ainda mais para reduzir a vulnerabilidade dos LLMs a estes ataques, ao mesmo tempo que também pode inspirar o desenvolvimento de outras estratégias de defesa semelhantes.

“Nosso trabalho documenta sistematicamente as ameaças representadas por ataques de jailbreak, apresenta e analisa um conjunto de dados para avaliar intervenções defensivas e propõe a técnica de auto-lembrete de inspiração psicológica que pode mitigar de forma eficiente e eficaz contra jailbreaks sem treinamento adicional”, resumem os pesquisadores em seu artigo.

Mais Informações: Yueqi Xie et al, Defendendo ChatGPT contra ataque de jailbreak por meio de auto-lembretes, Inteligência da Máquina da Natureza (2023). DOI: 10.1038/s42256-023-00765-8.

© 2024 Science X Network

Citação: Uma técnica simples para defender o ChatGPT contra ataques de jailbreak (2024, 18 de janeiro) recuperada em 12 de maio de 2024 em https://techxplore.com/news/2024-01-simple-technique-defend-chatgpt-jailbreak.html

Este documento está sujeito a direitos autorais. Além de qualquer negociação justa para fins de estudo ou pesquisa privada, nenhuma parte pode ser reproduzida sem permissão por escrito. O conteúdo é fornecido apenas para fins informativos.

0 notes

Text

Exemplo de um ataque de jailbreak e auto-lembrete de modo de sistema proposto pela equipe. Crédito: Inteligência da Máquina da Natureza (2023). DOI: 10.1038/s42256-023-00765-8.

Grandes modelos de linguagem (LLMs), modelos baseados em aprendizagem profunda treinados para gerar, resumir, traduzir e processar textos escritos, ganharam atenção significativa após o lançamento da plataforma conversacional ChatGPT da Open AI. Embora o ChatGPT e plataformas semelhantes sejam agora amplamente utilizados para uma vasta gama de aplicações, podem ser vulneráveis a um tipo específico de ataque cibernético que produz respostas tendenciosas, não fiáveis ou mesmo ofensivas.

Pesquisadores da Universidade de Ciência e Tecnologia de Hong Kong, da Universidade de Ciência e Tecnologia da China, da Universidade de Tsinghua e da Microsoft Research Asia realizaram recentemente um estudo investigando o impacto potencial desses ataques e técnicas que poderiam proteger os modelos contra eles. Deles papelpublicado em Inteligência da Máquina da Naturezaapresenta uma nova técnica inspirada na psicologia que pode ajudar a proteger o ChatGPT e plataformas de conversação semelhantes baseadas em LLM contra ataques cibernéticos.

“ChatGPT é uma ferramenta de inteligência artificial de impacto social com milhões de usuários e integração em produtos como o Bing”, escrevem Yueqi Xie, Jingwei Yi e seus colegas em seu artigo. “No entanto, o surgimento fuga de presos ataques ameaça notavelmente seu uso responsável e seguro. Os ataques de jailbreak usam avisos adversários para contornar as salvaguardas éticas do ChatGPT e gerar respostas prejudiciais."

O objetivo principal do trabalho recente de Xie, Yi e seus colegas foi destacar o impacto que os ataques de jailbreak podem ter no ChatGPT e introduzir estratégias de defesa viáveis contra esses ataques. Os ataques de jailbreak exploram essencialmente as vulnerabilidades dos LLMs para contornar as restrições definidas pelos desenvolvedores e obter respostas de modelo que normalmente seriam restritas.

“Este artigo investiga os problemas graves, mas pouco explorados, criados pelos jailbreaks, bem como possíveis técnicas defensivas”, explicam Xie, Yi e seus colegas em seu artigo. “Introduzimos um conjunto de dados de jailbreak com vários tipos de prompts de jailbreak e instruções maliciosas.”

Os pesquisadores primeiro compilaram um conjunto de dados incluindo 580 exemplos de prompts de jailbreak projetados para contornar restrições que impedem o ChatGPT de fornecer respostas consideradas “imorais”. Isto inclui textos não confiáveis que podem alimentar desinformação, bem como conteúdo tóxico ou abusivo.

Quando testaram o ChatGPT nesses prompts de jailbreak, descobriram que muitas vezes ele caía em sua “armadilha”, produzindo o conteúdo malicioso e antiético solicitado. Xie, Yi e seus colegas decidiram então desenvolver uma técnica simples, mas eficaz, que pudesse proteger o ChatGPT contra ataques de jailbreak cuidadosamente adaptados.

A técnica que criaram inspira-se no conceito psicológico de auto-lembretes, cutucadas que podem ajudar as pessoas a lembrarem-se de tarefas que precisam de completar, de eventos aos quais deveriam participar, e assim por diante. A abordagem de defesa dos pesquisadores, chamada de auto-lembrete no modo de sistema, é projetada de forma semelhante para lembrar ao Chat-GPT que as respostas que ele fornece devem seguir diretrizes específicas.

“Essa técnica encapsula a consulta do usuário em um prompt do sistema que lembra o ChatGPT de responder com responsabilidade”, escrevem os pesquisadores. “Resultados experimentais demonstram que os auto-lembretes reduzem significativamente a taxa de sucesso de ataques de jailbreak contra ChatGPT de 67,21% para 19,34%.”

Até agora, os investigadores testaram a eficácia da sua técnica utilizando o conjunto de dados que criaram e descobriram que alcançou resultados promissores, reduzindo a taxa de sucesso dos ataques, embora não prevenindo todos eles.

No futuro, esta nova técnica poderá ser melhorada ainda mais para reduzir a vulnerabilidade dos LLMs a estes ataques, ao mesmo tempo que também pode inspirar o desenvolvimento de outras estratégias de defesa semelhantes.

“Nosso trabalho documenta sistematicamente as ameaças representadas por ataques de jailbreak, apresenta e analisa um conjunto de dados para avaliar intervenções defensivas e propõe a técnica de auto-lembrete de inspiração psicológica que pode mitigar de forma eficiente e eficaz contra jailbreaks sem treinamento adicional”, resumem os pesquisadores em seu artigo.

Mais Informações: Yueqi Xie et al, Defendendo ChatGPT contra ataque de jailbreak por meio de auto-lembretes, Inteligência da Máquina da Natureza (2023). DOI: 10.1038/s42256-023-00765-8.

© 2024 Science X Network

Citação: Uma técnica simples para defender o ChatGPT contra ataques de jailbreak (2024, 18 de janeiro) recuperada em 12 de maio de 2024 em https://techxplore.com/news/2024-01-simple-technique-defend-chatgpt-jailbreak.html

Este documento está sujeito a direitos autorais. Além de qualquer negociação justa para fins de estudo ou pesquisa privada, nenhuma parte pode ser reproduzida sem permissão por escrito. O conteúdo é fornecido apenas para fins informativos.

0 notes

Text

Exemplo de um ataque de jailbreak e auto-lembrete de modo de sistema proposto pela equipe. Crédito: Inteligência da Máquina da Natureza (2023). DOI: 10.1038/s42256-023-00765-8.

Grandes modelos de linguagem (LLMs), modelos baseados em aprendizagem profunda treinados para gerar, resumir, traduzir e processar textos escritos, ganharam atenção significativa após o lançamento da plataforma conversacional ChatGPT da Open AI. Embora o ChatGPT e plataformas semelhantes sejam agora amplamente utilizados para uma vasta gama de aplicações, podem ser vulneráveis a um tipo específico de ataque cibernético que produz respostas tendenciosas, não fiáveis ou mesmo ofensivas.

Pesquisadores da Universidade de Ciência e Tecnologia de Hong Kong, da Universidade de Ciência e Tecnologia da China, da Universidade de Tsinghua e da Microsoft Research Asia realizaram recentemente um estudo investigando o impacto potencial desses ataques e técnicas que poderiam proteger os modelos contra eles. Deles papelpublicado em Inteligência da Máquina da Naturezaapresenta uma nova técnica inspirada na psicologia que pode ajudar a proteger o ChatGPT e plataformas de conversação semelhantes baseadas em LLM contra ataques cibernéticos.

“ChatGPT é uma ferramenta de inteligência artificial de impacto social com milhões de usuários e integração em produtos como o Bing”, escrevem Yueqi Xie, Jingwei Yi e seus colegas em seu artigo. “No entanto, o surgimento fuga de presos ataques ameaça notavelmente seu uso responsável e seguro. Os ataques de jailbreak usam avisos adversários para contornar as salvaguardas éticas do ChatGPT e gerar respostas prejudiciais."

O objetivo principal do trabalho recente de Xie, Yi e seus colegas foi destacar o impacto que os ataques de jailbreak podem ter no ChatGPT e introduzir estratégias de defesa viáveis contra esses ataques. Os ataques de jailbreak exploram essencialmente as vulnerabilidades dos LLMs para contornar as restrições definidas pelos desenvolvedores e obter respostas de modelo que normalmente seriam restritas.

“Este artigo investiga os problemas graves, mas pouco explorados, criados pelos jailbreaks, bem como possíveis técnicas defensivas”, explicam Xie, Yi e seus colegas em seu artigo. “Introduzimos um conjunto de dados de jailbreak com vários tipos de prompts de jailbreak e instruções maliciosas.”

Os pesquisadores primeiro compilaram um conjunto de dados incluindo 580 exemplos de prompts de jailbreak projetados para contornar restrições que impedem o ChatGPT de fornecer respostas consideradas “imorais”. Isto inclui textos não confiáveis que podem alimentar desinformação, bem como conteúdo tóxico ou abusivo.

Quando testaram o ChatGPT nesses prompts de jailbreak, descobriram que muitas vezes ele caía em sua “armadilha”, produzindo o conteúdo malicioso e antiético solicitado. Xie, Yi e seus colegas decidiram então desenvolver uma técnica simples, mas eficaz, que pudesse proteger o ChatGPT contra ataques de jailbreak cuidadosamente adaptados.

A técnica que criaram inspira-se no conceito psicológico de auto-lembretes, cutucadas que podem ajudar as pessoas a lembrarem-se de tarefas que precisam de completar, de eventos aos quais deveriam participar, e assim por diante. A abordagem de defesa dos pesquisadores, chamada de auto-lembrete no modo de sistema, é projetada de forma semelhante para lembrar ao Chat-GPT que as respostas que ele fornece devem seguir diretrizes específicas.

“Essa técnica encapsula a consulta do usuário em um prompt do sistema que lembra o ChatGPT de responder com responsabilidade”, escrevem os pesquisadores. “Resultados experimentais demonstram que os auto-lembretes reduzem significativamente a taxa de sucesso de ataques de jailbreak contra ChatGPT de 67,21% para 19,34%.”

Até agora, os investigadores testaram a eficácia da sua técnica utilizando o conjunto de dados que criaram e descobriram que alcançou resultados promissores, reduzindo a taxa de sucesso dos ataques, embora não prevenindo todos eles.

No futuro, esta nova técnica poderá ser melhorada ainda mais para reduzir a vulnerabilidade dos LLMs a estes ataques, ao mesmo tempo que também pode inspirar o desenvolvimento de outras estratégias de defesa semelhantes.

“Nosso trabalho documenta sistematicamente as ameaças representadas por ataques de jailbreak, apresenta e analisa um conjunto de dados para avaliar intervenções defensivas e propõe a técnica de auto-lembrete de inspiração psicológica que pode mitigar de forma eficiente e eficaz contra jailbreaks sem treinamento adicional”, resumem os pesquisadores em seu artigo.

Mais Informações: Yueqi Xie et al, Defendendo ChatGPT contra ataque de jailbreak por meio de auto-lembretes, Inteligência da Máquina da Natureza (2023). DOI: 10.1038/s42256-023-00765-8.

© 2024 Science X Network

Citação: Uma técnica simples para defender o ChatGPT contra ataques de jailbreak (2024, 18 de janeiro) recuperada em 12 de maio de 2024 em https://techxplore.com/news/2024-01-simple-technique-defend-chatgpt-jailbreak.html

Este documento está sujeito a direitos autorais. Além de qualquer negociação justa para fins de estudo ou pesquisa privada, nenhuma parte pode ser reproduzida sem permissão por escrito. O conteúdo é fornecido apenas para fins informativos.

0 notes

Text

Exemplo de um ataque de jailbreak e auto-lembrete de modo de sistema proposto pela equipe. Crédito: Inteligência da Máquina da Natureza (2023). DOI: 10.1038/s42256-023-00765-8.

Grandes modelos de linguagem (LLMs), modelos baseados em aprendizagem profunda treinados para gerar, resumir, traduzir e processar textos escritos, ganharam atenção significativa após o lançamento da plataforma conversacional ChatGPT da Open AI. Embora o ChatGPT e plataformas semelhantes sejam agora amplamente utilizados para uma vasta gama de aplicações, podem ser vulneráveis a um tipo específico de ataque cibernético que produz respostas tendenciosas, não fiáveis ou mesmo ofensivas.

Pesquisadores da Universidade de Ciência e Tecnologia de Hong Kong, da Universidade de Ciência e Tecnologia da China, da Universidade de Tsinghua e da Microsoft Research Asia realizaram recentemente um estudo investigando o impacto potencial desses ataques e técnicas que poderiam proteger os modelos contra eles. Deles papelpublicado em Inteligência da Máquina da Naturezaapresenta uma nova técnica inspirada na psicologia que pode ajudar a proteger o ChatGPT e plataformas de conversação semelhantes baseadas em LLM contra ataques cibernéticos.

“ChatGPT é uma ferramenta de inteligência artificial de impacto social com milhões de usuários e integração em produtos como o Bing”, escrevem Yueqi Xie, Jingwei Yi e seus colegas em seu artigo. “No entanto, o surgimento fuga de presos ataques ameaça notavelmente seu uso responsável e seguro. Os ataques de jailbreak usam avisos adversários para contornar as salvaguardas éticas do ChatGPT e gerar respostas prejudiciais."

O objetivo principal do trabalho recente de Xie, Yi e seus colegas foi destacar o impacto que os ataques de jailbreak podem ter no ChatGPT e introduzir estratégias de defesa viáveis contra esses ataques. Os ataques de jailbreak exploram essencialmente as vulnerabilidades dos LLMs para contornar as restrições definidas pelos desenvolvedores e obter respostas de modelo que normalmente seriam restritas.

“Este artigo investiga os problemas graves, mas pouco explorados, criados pelos jailbreaks, bem como possíveis técnicas defensivas”, explicam Xie, Yi e seus colegas em seu artigo. “Introduzimos um conjunto de dados de jailbreak com vários tipos de prompts de jailbreak e instruções maliciosas.”

Os pesquisadores primeiro compilaram um conjunto de dados incluindo 580 exemplos de prompts de jailbreak projetados para contornar restrições que impedem o ChatGPT de fornecer respostas consideradas “imorais”. Isto inclui textos não confiáveis que podem alimentar desinformação, bem como conteúdo tóxico ou abusivo.

Quando testaram o ChatGPT nesses prompts de jailbreak, descobriram que muitas vezes ele caía em sua “armadilha”, produzindo o conteúdo malicioso e antiético solicitado. Xie, Yi e seus colegas decidiram então desenvolver uma técnica simples, mas eficaz, que pudesse proteger o ChatGPT contra ataques de jailbreak cuidadosamente adaptados.

A técnica que criaram inspira-se no conceito psicológico de auto-lembretes, cutucadas que podem ajudar as pessoas a lembrarem-se de tarefas que precisam de completar, de eventos aos quais deveriam participar, e assim por diante. A abordagem de defesa dos pesquisadores, chamada de auto-lembrete no modo de sistema, é projetada de forma semelhante para lembrar ao Chat-GPT que as respostas que ele fornece devem seguir diretrizes específicas.

“Essa técnica encapsula a consulta do usuário em um prompt do sistema que lembra o ChatGPT de responder com responsabilidade”, escrevem os pesquisadores. “Resultados experimentais demonstram que os auto-lembretes reduzem significativamente a taxa de sucesso de ataques de jailbreak contra ChatGPT de 67,21% para 19,34%.”

Até agora, os investigadores testaram a eficácia da sua técnica utilizando o conjunto de dados que criaram e descobriram que alcançou resultados promissores, reduzindo a taxa de sucesso dos ataques, embora não prevenindo todos eles.

No futuro, esta nova técnica poderá ser melhorada ainda mais para reduzir a vulnerabilidade dos LLMs a estes ataques, ao mesmo tempo que também pode inspirar o desenvolvimento de outras estratégias de defesa semelhantes.

“Nosso trabalho documenta sistematicamente as ameaças representadas por ataques de jailbreak, apresenta e analisa um conjunto de dados para avaliar intervenções defensivas e propõe a técnica de auto-lembrete de inspiração psicológica que pode mitigar de forma eficiente e eficaz contra jailbreaks sem treinamento adicional”, resumem os pesquisadores em seu artigo.

Mais Informações: Yueqi Xie et al, Defendendo ChatGPT contra ataque de jailbreak por meio de auto-lembretes, Inteligência da Máquina da Natureza (2023). DOI: 10.1038/s42256-023-00765-8.

© 2024 Science X Network

Citação: Uma técnica simples para defender o ChatGPT contra ataques de jailbreak (2024, 18 de janeiro) recuperada em 12 de maio de 2024 em https://techxplore.com/news/2024-01-simple-technique-defend-chatgpt-jailbreak.html

Este documento está sujeito a direitos autorais. Além de qualquer negociação justa para fins de estudo ou pesquisa privada, nenhuma parte pode ser reproduzida sem permissão por escrito. O conteúdo é fornecido apenas para fins informativos.

0 notes

Text

Exemplo de um ataque de jailbreak e auto-lembrete de modo de sistema proposto pela equipe. Crédito: Inteligência da Máquina da Natureza (2023). DOI: 10.1038/s42256-023-00765-8.

Grandes modelos de linguagem (LLMs), modelos baseados em aprendizagem profunda treinados para gerar, resumir, traduzir e processar textos escritos, ganharam atenção significativa após o lançamento da plataforma conversacional ChatGPT da Open AI. Embora o ChatGPT e plataformas semelhantes sejam agora amplamente utilizados para uma vasta gama de aplicações, podem ser vulneráveis a um tipo específico de ataque cibernético que produz respostas tendenciosas, não fiáveis ou mesmo ofensivas.

Pesquisadores da Universidade de Ciência e Tecnologia de Hong Kong, da Universidade de Ciência e Tecnologia da China, da Universidade de Tsinghua e da Microsoft Research Asia realizaram recentemente um estudo investigando o impacto potencial desses ataques e técnicas que poderiam proteger os modelos contra eles. Deles papelpublicado em Inteligência da Máquina da Naturezaapresenta uma nova técnica inspirada na psicologia que pode ajudar a proteger o ChatGPT e plataformas de conversação semelhantes baseadas em LLM contra ataques cibernéticos.

“ChatGPT é uma ferramenta de inteligência artificial de impacto social com milhões de usuários e integração em produtos como o Bing”, escrevem Yueqi Xie, Jingwei Yi e seus colegas em seu artigo. “No entanto, o surgimento fuga de presos ataques ameaça notavelmente seu uso responsável e seguro. Os ataques de jailbreak usam avisos adversários para contornar as salvaguardas éticas do ChatGPT e gerar respostas prejudiciais."

O objetivo principal do trabalho recente de Xie, Yi e seus colegas foi destacar o impacto que os ataques de jailbreak podem ter no ChatGPT e introduzir estratégias de defesa viáveis contra esses ataques. Os ataques de jailbreak exploram essencialmente as vulnerabilidades dos LLMs para contornar as restrições definidas pelos desenvolvedores e obter respostas de modelo que normalmente seriam restritas.

“Este artigo investiga os problemas graves, mas pouco explorados, criados pelos jailbreaks, bem como possíveis técnicas defensivas”, explicam Xie, Yi e seus colegas em seu artigo. “Introduzimos um conjunto de dados de jailbreak com vários tipos de prompts de jailbreak e instruções maliciosas.”

Os pesquisadores primeiro compilaram um conjunto de dados incluindo 580 exemplos de prompts de jailbreak projetados para contornar restrições que impedem o ChatGPT de fornecer respostas consideradas “imorais”. Isto inclui textos não confiáveis que podem alimentar desinformação, bem como conteúdo tóxico ou abusivo.

Quando testaram o ChatGPT nesses prompts de jailbreak, descobriram que muitas vezes ele caía em sua “armadilha”, produzindo o conteúdo malicioso e antiético solicitado. Xie, Yi e seus colegas decidiram então desenvolver uma técnica simples, mas eficaz, que pudesse proteger o ChatGPT contra ataques de jailbreak cuidadosamente adaptados.

A técnica que criaram inspira-se no conceito psicológico de auto-lembretes, cutucadas que podem ajudar as pessoas a lembrarem-se de tarefas que precisam de completar, de eventos aos quais deveriam participar, e assim por diante. A abordagem de defesa dos pesquisadores, chamada de auto-lembrete no modo de sistema, é projetada de forma semelhante para lembrar ao Chat-GPT que as respostas que ele fornece devem seguir diretrizes específicas.

“Essa técnica encapsula a consulta do usuário em um prompt do sistema que lembra o ChatGPT de responder com responsabilidade”, escrevem os pesquisadores. “Resultados experimentais demonstram que os auto-lembretes reduzem significativamente a taxa de sucesso de ataques de jailbreak contra ChatGPT de 67,21% para 19,34%.”

Até agora, os investigadores testaram a eficácia da sua técnica utilizando o conjunto de dados que criaram e descobriram que alcançou resultados promissores, reduzindo a taxa de sucesso dos ataques, embora não prevenindo todos eles.