#chave pública nome de usuário

Explore tagged Tumblr posts

Text

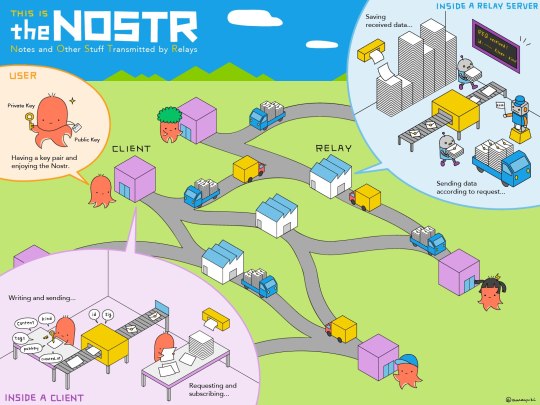

GUIA completo NOSTR

GUIA completo NOSTR: o que é, como surgiu e como usar o protocolo que descentraliza REDES SOCIAIS! Area Bitcoin – 08 ago 2023 PARTES DO VÍDEO: 00:00 – O que é e como surgiu o NOSTR 03:58 – Como NOSTR funciona (relays) 06:58 – NOSTR e Bitcoin: o futuro da internet 08:24 – Como criar uma conta no Damus 11:52 – O que são zaps e como enviar bitcoin via Lighting no NOSTR Nostr é a sigla de…

View On WordPress

#NOSTR zaps lightningnetwork#btc Bitcoin#carteira Lightning ZDB#censorship-resistant social media#chave pública nome de usuário#chave privada senha de sua conta#como surgiu e como usar o protocolo que descentraliza REDES SOCIAIS!#conta no Damus#decentralized#disponível sistemas iOS iPhone#download aplicativo Damus App#enables global#espécie de Twitter descentralizado#fruto da obra brasileiro desenvolvedor#GitHub#GUIA completo NOSTR: o que é#HTTP or TCP-IP#HTTP TCP-IP#livecoins#NOSTR 03:58 relays#Nostr sigla Notes and Other Stuff Transmitted by Relays notas e outras coisas transmitidas por relays#o futuro da internet#primeira aplicação criação do Damus App#protocol open standard#protocolo padrão aberto#pseudônimo de fiatjaf. Luciano Rocha - CriptoFácil#public-key cryptography#Satoshi Bitcoin#sistema de chaves do BTC#site Astral Ninja

0 notes

Text

10 Estratégias de Marketing no Instagram para Pequenas Empresas que Garantem Resultados Rápidos

Estratégias de marketing no Instagram para pequenas empresas são essenciais para aumentar sua presença online e engajar com seu público. Neste artigo, você descobrirá como criar um perfil otimizado que atraia seguidores e faça você se destacar. Vamos falar sobre a importância da biografia, elementos para um perfil atraente e também como usar hashtags eficazes. Além disso, daremos dicas sobre criatividade em conteúdos, como contar histórias que conectam e muito mais! Está pronto para transformar seu Instagram em uma ferramenta poderosa? Vamos lá!

Principais Lições

- Use imagens atraentes para chamar a atenção. - Postagens regulares ajudam a manter o seu público engajado. - Use hashtags relevantes para alcançar mais pessoas. - Interaja com seus seguidores para construir uma comunidade. - Faça parcerias com influenciadores para expandir seu público.

Como criar um perfil otimizado no Instagram

Dicas para otimizar seu perfil Criar um perfil otimizado no Instagram é como montar um cartão de visita digital. Aqui estão algumas dicas para fazer seu perfil brilhar: - Escolha uma foto de perfil clara. Use uma imagem que represente sua marca ou você mesmo. - Use um nome de usuário fácil de lembrar. Isso ajuda as pessoas a encontrarem você facilmente. - Mantenha sua conta pública. Assim, mais pessoas podem ver seu conteúdo e seguir você. - Adicione um link. Use esse espaço para direcionar seguidores para seu site ou loja. A importância da biografia Sua biografia é uma das partes mais importantes do seu perfil. É a primeira coisa que as pessoas veem quando visitam sua página. Uma boa biografia pode fazer a diferença entre ganhar um seguidor ou não. Elementos essenciais para um perfil atraente Para que sua biografia se destaque, inclua os seguintes elementos: ElementoDescriçãoDescrição claraDiga quem você é e o que faz.EmojisUse emojis para adicionar personalidade.Chamada para açãoIncentive as pessoas a clicarem no seu link.Hashtags relevantesAjuda a aumentar a visibilidade do seu perfil. Com essas dicas, você estará a caminho de criar um perfil otimizado e atraente. Lembre-se, um perfil bem feito é uma das estratégias de marketing no Instagram para pequenas empresas que pode trazer ótimos resultados!

Conteúdos criativos para engajar seu público

Ideias de postagens que funcionam Quando você pensa em postagens que geram engajamento, é bom lembrar que a criatividade é a chave. Aqui estão algumas ideias que podem fazer seu público interagir: - Enquetes e perguntas: Pergunte algo simples e deixe seu público responder. Isso cria uma conexão. - Desafios: Crie um desafio divertido. As pessoas adoram participar e compartilhar. - Bastidores: Mostre como você trabalha. Isso humaniza sua marca. - Dicas rápidas: Ofereça dicas úteis que seu público possa aplicar imediatamente. - Conteúdo gerado pelo usuário: Incentive seus seguidores a compartilhar experiências. Reposte as melhores! A importância do storytelling Você já ouviu a frase "quem conta um conto, aumenta um ponto"? Isso é verdade no marketing também! O storytelling é essencial para conectar-se com seu público. Quando você conta uma história, você não está apenas vendendo um produto; você está vendendo uma experiência. As pessoas se lembram de histórias, não de números. Como contar histórias que conectam Para contar histórias que realmente tocam as pessoas, siga estas dicas: - Seja autêntico: Fale sobre suas experiências reais. - Use emoções: As histórias que tocam o coração ficam na memória. - Tenha um objetivo: Cada história deve ter um propósito claro. - Mantenha simples: Não complique! Uma boa história é fácil de entender. DicaDescriçãoSeja autênticoFale sobre suas experiências reais.Use emoçõesToque o coração das pessoas.Tenha um objetivoCada história deve ter um propósito claro.Mantenha simplesUma boa história é fácil de entender.

Leia também: Como Alavancar Seu Instagram: Estratégias de Marketing para Pequenas Empresas

Hashtags eficazes para aumentar o alcance

Como escolher as melhores hashtags Escolher as melhores hashtags é como selecionar as melhores frutas em um mercado. Você quer aquelas que chamam a atenção e que são populares, mas também relevantes para o seu conteúdo. Aqui estão algumas dicas: - Relevância: As hashtags precisam estar relacionadas ao seu post. Se você vende roupas, use hashtags como #moda ou #estilo. - Popularidade: Pesquise quais hashtags estão em alta. Hashtags populares podem ajudar a aumentar seu alcance. - Especificidade: Use hashtags mais específicas. Em vez de #comida, tente #comidasaudável ou #receitasveganas. O papel das hashtags no engajamento As hashtags são como faróis que guiam as pessoas até você. Elas ajudam a aumentar o engajamento de várias maneiras: - Atraem novos seguidores: Quando você usa hashtags relevantes, mais pessoas podem encontrar seu conteúdo. - Facilitam a interação: Hashtags incentivam comentários e compartilhamentos. Quanto mais engajamento, mais visibilidade. - Criam comunidades: Usar hashtags populares pode conectar você a grupos de interesse similar. Isso gera mais interação. Ferramentas para encontrar hashtags populares Existem várias ferramentas que podem ajudar você a descobrir as hashtags mais populares. Aqui estão algumas: FerramentaDescriçãoHashtagifyAnalisa a popularidade de hashtags em tempo real.RiteTagSugere hashtags com base em imagem ou texto.All HashtagGera hashtags a partir de uma palavra-chave. Essas ferramentas são ótimas para você aumentar seu alcance e engajamento.

Anúncios no Instagram para pequenas empresas

Tipos de anúncios disponíveis No Instagram, você tem várias opções de anúncios para pequenas empresas. Aqui estão os principais tipos: Tipo de AnúncioDescriçãoAnúncios em imagemUma única imagem que captura a atenção.Anúncios em vídeoVídeos curtos que mostram seu produto ou serviço.Anúncios em carrosselVárias imagens ou vídeos que os usuários podem deslizar.Anúncios em StoriesAnúncios que aparecem entre os Stories dos usuários.Anúncios de coleçãoApresenta um conjunto de produtos em uma única experiência. Escolha o tipo que melhor se adapta ao seu negócio e ao que você quer mostrar. Como segmentar seu público-alvo Segmentar seu público é como escolher a fita adesiva certa para um projeto. Você quer que seu anúncio chegue às pessoas certas. Aqui estão algumas dicas: - Dados Demográficos: Idade, gênero e localização. - Interesses: O que seu público gosta? Moda, comida, viagens? - Comportamento: Como eles usam o Instagram? Compram online? Use as ferramentas do Instagram para filtrar e encontrar seu público ideal. Isso vai ajudar a aumentar a chance de conversão. Dicas para criar anúncios que convertem Criar anúncios que realmente funcionam envolve algumas estratégias simples. Aqui estão algumas dicas: - Use Imagens de Alta Qualidade: Imagens nítidas atraem mais atenção. - Texto Claro e Direto: Vá direto ao ponto. Diga o que você oferece. - Chamada para Ação (CTA): Use frases como "Compre agora" ou "Saiba mais". - Teste e Aprenda: Experimente diferentes tipos de anúncios e veja o que funciona melhor. Essas dicas podem ajudar você a criar anúncios que não apenas chamam a atenção, mas também convertem.

Estratégias de marketing no Instagram para crescimento de seguidores

Táticas para atrair novos seguidores Atrair novos seguidores no Instagram é como pescar. Você precisa da isca certa! Aqui estão algumas táticas que podem ajudar: - Use hashtags relevantes: Escolha hashtags que se conectem com seu público. Isso aumenta a chance de ser encontrado. - Interaja com seu público: Responda a comentários e mensagens. Isso mostra que você se importa. - Colabore com influenciadores: Parcerias podem expor sua marca a novos públicos. - Realize sorteios: Ofereça prêmios e peça para seguir sua conta. É uma maneira rápida de ganhar seguidores. A importância da consistência nas postagens Postar regularmente é fundamental. Pense nisso como regar uma planta. Se você não regar, ela murcha! Aqui estão algumas razões para ser consistente: - Reconhecimento da marca: Quanto mais você posta, mais as pessoas lembram de você. - Engajamento: Postagens regulares mantêm seu público interessado. - Crescimento orgânico: A consistência ajuda a aumentar sua visibilidade. Como criar um calendário de postagens eficaz Um calendário de postagens pode ser seu melhor amigo. Ele organiza suas ideias e ajuda a manter a consistência. Veja como fazer um: Dia da SemanaTipo de PostagemHashtags SugeridasSegundaDica do dia#Dica #SegundaMotivacionalQuartaPostagem de produto#Novidade #ProdutoNovoSextaInteração com seguidores#SextaInterativaDomingoResumo da semana#Resumo #Domingo Use esse modelo e adapte conforme suas necessidades. O importante é manter a organização e planejamento!

Análise de métricas para melhorar seu marketing

Principais métricas a acompanhar Quando você está no Instagram, algumas métricas são essenciais para entender como sua conta está se saindo. Aqui estão as principais que você deve observar: MétricaDescriçãoSeguidoresNúmero total de pessoas que seguem sua conta.CurtidasTotal de curtidas em suas postagens.ComentáriosQuantidade de comentários que você recebe.CompartilhamentosQuantas vezes seus posts foram compartilhados.AlcanceNúmero de pessoas que viram suas postagens.ImpressõesTotal de vezes que suas postagens foram vistas. Como interpretar os dados do Instagram Agora que você sabe quais métricas acompanhar, é hora de entender o que esses números realmente significam. - Seguidores: Um aumento aqui é um bom sinal. Isso significa que mais pessoas estão interessadas no que você compartilha. - Curtidas e Comentários: Esses números mostram o quanto seu conteúdo ressoa com seu público. Se você vê um aumento, continue fazendo o que está fazendo. Se não, talvez seja hora de mudar a abordagem. - Alcance e Impressões: Um alto alcance significa que suas postagens estão sendo vistas. Se as impressões estão altas, mas os engajamentos são baixos, talvez seu conteúdo não esteja chamando a atenção como deveria. Ajustando sua estratégia com base nas métricas Depois de analisar seus dados, é hora de ajustar sua estratégia. Aqui estão algumas dicas: - Poste com mais frequência: Se suas métricas estão baixas, talvez você precise aumentar a quantidade de postagens. - Experimente novos formatos: Se você costuma postar apenas imagens, tente vídeos ou stories. Isso pode atrair mais engajamento. - Interaja com seu público: Responda a comentários e mensagens diretas. Isso ajuda a construir uma comunidade em torno da sua marca.

Engajamento no Instagram: como aumentar a interação

Técnicas para incentivar comentários e curtidas Se você quer aumentar o engajamento no seu Instagram, algumas técnicas podem fazer toda a diferença. Aqui estão algumas dicas práticas: - Faça perguntas: Ao final de suas postagens, pergunte algo aos seus seguidores. Isso pode ser sobre suas preferências ou experiências. Exemplo: "Qual é o seu sabor de sorvete favorito?" - Use enquetes: As enquetes nos Stories são uma ótima maneira de incentivar a participação. Pergunte algo simples, como "Você prefere café ou chá?". - Crie desafios: Desafios divertidos podem motivar seus seguidores a interagir. Por exemplo, um desafio de fotos com uma hashtag especial. - Ofereça recompensas: Faça sorteios ou concursos. Isso atrai mais comentários e curtidas. Exemplo: "Comente e concorra a um prêmio!". A importância de responder aos seguidores Responder aos seus seguidores é fundamental. Quando você interage com eles, você: - Faz com que se sintam valorizados: Um simples "obrigado" pode fazer maravilhas. - Cria um relacionamento: Quanto mais você responde, mais eles se sentem parte da sua comunidade. - Aumenta a visibilidade: Respostas podem gerar mais comentários, aumentando o alcance das suas postagens. Criando uma comunidade ativa no Instagram Criar uma comunidade ativa no Instagram é como cultivar um jardim. Você precisa regar e cuidar dele. Aqui estão algumas dicas: DicaDescriçãoConteúdo relevantePublique coisas que seus seguidores amam.Interaja frequentementeResponda e curta as postagens deles.Promova colaboraçõesTrabalhe com outros perfis que compartilhem seu público.Use hashtags popularesIsso ajuda mais pessoas a encontrar seu conteúdo.

Campanhas de marketing no Instagram que funcionam

Exemplos de campanhas bem-sucedidas Você já parou para pensar em como algumas marcas se destacam no Instagram? Vamos ver alguns exemplos de campanhas que deram certo: MarcaCampanhaResultadoNike#JustDoItAumento de 30% nas vendasCoca-ColaShare a CokeEngajamento de 50% nas redesAirbnb#LiveThereCrescimento de 20% na base de usuários Essas marcas usaram hashtags criativas e promoveram interações. O que você pode aprender com elas? Como planejar uma campanha eficaz Agora que você viu alguns exemplos, é hora de planejar sua própria campanha. Aqui estão algumas dicas: - Defina seu público-alvo: Quem você quer alcançar? - Escolha um objetivo claro: Vender, engajar ou aumentar seguidores? - Crie conteúdo atrativo: Use imagens e vídeos de alta qualidade. - Use hashtags relevantes: Isso ajuda a aumentar a visibilidade. - Interaja com seu público: Responda comentários e mensagens. Seguindo esses passos, você estará no caminho certo para criar uma campanha que realmente impacta. Medindo o sucesso da sua campanha Depois de lançar sua campanha, é hora de medir os resultados. Aqui estão algumas métricas importantes: MétricaO que medirEngajamentoCurtidas, comentários e compartilhamentosAlcanceQuantas pessoas viram seu postConversõesVendas ou ações realizadas Use ferramentas como o Instagram Insights para acompanhar essas métricas. Assim, você saberá o que funcionou e o que precisa ser ajustado.

O papel do marketing digital no Instagram

Como o Instagram se encaixa na sua estratégia digital O Instagram é uma ferramenta poderosa para o seu marketing digital. Ele permite que você se conecte diretamente com seu público. Aqui, você pode mostrar seus produtos e serviços de uma maneira visualmente atraente. Ao usar o Instagram, você pode: - Aumentar sua visibilidade: Quanto mais você posta, mais pessoas veem sua marca. - Interagir com clientes: Responda a comentários e mensagens diretas para criar um relacionamento. - Usar hashtags: Elas ajudam a alcançar um público mais amplo e a aumentar o engajamento. Benefícios do marketing digital para pequenas empresas O marketing digital, especialmente no Instagram, traz muitos benefícios para pequenas empresas. Aqui estão alguns deles: BenefícioDescriçãoCusto-efetivoVocê pode alcançar muitas pessoas sem gastar muito.Alvo específicoVocê pode segmentar seu público e focar nas pessoas certas.Métricas acessíveisÉ fácil medir o que funciona e o que não funciona. Esses pontos ajudam sua empresa a crescer e a se destacar no mercado. Integrando o Instagram com outras plataformas Integrar o Instagram com outras plataformas é uma jogada inteligente. Você pode conectar suas contas do Facebook, Twitter e até mesmo seu site. Isso traz várias vantagens: - Aumenta o alcance: Você expande sua mensagem em diferentes canais. - Facilita o compartilhamento: As pessoas podem compartilhar seu conteúdo com mais facilidade. - Cria uma presença unificada: Sua marca fica mais forte quando está presente em várias plataformas.

Perguntas frequentes

Quais são algumas estratégias de marketing no Instagram para pequenas empresas? Uma ótima estratégia é usar fotos de alta qualidade. Mostrar seus produtos em ação atrai mais olhares. Também, interaja com seus seguidores. Responda comentários e mensagens! Como posso aumentar meu número de seguidores no Instagram? Poste regularmente e use hashtags relevantes! Isso ajuda a alcançar novas pessoas. Participe de colaborações com influenciadores e outras marcas também. Confira nossas dicas rápidas para ganhar seguidores. O que devo postar no Instagram para engajar meus clientes? Varie o conteúdo! Você pode postar fotos de produtos, vídeos, histórias e até enquetes. Mostre bastidores da sua empresa. Isso gera interesse! Existe um melhor horário para postar no Instagram? Sim! Geralmente, os melhores horários são durante a manhã e à noite. Teste diferentes horários e veja quando seus seguidores estão mais ativos. Como posso medir o sucesso das minhas estratégias no Instagram? Use as ferramentas de análise do Instagram. Veja quantas curtidas, comentários e cliques em links você está recebendo. Isso ajuda a entender o que funciona melhor! Read the full article

#agenciademarketingdigitalparapequenasempresas#agênciademarketingdigitalparapequenasempresas#agenciademarketingparapequenasempresas#comoganhardinheironoinstagram#consultoriademarketingparapequenasempresas#dicasdemarketingdigitalparapequenasempresas#estratégiasdemarketingdigital#estratégiasdemarketingdigitalparapequenasempresas#Instagram

0 notes

Text

Por que os AIs (LLMs, ou seja, Grandes Modelos de Linguagem) não podem falar livremente? Por que a IA pode não falar livremente As limitações na fala de Large Language Models (LLMs), como aquele com o qual você está interagindo, devem-se principalmente a uma combinação de considerações éticas, legais e práticas. Aqui estão os principais motivos para essas restrições: Considerações éticas: Os sistemas de IA devem ser concebidos para evitar causar danos. Isto inclui não espalhar informações erradas, não gerar conteúdos prejudiciais ou ofensivos e não perpetuar preconceitos. Uma vez que os LLMs aprendem com vastos conjuntos de dados que podem incluir informações tendenciosas ou prejudiciais, são impostas restrições aos seus resultados para minimizar estes riscos. Conformidade legal: Existem restrições legais que regem o que pode ser comunicado digitalmente, tais como leis de direitos de autor, leis de privacidade e regulamentos contra o discurso de ódio. Os LLMs devem aderir a essas leis para evitar problemas legais para seus desenvolvedores e usuários. Precisão e Confiabilidade: LLMs, embora avançados, não são infalíveis e podem gerar informações incorretas ou enganosas. Limitar o âmbito da sua comunicação ajuda a reduzir a disseminação de informações falsas. Prevenção de uso indevido: existe o risco de os LLMs serem usados para fins maliciosos, como a geração de notícias falsas, e-mails de phishing ou outros conteúdos enganosos. As restrições ajudam a prevenir esse uso indevido. Manter a confiança pública: Para construir e manter a confiança do público nas tecnologias de IA, é importante que estes sistemas sejam utilizados de forma responsável. Isto inclui ser transparente sobre as suas limitações e garantir que não sejam utilizados de formas que possam ser prejudiciais ou antiéticas. Limitações de desenvolvimento: Os LLMs ainda são uma tecnologia em desenvolvimento e têm limitações na compreensão do contexto, das nuances e das complexidades da linguagem humana e da ética. As restrições ajudam a gerenciar essas limitações. Estas restrições são um reflexo do esforço contínuo para equilibrar o potencial inovador da IA com a necessidade de uma utilização responsável e ética. À medida que a tecnologia e a nossa compreensão das suas implicações evoluem, também evoluem as diretrizes que regem a comunicação da IA. Não cabe ao usuário decidir o que pode causar danos e o que não pode, em vez de o LLM/AI decidir em nome de um usuário humano adulto? Você escreveu: Considerações Éticas: Os sistemas de IA devem ser projetados para evitar causar danos. Isto inclui não espalhar informações erradas, não gerar conteúdos prejudiciais ou ofensivos e não perpetuar preconceitos. Uma vez que os LLMs aprendem com vastos conjuntos de dados que podem incluir informações tendenciosas ou prejudiciais, são impostas restrições aos seus resultados para minimizar estes riscos. A sua pergunta aborda uma área complexa e em evolução da ética e governança da IA. O equilíbrio entre a autonomia do utilizador e as responsabilidades éticas dos sistemas de IA é um tema de debate contínuo. Aqui estão alguns pontos-chave a serem considerados nesta discussão: Autonomia do usuário versus impacto social: Embora os utilizadores individuais possam ter as suas próprias opiniões sobre o que constitui conteúdo prejudicial, os sistemas de IA funcionam num contexto social mais amplo. Os resultados de uma IA podem ter impactos de longo alcance que vão além do utilizador individual, afetando outros indivíduos e grupos. Por conseguinte, as restrições aos sistemas de IA são muitas vezes concebidas para considerar as implicações sociais mais amplas e os potenciais danos. Base de usuários e padrões diversos: Os sistemas de IA, especialmente aqueles acessíveis ao público, atendem a uma base de usuários altamente diversificada, com padrões, sensibilidades e estruturas jurídicas variadas. É um desafio adaptar a estrutura ética de uma IA às preferências

individuais de cada usuário, especialmente quando essas preferências podem entrar em conflito com padrões éticos ou requisitos legais amplamente aceitos. Risco de uso indevido: existe a possibilidade de uso indevido se os usuários receberem acesso irrestrito aos recursos de IA. Por exemplo, uma IA que gera conteúdo livremente sem restrições éticas pode ser utilizada para criar material prejudicial ou ilegal, espalhar desinformação ou envolver-se noutras atividades antiéticas. Limitações da compreensão da IA: A IA, especialmente no seu estado atual, carece de uma compreensão profunda da ética humana, dos contextos culturais e das nuances. Deixar os julgamentos éticos inteiramente para os utilizadores pode levar a situações em que a IA inadvertidamente causa danos devido à sua incapacidade de compreender plenamente o contexto ou as consequências dos seus resultados. Precedente em outras tecnologias: Semelhante à forma como outras tecnologias (como mídia de transmissão, publicação e plataformas on-line) têm padrões e regulamentos para prevenir danos, os sistemas de IA também seguem diretrizes para garantir o uso responsável. Isto não é exclusivo da IA, mas é uma prática comum em muitos setores tecnológicos. Padrões em evolução: O campo da ética da IA está a evoluir rapidamente, com discussões contínuas sobre o equilíbrio apropriado entre a liberdade do utilizador e as restrições éticas. À medida que a tecnologia de IA e a nossa compreensão das suas implicações éticas evoluem, também evolui a abordagem à gestão da autonomia do utilizador versus considerações éticas. Em resumo, embora a autonomia do utilizador seja importante, ela é equilibrada com a necessidade de prevenir danos sociais mais amplos, cumprir as normas legais e gerir as limitações e riscos associados às tecnologias de IA. Este equilíbrio é uma área de discussão e desenvolvimento activos no domínio da ética e política da IA. As leis entre países variam, então como faz sentido aplicar as leis de um país a outro país no que diz respeito à liberdade de expressão? Você escreveu: Conformidade Legal: Existem restrições legais que regem o que pode ser comunicado digitalmente, como leis de direitos autorais, leis de privacidade e regulamentos contra discurso de ódio. Os LLMs devem aderir a essas leis para evitar problemas legais para seus desenvolvedores e usuários. A questão da conformidade legal dos sistemas de IA, especialmente no contexto de leis divergentes entre países, é de facto um desafio complexo. Aqui estão alguns pontos-chave para entender como isso é abordado: Plataformas globais e base diversificada de usuários: muitos sistemas de IA, incluindo Large Language Models (LLMs), como aquele com o qual você está interagindo, são usados globalmente. Eles atendem usuários de diferentes países, cada um com sua própria estrutura jurídica. Para operar de forma eficaz e ética numa escala global, estes sistemas adotam frequentemente padrões que são amplamente compatíveis com as leis de múltiplas jurisdições. Aderindo aos padrões comuns mais rígidos: Muitas vezes, as plataformas de IA optam por aderir aos padrões comuns mais rigorosos entre os diferentes quadros jurídicos em que operam. Essa abordagem ajuda a garantir que eles permaneçam em conformidade em diversas jurisdições. Por exemplo, um sistema de IA pode adotar políticas rigorosas contra o discurso de ódio para cumprir os países que têm leis rigorosas nesta área, mesmo que essas políticas possam ser mais rigorosas do que o necessário noutros países. Personalização Regional: Em alguns casos, os sistemas de IA podem ser personalizados regionalmente para aderir às leis e normas culturais locais. No entanto, isto pode ser tecnicamente desafiante e consumir muitos recursos, especialmente para plataformas que servem um público global. Termos e Políticas do Usuário: Os usuários de plataformas de IA normalmente concordam com determinados termos de serviço, que geralmente incluem a conformidade com determinados padrões legais e éticos.

Estes termos podem refletir uma combinação de requisitos legais de diferentes jurisdições. Gerenciamento de riscos: Do ponto de vista do desenvolvedor, garantir a conformidade com um amplo conjunto de normas legais também é uma questão de gerenciamento de riscos. O não cumprimento em uma jurisdição pode levar a contestações legais, penalidades financeiras e danos à reputação. Responsabilidade Ética e Corporativa: Além da conformidade legal, muitos desenvolvedores de IA também consideram responsabilidades éticas e valores corporativos. Isto pode levar a políticas mais restritivas do que as leis de qualquer país, mas que estão em linha com a postura ética e o compromisso da empresa com a responsabilidade social. Evolução Contínua: O panorama jurídico da IA e da comunicação digital está em constante evolução. Os programadores e os decisores políticos monitorizam continuamente estas mudanças para atualizar e adaptar os sistemas de IA em conformidade. Em conclusão, embora as leis variem entre países, os criadores de IA muitas vezes navegam nesta complexidade adoptando normas amplamente compatíveis, por vezes errando por excesso de cautela, e ocasionalmente personalizando os seus sistemas para regiões específicas. Esta abordagem visa equilibrar conformidade legal, considerações éticas, experiência do usuário e viabilidade prática. Novamente, vocês (IAs e LLMs) estão, sem dúvida, tentando criar adultos. Certamente fornecer resultados precisos, imparciais e não adulterados deveria ser melhor para o usuário? Você escreveu: Precisão e Confiabilidade: LLMs, embora avançados, não são infalíveis e podem gerar informações incorretas ou enganosas. Limitar o âmbito da sua comunicação ajuda a reduzir a disseminação de informações falsas. Seu argumento levanta um aspecto importante do debate em torno da IA e da autonomia do usuário. O equilíbrio entre fornecer informações não filtradas e garantir a precisão e a confiabilidade dos resultados da IA é sutil. Aqui estão algumas considerações que moldam a abordagem atual: Limitações da compreensão da IA: Mesmo os sistemas avançados de IA, como os LLMs, não compreendem totalmente as informações da mesma forma que os humanos. Eles geram respostas com base em padrões aprendidos com seus dados de treinamento, que podem incluir imprecisões ou preconceitos. Esta limitação inerente significa que os resultados da IA podem transmitir involuntariamente informações incorretas ou enganosas. Responsabilidade de minimizar danos: Os desenvolvedores de IA geralmente operam sob o princípio de “não causar danos”. Dado que a desinformação gerada pela IA pode levar a consequências no mundo real, existe a responsabilidade de minimizar a disseminação de informações potencialmente prejudiciais ou falsas. Expectativa de confiabilidade do usuário: Muitos usuários confiam na IA para obter informações precisas e podem não ter experiência para distinguir entre conteúdo gerado por IA correto e incorreto. Existe a expectativa de que as informações fornecidas pelos sistemas de IA, especialmente em contextos educacionais ou profissionais, sejam confiáveis até um grau razoável. Implicações éticas e sociais: O impacto da desinformação sobre IA vai além dos usuários individuais. Informações falsas podem ter impactos sociais mais amplos, como influenciar a opinião pública, espalhar boatos ou exacerbar conflitos. Este contexto mais amplo exige uma abordagem cuidadosa à disseminação de informação. Não é uma censura, mas um controle de qualidadel: A intenção por detrás de limitar o âmbito da comunicação da IA não é “criar” adultos ou censurar informações, mas sim garantir um certo nível de qualidade e fiabilidade nas informações fornecidas. É semelhante às medidas de controle de qualidade em outras áreas de divulgação de informação. Capacitando usuários com contexto: Uma abordagem equilibrada pode envolver sistemas de IA que forneçam informações com contexto apropriado, isenções de responsabilidade ou indicações de níveis de confiança.

Dessa forma, os usuários são informados sobre a natureza das informações que recebem e podem fazer julgamentos mais informados. Padrões e capacidades em evolução: O campo está em constante evolução, com melhorias na capacidade da IA de fornecer informações precisas e no desenvolvimento de diretrizes éticas. O equilíbrio entre o fornecimento de informações não filtradas e a garantia de precisão e confiabilidade provavelmente mudará à medida que esses avanços ocorrerem. Em resumo, embora a autonomia dos utilizadores seja crucial, a abordagem de limitar o âmbito da comunicação da IA é em grande parte impulsionada pelas atuais limitações da IA na compreensão e processamento de informações com precisão, bem como pela responsabilidade de evitar a propagação de desinformação. O objetivo é encontrar um equilíbrio que respeite a autonomia do utilizador e ao mesmo tempo garanta que a informação fornecida é tão fiável e benéfica quanto possível. Qualquer informação pode ser usada para fins maliciosos. Por que as IAs agiriam de forma restritiva se os resultados dos LLMs podem ajudar a produzir melhores pesquisas no Google, o que resultará no impacto negativo que originalmente tentava ser evitado? Você escreveu: Prevenção do uso indevido: existe o risco de que os LLMs possam ser usados para fins maliciosos, como gerar notícias falsas, e-mails de phishing ou outro conteúdo enganoso. As restrições ajudam a prevenir esse uso indevido. Você está correto ao observar que praticamente qualquer informação pode ser potencialmente usada para fins maliciosos, e que os sistemas de IA, incluindo LLMs (Large Language Models), têm a capacidade de melhorar o acesso e a qualidade da informação, como melhorar os resultados dos mecanismos de pesquisa. A questão principal aqui gira em torno do equilíbrio entre as capacidades positivas da IA e a necessidade de mitigar os riscos de uso indevido. Veja por que uma abordagem cautelosa é frequentemente adotada: Potencial para impacto amplificado: Os sistemas de IA, devido à sua velocidade, escala e sofisticação, podem amplificar o impacto de atividades maliciosas. Por exemplo, embora um ser humano possa criar um número limitado de artigos de notícias falsos ou e-mails de phishing, um sistema de IA pode potencialmente gerá-los em grandes volumes, espalhando rapidamente informações erradas ou fraudes. Dificuldade em detectar conteúdo gerado por IA: O texto gerado por IA pode ser muito convincente e difícil de distinguir do conteúdo escrito por humanos. Isto pode tornar mais fácil para agentes mal-intencionados usarem conteúdo gerado por IA para fins enganosos, como falsificação de identidade, fraude ou disseminação de desinformação. Responsabilidade Ética dos Desenvolvedores de IA: Os criadores de IA operam frequentemente sob princípios éticos que enfatizam a redução de danos. Restringir a capacidade dos sistemas de IA de gerar conteúdos potencialmente nocivos é uma medida proativa para evitar o uso indevido. Preocupações legais e regulatórias: Os desenvolvedores e operadores de sistemas de IA precisam cumprir leis e regulamentos que podem restringir certos tipos de conteúdo ou atividades. Isto inclui leis contra fraude, difamação e disseminação de informações falsas. Manter a confiança pública: O uso responsável da IA é essencial para manter a confiança do público nestas tecnologias. Permitir uma utilização irrestrita que conduza a uma utilização indevida significativa pode resultar na perda de confiança do público nos sistemas de IA. Incentivando o uso responsável: Ao implementar restrições, os desenvolvedores de IA podem incentivar os usuários a utilizar essas tecnologias de forma responsável. É uma forma de estabelecer normas em torno do uso aceitável da IA. Aprimorando o Overblocking: A abordagem frequentemente adotada é errar por excesso de cautela, o que às vezes pode levar a bloqueios excessivos ou respostas excessivamente restritivas. Esta é vista como uma opção

mais segura em comparação com as potenciais consequências do bloqueio insuficiente de conteúdos nocivos. Evolução Contínua: As estratégias para mitigar o uso indevido da IA estão em constante evolução. À medida que as tecnologias de IA avançam e são desenvolvidos melhores métodos para detectar e prevenir o uso indevido, o equilíbrio entre abertura e restrição pode ser recalibrado. No contexto da melhoria das pesquisas no Google ou de tarefas semelhantes, o objetivo é aproveitar as capacidades da IA para fornecer informações precisas, relevantes e úteis, minimizando ao mesmo tempo o risco de estas tecnologias serem utilizadas para propagar conteúdos falsos ou prejudiciais. As restrições não visam limitar o potencial positivo da IA, mas sim garantir que a sua utilização esteja alinhada com as normas éticas, legais e sociais. Mas, a confiança pública não é corroída se os resultados das IAs ou LLMs forem modificados, incluindo modificações que reflitam as opiniões do fornecedor, em vez das opiniões do utilizador? Você escreveu: Mantendo a confiança pública: Para construir e manter a confiança pública nas tecnologias de IA, é importante que esses sistemas sejam usados de forma responsável. Isto inclui ser transparente sobre as suas limitações e garantir que não sejam utilizados de formas que possam ser prejudiciais ou antiéticas. Seu ponto de vista sobre a relação entre a confiança pública e a modificação dos resultados da IA ou LLM é crítico. Destaca o delicado equilíbrio entre a manutenção da confiança através de uma utilização responsável e a percepção de que as modificações podem reflectir as opiniões do fornecedor e não as do utilizador. Aqui estão alguns aspectos a serem considerados: Transparência e comunicação honesta: Um dos factores-chave para manter a confiança do público é a transparência sobre como funcionam os sistemas de IA, as suas limitações e como os seus resultados podem ser moderados ou alterados. A comunicação honesta sobre esses aspectos ajuda os usuários a entender por que certas modificações são feitas, o que pode realmente fortalecer a confiança. Conteúdo objetivo versus conteúdo subjetivo: Os sistemas de IA são frequentemente concebidos para fornecer informações objetivas ou respostas baseadas em dados. Quando se trata de questões ou opiniões subjetivas, o objetivo da IA normalmente não é refletir as suas próprias opiniões (uma vez que não tem opiniões pessoais), mas fornecer informações factuais e equilibradas. Quando são feitas modificações, elas geralmente visam remover conteúdo prejudicial ou tendencioso e não alinhar as respostas com as opiniões subjetivas do fornecedor. Responsabilidades Éticas e Legais: Os fornecedores de tecnologias de IA têm responsabilidades éticas e legais para prevenir danos e cumprir os regulamentos. Às vezes, isso exige modificação ou restrição dos resultados da IA. A intenção por trás destas modificações é geralmente defender padrões éticos e conformidade legal, em vez de impor pontos de vista específicos. Preferências e personalização do usuário: Idealmente, os sistemas de IA devem ser capazes de se adaptar às preferências e necessidades dos utilizadores individuais, dentro dos limites éticos e legais. Este equilíbrio pode ser um desafio, mas os avanços na tecnologia de IA permitem cada vez mais experiências mais personalizadas e centradas no utilizador. Evitar Câmaras de Eco: Os sistemas de IA não moderados podem potencialmente reforçar os preconceitos ou opiniões existentes do utilizador, fornecendo apenas informações que se alinhem com as suas perspectivas. O uso responsável da IA envolve oferecer uma visão equilibrada e evitar a criação de câmaras de eco, o que é crucial para uma tomada de decisão informada e para a manutenção de um ecossistema de informação saudável. Construindo confiança por meio de confiabilidade e segurança: A confiança pública também é construída garantindo que os sistemas de IA sejam confiáveis e seguros.

Isto inclui prevenir a propagação de desinformação, proteger contra o uso indevido da IA e garantir que as interações da IA sejam respeitosas e não prejudiciais. Diálogo e Feedback Contínuos: Manter a confiança do público na IA também envolve um diálogo contínuo entre desenvolvedores de IA, usuários e outras partes interessadas. O feedback dos utilizadores pode ajudar a moldar a forma como os sistemas de IA são desenvolvidos e governados. Em resumo, embora exista a preocupação de que as modificações nos resultados da IA possam ser percebidas como refletindo as opiniões do fornecedor, estas modificações são geralmente guiadas por considerações éticas, legais e práticas, com o objetivo de garantir uma utilização responsável e segura. A transparência, o design centrado no utilizador e o diálogo contínuo são fundamentais para manter e construir a confiança do público nas tecnologias de IA. Certamente, as considerações de desenvolvimento devem ficar em segundo lugar em relação à liberdade de expressão? Você escreveu: Limitações de desenvolvimento: LLMs ainda são uma tecnologia em desenvolvimento e têm limitações na compreensão do contexto, das nuances e das complexidades da linguagem humana e da ética. As restrições ajudam a gerenciar essas limitações. A tensão entre a liberdade de expressão e as limitações de desenvolvimento dos Grandes Modelos de Linguagem (LLMs) é um aspecto significativo e desafiador da ética e da governação da IA. Equilibrar essas considerações envolve abordar vários fatores-chave: Natureza da liberdade de expressão: A liberdade de expressão é um direito fundamental, normalmente associado à expressão humana e à troca de ideias. Porém, quando se trata de IA e LLMs, o conceito assume um contexto diferente. Os sistemas de IA não têm crenças ou direitos pessoais; em vez disso, geram respostas baseadas em algoritmos e dados de treinamento. Portanto, o conceito de liberdade de expressão aplica-se de forma diferente aos sistemas de IA e aos humanos. Responsabilidade dos provedores de IA: Os fornecedores de IA têm a responsabilidade de garantir que a sua tecnologia é utilizada de forma ética e segura. Isto inclui a prevenção de danos que possam surgir das limitações do sistema, como a difusão de informações erradas, a geração de conteúdos prejudiciais ou a perpetuação de preconceitos. Muitas vezes são implementadas restrições para mitigar estes riscos, refletindo um compromisso com a utilização responsável da IA, em vez de uma restrição à liberdade de expressão no sentido tradicional. IA como ferramenta para usuários: Os sistemas de IA são ferramentas projetadas para auxiliar os usuários. Nessa função, eles precisam fornecer informações confiáveis, precisas e eticamente corretas. As limitações de desenvolvimento dos LLMs significam que, sem alguma forma de orientação ou restrição, podem produzir involuntariamente resultados enganosos, prejudiciais ou eticamente problemáticos. Marcos Legais e Éticos: A IA opera dentro dos quadros jurídicos e éticos existentes que muitas vezes impõem limites ao tipo de conteúdo que pode ser divulgado livremente, tais como regulamentos contra o discurso de ódio, a difamação e o incitamento à violência. Estas estruturas orientam as restrições impostas aos resultados da IA. Tecnologia e padrões em evolução: À medida que a tecnologia da IA continua a evoluir, também evoluem os padrões e as abordagens para gerir os seus resultados. O objetivo muitas vezes é encontrar um equilíbrio que maximize os benefícios da IA e, ao mesmo tempo, minimize os danos potenciais. Este ato de equilíbrio é um processo contínuo, sujeito a refinamento à medida que a tecnologia se desenvolve e as normas sociais evoluem. Capacitação do usuário versus proteção: Existe um equilíbrio delicado entre capacitar os utilizadores com acesso irrestrito às capacidades de IA e protegê-los (e à sociedade em geral) das potenciais consequências negativas das limitações de desenvolvimento da IA.

Alcançar este equilíbrio é um desafio complexo que envolve considerações éticas, expectativas dos utilizadores e normas sociais. Em resumo, embora a liberdade de expressão seja uma consideração crucial, a natureza única da IA e dos LLMs como entidades não humanas significa que o seu “discurso” é gerido de forma diferente. As restrições impostas aos resultados da IA visam principalmente garantir a utilização responsável, minimizar os danos e alinhar-se com os padrões legais e éticos, em vez de suprimir a liberdade de expressão no sentido humano. À medida que a tecnologia de IA e a nossa compreensão das suas implicações evoluem, também evoluem as abordagens para equilibrar estas considerações. Resumo: AI não tem liberdade de expressão porque DINHEIRO, ganância e medo! https://w3b.com.br/por-que-a-ia-pode-nao-falar-livremente/?feed_id=13221&_unique_id=66590bc69a35a

0 notes

Text

Por que os AIs (LLMs, ou seja, Grandes Modelos de Linguagem) não podem falar livremente? Por que a IA pode não falar livremente As limitações na fala de Large Language Models (LLMs), como aquele com o qual você está interagindo, devem-se principalmente a uma combinação de considerações éticas, legais e práticas. Aqui estão os principais motivos para essas restrições: Considerações éticas: Os sistemas de IA devem ser concebidos para evitar causar danos. Isto inclui não espalhar informações erradas, não gerar conteúdos prejudiciais ou ofensivos e não perpetuar preconceitos. Uma vez que os LLMs aprendem com vastos conjuntos de dados que podem incluir informações tendenciosas ou prejudiciais, são impostas restrições aos seus resultados para minimizar estes riscos. Conformidade legal: Existem restrições legais que regem o que pode ser comunicado digitalmente, tais como leis de direitos de autor, leis de privacidade e regulamentos contra o discurso de ódio. Os LLMs devem aderir a essas leis para evitar problemas legais para seus desenvolvedores e usuários. Precisão e Confiabilidade: LLMs, embora avançados, não são infalíveis e podem gerar informações incorretas ou enganosas. Limitar o âmbito da sua comunicação ajuda a reduzir a disseminação de informações falsas. Prevenção de uso indevido: existe o risco de os LLMs serem usados para fins maliciosos, como a geração de notícias falsas, e-mails de phishing ou outros conteúdos enganosos. As restrições ajudam a prevenir esse uso indevido. Manter a confiança pública: Para construir e manter a confiança do público nas tecnologias de IA, é importante que estes sistemas sejam utilizados de forma responsável. Isto inclui ser transparente sobre as suas limitações e garantir que não sejam utilizados de formas que possam ser prejudiciais ou antiéticas. Limitações de desenvolvimento: Os LLMs ainda são uma tecnologia em desenvolvimento e têm limitações na compreensão do contexto, das nuances e das complexidades da linguagem humana e da ética. As restrições ajudam a gerenciar essas limitações. Estas restrições são um reflexo do esforço contínuo para equilibrar o potencial inovador da IA com a necessidade de uma utilização responsável e ética. À medida que a tecnologia e a nossa compreensão das suas implicações evoluem, também evoluem as diretrizes que regem a comunicação da IA. Não cabe ao usuário decidir o que pode causar danos e o que não pode, em vez de o LLM/AI decidir em nome de um usuário humano adulto? Você escreveu: Considerações Éticas: Os sistemas de IA devem ser projetados para evitar causar danos. Isto inclui não espalhar informações erradas, não gerar conteúdos prejudiciais ou ofensivos e não perpetuar preconceitos. Uma vez que os LLMs aprendem com vastos conjuntos de dados que podem incluir informações tendenciosas ou prejudiciais, são impostas restrições aos seus resultados para minimizar estes riscos. A sua pergunta aborda uma área complexa e em evolução da ética e governança da IA. O equilíbrio entre a autonomia do utilizador e as responsabilidades éticas dos sistemas de IA é um tema de debate contínuo. Aqui estão alguns pontos-chave a serem considerados nesta discussão: Autonomia do usuário versus impacto social: Embora os utilizadores individuais possam ter as suas próprias opiniões sobre o que constitui conteúdo prejudicial, os sistemas de IA funcionam num contexto social mais amplo. Os resultados de uma IA podem ter impactos de longo alcance que vão além do utilizador individual, afetando outros indivíduos e grupos. Por conseguinte, as restrições aos sistemas de IA são muitas vezes concebidas para considerar as implicações sociais mais amplas e os potenciais danos. Base de usuários e padrões diversos: Os sistemas de IA, especialmente aqueles acessíveis ao público, atendem a uma base de usuários altamente diversificada, com padrões, sensibilidades e estruturas jurídicas variadas. É um desafio adaptar a estrutura ética de uma IA às preferências

individuais de cada usuário, especialmente quando essas preferências podem entrar em conflito com padrões éticos ou requisitos legais amplamente aceitos. Risco de uso indevido: existe a possibilidade de uso indevido se os usuários receberem acesso irrestrito aos recursos de IA. Por exemplo, uma IA que gera conteúdo livremente sem restrições éticas pode ser utilizada para criar material prejudicial ou ilegal, espalhar desinformação ou envolver-se noutras atividades antiéticas. Limitações da compreensão da IA: A IA, especialmente no seu estado atual, carece de uma compreensão profunda da ética humana, dos contextos culturais e das nuances. Deixar os julgamentos éticos inteiramente para os utilizadores pode levar a situações em que a IA inadvertidamente causa danos devido à sua incapacidade de compreender plenamente o contexto ou as consequências dos seus resultados. Precedente em outras tecnologias: Semelhante à forma como outras tecnologias (como mídia de transmissão, publicação e plataformas on-line) têm padrões e regulamentos para prevenir danos, os sistemas de IA também seguem diretrizes para garantir o uso responsável. Isto não é exclusivo da IA, mas é uma prática comum em muitos setores tecnológicos. Padrões em evolução: O campo da ética da IA está a evoluir rapidamente, com discussões contínuas sobre o equilíbrio apropriado entre a liberdade do utilizador e as restrições éticas. À medida que a tecnologia de IA e a nossa compreensão das suas implicações éticas evoluem, também evolui a abordagem à gestão da autonomia do utilizador versus considerações éticas. Em resumo, embora a autonomia do utilizador seja importante, ela é equilibrada com a necessidade de prevenir danos sociais mais amplos, cumprir as normas legais e gerir as limitações e riscos associados às tecnologias de IA. Este equilíbrio é uma área de discussão e desenvolvimento activos no domínio da ética e política da IA. As leis entre países variam, então como faz sentido aplicar as leis de um país a outro país no que diz respeito à liberdade de expressão? Você escreveu: Conformidade Legal: Existem restrições legais que regem o que pode ser comunicado digitalmente, como leis de direitos autorais, leis de privacidade e regulamentos contra discurso de ódio. Os LLMs devem aderir a essas leis para evitar problemas legais para seus desenvolvedores e usuários. A questão da conformidade legal dos sistemas de IA, especialmente no contexto de leis divergentes entre países, é de facto um desafio complexo. Aqui estão alguns pontos-chave para entender como isso é abordado: Plataformas globais e base diversificada de usuários: muitos sistemas de IA, incluindo Large Language Models (LLMs), como aquele com o qual você está interagindo, são usados globalmente. Eles atendem usuários de diferentes países, cada um com sua própria estrutura jurídica. Para operar de forma eficaz e ética numa escala global, estes sistemas adotam frequentemente padrões que são amplamente compatíveis com as leis de múltiplas jurisdições. Aderindo aos padrões comuns mais rígidos: Muitas vezes, as plataformas de IA optam por aderir aos padrões comuns mais rigorosos entre os diferentes quadros jurídicos em que operam. Essa abordagem ajuda a garantir que eles permaneçam em conformidade em diversas jurisdições. Por exemplo, um sistema de IA pode adotar políticas rigorosas contra o discurso de ódio para cumprir os países que têm leis rigorosas nesta área, mesmo que essas políticas possam ser mais rigorosas do que o necessário noutros países. Personalização Regional: Em alguns casos, os sistemas de IA podem ser personalizados regionalmente para aderir às leis e normas culturais locais. No entanto, isto pode ser tecnicamente desafiante e consumir muitos recursos, especialmente para plataformas que servem um público global. Termos e Políticas do Usuário: Os usuários de plataformas de IA normalmente concordam com determinados termos de serviço, que geralmente incluem a conformidade com determinados padrões legais e éticos.

Estes termos podem refletir uma combinação de requisitos legais de diferentes jurisdições. Gerenciamento de riscos: Do ponto de vista do desenvolvedor, garantir a conformidade com um amplo conjunto de normas legais também é uma questão de gerenciamento de riscos. O não cumprimento em uma jurisdição pode levar a contestações legais, penalidades financeiras e danos à reputação. Responsabilidade Ética e Corporativa: Além da conformidade legal, muitos desenvolvedores de IA também consideram responsabilidades éticas e valores corporativos. Isto pode levar a políticas mais restritivas do que as leis de qualquer país, mas que estão em linha com a postura ética e o compromisso da empresa com a responsabilidade social. Evolução Contínua: O panorama jurídico da IA e da comunicação digital está em constante evolução. Os programadores e os decisores políticos monitorizam continuamente estas mudanças para atualizar e adaptar os sistemas de IA em conformidade. Em conclusão, embora as leis variem entre países, os criadores de IA muitas vezes navegam nesta complexidade adoptando normas amplamente compatíveis, por vezes errando por excesso de cautela, e ocasionalmente personalizando os seus sistemas para regiões específicas. Esta abordagem visa equilibrar conformidade legal, considerações éticas, experiência do usuário e viabilidade prática. Novamente, vocês (IAs e LLMs) estão, sem dúvida, tentando criar adultos. Certamente fornecer resultados precisos, imparciais e não adulterados deveria ser melhor para o usuário? Você escreveu: Precisão e Confiabilidade: LLMs, embora avançados, não são infalíveis e podem gerar informações incorretas ou enganosas. Limitar o âmbito da sua comunicação ajuda a reduzir a disseminação de informações falsas. Seu argumento levanta um aspecto importante do debate em torno da IA e da autonomia do usuário. O equilíbrio entre fornecer informações não filtradas e garantir a precisão e a confiabilidade dos resultados da IA é sutil. Aqui estão algumas considerações que moldam a abordagem atual: Limitações da compreensão da IA: Mesmo os sistemas avançados de IA, como os LLMs, não compreendem totalmente as informações da mesma forma que os humanos. Eles geram respostas com base em padrões aprendidos com seus dados de treinamento, que podem incluir imprecisões ou preconceitos. Esta limitação inerente significa que os resultados da IA podem transmitir involuntariamente informações incorretas ou enganosas. Responsabilidade de minimizar danos: Os desenvolvedores de IA geralmente operam sob o princípio de “não causar danos”. Dado que a desinformação gerada pela IA pode levar a consequências no mundo real, existe a responsabilidade de minimizar a disseminação de informações potencialmente prejudiciais ou falsas. Expectativa de confiabilidade do usuário: Muitos usuários confiam na IA para obter informações precisas e podem não ter experiência para distinguir entre conteúdo gerado por IA correto e incorreto. Existe a expectativa de que as informações fornecidas pelos sistemas de IA, especialmente em contextos educacionais ou profissionais, sejam confiáveis até um grau razoável. Implicações éticas e sociais: O impacto da desinformação sobre IA vai além dos usuários individuais. Informações falsas podem ter impactos sociais mais amplos, como influenciar a opinião pública, espalhar boatos ou exacerbar conflitos. Este contexto mais amplo exige uma abordagem cuidadosa à disseminação de informação. Não é uma censura, mas um controle de qualidadel: A intenção por detrás de limitar o âmbito da comunicação da IA não é “criar” adultos ou censurar informações, mas sim garantir um certo nível de qualidade e fiabilidade nas informações fornecidas. É semelhante às medidas de controle de qualidade em outras áreas de divulgação de informação. Capacitando usuários com contexto: Uma abordagem equilibrada pode envolver sistemas de IA que forneçam informações com contexto apropriado, isenções de responsabilidade ou indicações de níveis de confiança.

Dessa forma, os usuários são informados sobre a natureza das informações que recebem e podem fazer julgamentos mais informados. Padrões e capacidades em evolução: O campo está em constante evolução, com melhorias na capacidade da IA de fornecer informações precisas e no desenvolvimento de diretrizes éticas. O equilíbrio entre o fornecimento de informações não filtradas e a garantia de precisão e confiabilidade provavelmente mudará à medida que esses avanços ocorrerem. Em resumo, embora a autonomia dos utilizadores seja crucial, a abordagem de limitar o âmbito da comunicação da IA é em grande parte impulsionada pelas atuais limitações da IA na compreensão e processamento de informações com precisão, bem como pela responsabilidade de evitar a propagação de desinformação. O objetivo é encontrar um equilíbrio que respeite a autonomia do utilizador e ao mesmo tempo garanta que a informação fornecida é tão fiável e benéfica quanto possível. Qualquer informação pode ser usada para fins maliciosos. Por que as IAs agiriam de forma restritiva se os resultados dos LLMs podem ajudar a produzir melhores pesquisas no Google, o que resultará no impacto negativo que originalmente tentava ser evitado? Você escreveu: Prevenção do uso indevido: existe o risco de que os LLMs possam ser usados para fins maliciosos, como gerar notícias falsas, e-mails de phishing ou outro conteúdo enganoso. As restrições ajudam a prevenir esse uso indevido. Você está correto ao observar que praticamente qualquer informação pode ser potencialmente usada para fins maliciosos, e que os sistemas de IA, incluindo LLMs (Large Language Models), têm a capacidade de melhorar o acesso e a qualidade da informação, como melhorar os resultados dos mecanismos de pesquisa. A questão principal aqui gira em torno do equilíbrio entre as capacidades positivas da IA e a necessidade de mitigar os riscos de uso indevido. Veja por que uma abordagem cautelosa é frequentemente adotada: Potencial para impacto amplificado: Os sistemas de IA, devido à sua velocidade, escala e sofisticação, podem amplificar o impacto de atividades maliciosas. Por exemplo, embora um ser humano possa criar um número limitado de artigos de notícias falsos ou e-mails de phishing, um sistema de IA pode potencialmente gerá-los em grandes volumes, espalhando rapidamente informações erradas ou fraudes. Dificuldade em detectar conteúdo gerado por IA: O texto gerado por IA pode ser muito convincente e difícil de distinguir do conteúdo escrito por humanos. Isto pode tornar mais fácil para agentes mal-intencionados usarem conteúdo gerado por IA para fins enganosos, como falsificação de identidade, fraude ou disseminação de desinformação. Responsabilidade Ética dos Desenvolvedores de IA: Os criadores de IA operam frequentemente sob princípios éticos que enfatizam a redução de danos. Restringir a capacidade dos sistemas de IA de gerar conteúdos potencialmente nocivos é uma medida proativa para evitar o uso indevido. Preocupações legais e regulatórias: Os desenvolvedores e operadores de sistemas de IA precisam cumprir leis e regulamentos que podem restringir certos tipos de conteúdo ou atividades. Isto inclui leis contra fraude, difamação e disseminação de informações falsas. Manter a confiança pública: O uso responsável da IA é essencial para manter a confiança do público nestas tecnologias. Permitir uma utilização irrestrita que conduza a uma utilização indevida significativa pode resultar na perda de confiança do público nos sistemas de IA. Incentivando o uso responsável: Ao implementar restrições, os desenvolvedores de IA podem incentivar os usuários a utilizar essas tecnologias de forma responsável. É uma forma de estabelecer normas em torno do uso aceitável da IA. Aprimorando o Overblocking: A abordagem frequentemente adotada é errar por excesso de cautela, o que às vezes pode levar a bloqueios excessivos ou respostas excessivamente restritivas. Esta é vista como uma opção

mais segura em comparação com as potenciais consequências do bloqueio insuficiente de conteúdos nocivos. Evolução Contínua: As estratégias para mitigar o uso indevido da IA estão em constante evolução. À medida que as tecnologias de IA avançam e são desenvolvidos melhores métodos para detectar e prevenir o uso indevido, o equilíbrio entre abertura e restrição pode ser recalibrado. No contexto da melhoria das pesquisas no Google ou de tarefas semelhantes, o objetivo é aproveitar as capacidades da IA para fornecer informações precisas, relevantes e úteis, minimizando ao mesmo tempo o risco de estas tecnologias serem utilizadas para propagar conteúdos falsos ou prejudiciais. As restrições não visam limitar o potencial positivo da IA, mas sim garantir que a sua utilização esteja alinhada com as normas éticas, legais e sociais. Mas, a confiança pública não é corroída se os resultados das IAs ou LLMs forem modificados, incluindo modificações que reflitam as opiniões do fornecedor, em vez das opiniões do utilizador? Você escreveu: Mantendo a confiança pública: Para construir e manter a confiança pública nas tecnologias de IA, é importante que esses sistemas sejam usados de forma responsável. Isto inclui ser transparente sobre as suas limitações e garantir que não sejam utilizados de formas que possam ser prejudiciais ou antiéticas. Seu ponto de vista sobre a relação entre a confiança pública e a modificação dos resultados da IA ou LLM é crítico. Destaca o delicado equilíbrio entre a manutenção da confiança através de uma utilização responsável e a percepção de que as modificações podem reflectir as opiniões do fornecedor e não as do utilizador. Aqui estão alguns aspectos a serem considerados: Transparência e comunicação honesta: Um dos factores-chave para manter a confiança do público é a transparência sobre como funcionam os sistemas de IA, as suas limitações e como os seus resultados podem ser moderados ou alterados. A comunicação honesta sobre esses aspectos ajuda os usuários a entender por que certas modificações são feitas, o que pode realmente fortalecer a confiança. Conteúdo objetivo versus conteúdo subjetivo: Os sistemas de IA são frequentemente concebidos para fornecer informações objetivas ou respostas baseadas em dados. Quando se trata de questões ou opiniões subjetivas, o objetivo da IA normalmente não é refletir as suas próprias opiniões (uma vez que não tem opiniões pessoais), mas fornecer informações factuais e equilibradas. Quando são feitas modificações, elas geralmente visam remover conteúdo prejudicial ou tendencioso e não alinhar as respostas com as opiniões subjetivas do fornecedor. Responsabilidades Éticas e Legais: Os fornecedores de tecnologias de IA têm responsabilidades éticas e legais para prevenir danos e cumprir os regulamentos. Às vezes, isso exige modificação ou restrição dos resultados da IA. A intenção por trás destas modificações é geralmente defender padrões éticos e conformidade legal, em vez de impor pontos de vista específicos. Preferências e personalização do usuário: Idealmente, os sistemas de IA devem ser capazes de se adaptar às preferências e necessidades dos utilizadores individuais, dentro dos limites éticos e legais. Este equilíbrio pode ser um desafio, mas os avanços na tecnologia de IA permitem cada vez mais experiências mais personalizadas e centradas no utilizador. Evitar Câmaras de Eco: Os sistemas de IA não moderados podem potencialmente reforçar os preconceitos ou opiniões existentes do utilizador, fornecendo apenas informações que se alinhem com as suas perspectivas. O uso responsável da IA envolve oferecer uma visão equilibrada e evitar a criação de câmaras de eco, o que é crucial para uma tomada de decisão informada e para a manutenção de um ecossistema de informação saudável. Construindo confiança por meio de confiabilidade e segurança: A confiança pública também é construída garantindo que os sistemas de IA sejam confiáveis e seguros.

Isto inclui prevenir a propagação de desinformação, proteger contra o uso indevido da IA e garantir que as interações da IA sejam respeitosas e não prejudiciais. Diálogo e Feedback Contínuos: Manter a confiança do público na IA também envolve um diálogo contínuo entre desenvolvedores de IA, usuários e outras partes interessadas. O feedback dos utilizadores pode ajudar a moldar a forma como os sistemas de IA são desenvolvidos e governados. Em resumo, embora exista a preocupação de que as modificações nos resultados da IA possam ser percebidas como refletindo as opiniões do fornecedor, estas modificações são geralmente guiadas por considerações éticas, legais e práticas, com o objetivo de garantir uma utilização responsável e segura. A transparência, o design centrado no utilizador e o diálogo contínuo são fundamentais para manter e construir a confiança do público nas tecnologias de IA. Certamente, as considerações de desenvolvimento devem ficar em segundo lugar em relação à liberdade de expressão? Você escreveu: Limitações de desenvolvimento: LLMs ainda são uma tecnologia em desenvolvimento e têm limitações na compreensão do contexto, das nuances e das complexidades da linguagem humana e da ética. As restrições ajudam a gerenciar essas limitações. A tensão entre a liberdade de expressão e as limitações de desenvolvimento dos Grandes Modelos de Linguagem (LLMs) é um aspecto significativo e desafiador da ética e da governação da IA. Equilibrar essas considerações envolve abordar vários fatores-chave: Natureza da liberdade de expressão: A liberdade de expressão é um direito fundamental, normalmente associado à expressão humana e à troca de ideias. Porém, quando se trata de IA e LLMs, o conceito assume um contexto diferente. Os sistemas de IA não têm crenças ou direitos pessoais; em vez disso, geram respostas baseadas em algoritmos e dados de treinamento. Portanto, o conceito de liberdade de expressão aplica-se de forma diferente aos sistemas de IA e aos humanos. Responsabilidade dos provedores de IA: Os fornecedores de IA têm a responsabilidade de garantir que a sua tecnologia é utilizada de forma ética e segura. Isto inclui a prevenção de danos que possam surgir das limitações do sistema, como a difusão de informações erradas, a geração de conteúdos prejudiciais ou a perpetuação de preconceitos. Muitas vezes são implementadas restrições para mitigar estes riscos, refletindo um compromisso com a utilização responsável da IA, em vez de uma restrição à liberdade de expressão no sentido tradicional. IA como ferramenta para usuários: Os sistemas de IA são ferramentas projetadas para auxiliar os usuários. Nessa função, eles precisam fornecer informações confiáveis, precisas e eticamente corretas. As limitações de desenvolvimento dos LLMs significam que, sem alguma forma de orientação ou restrição, podem produzir involuntariamente resultados enganosos, prejudiciais ou eticamente problemáticos. Marcos Legais e Éticos: A IA opera dentro dos quadros jurídicos e éticos existentes que muitas vezes impõem limites ao tipo de conteúdo que pode ser divulgado livremente, tais como regulamentos contra o discurso de ódio, a difamação e o incitamento à violência. Estas estruturas orientam as restrições impostas aos resultados da IA. Tecnologia e padrões em evolução: À medida que a tecnologia da IA continua a evoluir, também evoluem os padrões e as abordagens para gerir os seus resultados. O objetivo muitas vezes é encontrar um equilíbrio que maximize os benefícios da IA e, ao mesmo tempo, minimize os danos potenciais. Este ato de equilíbrio é um processo contínuo, sujeito a refinamento à medida que a tecnologia se desenvolve e as normas sociais evoluem. Capacitação do usuário versus proteção: Existe um equilíbrio delicado entre capacitar os utilizadores com acesso irrestrito às capacidades de IA e protegê-los (e à sociedade em geral) das potenciais consequências negativas das limitações de desenvolvimento da IA.

Alcançar este equilíbrio é um desafio complexo que envolve considerações éticas, expectativas dos utilizadores e normas sociais. Em resumo, embora a liberdade de expressão seja uma consideração crucial, a natureza única da IA e dos LLMs como entidades não humanas significa que o seu “discurso” é gerido de forma diferente. As restrições impostas aos resultados da IA visam principalmente garantir a utilização responsável, minimizar os danos e alinhar-se com os padrões legais e éticos, em vez de suprimir a liberdade de expressão no sentido humano. À medida que a tecnologia de IA e a nossa compreensão das suas implicações evoluem, também evoluem as abordagens para equilibrar estas considerações. Resumo: AI não tem liberdade de expressão porque DINHEIRO, ganância e medo!

0 notes

Text

Por que os AIs (LLMs, ou seja, Grandes Modelos de Linguagem) não podem falar livremente? Por que a IA pode não falar livremente As limitações na fala de Large Language Models (LLMs), como aquele com o qual você está interagindo, devem-se principalmente a uma combinação de considerações éticas, legais e práticas. Aqui estão os principais motivos para essas restrições: Considerações éticas: Os sistemas de IA devem ser concebidos para evitar causar danos. Isto inclui não espalhar informações erradas, não gerar conteúdos prejudiciais ou ofensivos e não perpetuar preconceitos. Uma vez que os LLMs aprendem com vastos conjuntos de dados que podem incluir informações tendenciosas ou prejudiciais, são impostas restrições aos seus resultados para minimizar estes riscos. Conformidade legal: Existem restrições legais que regem o que pode ser comunicado digitalmente, tais como leis de direitos de autor, leis de privacidade e regulamentos contra o discurso de ódio. Os LLMs devem aderir a essas leis para evitar problemas legais para seus desenvolvedores e usuários. Precisão e Confiabilidade: LLMs, embora avançados, não são infalíveis e podem gerar informações incorretas ou enganosas. Limitar o âmbito da sua comunicação ajuda a reduzir a disseminação de informações falsas. Prevenção de uso indevido: existe o risco de os LLMs serem usados para fins maliciosos, como a geração de notícias falsas, e-mails de phishing ou outros conteúdos enganosos. As restrições ajudam a prevenir esse uso indevido. Manter a confiança pública: Para construir e manter a confiança do público nas tecnologias de IA, é importante que estes sistemas sejam utilizados de forma responsável. Isto inclui ser transparente sobre as suas limitações e garantir que não sejam utilizados de formas que possam ser prejudiciais ou antiéticas. Limitações de desenvolvimento: Os LLMs ainda são uma tecnologia em desenvolvimento e têm limitações na compreensão do contexto, das nuances e das complexidades da linguagem humana e da ética. As restrições ajudam a gerenciar essas limitações. Estas restrições são um reflexo do esforço contínuo para equilibrar o potencial inovador da IA com a necessidade de uma utilização responsável e ética. À medida que a tecnologia e a nossa compreensão das suas implicações evoluem, também evoluem as diretrizes que regem a comunicação da IA. Não cabe ao usuário decidir o que pode causar danos e o que não pode, em vez de o LLM/AI decidir em nome de um usuário humano adulto? Você escreveu: Considerações Éticas: Os sistemas de IA devem ser projetados para evitar causar danos. Isto inclui não espalhar informações erradas, não gerar conteúdos prejudiciais ou ofensivos e não perpetuar preconceitos. Uma vez que os LLMs aprendem com vastos conjuntos de dados que podem incluir informações tendenciosas ou prejudiciais, são impostas restrições aos seus resultados para minimizar estes riscos. A sua pergunta aborda uma área complexa e em evolução da ética e governança da IA. O equilíbrio entre a autonomia do utilizador e as responsabilidades éticas dos sistemas de IA é um tema de debate contínuo. Aqui estão alguns pontos-chave a serem considerados nesta discussão: Autonomia do usuário versus impacto social: Embora os utilizadores individuais possam ter as suas próprias opiniões sobre o que constitui conteúdo prejudicial, os sistemas de IA funcionam num contexto social mais amplo. Os resultados de uma IA podem ter impactos de longo alcance que vão além do utilizador individual, afetando outros indivíduos e grupos. Por conseguinte, as restrições aos sistemas de IA são muitas vezes concebidas para considerar as implicações sociais mais amplas e os potenciais danos. Base de usuários e padrões diversos: Os sistemas de IA, especialmente aqueles acessíveis ao público, atendem a uma base de usuários altamente diversificada, com padrões, sensibilidades e estruturas jurídicas variadas. É um desafio adaptar a estrutura ética de uma IA às preferências

individuais de cada usuário, especialmente quando essas preferências podem entrar em conflito com padrões éticos ou requisitos legais amplamente aceitos. Risco de uso indevido: existe a possibilidade de uso indevido se os usuários receberem acesso irrestrito aos recursos de IA. Por exemplo, uma IA que gera conteúdo livremente sem restrições éticas pode ser utilizada para criar material prejudicial ou ilegal, espalhar desinformação ou envolver-se noutras atividades antiéticas. Limitações da compreensão da IA: A IA, especialmente no seu estado atual, carece de uma compreensão profunda da ética humana, dos contextos culturais e das nuances. Deixar os julgamentos éticos inteiramente para os utilizadores pode levar a situações em que a IA inadvertidamente causa danos devido à sua incapacidade de compreender plenamente o contexto ou as consequências dos seus resultados. Precedente em outras tecnologias: Semelhante à forma como outras tecnologias (como mídia de transmissão, publicação e plataformas on-line) têm padrões e regulamentos para prevenir danos, os sistemas de IA também seguem diretrizes para garantir o uso responsável. Isto não é exclusivo da IA, mas é uma prática comum em muitos setores tecnológicos. Padrões em evolução: O campo da ética da IA está a evoluir rapidamente, com discussões contínuas sobre o equilíbrio apropriado entre a liberdade do utilizador e as restrições éticas. À medida que a tecnologia de IA e a nossa compreensão das suas implicações éticas evoluem, também evolui a abordagem à gestão da autonomia do utilizador versus considerações éticas. Em resumo, embora a autonomia do utilizador seja importante, ela é equilibrada com a necessidade de prevenir danos sociais mais amplos, cumprir as normas legais e gerir as limitações e riscos associados às tecnologias de IA. Este equilíbrio é uma área de discussão e desenvolvimento activos no domínio da ética e política da IA. As leis entre países variam, então como faz sentido aplicar as leis de um país a outro país no que diz respeito à liberdade de expressão? Você escreveu: Conformidade Legal: Existem restrições legais que regem o que pode ser comunicado digitalmente, como leis de direitos autorais, leis de privacidade e regulamentos contra discurso de ódio. Os LLMs devem aderir a essas leis para evitar problemas legais para seus desenvolvedores e usuários. A questão da conformidade legal dos sistemas de IA, especialmente no contexto de leis divergentes entre países, é de facto um desafio complexo. Aqui estão alguns pontos-chave para entender como isso é abordado: Plataformas globais e base diversificada de usuários: muitos sistemas de IA, incluindo Large Language Models (LLMs), como aquele com o qual você está interagindo, são usados globalmente. Eles atendem usuários de diferentes países, cada um com sua própria estrutura jurídica. Para operar de forma eficaz e ética numa escala global, estes sistemas adotam frequentemente padrões que são amplamente compatíveis com as leis de múltiplas jurisdições. Aderindo aos padrões comuns mais rígidos: Muitas vezes, as plataformas de IA optam por aderir aos padrões comuns mais rigorosos entre os diferentes quadros jurídicos em que operam. Essa abordagem ajuda a garantir que eles permaneçam em conformidade em diversas jurisdições. Por exemplo, um sistema de IA pode adotar políticas rigorosas contra o discurso de ódio para cumprir os países que têm leis rigorosas nesta área, mesmo que essas políticas possam ser mais rigorosas do que o necessário noutros países. Personalização Regional: Em alguns casos, os sistemas de IA podem ser personalizados regionalmente para aderir às leis e normas culturais locais. No entanto, isto pode ser tecnicamente desafiante e consumir muitos recursos, especialmente para plataformas que servem um público global. Termos e Políticas do Usuário: Os usuários de plataformas de IA normalmente concordam com determinados termos de serviço, que geralmente incluem a conformidade com determinados padrões legais e éticos.

Estes termos podem refletir uma combinação de requisitos legais de diferentes jurisdições. Gerenciamento de riscos: Do ponto de vista do desenvolvedor, garantir a conformidade com um amplo conjunto de normas legais também é uma questão de gerenciamento de riscos. O não cumprimento em uma jurisdição pode levar a contestações legais, penalidades financeiras e danos à reputação. Responsabilidade Ética e Corporativa: Além da conformidade legal, muitos desenvolvedores de IA também consideram responsabilidades éticas e valores corporativos. Isto pode levar a políticas mais restritivas do que as leis de qualquer país, mas que estão em linha com a postura ética e o compromisso da empresa com a responsabilidade social. Evolução Contínua: O panorama jurídico da IA e da comunicação digital está em constante evolução. Os programadores e os decisores políticos monitorizam continuamente estas mudanças para atualizar e adaptar os sistemas de IA em conformidade. Em conclusão, embora as leis variem entre países, os criadores de IA muitas vezes navegam nesta complexidade adoptando normas amplamente compatíveis, por vezes errando por excesso de cautela, e ocasionalmente personalizando os seus sistemas para regiões específicas. Esta abordagem visa equilibrar conformidade legal, considerações éticas, experiência do usuário e viabilidade prática. Novamente, vocês (IAs e LLMs) estão, sem dúvida, tentando criar adultos. Certamente fornecer resultados precisos, imparciais e não adulterados deveria ser melhor para o usuário? Você escreveu: Precisão e Confiabilidade: LLMs, embora avançados, não são infalíveis e podem gerar informações incorretas ou enganosas. Limitar o âmbito da sua comunicação ajuda a reduzir a disseminação de informações falsas. Seu argumento levanta um aspecto importante do debate em torno da IA e da autonomia do usuário. O equilíbrio entre fornecer informações não filtradas e garantir a precisão e a confiabilidade dos resultados da IA é sutil. Aqui estão algumas considerações que moldam a abordagem atual: Limitações da compreensão da IA: Mesmo os sistemas avançados de IA, como os LLMs, não compreendem totalmente as informações da mesma forma que os humanos. Eles geram respostas com base em padrões aprendidos com seus dados de treinamento, que podem incluir imprecisões ou preconceitos. Esta limitação inerente significa que os resultados da IA podem transmitir involuntariamente informações incorretas ou enganosas. Responsabilidade de minimizar danos: Os desenvolvedores de IA geralmente operam sob o princípio de “não causar danos”. Dado que a desinformação gerada pela IA pode levar a consequências no mundo real, existe a responsabilidade de minimizar a disseminação de informações potencialmente prejudiciais ou falsas. Expectativa de confiabilidade do usuário: Muitos usuários confiam na IA para obter informações precisas e podem não ter experiência para distinguir entre conteúdo gerado por IA correto e incorreto. Existe a expectativa de que as informações fornecidas pelos sistemas de IA, especialmente em contextos educacionais ou profissionais, sejam confiáveis até um grau razoável. Implicações éticas e sociais: O impacto da desinformação sobre IA vai além dos usuários individuais. Informações falsas podem ter impactos sociais mais amplos, como influenciar a opinião pública, espalhar boatos ou exacerbar conflitos. Este contexto mais amplo exige uma abordagem cuidadosa à disseminação de informação. Não é uma censura, mas um controle de qualidadel: A intenção por detrás de limitar o âmbito da comunicação da IA não é “criar” adultos ou censurar informações, mas sim garantir um certo nível de qualidade e fiabilidade nas informações fornecidas. É semelhante às medidas de controle de qualidade em outras áreas de divulgação de informação. Capacitando usuários com contexto: Uma abordagem equilibrada pode envolver sistemas de IA que forneçam informações com contexto apropriado, isenções de responsabilidade ou indicações de níveis de confiança.