#cea paris

Explore tagged Tumblr posts

Photo

2024 May 24

M78 from the Euclid Space Telescope Image Credit & License: ESA, Euclid, Euclid Consortium, NASA; Processing: J.-C. Cuillandre (CEA Paris-Saclay), G. Anselmi

Explanation: Star formation can be messy. To help find out just how messy, ESA's new Sun-orbiting Euclid telescope recently captured the most detailed image ever of the bright star forming region M78. Near the image center, M78 lies at a distance of only about 1,300 light-years away and has a main glowing core that spans about 5 light-years. The featured image was taken in both visible and infrared light. The purple tint in M78's center is caused by dark dust preferentially reflecting the blue light of hot, young stars. Complex dust lanes and filaments can be traced through this gorgeous and revealing skyscape. On the upper left is associated star forming region NGC 2071, while a third region of star formation is visible on the lower right. These nebulas are all part of the vast Orion Molecular Cloud Complex which can be found with even a small telescope just north of Orion's belt.

∞ Source: apod.nasa.gov/apod/ap240524.html

121 notes

·

View notes

Text

How on earth did these goats get there?

*****

In reality the goats are lying on their sides on rocky ground, looking up at a crane-mounted camera. The photograph was taken some years ago, part of a series reconstructing Central European folk customs and traditions which have fallen from favour or are now prohibited.

This old-fashioned rural blood-sport was originally practiced in parts of Anatolia, Turkey, where the game was called keçi fırlatmak, and also in the Carpathian Alps of Romania, possibly imported during the Ottoman conquest. The name there was aruncarea caprei.

*****

The goats would have been coated in a strong adhesive traditionally distilled from pine resin.(represented pictorially here by darker patches of dye on the flanks) and were then thrown upwards towards a cliff or rock-face with makeshift catapults, often a primitive form of counterweight trebuchet assembled from wooden beams and weighted with rocks.

The game ended when the glue dried and lost adhesion, and the goats fell to their deaths. They were then cooked and eaten, their meat being valued like that of Spanish fighting bulls.

The meat of the last goat to fall (başarılı keçi or cea mai durabilă capră) was prized as a special delicacy and selected cuts from the legs of this particular “winner” goat were often smoked and dried into a kind of jerky.

*****

In his “Grandes Histoires Vraies d'un Voyageur le 1er Avril” (pub. Mensonges & Faussetés, Paris, 1871) French folk-historian, anthropologist and retired cavalry general Gilles-Etienne Gérârd wrote about witnessing a festival near Sighișoara, Transylvania, in 1868.

There he claims to have seen catapults improvised from jeunes arbres, très élastiques et souples - “very springy and flexible young trees” - which were drawn back with ropes and then released.

Bets were placed before the throw, and marks given afterwards, according to what way up the goats adhered and for how long. The reconstruction, with both goats upright, facing outward and still in place, shows what would have been a potential high score.

The practice has been officially banned in both countries since the late 1940s, but supposedly still occurred in more isolated areas up to the end of the 20th century. Wooden beams from which the catapults were constructed could easily be disguised as barn-rafters etc., and of course flexible trees were, and are, just trees.

*****

Gérârd’s book incorrectly calls the goat jerky “pastrami”, to which he gives the meaning "meat of preservation".

While pastrami may be a printing error for the Turkish word bastırma or the Romanian pastramă, both meaning “preserved meat”, at least one reviewer claims that Gérârd misunderstood his guide-translator, who would have been working from rural dialect to formal Romanian to scholarly French.

Since this jerky was considered a good-luck food for shepherds, mountaineers, steeplejacks and others whose work involved a risk of falling, Gérârd's assumption seems a reasonable one.

However, several critical comments on that review have dismissed its conclusion, claiming "no translator could be so clumsy", but in its defence, other comments point out confusion between slang usage in the same language.

One cites American and British English, noting that even before differences in spelling (tire / tyre, kerb / curb etc.) "guns" can mean biceps or firearms, "flat" can mean a deflated wheel or a place to live, "ass" can mean buttocks or donkey and adds, with undisguised relish, some of the more embarrassing examples.

This comment concludes that since the errors "usually make sense in context", Gérârd's misapprehension is entitled to the same respect.

*****

The good-luck aspect of the meat apparently extended to work which involved "falling safely", since its last known use was believed to be in ration packs issued to the 1. Hava İndirme Tugayı (1st Airborne Brigade) of the Turkish Army, immediately before the invasion of Cyprus in July 1974.

Nothing more recent has been officially recorded, because the presence of cameras near military bases or possible - and of course illegal - contests is strongly (sometimes forcefully) discouraged, and the sport’s very existence is increasingly dismissed as an urban or more correctly rural legend.

The official line taken by both Anatolian and Carpathian authorities is that it was only ever a joke played on tourists, similar to the Australian “Drop-bear”, the Scottish “Wild Haggis” and the North American “Jackalope”.

They dismiss the evidence of Gérârd’s personal observation as “a wild fable to encourage sales of his book”, “a city-dweller’s misinterpretation of country practices”, or even “the deliberate deception of a gullible foreigner by humorous peasants”.

And as for those paratroop ration packs, Turkish involvement in Cyprus is still such a delicate subject that the standard response remains “no comment”.

88 notes

·

View notes

Text

Euclid’s new image of star-forming region Messier 78,

A nebula that lies in the constellation Orion.

ESA / Euclid / Euclid Consortium / NASA; Image processing by J.-C. Cuillandre (CEA Paris-Saclay), G. Anselmi

#art#cosmos#cosmic#universe#blast#space#photography#stars#light#euclid#messier 78#ESA#NASA#orion#nebula

72 notes

·

View notes

Text

The light of the planet TRAPPIST-1 b measured in two color reveals new insights on the planet’s nature

An international team of researchers has just published in Nature Astronomy a complete analysis of all the mid-infrared data collected on TRAPPIST-1 b, with the aim of determining whether this planet has an atmosphere

New TRAPPIST-1 observations with JWST underscore the complexities of confirming a planet's atmosphere using only broadband thermal emission data. This insight takes on added significance with the newly approved "Rocky Worlds" observation program by Space Telescope Science Institute (STScI) which plans to apply this very method to study numerous rocky exoplanets orbiting cool stars.

The James Webb Space Telescope (JWST) is revolutionizing the study of exoplanets (planets orbiting stars other than the Sun), notably by enabling detailed spectroscopic studies of small rocky planets, but only if they orbit nearby ‘red dwarfs’, the smallest, least massive and coldest stars. At the top of its list of targets is the very low-mass red dwarf TRAPPIST-1, whose astonishing system of seven rocky planets the size of Earth, including three located in the star's habitable zone, was discovered in 2017 by an international team led by ULiège astronomer Michaël Gillon.

The innermost planet, TRAPPIST-1 b, was recently observed in depth by JWST in the mid-infrared, a type of light to which our eyes are not sensitive. An international team of researchers has just published in Nature Astronomy a complete analysis of all the mid-infrared data collected on TRAPPIST-1 b, with the aim of determining whether this planet has an atmosphere. ‘Planets orbiting red dwarfs are our best chance of studying for the first time the atmospheres of temperate rocky planets, those that receive stellar fluxes between those of Mercury and Mars’, explains Elsa Ducrot, co-lead author of the study and assistant astronomer at the Commissariat aux Énergies Atomiques (CEA) in Paris, France. ‘The TRAPPIST-1 planets provide an ideal laboratory for this ground-breaking research.

A previous observation with JWST measured TRAPPIST-1 b's infrared emission at 15 microns and suggested that a thick, CO2-rich atmosphere was unlikely (Greene et al., 2023). This conclusion was based on the fact that CO2 strongly absorbs radiation at this wavelength, which would have significantly reduced the observed flux if such an atmosphere were present. The study proposed that the measurement was most consistent with a "dark bare rock" scenario— a planet without an atmosphere and a dark surface that absorbs nearly all incoming starlight. However, a single measurement at one wavelength was insufficient to rule out all potential atmospheric scenarios

In this new study, the authors expanded on this work by measuring the planet’s flux at another wavelength, 12.8 microns. They conducted a global analysis of all available JWST data and compared these observations with surface and atmospheric models to identify the scenario that best matches the data.

Emission to the rescue

The method most used to determine whether an exoplanet has an atmosphere - transit transmission spectroscopy - involves observing its ‘transits’, i.e. when it passes in front of its host star at different wavelengths and detecting and measuring the tiny fraction of the light emitted by the star in our direction that is absorbed by its atmosphere, which is an indicator of its chemical composition. ‘However, very low-mass red dwarfs pose a problem in this respect,’ explains Professor Michaël Gillon (ULiège), author of the study. ‘Their surface is not homogeneous, and this inhomogeneity can pollute the transmission spectrum of transiting planets and mimic atmospheric characteristics.’ Such a phenomenon has been observed on several occasions with the JWST during the observation of transits of planets around red dwarfs.

One solution to overcome this stellar contamination and still get information about the presence (or absence) of an atmosphere is to directly measure the planet's heat by observing a drop in flux as the planet passes behind the star (an event called occultation). By observing the star just before and during the occultation, we can deduce the amount of infrared light coming from the planet.

‘Emission quickly became the preferred method for studying rocky exoplanets around red dwarfs during the first two years of JWST,’ explains Pierre Lagage, co-lead author of the study and head of the astrophysics department at the Commissariat aux Énergies Atomiques (CEA) in Paris, France. ‘For the TRAPPIST-1 planets, the first information comes from emission measurements, because it is still difficult to disentangle the atmospheric and stellar signals in the transit.

Reflecting this growing interest, the Space Telescope Science Institute (STScI), that manages JWST operations, recently approved a 500 hours Director Discretionary Time (DDT) program called ‘Rocky Worlds‘ to investigate the atmospheres of terrestrial exoplanets around nearby M-dwarf stars using exactly the same approach as the authors, via occultation observations, but at 15 microns only.

The results of the study are not very consistent with the ‘dark, bare surface’ scenario suggested by Greene et al. 2023. The authors found that a not-so-grey bare surface composed of ultramafic rocks (volcanic rocks enriched in minerals) better explained the data.

Alternatively, they were able to show that an atmosphere with a large amount of CO2 and haze could also explain the observations. This was a surprising result, since a CO2-rich atmosphere seemed incompatible with the strong emission at 15 microns. However, haze can radically change the situation: it can effectively absorb starlight and make the upper atmosphere warmer than the lower layers, creating what is known as a ‘thermal inversion’, like the Earth's stratosphere. This inversion causes the CO₂ to emit light rather than absorb it, resulting in a higher flux at 15 microns than at 12.8 microns.

“These thermal inversions are quite common in the atmospheres of Solar system bodies, perhaps the most similar example being the hazy atmosphere of Saturn's moon Titan. Yet, the chemistry in the atmosphere of TRAPPIST-1b is expected to be very different from Titan or any of the Solar system's rocky bodies and it is fascinating to think we might be looking at a type of atmosphere we have never seen before” explains Dr. Michiel Min from SRON Netherlands Institute for Space Research.

The authors note, however, that this atmospheric model, while consistent with the data, remains less likely than the bare rock scenario. Its complexity and the questions relating to haze formation and long-term climate stability on TRAPPIST-1 b make it a difficult model to implement. Future research, including advanced 3D modelling, will be needed to explore these issues. More generally, the team stresses the difficulty of determining with certainty a planet's surface or atmospheric composition using only emission measurements in a few wavelengths, while highlighting two convincing scenarios that will be explored in greater detail with the next observations of TRAPPIST-1 b.

What’s next?

‘Although both scenarios remain viable, our recent observations of TRAPPIST-1 b's phase curve - which tracks the flow of the planet throughout its orbit - will help to solve the mystery’, says Professor Michaël Gillon, who co-directs the new JWST program with Dr Elsa Ducrot. She adds: ‘By analyzing the efficiency with which heat is redistributed on the planet, astronomers can deduce the presence of an atmosphere. If an atmosphere exists, the heat should be distributed from the day side of the planet to its night side; without an atmosphere, the redistribution of heat would be minimal."

So we should soon know more about the presence or absence of an atmosphere around TRAPPIST-1's inner planet.

8 notes

·

View notes

Text

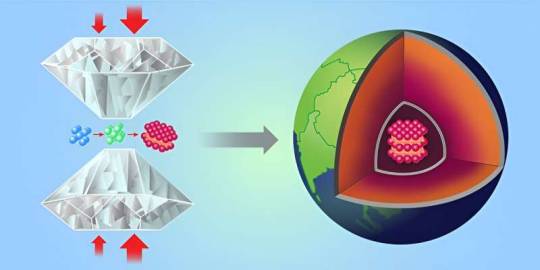

A team of physicists and geologists at CEA DAM-DIF and Universit´e Paris-Saclay, working with a colleague from ESRF, BP220, F-38043 Grenoble Cedex and another from the European Synchrotron Radiation Facility, has succeeded in synthesizing a single-crystalline iron in a form that iron has in the Earth's core. In their paper published in the journal Physical Review Letters, the group describes how they used an experimental approach to synthesize pure single-crystalline ε-iron and possible uses for the material In trying to understand Earth's internal composition, scientists have had to rely mostly on seismological data. Such studies have led scientists to believe that the core is solid and that it is surrounded by liquid. But questions have remained. For example, back in the 1980s, studies revealed that seismic waves travel faster through the Earth when traveling pole to pole versed equator to equator, and no one could explain why. Most theories have suggested it is likely because of the way the iron in the core is structured. Most in the field agree that if the type of iron that exists in the core could be made and tested at the surface, such questions could be answered with a reasonable degree of certainty. But doing so has proven to be challenging due to fracturing during synthesis. In this new effort, the research team has found a way around such problems and in so doing have found a way to synthesize a type of iron that can be used for testing the properties of iron in Earth's core.

Continue Reading

88 notes

·

View notes

Text

Physicists synthesize single-crystalline iron in the form likely found in Earth's core

A team of physicists and geologists at CEA DAM-DIF and Universit´e Paris-Saclay, working with a colleague from ESRF, BP220, F-38043 Grenoble Cedex and another from the European Synchrotron Radiation Facility, has succeeded in synthesizing a single-crystalline iron in a form that iron has in the Earth's core. In their paper published in the journal Physical Review Letters, the group describes how they used an experimental approach to synthesize pure single-crystalline ε-iron and possible uses for the material In trying to understand Earth's internal composition, scientists have had to rely mostly on seismological data. Such studies have led scientists to believe that the core is solid and that it is surrounded by liquid. But questions have remained. For example, back in the 1980s, studies revealed that seismic waves travel faster through the Earth when traveling pole to pole versed equator to equator, and no one could explain why.

Read more.

20 notes

·

View notes

Text

Séminaire Informatique Quantique

J’ai participé, il y a un peu plus d’un mois, à une session sur « Etat des lieux de l’informatique Quantique en France » organisée à Paris. A part la présence de différents acteurs, il y avait surtout Maud Vinet, ex-responsable du quantum computing au CEA et considérée comme la tête chercheuse du quantique en France (c’est surtout pour sa présence que j’ai fait le déplacement).

L’avantage de cette session était le nombre réduit de participants ce qui a permis une interaction tout au long de la journée aussi bien durant les conférences qu’en dehors (lors des pauses…).

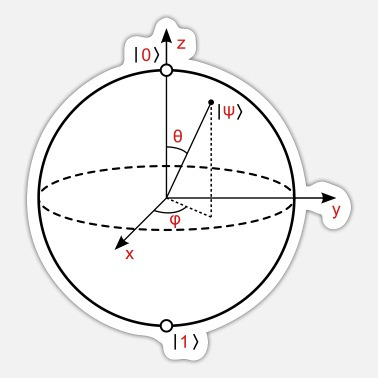

Ainsi plusieurs conférenciers se sont succédés. Les premières interventions étaient surtout pour rappeler les fondamentaux des ordinateurs quantiques. On a rappelé la notion de "Qbits" basée sur des particules élémentaires (photons, électrons, atomes...) qui obéissent aux lois de la mécanique quantique. Et surtout l’avantage de ces "Qbits" qui, contrairement aux "bits" peuvent prendre tous les états entre 0 et 1 (cf mon précédent article).

Plusieurs images, pour faire la comparaison ont été évoquées :

Les 2 touches sur un piano : Vous pouvez jouer une touche l’une après l’autre mais aussi les 2 touches en même temps ou encore frapper plus ou moins fort les touches… les possibilités sont nombreuses.

Une autre représentation est la sphère de Bloch où le pôle Nord est le 0, et le pôle Sud le 1 : Le qubit peut avoir n’importe quelle valeur sur cette sphère durant la phase de calcul. Lors de la mesure son état est alors figé.

Puis on a attaqué dans le dur avec les algorithmes à utiliser : L’objectif étant d’associer plusieurs Qbits pour un calcul, car la « puissance » est exponentielle avec le nombre de Qbits utilisés. Il existe ainsi plusieurs types d’algorithmes qui peuvent être basés sur l’optimisation des valeurs matricielles, l’optimisation combinatoire ou encore un réseau de neurones quantiques. J’avoue à ce niveau, j’ai lâché un peu le fil de l’exposé. Mais pour résumer, il existe des portes quantiques qui permettent suivant l’algorithme de relier un certain nombre de Qbits plus ou moins proches. Un focus a été fait sur l’algorithme des réseaux neurones orthogonaux qui peuvent s'avérer utiles pour améliorer la performance ou pour réduire le nombre de paramètres.

Ce qui est m’a intéressé, est la possibilité de tester dès aujourd’hui ces algorithmes à l’aide de logiciels d’émulateurs quantiques qui fonctionnent sous GPU. Mais ces programmes donnent des résultats avec un nombre de Qbits « parfaits ». Hors dans la vraie vie, ces Qbits sont très instables et très difficiles à contrôler, avec une difficulté qui va croissante au fur et à mesure qu'on ajoute des Qbits pour doper la puissance de calcul. Il y a donc des erreurs qui se produisent. Il est nécessaire d’introduire une couche de correction d'erreurs quantiques et cette couche de correction à un coût en terme de nombre de Qbits physiques. Aujourd'hui suivant le type de système physique avec lequel on travaille et la durée de calcul, on estime qu’il faudrait environ 1000 Qbits physique pour créer un Qbit parfait ou Qbit « logique » permanent dans le temps.

Lors d’échanges informels, d’autres approches basées sur la redondance d'information permettraient de déduire une « probabilité » pour obtenir le bon résultat spécifique. Avec cette méthode on arriverait entre 60 et 30 Qbits physiques pour un Qbit logique permanent.

C’est le moment où Maud Vinet est intervenue pour sa présentation. Elle a justement fait un rappel des différentes technologies permettant de créer des serveurs Quantiques. Car le problème aujourd'hui c'est vraiment la partie hardware. Pour la manipulation d’objets uniques auxquels on a accès facilement les possibilités sont nombreuses : Que cela soit des atomes sous vide, les supraconducteurs qui présentent des propriétés quantiques à l'échelle macroscopique intéressantes ou encore les photons pour leur facilité de mise en œuvre avec des lasers, chaque techno apporte ses avantages mais aussi ses imperfections et donc ses erreurs.

La course est donc ouverte, c’est pour cette raison que Maud VINET a créé il y a 6 mois la société SIQUANCE en se disant que le silicium peut être aussi un super candidat. Elle met en avant la qualité du silicium employé qui permet d’améliorer le taux d’erreur. Dans la suite de sa conférence, Maud VINET a détaillé le fonctionnement de son ordinateur quantique en utilisant le degré de liberté de spin : La microélectronique utilise une seule propriété des électrons, leur charge électrique, et un matériau principal, le silicium. L'informatique quantique utilise une autre caractéristique des électrons, purement quantique, leur spin. Pour résumé, le spin concerne la rotation de l’électron sur lui-même. Il peut tourner dans un sens ou dans l'autre. Cela lui donne un degré de liberté magnétique permettant de définir les états quantiques (De 0 à 1). Cet état va être sensible au champ magnétique qu'on applique pour le manipuler. Et voilà comment sont nés les Qbits de spin dans le silicium.

Toujours durant ces échanges, on a parlé de la start-up la plus avancée en France : Pasqal. Cette société développe un ordinateur quantique à atomes neutres : Quelques atomes de rubidium sont disposés dans le « vide » et à l’aide de lasers ils sont manipulés.

Alain Aspect, cofondateur de Pasqal, a remporté le Prix Nobel en 2022 aux côtés de John F. Clauser et Anton Zeilinger, pour avoir mené des expériences extraordinaires en utilisant des états d'intrication quantique, dans lesquels deux particules se comportent comme une seule unité, même en étant séparées. De ces recherches, il peut être envisagé de réduire le nombre de Qbits physiques nécessaires pour le traitement des erreurs comme évoqué précédemment.

Il faut savoir qu'actuellement la start-up affichent "déjà" entre 100 et 200 Qbits physiques, mais elle envisage dès 2024, 1000 Qbits !

Il a été ensuite évoqué les utilisations concrètes de l’informatique quantique comme chez AstraZeneca sur la prédiction de taux de réussite ou encore chez Roche pour l’imagerie médicale.

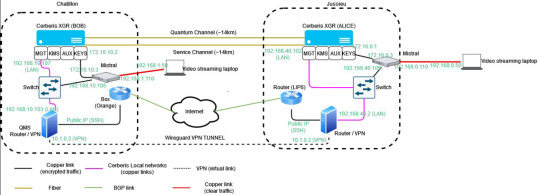

Après une longue pause bien mérité, les conférences ont abordé les aspects liés à la sécurité. On a commencé par les technologies quantiques pour sécuriser l’échange de clés (QKD). Sur ce point la technologie est déjà validée et garantit une sécurité quasi-totale (ainsi l’intrication quantique permet de déterminer si une clé a été interceptée). La seule difficulté consiste à construire des réseaux supportant la transmission d’informations Quantiques. Orange a ainsi expérimenté le QKD à travers « la lumière » et son réseau optique. Sachant qu’une fois l’échange de clefs effectué, la transmission des données utilise des moyens classiques. Un flux vidéo a ainsi été mis en place de façon sécurisé en utilisant le QKD entre 2 sites de recherche d’Orange :

Il semble que sur ce point, la France a pris du retard par rapport aux autres pays Européens pour déployer ce type de réseau.

Mais le principal risque est d’ordre cryptographique. Avec la puissance du quantique, il sera possible de décrypter des données en quelques mois, voire semaines, là où aujourd’hui il faudrait plusieurs dizaines d’années. Certains « états » pratiquent déjà le Store Now,DecypherLater. Pour contrer ce problème des algorithmes de chiffrement et de signature «post-quantiques» (PQC) ont été proposés par le NIST (National Institute of Standards and Technology). Le problème est que ces algorithmes sont peu nombreux (3) et surtout qu’aucun de ces algorithmes n’a encore passé l’épreuve du feu sur un ordinateur quantique… Les acteurs de la sécurité travaillent surtout à coupler les algorithmes PQC aux systèmes actuels dans une stratégie d’« hybridation » pour essayer de maximiser la sécurité (préconisation de l’ANSSI).

Suite à ces échanges sur la sécurité, une question a été évoquée sur le quantique en Chine. Un ordinateur quantique, Juizhang, a été construit. Ce serveur utilise la lumière (photons) comme support physique de calcul. La chine s’est notamment « vantée » en 2020 d’avoir réalisé un calcul sur un Juizhang (V2) en 200 secondes qui aurait pris plusieurs années avec un HPC classique.

Pour finir la journée, une thématique a été évoquée sur l’impact énergétique de l’ordinateur quantique. Comme évoqué, les particules impliquées dans le processus de l’informatique quantique sont sujettes à des erreurs si elles sont exposées à la moindre perturbation de l'environnement. C'est pourquoi les ordinateurs quantiques fonctionnent dans des environnements isolés et à des températures extrêmement basses. Cela a un impact environnemental même si le ratio par rapport à un HPC n’est pas comparable.

Pasqal, en utilisant des atomes manipulés par lasers, n’a pas besoin en principe de système cryogénique mais il est cependant nécessaire de refroidir la pompe qui génère le vide.

Nous sommes sur le point de passer une nouvelle frontière. Nous ne savons pas encore quand et par quel moyen l’atteindre mais les « richesses potentielles » seront immenses. Aujourd’hui entraîner l’IA sur des modèles LLM nécessite plusieurs mois, avec un ordinateur quantique cela se mesurera en secondes… La conquête vers ce nouveau monde est lancée, les premiers qui y parviendront, auront la possibilité de s’imposer durablement.

L'invention du transistor date de 1947 mais celui-ci a été imaginé conceptuellement à la fin des années 20. Il a fallu attendre le milieu des années 70 pour aboutir au développement industriel des transistors dans les processeurs. Le principe de l’ordinateur quantique date du milieu des année 80, le premier Qbits est n�� au début des années 2000. En 2020, plusieurs ordinateurs quantiques de 50 Qbits fonctionnent dans le monde. Aujourd’hui le système de processeurs quantiques Eagle d'IBM affiche une puissance de 127 Qbits. Son prochain processeur quantique, attendu pour la fin de 2023, devrait franchir la barre de 1000 Qbits. L’augmentation du nombre de Qbits physiques disponibles pour un calcul, couplé à la quête du Qbit parfait, pourraient bien représenter une avancée décisive dans les 5 prochaines années…

6 notes

·

View notes

Text

Getting Started in Saclay

I started work this week in my new position, as a permanent researcher at the Institute for Theoretical Physics of CEA Paris-Saclay. I’m still settling in, figuring out how to get access to the online system and food at the canteen and healthcare. Things are slowly getting into shape, with a lot of running around involved. Until then, I don’t have a ton of time to write (and am dedicating most of…

View On WordPress

3 notes

·

View notes

Text

OC INFO PACKET: CLAUDE DI MONTOYA (Historical OC)

NAME: Claude di Montoya ; Occasionally Claudia or Claudio AGE: 22 in mainverse HAIR: Black EYES: Amber HEIGHT: 5′4″ OCCUPATION: Agent of Savoy espionage ; Heir to the Marquisate of Cea FAMILY: Mother (deceased) ; Father (estranged) ; Raffaelle (younger brother) ; L'Comte de Monte Cristo (foster father)

OVERVIEW:

A survivor by nature, Claude has already played many roles in their short life. As their narrative opens, they're an agent of the ruling family of Piedmont, abroad in their native France pursuant of information that will be the foundation of future rebellions, and the reunification of Italy itself. They currently run a double life, owing to their own fluid nature: One a vivacious young noblewoman, the other a gentleman of the highest caliber. At heart, however, they're something of a hurting hero, pulled from mission to mission with little control of their own life, despite their desire to be the constant rebel.

For someone who hates the nobility and ruling class, they sure are wellborn. Their mother claimed descent from the di Montoya family, first of Spain, then gaining the Marquisate of Cea in Italy during the fall of the Hapsburgs. Their father is a holy man of the nearly sacrosanct Talleyrand-Perigord family. However, the loss of their mother left them bitter against the elite who denied Claude and their younger brother, the result of which was the pair living on the streets for much of their remaining childhood. Their hatred runs deep, wild, and their forced proximity to the beautiful elite is a source of great conflict in them.

Got pressganged into service to @luxsclaris's Count of Monte Cristo, who saw potential in the hot-blooded youth with something to prove. It was this same promise that another man saw in Claude when they were adolescent, and it is this history with Morcerf that the Count hopes to capitalize on.

Starts out an emotionally distant, skeptical loner who over the course of interactions has been found family'd by a fair few characters from across various fandoms. Is unfailingly loyal to those who have given them a chance to trust others again, and is working to break their own cycle of self-hatred in relation to the horrors they have seen and committed over the years. They will spare the world because it has those who they love within it, and they will spare themself because they are capable of being loved.

No queer trauma here! Claude is totally comfortable in their own identity, and loves openly across gender lines so long as they have an affinity for whoever ensnares their heart. It's important to me to show historical queer identities that are happy and fulfilled, because we have always been here, and we have always had ways to not only survive, but live and be happy.

A true blue skeptic in the face of the inhuman in threads. Interacts with a giant naga in threads and believes it's a marvelous piece of machinery manned by the 'human' portion. Thinks their bestie/potential love interest is using a 'vampire' narrative to explain his own self-loathing towards what must have been a traumatic upbringing. No one is amused with this except me, who loves what a dumbass they are about this.

Big fan of the French Revolution. Keeps tiny portraits of Robespierre and General Dumas in their quarters. Truly believes in brotherhood and liberty, even if they sneer that the world is not quite ready for such virtues.

Hates the nobility. Is the sole heir of their maternal uncle the Marquis, who has no sons of his own. Lives fully masc in Sardinia, which makes Paris at least tolerable in that they can be wholly themselves and embrace all the many facets of their gender.

Is in some kind of love triangle with a 500 year old vampire who runs their favorite theater company (Armand) and the deposed daughter of an Greek pasha who came to Paris to fuck up Claude's former mentor (Haydee.) This usually ends in polyamory as soon as Claude accepts they are desirable by others. Both are played by aforementioned luxsclaris.

A descendant of my OC Cirila, specifically a several times great-grandchild from the line of Cirila's youngest son. This also means they claim descent from a Dumas protagonist based on that son-slash-ancestor's marriage, but details, details.

2 notes

·

View notes

Photo

2023 November 8

Perseus Galaxy Cluster from Euclid Image Credit & License: ESA, Euclid, Euclid Consortium, NASA; Processing: Jean-Charles Cuillandre (CEA Paris-Saclay) & Giovanni Anselmi; Text: Jean-Charles Cuillandre

Explanation: There's a new space telescope in the sky: Euclid. Equipped with two large panoramic cameras, Euclid captures light from the visible to the near-infrared. It took five hours of observing for Euclid's 1.2-meter diameter primary mirror to capture, through its sharp optics, the 1000+ galaxies in the Perseus cluster, which lies 250 million light years away. More than 100,000 galaxies are visible in the background, some as far away as 10 billion light years. The revolutionary nature of Euclid lies in the combination of its wide field of view (twice the area of the full moon), its high angular resolution (thanks to its 620 Megapixel camera), and its infrared vision, which captures both images and spectra. Euclid's initial surveys, covering a third of the sky and recording over 2 billion galaxies, will enable a study of how dark matter and dark energy have shaped our universe.

∞ Source: apod.nasa.gov/apod/ap231108.html

157 notes

·

View notes

Text

Euclid’s new image of spiral galaxy NGC 6744,

Which is 30 million light-years away.

ESA / Euclid / Euclid Consortium / NASA; Image processing by J.-C. Cuillandre (CEA Paris-Saclay), G. Anselmi

#art#cosmos#cosmic#universe#blast#space#photography#stars#light#euclid space telescope#galaxy#NGC 6744#ESA#NASA#euclid

30 notes

·

View notes

Text

Până după anii 2000 prea puțini români auziseră de bisericile-cetăți săsești din Transilvania. Bine, localnicii, sașii, istoricii, cineaștii... auziseră. Dar nu era un fenomen de masă. Mai ales înainte de 1989. Guvernul comunist a descurajat cât a putut promovarea sub orice formă a monumentelor ne-românești, în special cele maghiare și germane din Transilvania. Patrimoniul medieval săsesc, cele peste 150 de biserici fortificate erau cvasinecunoscute publicului larg, chiar și celui educat.

Desigur erau cunoscute cetatea de la Râșnov sau castelul Bran, care apăreau în reclamele ONTului sau în reviste gen România Pitorească, dar nu se sufla o vorbă despre originea constructorilor lor. Râșnovul era „cetate țărănească” construit de „țărani” fără etnie iar Branul era castelul făcut de „brașoveni”, iarăși un termen ambiguu.

După „redescoperirea” acestui fabulos patrimoniu moștenit de la sași și intrarea a 6 monumente în patrimoniul UNESCO, satele săsești au intrat în circuitul turistic. Din păcate fără sași, care plecaseră mai toți până în 1992-93.

Azi, Internetul s-a umplut de poze și situri care scriu cu mândrie despre bisericile fortificate.

De câțiva ani mi-a atras atenția o informație care apare pe zeci și zeci de situri, fiind răspândită cu regularitate și pe facebook. Este vorba despre povestea ușii sacristiei de la Biertan, cea cu o extraordinară broască și un sistem complex de tije de metal care, cu ajutorul unei manivele intră în tocurile de piatră ale porții. Și prezentarea admirativă a ingeniozității mecanismului ușii e invariabil însoțită de informația că în 1900, ușa a fost scoasă din balamale și dusă la Expoziția Universală de la Paris, unde franțujii uluiți au dat ușii medalia de aur. Ocazie cu care românul se umple de mândrie că uite ce chestie grozavă avem noi.

Interesant e că nimeni, dar nimeni nu a căutat mai multe informații despre „participarea” acestei uși, o minune a tehnicii medievale săsești la Expoziția Universală de la Paris, din 1900. Informația simplistă era suficient de spumoasă ca să ne emoționeze. Iar deseori în articolele sau notițele legate de acest eveniment din istoria ușii sacristiei de Biertan nu este menționat niciodată cuvântul „sas” sau „săsesc”. Pentru oamenii mai puțin educați, sugestia nespusă fiind că a fost vorba de un succes – cumva - al României sau al „românismului”.

Ceea ce nu se spune nicăieri e că ușa sacristiei de la Biertan a ajuns la Paris ca exponat al pavilionului Ungariei. Era prima participare a Ungariei ca țară separată de Austria, după ce în tot veacul 19, participase ca „secție” în interiorul pavilionul imperiului Austro-Ungar. La 1900, Ungaria și-a prezentat în expoziție cu mândrie arta decorativă și arhitectura art-nouveau la care excelau în epocă. În acest discurs au amenajat și câteva săli în care au prezentat fundalul vechi, medieval al acestor arte, sculptură, pictură, feronerie. Ușa de la Biertan era o capodoperă atât a mobilierului cât și al artei lăcătușeriei din regatul medieval al Ungariei. Ușa are pe exterior decorații complexe de marchetărie (arta intarsiilor de lemn de diverse culori forme), iar pe interior, o capodoperă de inginerie mecanică a meșteșugarilor sași de la Sighișoara.

Nu am găsit nici o fotografie de epocă cu ușa de la Biertan expusă la Paris. Am găsit imagini cu detaliile de feronerie ale ușii într-o carte maghiară despre istoria artelor decorative în Ungaria. Unde este pomenită călătoria ușii la Paris. Alături de această ușă au călătorit la Paris numeroase artefacte vechi de mare valoare adunate din muzee, palate și biserici.

Iată un citat dintr-o lucrare din epocă, care descrie expoziția despre arta veche expusă de Ungaria în expoziție( scuzați traducerea automata, adică grosolana pe alocuri):

” Exponatele includ arme de apărare și atac, steaguri de război și alte obiecte ce evocă viața militară sau diverse aspecte ale acesteia. Printre piesele notabile se numără: spada episcopului Kálmán (fiul nelegitim al lui Róbert Károly/Carol-Robert), spada lui Matia Hunyadi, sabia lui Skanderbeg și a căpitanului Thúry György, sabia și coiful eroului de la Szigetvár, Zrínyi Miklós, o mască de antrenament a unui husar din secolul al XVI-lea, un taragot kuruț din secolul al XVII-lea, cheile fortăreței Timișoara, predate lui Pálffy János, și sabia ceremonială a împăratului Iosif al II-lea, purtată de acesta la vârsta de 10 ani. (...)

În capela de jos se află un alt exponat remarcabil: altarul cu aripi (poliptic) de la Căpâlna, o adevărată capodoperă, alături de impresionanta cristelniță din bronz, turnată în 1481 de meșterul János de Nova Villa. Ușa sacristiei bisericii evanghelice din Biertan, datând din 1515, cu un mecanism ingenios de închidere și 21 de zăvoare, reprezintă un rar exemplu de măiestrie în lăcătușerie. Aici este expus și marele suport de cărți de la Bobâlna, mai multe steaguri bisericești din secolele XVII-XVIII, iar, pentru a menționa doar câteva exemple suplimentare, predela bisericii parohiale din Löcse (Levoča, astăzi în Slovacia), datând din secolul al XV-lea, care ilustrează închinarea celor trei Magi"

Legat de „medalia de aur”. Nu a fost ceva ieșit din comun. Medaliile s-au dat cu generozitate de organizatori, atât artefactelor cât și artiștilor. Iată ce a câștigat Ungaria în 1900

” Expozanții maghiari au câștigat în total 145 de Grand Prix, 240 de medalii de aur și 360 de argint, 366 de bronz și 250 de diplome, plasând Ungaria pe locul cinci la competiţia pe ţări. Presa maghiară a recunoscut cu bucurie succesele de la Paris, așa cum a notat unul dintre autorii ziarului nostru: „națiunea a putut trece pragul noului secol într-un potop de recunoașteri”, sperând cu încredere că „Europa va accepta Ungaria printre cei recunoscuți”.

În plus umblă pe net (vezi atașamentul) și informații false. Nici vorbă să fie vorba de ”cea mai complicată încuietoare din lume”. Zici că că situri precum „România misterioasă” promovează asemnea prostii? Nici vorbă, informația circulă și pe situri cu pretenții. Ca să știți, am văzut mecanisme și încuietori mai complexe decât cea de la Biertan. Din aceeași epocă.

Din aceeași categorie de informații false promovate cu mândrie, gen „Sighișoara singura cetate locuită din lume”.

Cam asta e povestea cu ușa de Biertan și medalia de aur primită ca recunoaștere peste veacuri de meșterii sași. În imagini, pavilionul Ungariei de la paris 1900. Ușa de la Biertan a fost expusă în ”Sala cavalerilor”, prima poză, inspirată de cea de la Castelul de la Hunedoara.

Vreți să vedeți mai mult, intrați aici și veți avea și o descriere a fiecărui pavilion. https://en.worldfairs.info/expolistepavillons.php?expo_id=8

0 notes

Text

Why Indian students should consider France for higher studies

The country famous for its arts, history, and gourmet food is gradually becoming one of the preferred countries for Indian students pursuing quality education. Universities in France are ranked amongst the best in the international system, tuition fees are relatively low, and there are plentiful job opportunities in the country. This is why Indian students should consider France for their studies.

1. World-Class Education System

French education is well recognized as one of the most effective in the world, and it remains one of the most potent grounds for implementing novelties in education. Universities and arabes (Grandes Écoles) prepare individuals who fit the need of a global operating environment to meet the requirements of the ‘fourth industrial revolution’.

The reputation of Universities: Sorbonne University, INSEAD, and HEC Paris are leading schools all over the world today.

Diverse Courses: France presents a large variety of options: From business and engineering, up to art and humanities.

Key Highlight:

French degrees are widely recognized all over the world and hence, receiving a degree from a French institution will mean that one could readily work anywhere in the world.

2. Affordable Tuition Fees

It is a myth that studying in France is costly, compared to other Western countries such as the United States and the United Kingdom. As more public universities in France receive government subsidies, they only charge a token fee for tuition.

Cost Comparison: Tuition in public universities starts from € 200 – € 600 for first cycle and € 3,000 – € 10,000 for private universities for first cycle programs.

Scholarships for Indian Students: Scholarships are still open for the French government and universities such as the Eiffel Excellence Scholarship, Charpak Scholarship, and Erasmus+.

Tip:

These scholarships can be availed by Indian students to cut down their expenses even more because these scholarships provide for tuition fees, travel, and secondly, their expenses of living.

3. Post-Study Work Opportunities

France is Ranked one of the Best Countries for Indian students due to its friendly Policies In Giving Post-Study Work Visa.

Stay-Back Options: Indian students can look for employment in France for about two years after they’ve left their schools.

Growing Job Market: There is no shortage of opportunities in STEM fields, tech, fashion, and especially in finance.

Example:

France is founded with multinational firms; for instance, Airbus, Total Energies, and L’Oréal offer amazing business opportunities.

4. Hub for Innovation and Research

France is among the world’s major players are research and development, especially in such sectors as aerospace, biotechnologies, and artificial intelligence.

Research Facilities: CNRS and CEA are ranked among the most innovative institutions in research.

Funding for Research Students: It is important for the universities to know that doctoral and postdoctoral researchers usually receive large grants.

Fun Fact:

France takes its place in the top ten countries Nobel Prize science winners.

5. Cultural and Language Benefits

The opportunity to study in France allows a unique opportunity to experience one of the leading cultures of the world.

Learn French: Even if many programs are in English it is beneficial to learn French and it gives extra advantages and more opportunities.

Cultural Richness: Coffee shops, restaurants, art galleries, museums, festivals – France’s cultural history benefiting the everyday student life.

Pro Tip:

To avoid such difficulties, Indian students are allowed by the management of Alliance Française to have french language courses.

6. Diverse and Inclusive Environment

There is a relatively large opportunity for international students in France due to the young and increasing population with an international outlook.

Indian Community: Indian students are gonna get all the support they need with organizations like FISA which is the Federation of Indian Student Associations in France.

Cultural Events: Indian students feel comfortable in the foreign universities they live in because they get to celebrate Diwali and Holli festivals.

7. Strategic Location in Europe

Traveling to France is easy as it is in the heart of Europe, hence the opportunity to access other countries within Europe will be of benefit to the Indian students.

Easy Travel: Users of the Schengen visa are allowed to access 26 countries within Europe.

Networking Opportunities: Operation in Europe and worldwide internships and job openings.

8. Focus on Employability

French universities give preference to making students employable, this means that French universities focus on the objective of making students fit to secure jobs.

Internship Opportunities: Internships are widely used as an element of many programs and curricula.

Industry Collaborations: To ensure. students get placed after completion of their course, universities have industry linkages.

Fact:

In the employability, both HEC Paris and INSEAD are listed as some of the best business schools in the world.

9. Safety and Quality of Life

When it comes to quality of live in the aspects of safety, health care, and efficiency of the public services France is offered at top quality.

Student Housing: Basic foods can be obtained at prices within or below those offered by suppliers to universities, eateries, and other establishments.

Healthcare Benefits: Being one of the best health systems in the world students in France have the privilege of health care at the lowest charges.

10. Government Support for International Students

Education is one area where the French authorities go out of their way to attract internationals.

Campus France: This organization assists Indian students in getting visas, choosing the courses to study, and even how to live in France.

Bienvenue en France: This is a program that seeks to enhance the notion of internationalization through scholarship and services meant for international students.

How to Apply to French Universities

1. Research and Shortlist Universities

List down the appropriate university and the corresponding program under the plan.

2. Check Eligibility Criteria

While pursuing an undergraduate course, one has to qualify 10+2 standard and for postgraduate courses, one needs a bachelor’s degree.

3. Language Requirements

For the English taught programs you are required to submit your TOEFL or IELTS scores. For all the programs offered in French, French is required for admission into the programs.

4. Prepare Application Documents

Typical requirements include:

Academic transcripts

Statement of Purpose (SOP)

Letters of Recommendation (LOR)

CV or resume

5. Apply for Scholarships

Thus, searching for scholarships that are only for Indian students can help in the lowering of the financial pressure.

6. Apply for a Student Visa

An application must be submitted with documents to the French Consulate or VFS Global.

Challenges and Tips

Common Challenges:

Language barriers for non-French speakers.

Adapting to French academic norms.

Tips:

First, it is useful to know at least some basic forms of the French language before getting there.

Utilise student support services.

Conclusion

France and education have always been an interesting proposition for Indian students because they get the best of both worlds- education and diversity at their best along with career opportunities. easy policies, scholarships, and low-cost education make France one of the most favored countries for higher education around the world. No matter whether you are a businessman or woman, an engineer, an artist, or a researcher, France has a lot to offer.

On this journey to France, you will open the door to several opportunities

Are you looking for the best study abroad Consultants in Kochi

#study abroad#study in australia#study in uk#study abroad consultants#study in germany#study in ireland#study blog

0 notes

Text

Mysterious ‘Red Monster’ galaxies in the early Universe

An international team that was led by the University of Geneva (UNIGE) and includes Professor Stijn Wuyts from the University of Bath in the UK has identified three ultra-massive galaxies – each nearly as massive as the Milky Way – that had already assembled within the first billion years after the Big Bang.

The researchers’ results indicate that the formation of stars in the early Universe was far more efficient than previously thought, challenging existing galaxy formation models.

The surprising discovery – described today in the journal Nature – was made by the James Webb Space Telescope (JWST) as part of the JWST FRESCO programme.

The programme set out to systematically analyse a complete sample of emission-line galaxies (ELGs) within the first billion years of cosmic history. ELGs exhibit strong emission lines in their spectra (a spectrum is the range of different wavelengths of light emitted). These emission lines appear as bright lines at specific wavelengths, standing out against the darker background of the spectrum.

The presence of emission lines enabled the team to accurately pin down the distances to the galaxies in the sample. In turn, precise knowledge of the distances and emission line strengths allowed the researchers to reliably measure the amount of stars contained within the galaxies. Three stood out by their large stellar content.

“Finding three such massive beasts among the sample poses a tantalising puzzle”, said Professor Wuyts, co-author of the Nature study and Hiroko Sherwin Chair in Extragalactic Astronomy at Bath’s Department of Physics.

“Many processes in galaxy evolution have a tendency to introduce a rate-limiting step in how efficiently gas can convert into stars, yet somehow these Red Monsters appear to have swiftly evaded most of these hurdles.”

Fast growing Red Monsters

Until now, it was believed that all galaxies formed gradually within large halos of dark matter. Dark matter halos capture gas (atoms and molecules) into gravitationally bound structures. Typically, 20% of this gas, at most, is converted into stars in galaxies. However, the new findings challenge this view, revealing that massive galaxies in the early Universe may have grown far more rapidly and efficiently than previously thought.

Detail in the FRESCO study was captured through ‘slitless spectroscopy’ with JWST’s Near Infrared Camera, a surveying method that allows light to be captured and unravelled into its constituent wavelengths for all objects in a field of view. This makes it an excellent method for measuring accurate distances and physical characteristics of galaxies.

JWST's unparalleled capabilities have allowed astronomers to systematically study galaxies in the very distant and early Universe, providing insights into massive and dust-obscured galaxies. By analysing galaxies included in the FRESCO survey, scientists found that most galaxies fit existing models. However, they also found three surprisingly massive galaxies, with stellar masses comparable to today’s Milky Way.

These are forming stars nearly twice as efficiently as lower mass galaxies from the same epoch or ordinary galaxies at later times in cosmic history. Due to their high dust content, which gives these three massive galaxies a distinct red appearance in JWST images, they have been named the three Red Monsters.

Dr Mengyuan Xiao, lead author of the new study and postdoctoral researcher at UNIGE, said: “Our findings are reshaping our understanding of galaxy formation in the early Universe.”

Dr David Elbaz, director of research at CEA Paris-Saclay and collaborator on this project, said: “The massive properties of these Red Monsters were hardly determined before JWST, as they are optically invisible due to dust attenuation.”

A Milestone in Galaxy Observations

Pascal Oesch, associate professor in the Department of Astronomy at the UNIGE, and principal investigator of the observation programme, said: “Our findings highlight the remarkable power of NIRCam/grism spectroscopy. The instrument on board the space telescope allows us to identify and study the growth of galaxies over time, and to obtain a clearer picture of how stellar mass accumulates over the course of cosmic history.”

While these findings do not conflict with the standard cosmological model, they raise questions for galaxy formation theories, specifically the issue of ‘too many, too massive’ galaxies in the early Universe.

Current models may need to consider unique processes that allowed certain early massive galaxies to achieve such efficient star formation and thus form very rapidly, very early in the Universe. Future observations with JWST and the Atacama Large Millimeter Array (ALMA) telescope will provide further insights into these ultra-massive Red Monsters and reveal larger samples of such sources.

Dr Xiao said: “These results indicate that galaxies in the early Universe could form stars with unexpected efficiency. As we study these galaxies in more depth, they will offer new insights into the conditions that shaped the Universe’s earliest epochs. The Red Monsters are just the beginning of a new era in our exploration of the early Universe.”

Professor Wuyts added: "That is what is so great about astronomy, we're constantly being surprised by new discoveries. Already in its first few years of operation, JWST has thrown us a couple of curveballs. In more ways than one, it has shown us that some galaxies mature rapidly during the first chapters of cosmic history."

IMAGE: The three Red Monsters represent the core findings of this work – these extremely massive and dusty galaxies in the first billion years after the Big Bang indicate that the early Universe is forming stars more efficiently than expected. Image taken by the James Webb Space Telescope. Credit NASA/CSA/ESA, M. Xiao & P. A. Oesch (University of Geneva), G. Brammer (Niels Bohr Institute), Dawn JWST Archive

1 note

·

View note

Text

Widerspruch zur Relativitätstheorie: Kosmische Gravitationssenken werden flacher | heise.de

https://www.heise.de/news/Widerspruch-zur-Relativitaetstheorie-Kosmische-Gravitationssenken-werden-flacher-10027092.html (Bild: ESA/Euclid/Euclid Consortium/NASA, image processing by J.-C. Cuillandre (CEA Paris-Saclay), G. Anselmi) Interessant: Offenbar sind die kosmischen Gesetze doch keiner “Ewigkeitsgarantie” unterworfen. So fand eine Forschungsgruppe um Isaac Tutusaus von der Universität…

#AllgemeineRelativitaetstheorie#DE#Einstein#Heise#RaumZeit#RaumZeitKruemmung#StandardmodellDerPhysik

0 notes

Text

Depression: Neuronal dysfunction in the amygdala may contribute to negative perceptions of the environment.

Depression is often marked by an excessive tendency to perceive sensory stimuli and everyday situations in a negative light. The mechanisms behind this "negativity bias," which can drive the development of depressive symptoms, had largely remained unclear. To investigate this, scientists from the Institut Pasteur and the CNRS, in collaboration with psychiatrists from Paris Psychiatry and Neurosciences GHU, Inserm, and the CEA, examined the amygdala’s function during depressive episodes. Their research indicates that depression alters specific neural circuits, reducing activity in neurons responsible for positive perceptions while overactivating those involved in negative perceptions. These findings, published in Translational Psychiatry in September 2024, may open new avenues for developing drugs to treat patients resistant to conventional therapies.

Between 15% and 20% of individuals experience a depressive episode, characterized by deep and lasting distress, at some point in their lives. However, about 30% of people with depression do not respond to standard antidepressant treatments. To develop new therapies, it is essential to understand the mechanisms behind depression, particularly the negativity bias. This bias causes patients to view the world and sensory stimuli overly negatively, making pleasant stimuli less appealing and unpleasant stimuli even more aversive, thus sustaining depressive symptoms.

"We now know that the amygdala is not only involved in emotional responses to environmental stimuli, influencing attraction or repulsion, but also plays a key role in depression," says Mariana Alonso, co-last author of the study and head of the Emotional Circuits group at the Institut Pasteur. "Recent studies have shown the role of specific neural circuits in the amygdala in perceiving positive or negative stimuli, but their alteration during depressive episodes had not been observed before."

To explore the role of these circuits in negativity bias, researchers used a mouse model for depression, in collaboration with psychiatrists from the Paris Psychiatry and Neurosciences University Hospital Group (GHU), Inserm, and the CEA. These mice, like depressed bipolar patients, exhibited anxiety and stress behaviors (e.g., lack of self-grooming, staying close to walls, and preferring darkness) and showed a negative valence bias to olfactory stimuli (e.g., little attraction to female urine and strong aversion to predator odors).

"We analyzed amygdala activity by measuring the neuronal networks involved in interpreting olfactory stimuli," explains Alonso. The findings revealed that, during depression, neurons encoding positive stimuli were less active than normal, while those encoding negative stimuli were more activated. In other words, depression appears to disrupt amygdala circuits responsible for processing environmental stimuli, further intensifying the negative bias typical of the condition.

These insights are crucial for developing new treatments for depression and bipolar disorder, where patients experience extreme mood swings. "We were able to partially reverse the negative emotional bias and related depressive behaviors in mice by overactivating neurons responsible for positive encoding of stimuli," says Alonso. "This offers a promising pathway for future therapies," she adds. "We are now exploring whether successfully treating a depressive episode in humans involves reactivating these neural networks," concludes Chantal Henry, Professor of Psychiatry at Université de Paris and psychiatrist at Centre hospitalier Sainte-Anne.

0 notes