Don't wanna be here? Send us removal request.

Text

재레드 다이아몬드는 "왜 백인들만 많은 것을 이룰 수 있었나요?"라는 질문을 받고 이에 대한 대답으로 <총, 균, 쇠>를 집필했다고 합니다.

저 역시 "챗GPT가 대체 무엇인가요?"라는 질문을 받은 어느 날, 이에 답하기 위해 연필을 들었습니다. 그렇게 시작된 여정의 결실로 마침내 챗GPT에 관한 모든 것을 담은 책 <비전공자도 이해할 수 있는 챗GPT>를 여러분께 소개합니다.

교보문고 https://product.kyobobook.co.kr/detail/S000216448015

예스24 https://www.yes24.com/product/goods/146290174

알라딘 https://www.aladin.co.kr/shop/wproduct.aspx?ItemId=363790686

사실 의 후속작은 쓸 생각이 없었습니다. 꾸준히 후속작에 대한 제안이 있었지만 계속 고사하다 보니 어느새 3년이라는 시간이 흘렀습니다. 그러나 챗GPT에 대한 질문에 답을 더는 미룰 수 없다는 생각에 지난 2년여간 집필에 몰두해 왔습니다. 그 기간 동안 많은 분들께 원고를 보여드리고, 소중한 피드백을 받으며, 수도 없이 내용을 고치고 또 고쳤습니다. 그렇게 탄생한 <비전공자도 이해할 수 있는 챗GPT>는 감히 '최고'라고 말할 순 없어도 '최선'이었다고는 자신 있게 말씀드릴 수 있습니다.

무엇보다 언제나 최고의 일러스트로 책을 빛내주시는 정진호 작가님과 이번에도 함께할 수 있어 더없이 든든했습니다. 얼마 전에는 회사에서 오픈소스로 공개해 좋은 반응을 얻고 있는 Smoothie Qwen https://github.com/dnotitia/smoothie-qwen 의 로고도 흔쾌히 그려주셔서 한층 더 완성도를 높일 수 있었습니다. 항상 존경하고 감사드립니다.

이번 책도 많은 분들의 도움이 있었기에 가능했습니다. 바쁘신 와중에도 기꺼이 원고를 검토하고 추천사를 보내주신 @하정우 센터장님, 항상 좋은 말씀 많이 해주시는 @김창민 상무님, @김덕진 소장님, 하이퍼액셀 원고를 꼼꼼히 검토하고 기꺼이 워드로 다시 정리해 보내주신 @이진원 CTO님, 오랫동안 뵙지 못했지만 언제나 가까이서 함께하는 듯한 @김지현 부사장님, 항상 생성 AI에 관한 통찰력 있는 글로 영감을 주시는 @김성완님, 흔쾌히 원고를 검토하고 피드백을 보내주신 @이승우님, 페이스북을 하지 않지만 소중한 의견을 보내준 전 직장 동료들, 그리고 기꺼이 원고를 리뷰해 주신 독서클럽 트레바리의 멤버 여러분 등 많은 분들께 진심으로 감사드립니다.

책 <비전공자도 이해할 수 있는 챗GPT>가 "챗GPT가 대체 무엇인가요?"라는 질문에 대한 충실한 답이 되기를 바라며, 기나긴 여정에 도움을 주신 많은 분들께 다시 한번 깊은 감사의 마음을 전합니다.

0 notes

Text

어제 파이토치 컨퍼런스에서 The Journey to Reproduce DeepSeek-R1이라는 제목으로 DNA-R1을 만든 과정과 경험담을 공유했습니다.

0 notes

Text

지난번 공개한 DNA-1.0-8B-Instruct에 이어, 이번에는 저희 팀에서 DeepSeek-R1 레시피를 동일하게 재현한 추론(Reasoning) 특화 모델 DNA-R1을 허깅페이스를 통해 공개했습니다.

무엇보다 한국어 기반으로 추론하는 첫 공개 모델이며, DeepSeek-R1과 동일한 방법론(GRPO)으로 대규모 강화학습(RL) 적용, 성능 저하 없이 한국어/영어 이중 언어 지원, 이외에도 수학, 코딩 및 일반 추론 작업에서 뛰어난 능력을 발휘합니다. 다양한 벤치마크에서 높은 점수를 기록했으며, 특히 14B 크기임에도 더 큰 모델과 견줄만한 뛰어난 성능을 발휘합니다.

저희는 오픈소스의 힘을 믿습니다. 작게나마 오픈소스 생태계에 다시 한 번 기여할 수 있게 되어 더할 나위 없이 기쁩니다. 공개된 모델은 허깅페이스에서 무료로 다운로드할 수 있습니다.

0 notes

Text

요즘 인공지능 관련 최고의 베스트셀러인 <박태웅의 AI 강의 2025>의 저자 박태웅 의장님을 모시고 트레바리에서 독서 모임을 진행했습니다.

읽기 편한 문체와 친절한 설명, 기술 발전 속에서 우리가 잊지 말아야 할 책 내용 전반을 아우르는 윤리적 가치들에 대한 깊이 있는 통찰, 나아가 대한민국의 미래를 위한 혜안이 담긴 정책 제안까지. 많은 분들이 이에 공감하고, 또 저자에게 직접 질문할 수 있는 뜻깊은 시간이었네요.

함께해 주신 모든 분들께 감사드리고, 특히 귀한 시간 내주신 의장님께 다시 한번 감사드립니다.

0 notes

Text

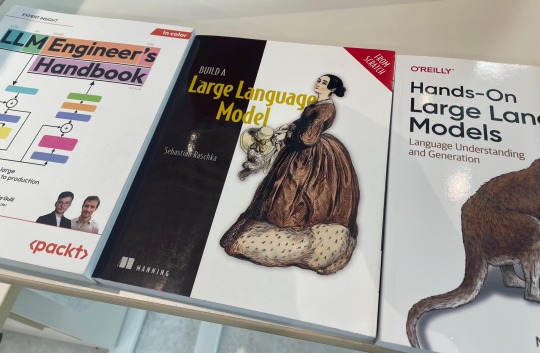

요즘 LLM 업계에서 가장 주목받는 도서 3권을 구했습니다.

Maxim Labonne의 LLM Engineering Handbook, Sebastian Raschka의 Build a Large Language Model 그리고 Jay Alammar의 Hands-On Large Language Models까지. 블로그 글을 통해 워낙 좋은 내용을 많이 공유하는 저자들이고, 각자 개성이 뚜렷하다 보니 각각의 책 내용이 더욱 기대되네요.

0 notes

Text

첫 인상은 좋지 않았어요.

'사실로 증명된 것은 하나도 없다'로 시작하는 서문은, 평소에 과학책이나 논문에서 철저히 증명된 사실을 기반으로 글을 읽는 습관을 지닌 내게 실망감을 안겨주기에 충분한 문구였기 때문이죠.

여러 주제를 의식의 흐름대로 나열한 것에도 적응하기 힘들었습니다. 주제간에 서로 연결고리가 없고, 추상적인 주제와 함께 시와 수필을 섞어 쓴듯한 내용을 보며, 무슨 얘기인지 이해하기 어려운 주제도 많았거든요.

책 표지에 저자 사진도 편견을 갖기에 충분했습니다. 창의성과는 멀어 보이는 히피 같은 몰골을 하고 있는 저자의 모습은 신뢰감을 주는 모습이 아니었어요.

마지막으로 어려운 번역 문제도 지적하고 싶습니다. 원문이 무엇이었는지도 모를 정도�� 한자어를 남발한 것은, 안그래도 난해한 책 내용에 어려움을 가중시켰습니다. 창조에 관한 첫 주제를 펼치자 마자 등장하는 '생득권'이라는 단어는 대체 무슨뜻이며, 영어로는 대체 무엇이었는지 책을 다읽은 지금도 알 수가 없습니다. 물론 다 읽는다고 앞에 내용이 이해되는 책이 아닌 점도 한몫 했고요.

그러나 모든 편견을 한 쪽으로 밀어두고 담담히 끝까지 읽어본 결과, 생각외로 흥미로운 내용이 많았습니다. 무엇보다 예술가의 관점에서 창의성을 얘기한다는 점이 흥미를 자극했고, 어쨌든 저자의 생각을 자유롭게 풀었다는 점에서 생각을 살펴보는 것도 흥미로웠습니다.

책 중반부터 등장하는 저자의 지침에는 상당히 관심이 갔습니다. 아무래도 초반에 지루하게 이어지는 추상적인 내용보다는 실용적인 얘기에 더 관심이 가는 게 사실이네요. 기억에 남는 지침은 다음과 같습니다.

- 자연을 참조하라 - 누구나 불완전하다. 작품에서 중요한 것은 완벽함이 아니다. - 창조 과정에서 막혔을 때 잠시 벗어나 거리를 두면 해결책이 나타날 수 있는 공간이 생긴다. 주의 산만은 작품에 도움이 되는 전략이다. - 가설과 방법에 이의를 제기하라. 더 좋은 방법을 찾을지도 모른다. - 듣기는 허용된 한계로부터의 자유이기도 하다. - 창의성에 관한 가장 깨지기 어려운 법칙이 있다면 인내심이 필요하다는 것이다. - 누구도 창조한 적 없는 방법으로 창조하기 위해서는 초심으로 출발해야 할지도 모른다. - 경험은 지혜를 제공하지만 순수의 힘을 억누른다. - 초기의 영감은 끝까지 끌고 갈 수 있는 에너지가 있다. 완벽하지 않은 부분이 있더라도 끝까지 나아가라. 완벽하지 않은 전체 버전이 완벽해 보이는 조각보다 더 유용하다. - 좋은 습관이 좋은 예술을 창조한다. - 모니터를 켜기 전에 햇빛을 보고, 명상을 하고, 운동을 하고, 찬물 샤워를 한 다음 적절한 공간에서 작업을 시작하라. - 일상 유지에 필요한 과제가 줄어들수록 창의적인 의사결정에 사용할 수 있는 시간도 늘어난다. 아인슈타인은 매일 똑같은 옷을 입었다.

3 notes

·

View notes

Text

얼마전에 공개한 디노티시아의 ���개 LLM, DNA 1.0 8B Instruct의 Technical Report 발행 소식을 전해드립니다.

- DNA 1.0 Technical Report https://arxiv.org/abs/2501.10648

LLM 공개 이후 한 달 정도 정리하면서 평가 metric과 학습 토큰 수를 포함한 여러 정보를 꼼꼼히 기입하였습니다.

이외에도 GGUF 포맷을 별도로 변환하여 허깅페이스에 함께 공개했습니다.

- https://huggingface.co/dno.../Llama-DNA-1.0-8B-Instruct-GGUF

GGUF 변환 작업을 하면서 동시에 ollama에도 모델 페이지를 마련하고 정리해두었습니다.

- https://ollama.com/dnotitia/dna

이제 ollama를 사용하는 분들은 다음 명령어로 간단하게 DNA 모델을 실행할 수 있습니다.

$ ollama run dnotitia/dna

많이 이용해보시고, 피드백도 많이 부탁드립니다.

0 notes

Text

한 때 유행할 뻔(?) 했던 '디지털 노마드'가 ��� 들어간 이유도 업에 대한 태도 문제가 가장 크다고 봅니다. 좋은 기술을 연구하는 것보다 본인의 편안함이 최우선인 분들은 결국 결과물도 그렇게 나올 수밖에 없기 때문. 일 하다 말고 갑자기 서핑하겠다고 바다에 뛰어드는 사람이 과연 얼마나 좋은 결과를 만들어 낼 수 있을지 생각해 보면 금방 답이 나옵니다. 좋은 결과는 디테일에서 나오는 것이고 이는 결국 마음가짐과 우선순위에 따라 결정됩니다. 기술이 아무리 발전해도 변하지 않는 원칙입니다.

1 note

·

View note

Text

0 notes

Text

스타트업에 있다 보니 "뭐 하는 회사냐"라는 질문을 가장 많이 받는데, 그 질문에 가장 명쾌하게 답할 수 있는 기사가 드디어 나왔네요. 대표님의 인터뷰와 함께, 회사의 투자 규모, 개발하고 있는 제품, 향후 비즈니스 방향까지. 회사의 전략이 총 망라되어 있습니다.

저희는 RAG에 활용되는 벡터 데이터베이스와 이를 빠르게 처리할 수 있는 반도체 칩, 그리고 이와 함께 LLM을 구동할 수 있는 장비와 함께 탑재할 DNA라는 이름의 LLM까지 직접 만들고 있습니다.

DNA는 얼마전에 1.0 버전을 허깅페이스를 통해 공개한 바 있고, 여기서도 제가 직접 소개한 적이 있는데요. 당연히 내부에서는 훨씬 더 고도화된 성능이 좋은 버전을 계속 실험 중이며, 앞으로 성능은 더욱 높여나갈 예정입니다.

DNA 허깅페이스: https://huggingface.co/dnotitia/Llama-DNA-1.0-8B-Instruct

이미 고려대학교 안암병원 등과 MOU를 맺고 의료 데이터 분석도 진행 중이며, 덕분에 저도 안암동 고대병원까지 찾아가서 의사 선생님들 앞에서 열심히 LLM을 발표하고 왔네요.

관련 뉴스: https://www.sedaily.com/NewsView/2DEGFEEVE5

이미 회사 홈페이지를 통해서 AI 어시스턴트의 베타 테스트도 진행 중인데요. 아직 초기버전 이긴 하나 어떤 모습인지 궁금하신 분들은 아래 링크에서 바로 베타 테스트를 체험하실 수 있습니다!

베타 테스트: https://request-demo.dnotitia.ai/

1 note

·

View note

Text

어제는 <2025 AI 대전환>의 저자 하정우님을 모시고 독서 모임을 진행했습니다. 역시나 국가대표 인공지능 전문가답게 어떠한 질문에도 막힘없는 깊이 있는 통찰과 명쾌한 답변이 인상적이었네요. 저도 몰랐던 사실을 많이 알게됐고 덕분에 새로운 인사이트를 많이 얻을 수 있었습니다.

특히 앞으로 AI 대전환 시대에 우리가 어떤 준비를 해야 하는지, 어떤 마인드셋을 가져야 하는지에 대한 여러 조언들은 모든 참석자에게 큰 울림을 주었습니다. 귀한 시간 내어 방문해주신 센터장님께 다시 한번 감사드립���다. 🙏✨

0 notes

Text

연말 송년회 시즌이네요.

저희 회사는 분기별로 다 같이 모이는 자리를 마련하고 있는데, 이번에는 송년회와 함께하게 됐습니다. 이제는 인원 수도 제법 늘어나 한 공간에 모이기도 쉽지 않을 만큼 성장했네요. 회사가 성장하는 모습을 함께 지켜보는 것은 참 뜻깊은 일 같습니다.

올해는 저희 팀에서도 목표하는 바를 모두 이뤄냈습니다. 함께 달려온 동료들과 지난 일 년을 돌아보고, 다가오는 2025년을 향한 새로운 비전을 나누었습니다. 이제부터가 다시 시작입니다. 내년에도 더 큰 꿈을 향해 함께 나아가겠습니다. 다들 한 해 마무리 잘 하시고, 행복한 연말 보내세요 🎉

0 notes

Text

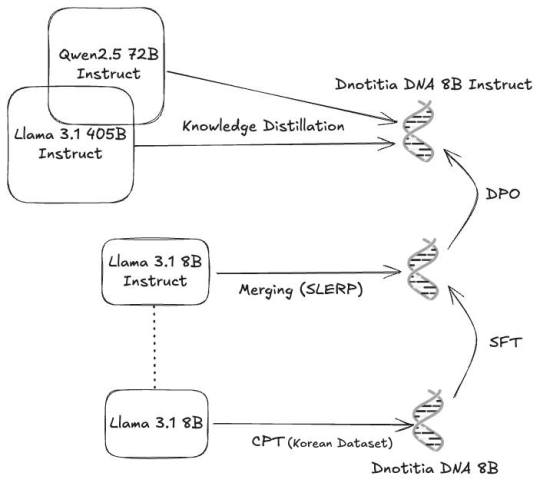

간만에 회사에서 제가 참여한 프로젝트를 소개하게 되어 기쁩니다 😊

저희가 공개한 DNA 1.0 8B Instruct는 한국어에 특화된 최첨단 LLM으로, 자연스러운 대화와 복잡한 지시 이해에 강점을 갖고 있습니다. 한국어는 물론 영어도 훌륭히 처리하며, 학습 과정에서 다양한 기법(SLERP, KD, CPT, DPO 등)을 총동원하여 성능을 최고로 끌어올렸습니다. 특히 어제 공개된 엑사원 3.5를 포함해 여러 다른 유명 모델과 비교했을 때, 대부분의 한국어 관련 평가에서 1위를 차지했습니다 🏆 우리나라에서 한국어를 가장 잘하는 모델을 만들어 보겠다는 저희의 바람을 점수로 증명할 수 있어서 기쁘네요.

수능 문제를 푸는 것부터 일상적인 대화까지, 다양한 한국어 관련 작업을 가장 잘 처리해낼 수 있는 모델입니다. 모델은 누구나 무료로 사용해 볼 수 있도록 공개했습니다.

허깅페이스: https://huggingface.co/dnotitia/Llama-DNA-1.0-8B-Instruct

언론 기사: https://zdnet.co.kr/view/?no=20241210090009

1 note

·

View note

Text

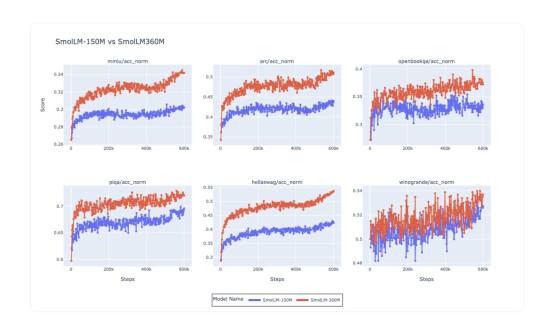

얼마 전에 라마 아키텍처를 채택하고도 라마가 아닌 모델에 대해 비판한 적이 있습니다. 이번에는 좋은 예시를 소개해봅니다. 허깅페이스에서 공개한 SmolLM2입니다. 이름 그대로 엣지 디바이스에서 사용할 수 있을 정도로 ‘작은’ 모델이고, 벌써 2번째 버전입니다. 허깅페이스 팀에서 직접 135M, 360M, 1.7B를 빌드했습니다. 데이터에 특히 신경을 많이 썼으며 웹 크롤링 데이터를 기반으로 Synthetic Data를 확장하는 기법을 사용했습니다. Classifier 모델을 구축하고 고품질 데이터 큐레이션에 많은 노력을 기울였으며 Chinchila Optimal Point를 넘어서도 더 긴 학습으로 성능이 계속 향상되는 걸 관찰했다고 합니다. 물론 Chinchila 모델이 나온 지도 벌써 한참 됐고 최근 나오는 모델은 대부분 비슷한 양상을 보이긴 합니다만, 600B 토큰 학습으로 1T를 학습한 MobileLLM의 성능을 뛰어넘었다는 점이 인상적이네요. 게다가 MobileLLM은 Layer Sharing라는 구조 변경이 포함되는데, 순수 라마 모델이라는 점에서 더욱 인상적입니다. 학습 방식이나 프레임워크, 데이터셋까지 모두 공개하고 있기 때문에 다양한 실험이나 연구 용도로도 적당합니다. 게다가 동일하게 LlamaForCausalLM 라마 모델로 인식되기 때문에 호환성도 좋습니다. 예전에 중국에서 TinyLlama가 나왔을 때 한동안 인기를 끈적이 있는데 이제는 SmolLM2를 가장 자신있게 추천할 수 있을 거 같네요.

0 notes

Text

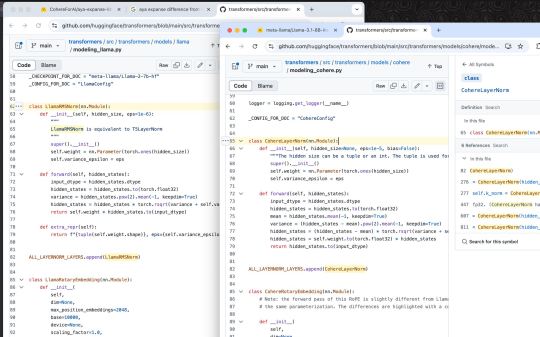

캐나다에서 가장 유명한 AI 기업인 Cohere에서 공개한 Aya Expanse에 llamafy를 시도해 봤습니다. 다른 파라미터는 모두 동일했는데 아쉽게도 딱 한 군데 RMSNorm에서 걸리네요. 이 간단한 수식의 차이로 이후 activation이 완전히 다른 값으로 변해서 llamafy가 불가능했습니다. normalization 함수의 사소한 변경일 뿐인데 호환성을 배제한 선택이 무척 아쉽네요. 만약 이 함수로 인해 성능을 월등히 높였다면 기존 라마 모델과 동일한 데이터로 학습해서 비교 결과로 증명하면 될 텐데 아쉬운 선택입니다.

얼마 전 LG에서 공개한 Exaone은 llamafy가 아주 잘 됐습니다. 이름 외에는 라마와 구조가 완전히 동일했거든요. 이 또한 호환성을 위해 원래 라마 모델로 공개했으면 더 좋았을 텐데 모델링 코드를 메인 프로젝트에 merge 하지 못한 채 trust_remote_code를 적용해서 사용하기 더 불편하게 한 점은 여러모로 아쉬운 선택입니다.

0 notes

Text

요즘은 회의실에 다들 노트북을 들고 들어오기 때문에 종이와 연필을 들고 아날로그 스타일로 참석하는 건 이제 제가 유일한 거 같습니다. 그렇다고 디지털을 사용하지 않느냐? 하면 그건 아니고 회의가 끝나면 종이에 적힌 내용을 항상 컴퓨터로 옮겨 적습니다. 단 모든 내용을 옮겨 적는 건 아니고 한번 더 읽어보고 꼭 기록해야겠다 싶은것만 적습니다. 이렇게 하면서 한번 더 필터링하게 되니 중요한 정보만 남기게 되는 이점도 있고요.

종이는 이면지를 사용합니다. 여전히 논문은 프린터로 출력해서 줄 그어가며 읽기 때문에 다 읽고 나면 이면지가 많이 남는 편이죠. 물론 이면지에 가득 필기하고 나면 꼭 필요한 내용은 다시 컴퓨터로 옮겨 쓰고 종이는 파쇄합니다. 보안 때문이기도 하고 물리적인 공간을 많이 차지하고 싶지 않아서죠. 책을 많이 읽지만 한 번 읽은 책은 모조리 처분하기 때문에 책장도 같은 이유로 항상 간결하게 유지합니다. 1년에 100권 정도 읽는 편인데 책장에는 100권이 채 안됩니다. 1년이 지나기 전에 읽은 책들을 모조리 처분하기 때문이죠.

가장 중요한 연필은, 저의 원픽은 파버카스텔 9000 HB입니다. 제가 세상에서 가장 좋아하는 연필이죠. 독일산에 최고급 연필이지만 그래봤자 천 얼마 밖에 안 합니다. 그만큼 연필이 저렴하죠. 물론 더 저렴한 연필들은 100원도 채 안 하기 때문에 파버카스텔 연필은 그래도 10배쯤 더 비싼 최고급 연필입니다. 만년필을 사용할 때는 몇 백만 원 짜리도 사용해 봤는데 그에 비하면 연필은 정말 저렴한 취미죠.

오늘은 퇴근길에 교보문고에 들러서 파버카스텔 필기구 세트를 샀습니다. 그냥은 절대 사지 않을 8B까지 들어 있어서 어떤 필기감일지 기대가 되네요. 좋은 필기구를 사면 항상 기분이 좋습니다. 그리고 이 연필들로 얼마나 더 무궁무진한 정보를 종이에 남기게 될지 기대도 많이 되고요.

2 notes

·

View notes

Text

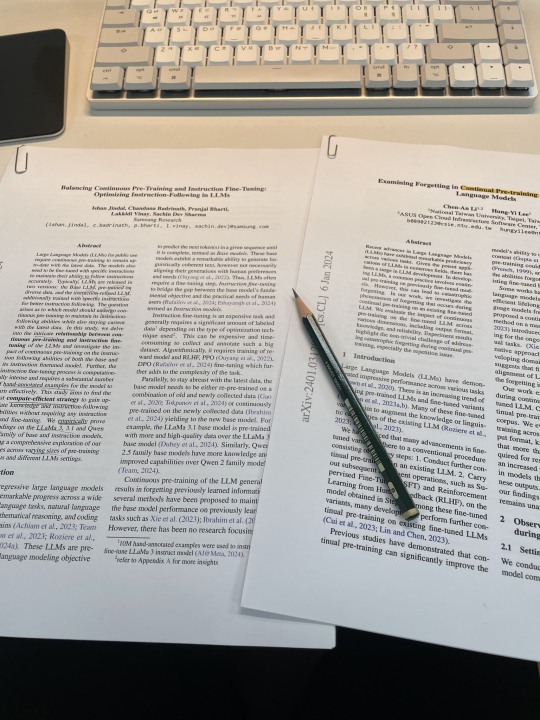

Domain Adaptation에 대한 2편의 논문을 추천받아 재밌게 읽었습니다. 역시 종이에 출력해서 연필로 중요한 부분에 표시해 가며 읽는 게 가장 좋네요. 생각해 보면 20년 전에도 A4 종이에 출력해서 연필로 표시하며 읽었던 거 같습니다. 그때와 다른 점이라면 흑백 프린터가 이제 컬러로 바뀌었다는 것뿐. 한 때 논문 전용 머신으로 리마커블2를 사볼까 했는데, 안 사고 계속 종이와 연필을 사용하기로 한 건 잘 한 결정 같습니다. 앞으로 20년 후에도 똑같이 읽을 수 있으면 좋겠네요.

1 note

·

View note